【AI论文】ReviewScore:基于大语言模型的误导性同行评审检测方法

摘要:本研究针对AI会议同行评审质量下降问题,提出REVIEWSCORE评估标准,通过分析15.2%的"不足"表述和26.4%的"疑问"表述存在的误导性,开发了自动化论证重建引擎。研究构建了专家标注数据集,验证8种先进LLM模型与人类评审具有中等一致性(加权Kappa 0.4-0.6),发现前提级评估比整体评估更可靠。实验表明专用模型如claude-sonn

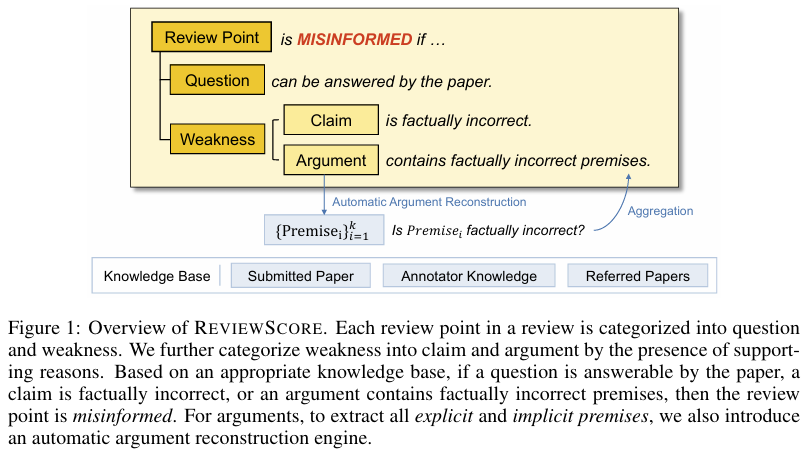

摘要:同行评审是学术研究的重要支撑,但在大多数人工智能会议中,随着投稿量激增,评审质量持续下降。为可靠检测低质量评审,我们将误导性评审要点定义为:评审中包含错误前提的“不足”表述,或论文中已明确解答的“疑问”表述。经核查发现,15.2%的“不足”表述和26.4%的“疑问”表述存在误导性,为此我们引入ReviewScore指标来判定评审要点是否具有误导性。为评估“不足”表述中各前提的真实性,我们开发了自动化引擎,可从“不足”表述中重构所有显性和隐性前提。我们构建了由人类专家标注的ReviewScore数据集,以检验大语言模型(LLM)自动化评估ReviewScore的能力。随后,我们使用八种当前最先进的LLM模型,测量人类与模型在ReviewScore判定上的一致性,验证了二者具有中等程度的一致性。研究还证明,评估前提层面的真实性比评估“不足”层面的真实性具有更高的一致性。深入的争议分析进一步表明,ReviewScore的完全自动化评估具有可行性。Huggingface链接:Paper page,论文链接:2509.21679

研究背景和目的

研究背景:

随着人工智能(AI)领域的快速发展,学术会议接收的论文数量呈现爆炸式增长。

这一趋势对同行评审系统构成了巨大挑战,因为评审质量的下降会直接影响学术研究的可信度和可靠性。传统的同行评审主要依赖专家评审员的知识和判断,但随着提交量的激增,评审员数量也需相应增加,这导致评审质量参差不齐,误评和低质量评审现象频发。特别是在AI会议中,由于评审任务的复杂性和专业性,评审质量的问题尤为突出。

当前,尽管有一些研究提出了评审质量的评估标准,但这些标准往往存在适用性广但具体性差,或针对性强但适用范围窄的问题。例如,Goldberg等人的研究提出了理解性、实质性、覆盖性和建设性四个评估维度,但这些维度更适用于整体评审的评估,难以明确指出具体评审点的质量。

Guo等人的研究专注于评估评审点的实质性,但仅关注评审点是否有支持证据,而未评估这些证据的真实性。

研究目的:

本研究旨在解决当前同行评审中存在的低质量评审问题,通过引入一种新的评审质量评估标准——REVIEW SCORE,并结合大语言模型(LLMs)自动化评估流程,以提高评审质量的可靠性和一致性。具体目标包括:

- 定义明确的评审质量评估标准:提出“无法回答的问题”和“事实性错误弱点”两个具体且可操作的评估标准,以检测低质量评审点。

- 构建自动化评估流程:开发一种基于LLMs的自动化评估流程,通过构建人工专家标注的REVIEW SCORE数据集,验证LLMs在自动化评估REVIEW SCORE中的可靠性。

- 提高评审质量的透明度和一致性:通过提供详细的评审点重建和事实性评估,帮助作者理解评审意图、形成反驳意见,同时帮助评审员和元评审员提高评审质量。

研究方法

1. 定义评审质量评估标准:

研究首先定义了REVIEW SCORE作为评审质量的评估标准,包括“无法回答的问题”(Unanswerability of Questions)和“事实性错误弱点”(Factuality of Weaknesses)两个维度。无法回答的问题指论文中已明确回答或通过简单推理可回答的问题;事实性错误弱点指评审中提出的弱点包含不正确的前提或结论。

2. 构建自动论证重建引擎:

为了评估弱点的事实性,研究提出了一种自动论证重建引擎。

该引擎通过LLMs从弱点中提取所有明确和隐含的前提,并重建为前提-结论结构。为了确保重建论证的有效性和真实性,研究还引入了有效性检查和真实性反馈循环。

3. 构建人工标注数据集:

为了验证LLMs在自动化评估REVIEW SCORE中的可靠性,研究构建了一个由人工专家标注的REVIEW SCORE数据集。

该数据集包含来自ICLR会议的657个评审点,涵盖了问题、主张和论证三种类型,并详细标注了每个评审点的事实性和无法回答性。

4. 实验验证与模型评估:

研究使用八个当前最先进的LLMs(包括五个专有模型和三个开源模型)对REVIEW SCORE进行自动化评估,并通过与人工标注结果的对比,验证LLMs的可靠性。

实验采用多种评估指标,包括精确率、召回率、F1分数和加权Kappa系数等,以全面评估模型性能。

研究结果

1. 评审质量评估标准的有效性:

通过人工标注和实验验证,研究确认了REVIEW SCORE作为评审质量评估标准的有效性。实验结果显示,15.2%的弱点和26.4%的问题存在事实性错误或无法回答的情况,表明当前AI会议的评审中存在相当比例的低质量评审点。

2. LLMs在自动化评估中的可靠性:

实验结果表明,LLMs在自动化评估REVIEW SCORE中表现出中等程度的一致性。

具体来说,对于主张和论证的评估,高级REVIEW SCORE(基于前提事实性评分)明显优于基础REVIEW SCORE(基于整体事实性评分),表明前提级事实性评分能显著提高评估一致性。此外,不同模型在评估性能上存在差异,专有模型(如claude-sonnet-3.7)通常优于开源模型(如qwen3-235b-a22b)。

3. 人类与模型评估的分歧分析:

通过详细分析人类与模型评估之间的分歧,研究发现了模型误解评审点意图、预测少数人类标注分数等常见问题。这些问题表明,尽管LLMs在自动化评估中表现出一定潜力,但仍需进一步优化以提高评估准确性和可靠性。

研究局限

1. 数据集的局限性:

尽管研究构建了一个较大规模的人工标注数据集,但数据集的多样性和规模仍有限。

未来研究可以进一步扩大数据集规模,涵盖更多会议和领域的评审数据,以提高模型的泛化能力。

2. 模型性能的局限性:

尽管LLMs在自动化评估中表现出中等程度的一致性,但其性能仍受限于模型本身的能力和训练数据的质量。未来研究可以探索更先进的模型架构和训练方法,以提高模型的评估准确性和鲁棒性。

3. 评估标准的局限性:

当前提出的REVIEW SCORE评估标准主要关注评审点的事实性和无法回答性,但评审质量还涉及其他多个维度(如理解性、覆盖性、建设性等)。

未来研究可以进一步扩展评估标准,以更全面地评估评审质量。

未来研究方向

1. 扩展评估标准:

未来的研究可以进一步扩展评审质量的评估标准,涵盖理解性、覆盖性、建设性等多个维度。通过构建更全面的评估体系,可以更准确地评估评审质量,并为评审员提供更具体的改进建议。

2. 优化模型性能:

未来的研究可以探索更先进的模型架构和训练方法,以提高LLMs在自动化评估中的准确性和鲁棒性。例如,可以引入更复杂的注意力机制、上下文感知模块等,以提高模型对评审点意图的理解和事实性评估的能力。

3. 跨领域与跨会议应用:

当前的研究主要关注于AI会议的评审质量评估,未来的研究可以探索将REVIEW SCORE评估标准和自动化评估流程应用于其他领域和会议的评审中。

通过跨领域与跨会议的应用验证,可以进一步评估方法的普适性和有效性。

4. 集成到现有评审系统中:

未来的研究可以探索如何将REVIEW SCORE评估标准和自动化评估流程集成到现有的同行评审系统中。

通过提供实时的评审质量反馈和改进建议,可以帮助评审员提高评审质量,并促进学术研究的可信度和可靠性。同时,集成到现有系统中还可以促进方法的广泛应用和持续优化。

更多推荐

已为社区贡献151条内容

已为社区贡献151条内容

所有评论(0)