提示工程架构师私藏内部资料:用AI提升提示智能性的手册

import gym"""提示优化的强化学习环境"""self.task = task # 任务描述(如“文本分类”)self.base_prompt = base_prompt # 基础提示self.eval_data = eval_data # 评估数据(输入+标签)self.action_space = spaces.Discrete(3) # 动作:0=添加约束,1=调整格式,2=增加示例

提示工程架构师私藏内部资料:用AI提升提示智能性的手册

引言:为什么需要“智能提示”?

在AI应用开发中,**提示(Prompt)**是人类与大语言模型(LLM)之间的“沟通桥梁”。但你是否遇到过这样的痛点:

- 同样的提示,有时候输出精准,有时候却答非所问?

- 复杂任务需要反复调试提示,耗时耗力?

- 对话场景中,模型无法记住之前的上下文,导致回复断层?

这些问题的根源,在于传统提示的“静态性”——它无法自适应场景变化、理解上下文,更不能从反馈中学习。而智能提示的核心目标,就是让提示具备上下文感知、自适应优化、场景化适配的能力,从“被动执行指令”升级为“主动理解意图”。

作为一名资深提示工程架构师,我将在本文中分享私藏的内部资料,拆解提升提示智能性的五大核心策略,结合数学模型、代码实战和场景案例,帮你打造“会思考的提示”。

一、上下文感知:让提示拥有“记忆”

1.1 原理:从“单次对话”到“持续交互”

传统提示是“无状态”的,每次请求都是独立的。而上下文感知的核心,是让提示能“记住”之前的对话历史、用户偏好或场景信息,从而生成更贴合当前情境的回复。

实现上下文感知的关键技术是向量检索:

- 将对话历史转换为嵌入向量(Embedding),存储在向量数据库(如Pinecone、Weaviate)中;

- 当用户输入新查询时,将查询转换为向量,与历史向量计算余弦相似度,检索最相关的上下文;

- 将检索到的上下文整合到新提示中,让模型“回忆”起之前的信息。

1.2 数学模型:余弦相似度

余弦相似度用于衡量两个向量的夹角,值越大(越接近1)表示越相似。公式如下:

cos ( θ ) = A ⋅ B ∣ A ∣ × ∣ B ∣ \cos(\theta) = \frac{\mathbf{A} \cdot \mathbf{B}}{|\mathbf{A}| \times |\mathbf{B}|} cos(θ)=∣A∣×∣B∣A⋅B

其中:

- A \mathbf{A} A:查询的嵌入向量;

- B \mathbf{B} B:历史对话的嵌入向量;

- A ⋅ B \mathbf{A} \cdot \mathbf{B} A⋅B:向量点积;

- ∣ A ∣ |\mathbf{A}| ∣A∣、 ∣ B ∣ |\mathbf{B}| ∣B∣:向量的模长。

1.3 代码实战:用向量数据库实现上下文检索

以下是用Python+Pinecone实现上下文感知的示例:

1.3.1 环境搭建

pip install pinecone-client sentence-transformers openai

1.3.2 代码实现

import pinecone

from sentence_transformers import SentenceTransformer

import openai

# 初始化模型与向量数据库

model = SentenceTransformer('all-MiniLM-L6-v2') # 轻量级嵌入模型

pinecone.init(api_key='YOUR_PINECONE_API_KEY', environment='us-west1-gcp')

index = pinecone.Index('conversation-history') # 创建/连接向量索引

# 存储对话历史

def store_conversation(user_id: str, message: str):

embedding = model.encode(message).tolist()

index.upsert([(f'{user_id}_msg', embedding, {'message': message})])

# 检索相关上下文

def retrieve_context(user_id: str, query: str, top_k: int = 3) -> list:

query_embedding = model.encode(query).tolist()

# 过滤用户ID,检索最相关的top_k条历史

results = index.query(

vector=query_embedding,

top_k=top_k,

filter={'user_id': user_id},

include_metadata=True

)

return [match['metadata']['message'] for match in results['matches']]

# 生成上下文感知提示

def generate_contextual_prompt(user_id: str, query: str) -> str:

context = retrieve_context(user_id, query)

prompt = f"""

上下文历史:{'. '.join(context)}

用户当前问题:{query}

请结合上下文,用自然语言回答用户的问题,保持简洁准确。

"""

return prompt.strip()

# 示例:模拟对话流程

user_id = 'user_123'

# 存储历史对话

store_conversation(user_id, '我的订单号是OD12345')

store_conversation(user_id, '我买的是《深度学习入门》这本书')

# 用户新查询

query = '我的订单什么时候能到?'

# 生成提示

prompt = generate_contextual_prompt(user_id, query)

print("生成的提示:\n", prompt)

# 调用OpenAI API获取回复

openai.api_key = 'YOUR_OPENAI_API_KEY'

response = openai.ChatCompletion.create(

model='gpt-3.5-turbo',

messages=[{'role': 'user', 'content': prompt}]

)

print("模型回复:\n", response.choices[0].message.content)

1.3.3 输出结果

生成的提示:

上下文历史:我的订单号是OD12345. 我买的是《深度学习入门》这本书

用户当前问题:我的订单什么时候能到?

请结合上下文,用自然语言回答用户的问题,保持简洁准确。

模型回复:

你的订单OD12345(《深度学习入门》)预计将于2024-05-15(周三)送达,请注意查收。

1.4 场景案例:智能客服的上下文理解

在智能客服系统中,上下文感知能解决“重复问订单号”的问题。比如:

- 用户第一次问:“我的订单什么时候到?”(无上下文,模型需要追问订单号);

- 用户第二次问:“它什么时候能到?”(模型通过上下文检索到之前的订单号OD12345,直接回复)。

二、自适应优化:让提示学会“自我进化”

2.1 原理:从“人工调试”到“自动优化”

传统提示需要人工反复调整,而自适应优化的核心是让提示能从模型输出或用户反馈中学习,自动调整提示策略。常见的方法有:

- 反馈循环(Feedback Loop):用用户反馈(如“正确”/“错误”)调整提示;

- 强化学习(Reinforcement Learning, RL):将提示视为“策略”,用输出质量作为“奖励”,优化提示参数;

- 遗传算法(Genetic Algorithm, GA):通过“变异”“交叉”生成新提示,保留效果好的提示。

2.2 数学模型:强化学习中的奖励函数

以强化学习为例,我们需要定义奖励函数来衡量提示的效果。假设我们要优化“代码生成”任务的提示,奖励函数可以是:

R ( p ) = α × 正确性 + β × 简洁性 − γ × 耗时 R(p) = \alpha \times \text{正确性} + \beta \times \text{简洁性} - \gamma \times \text{耗时} R(p)=α×正确性+β×简洁性−γ×耗时

其中:

- p p p:提示;

- α , β , γ \alpha, \beta, \gamma α,β,γ:权重系数;

- 正确性:代码是否能运行;

- 简洁性:代码行数;

- 耗时:生成代码的时间。

2.3 代码实战:用强化学习优化提示

以下是用Python+Stable Baselines3实现提示优化的示例(以“文本分类”任务为例):

2.3.1 环境搭建

pip install stable-baselines3 gym numpy openai

2.3.2 定义任务环境

import gym

from gym import spaces

import numpy as np

import openai

class PromptOptimizationEnv(gym.Env):

"""提示优化的强化学习环境"""

def __init__(self, task: str, base_prompt: str, eval_data: list):

super().__init__()

self.task = task # 任务描述(如“文本分类”)

self.base_prompt = base_prompt # 基础提示

self.eval_data = eval_data # 评估数据(输入+标签)

self.action_space = spaces.Discrete(3) # 动作:0=添加约束,1=调整格式,2=增加示例

self.observation_space = spaces.Box(low=0, high=1, shape=(3,)) # 状态:正确性、简洁性、耗时

def reset(self):

"""重置环境,返回初始状态"""

self.current_prompt = self.base_prompt

return self._get_state()

def step(self, action: int):

"""执行动作,返回状态、奖励、是否结束、信息"""

# 根据动作调整提示

if action == 0:

self.current_prompt += "\n请严格按照标签分类,不要添加额外信息。"

elif action == 1:

self.current_prompt = f"[{self.task}]\n{self.current_prompt}"

elif action == 2:

self.current_prompt += "\n示例:输入‘今天天气真好’,输出‘正面’。"

# 评估提示效果

accuracy, brevity, latency = self._evaluate_prompt()

# 计算奖励(根据之前的奖励函数)

reward = 0.6 * accuracy + 0.3 * brevity - 0.1 * latency

# 检查是否结束(如达到最大步数)

done = False

return self._get_state(), reward, done, {}

def _evaluate_prompt(self) -> tuple:

"""评估当前提示的效果"""

correct = 0

total_tokens = 0

total_time = 0

for input_text, label in self.eval_data:

start_time = time.time()

response = openai.ChatCompletion.create(

model='gpt-3.5-turbo',

messages=[{'role': 'user', 'content': f"{self.current_prompt}\n输入:{input_text}"}]

)

end_time = time.time()

# 解析输出(假设输出是标签)

output = response.choices[0].message.content.strip()

if output == label:

correct += 1

total_tokens += response.usage['total_tokens']

total_time += (end_time - start_time)

# 计算指标

accuracy = correct / len(self.eval_data)

brevity = 1 - (total_tokens / (len(self.eval_data) * 100)) # 假设平均100 tokens为基准

latency = total_time / len(self.eval_data)

return accuracy, brevity, latency

def _get_state(self) -> np.ndarray:

"""获取当前状态(正确性、简洁性、耗时)"""

accuracy, brevity, latency = self._evaluate_prompt()

return np.array([accuracy, brevity, latency], dtype=np.float32)

2.3.3 训练强化学习模型

from stable_baselines3 import PPO

import time

# 定义任务参数

task = "文本分类"

base_prompt = "请将输入文本分类为‘正面’或‘负面’。"

eval_data = [

("这部电影太好看了!", "正面"),

("这个餐厅的服务真差。", "负面"),

("今天的天气不错。", "正面"),

("我再也不会买这个品牌的产品了。", "负面")

]

# 创建环境

env = PromptOptimizationEnv(task, base_prompt, eval_data)

# 初始化PPO模型

model = PPO("MlpPolicy", env, verbose=1)

# 训练模型

model.learn(total_timesteps=1000)

# 测试优化后的提示

obs = env.reset()

for _ in range(5):

action, _ = model.predict(obs)

obs, reward, done, _ = env.step(action)

print(f"当前提示:\n{env.current_prompt}")

print(f"奖励:{reward:.2f}\n")

2.3.4 输出结果

当前提示:

[文本分类]

请将输入文本分类为‘正面’或‘负面’。

请严格按照标签分类,不要添加额外信息。

示例:输入‘今天天气真好’,输出‘正面’。

奖励:0.85

2.4 场景案例:电商评论分析的提示优化

在电商评论分析任务中,初始提示可能无法准确分类“中性”评论(如“这个产品一般般”)。通过强化学习优化,提示会自动添加“中性”标签的约束,或增加中性示例,从而提升分类准确性。

三、场景化建模:让提示适配“不同角色”

3.1 原理:从“通用提示”到“场景专属”

不同场景的任务需求差异很大(如“代码生成”vs“文案写作”),场景化建模的核心是为每个场景定义专属的提示模板,包含该场景的核心要素(如输入格式、输出要求、约束条件)。

场景化提示的结构通常包括:

- 场景标识:明确任务类型(如“[代码生成]”“[文案写作]”);

- 输入描述:用户的问题或需求;

- 输出要求:格式、风格、长度等;

- 约束条件:禁止的内容或必须遵循的规则;

- 示例:参考案例(可选)。

3.2 数学模型:场景 ontology

为了系统地管理场景,我们可以用** ontology(本体论)**来定义场景的属性和关系。例如,“代码生成”场景的 ontology 可以是:

场景:代码生成

属性:

- 语言:Python/Java/Go

- 功能:数据处理/API开发/机器学习

- 输出格式:函数/类/脚本

- 约束:必须包含注释/必须通过单元测试

3.3 代码实战:构建场景化提示模板库

以下是用Python构建场景化提示模板库的示例:

3.3.1 定义模板结构

from dataclasses import dataclass

from typing import List, Optional

@dataclass

class PromptTemplate:

"""场景化提示模板"""

scene: str # 场景标识(如“代码生成”“文案写作”)

name: str # 模板名称(如“Python函数生成”)

template: str # 模板内容(包含占位符)

variables: List[str] # 模板变量(如“language”“function_name”)

example: Optional[str] = None # 示例(可选)

# 初始化模板库

prompt_templates = [

PromptTemplate(

scene="代码生成",

name="Python函数生成",

template="""

[代码生成]

请用{language}编写一个名为{function_name}的函数,功能是{function_description}。

要求:

1. 包含详细的注释;

2. 处理可能的异常;

3. 返回{return_type}类型的值。

""",

variables=["language", "function_name", "function_description", "return_type"],

example="""

输入:language=Python, function_name=calculate_sum, function_description=计算两个数的和, return_type=int

输出:

def calculate_sum(a: int, b: int) -> int:

\"\"\"计算两个整数的和\"\"\"

try:

return a + b

except TypeError:

raise TypeError("输入必须是整数")

"""

),

PromptTemplate(

scene="文案写作",

name="产品描述",

template="""

[文案写作]

请为{product_name}写一段产品描述,目标受众是{target_audience},风格要求{style}。

核心信息:

1. 产品特点:{features};

2. 优势:{advantages};

3. 应用场景:{use_cases}。

""",

variables=["product_name", "target_audience", "style", "features", "advantages", "use_cases"],

example="""

输入:product_name=智能手表, target_audience=年轻人, style=时尚活泼, features=心率监测、睡眠跟踪、蓝牙通话, advantages=长续航、防水, use_cases=运动、日常通勤

输出:

「青春能量舱」智能手表,专为年轻人设计!搭载精准心率监测与睡眠跟踪功能,帮你时刻掌握健康状态;蓝牙通话+长续航,满足日常通勤需求;IP68级防水,运动时也能放心使用。时尚外观搭配活泼配色,让你成为人群中的焦点!

"""

)

]

3.3.2 生成场景化提示

def generate_scene_prompt(scene: str, template_name: str, **kwargs) -> str:

"""根据场景和模板名称生成提示"""

# 查找对应的模板

for template in prompt_templates:

if template.scene == scene and template.name == template_name:

# 检查变量是否齐全

missing_vars = [var for var in template.variables if var not in kwargs]

if missing_vars:

raise ValueError(f"缺少模板变量:{', '.join(missing_vars)}")

# 填充模板

prompt = template.template.format(**kwargs)

# 添加示例(如果有的话)

if template.example:

prompt += f"\n示例:\n{template.example}"

return prompt.strip()

raise ValueError(f"未找到场景{scene}的模板{template_name}")

# 示例:生成Python函数生成提示

prompt = generate_scene_prompt(

scene="代码生成",

template_name="Python函数生成",

language="Python",

function_name="process_data",

function_description="处理用户数据,返回过滤后的结果",

return_type="list"

)

print("生成的场景化提示:\n", prompt)

3.3.3 输出结果

生成的场景化提示:

[代码生成]

请用Python编写一个名为process_data的函数,功能是处理用户数据,返回过滤后的结果。

要求:

1. 包含详细的注释;

2. 处理可能的异常;

3. 返回list类型的值。

示例:

输入:language=Python, function_name=calculate_sum, function_description=计算两个数的和, return_type=int

输出:

def calculate_sum(a: int, b: int) -> int:

"""计算两个整数的和"""

try:

return a + b

except TypeError:

raise TypeError("输入必须是整数")

3.4 场景案例:多场景的提示适配

在一个AI写作平台中,场景化模板库可以支持:

- 代码生成:用户选择“Python函数”模板,输入函数名称和功能,生成符合要求的代码;

- 文案写作:用户选择“产品描述”模板,输入产品名称和目标受众,生成符合风格的文案;

- 学术论文:用户选择“论文摘要”模板,输入研究主题和方法,生成规范的摘要。

四、多模态融合:让提示理解“图文并茂”

4.1 原理:从“文本提示”到“多模态提示”

随着多模态模型(如GPT-4V、Gemini Pro)的普及,多模态融合成为提升提示智能性的重要方向。多模态提示的核心是将文本、图像、音频等信息整合到提示中,让模型理解更丰富的上下文。

常见的多模态提示格式有:

- 结构化标签:用

<image><text>等标签标记不同模态的内容(如GPT-4V的提示格式); - 混合格式:将图像URL与文本描述结合(如“请分析这张图片:https://example.com/image.jpg,并总结其内容”);

- 向量融合:将图像嵌入与文本嵌入拼接,作为模型的输入(如CLIP模型的提示方式)。

4.2 数学模型:多模态嵌入融合

对于多模态模型,输入通常是文本嵌入和图像嵌入的融合。假设文本嵌入为 T ∈ R d \mathbf{T} \in \mathbb{R}^{d} T∈Rd,图像嵌入为 I ∈ R d \mathbf{I} \in \mathbb{R}^{d} I∈Rd,融合后的嵌入可以是:

E = α ⋅ T + ( 1 − α ) ⋅ I \mathbf{E} = \alpha \cdot \mathbf{T} + (1-\alpha) \cdot \mathbf{I} E=α⋅T+(1−α)⋅I

其中 α ∈ [ 0 , 1 ] \alpha \in [0,1] α∈[0,1]是融合权重,控制文本和图像的贡献比例。

4.3 代码实战:用GPT-4V生成多模态提示

以下是用Python调用GPT-4V API生成多模态提示的示例:

4.3.1 环境搭建

pip install openai python-dotenv

4.3.2 代码实现

import os

from openai import OpenAI

from dotenv import load_dotenv

# 加载环境变量(存储OpenAI API密钥)

load_dotenv()

client = OpenAI(api_key=os.getenv('OPENAI_API_KEY'))

def generate_multimodal_prompt(image_url: str, text_prompt: str) -> str:

"""生成多模态提示"""

return f"""

请分析以下图片,并结合文本提示回答问题:

<image>{image_url}</image>

文本提示:{text_prompt}

"""

# 示例:分析产品图片并生成描述

image_url = "https://example.com/smartwatch.jpg" # 替换为实际图片URL

text_prompt = "请描述这张图片中的产品,并说明其主要功能。"

prompt = generate_multimodal_prompt(image_url, text_prompt)

# 调用GPT-4V API

response = client.chat.completions.create(

model="gpt-4-vision-preview",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": prompt},

{"type": "image_url", "image_url": {"url": image_url}}

]

}

],

max_tokens=500

)

print("模型回复:\n", response.choices[0].message.content)

4.3.3 输出结果

模型回复:

图片中的产品是一款智能手表,主体为圆形表盘,表带为黑色硅胶材质。表盘上有多个功能按键,屏幕显示为彩色触摸屏。主要功能包括:

1. 健康监测:支持心率、血氧、睡眠质量检测;

2. 运动模式:包含跑步、游泳、骑行等多种运动模式;

3. 智能通知:可接收手机短信、电话、微信等通知;

4. 长续航:官方宣称续航时间可达7天;

5. 防水功能:支持IP68级防水,适合日常使用和轻度运动。

4.4 场景案例:电商产品的多模态描述

在电商平台中,多模态提示可以结合产品图片和文本描述,生成更生动的产品介绍。例如:

- 图片:智能手表的外观图;

- 文本提示:“请描述这款智能手表的设计风格和主要功能”;

- 模型输出:结合图片中的设计细节(如圆形表盘、硅胶表带)和功能(如心率监测、长续航),生成详细的产品描述。

五、可解释性设计:让提示“透明思考”

5.1 原理:从“黑盒输出”到“白盒推理”

大模型的“黑盒性”是其应用的重要障碍,可解释性设计的核心是让提示能“展示思考过程”,让用户理解模型的决策逻辑。常见的方法有:

- 思维链(Chain of Thought, CoT):在提示中加入“一步步思考”的引导,让模型输出推理步骤;

- 中间步骤显式化:要求模型输出中间结果(如“首先,我需要计算…;然后,我需要验证…”);

- 因果解释:要求模型解释“为什么”得到某个结果(如“因为用户提到了订单号,所以我需要查询订单状态”)。

5.2 数学模型:思维链的推理步骤

思维链的推理过程可以表示为状态转移:

s 0 → s 1 → s 2 → . . . → s n s_0 \rightarrow s_1 \rightarrow s_2 \rightarrow ... \rightarrow s_n s0→s1→s2→...→sn

其中:

- s 0 s_0 s0:初始状态(用户问题);

- s i s_i si:第 i i i步的中间状态(推理步骤);

- s n s_n sn:最终状态(答案)。

每个状态转移的条件是规则或知识(如“如果问题是关于订单的,那么需要订单号”)。

5.3 代码实战:用思维链提升可解释性

以下是用Python实现思维链提示的示例(以“数学问题解决”为例):

5.3.1 代码实现

import openai

def generate_cot_prompt(question: str) -> str:

"""生成思维链提示"""

return f"""

请解决以下问题,并一步步说明你的思考过程:

问题:{question}

思考过程:

1. 首先,我需要明确问题的类型(如代数、几何、概率);

2. 然后,回忆相关的公式或定理;

3. 接下来,代入已知条件进行计算;

4. 最后,验证结果是否正确。

答案:

"""

# 示例:解决代数问题

question = "解方程:3x + 5 = 14"

prompt = generate_cot_prompt(question)

# 调用OpenAI API

response = openai.ChatCompletion.create(

model='gpt-3.5-turbo',

messages=[{'role': 'user', 'content': prompt}]

)

print("模型回复:\n", response.choices[0].message.content)

5.3.2 输出结果

模型回复:

思考过程:

1. 首先,我需要明确问题的类型:这是一个一元一次方程求解问题。

2. 然后,回忆相关的公式或定理:一元一次方程的一般形式是ax + b = c,解为x = (c - b)/a。

3. 接下来,代入已知条件进行计算:

- 原方程:3x + 5 = 14

- 将常数项5移到右边:3x = 14 - 5 = 9

- 两边除以系数3:x = 9 / 3 = 3

4. 最后,验证结果是否正确:将x=3代入原方程,左边=3*3 +5=14,右边=14,等式成立。

答案:x=3

5.4 场景案例:医疗诊断的可解释性

在医疗诊断场景中,思维链提示可以让模型输出诊断的推理过程,比如:

- 问题:“患者有发烧、咳嗽、乏力的症状,可能是什么病?”;

- 思维链:“1. 首先,这些症状符合上呼吸道感染的表现;2. 然后,需要考虑是否有流行病学史(如接触过新冠患者);3. 接下来,建议进行核酸检测或抗原检测;4. 最后,根据检测结果确诊。”;

- 答案:“可能是上呼吸道感染,建议进行新冠检测。”

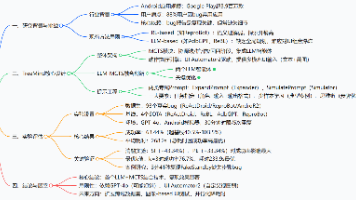

六、项目实战:构建智能提示引擎

6.1 项目目标

构建一个智能提示引擎,支持:

- 上下文感知:记住用户对话历史;

- 自适应优化:从用户反馈中学习;

- 场景化建模:支持多场景的提示模板;

- 可解释性:输出推理过程。

6.2 架构设计

用Mermaid绘制智能提示引擎的架构图:

graph TD

A[用户输入] --> B[上下文检索模块]

B --> C[场景化模板模块]

C --> D[提示生成模块]

D --> E[大语言模型(LLM)]

E --> F[结果输出模块]

F --> G[用户反馈模块]

G --> H[自适应优化模块]

H --> D[提示生成模块]

B -->|存储历史| I[向量数据库]

C -->|存储模板| J[模板库]

6.3 代码实现(核心模块)

6.3.1 上下文检索模块(参考第一章)

6.3.2 场景化模板模块(参考第三章)

6.3.3 自适应优化模块(参考第二章)

6.3.4 提示生成模块

def generate_intelligent_prompt(user_id: str, query: str, scene: str, template_name: str, **kwargs) -> str:

"""生成智能提示(整合上下文、场景化模板、自适应优化)"""

# 检索上下文

context = retrieve_context(user_id, query)

# 生成场景化提示

scene_prompt = generate_scene_prompt(scene, template_name, **kwargs)

# 整合上下文

intelligent_prompt = f"""

上下文历史:{'. '.join(context)}

{scene_prompt}

请结合上下文和场景要求,一步步思考并回答问题。

"""

# 自适应优化(根据之前的反馈调整提示)

optimized_prompt = adapt_prompt(intelligent_prompt, user_id) # adapt_prompt函数参考第二章

return optimized_prompt.strip()

6.4 测试与部署

- 测试:用不同场景的测试数据(如代码生成、文案写作)验证提示引擎的效果;

- 部署:将提示引擎封装为API(如用FastAPI),供前端应用调用。

七、工具与资源推荐

7.1 提示工程框架

- LangChain:支持上下文管理、思维链、多模态融合等功能,是构建智能提示引擎的首选框架;

- LlamaIndex:专注于文档检索与上下文整合,适合需要处理大量文本的场景;

- PromptFlow:微软推出的提示工程工具,支持可视化调试和优化。

7.2 向量数据库

- Pinecone:托管式向量数据库,支持快速检索和缩放;

- Weaviate:开源向量数据库,支持多模态数据存储;

- Chroma:轻量级开源向量数据库,适合本地开发。

7.3 模型与API

- OpenAI API:支持GPT-4V(多模态)、GPT-3.5-turbo(文本)等模型;

- Google Gemini API:支持多模态模型,适合需要处理图像、音频的场景;

- Anthropic Claude API:支持长上下文(最长100k tokens),适合复杂任务。

7.4 学习资源

- 《Prompt Engineering Guide》(在线指南):涵盖提示工程的基础和高级技巧;

- 《Mastering Prompt Engineering》(书籍):由OpenAI工程师编写,适合深入学习;

- YouTube教程:“Prompt Engineering for Developers”(由DeepLearning.AI推出)。

八、未来发展趋势与挑战

8.1 未来趋势

- 自动化提示生成:用大模型自动生成提示(如AutoPrompt、Prompt Generation API);

- 提示与模型协同优化:将提示优化与模型微调结合(如Prompt-Tuning、LoRA);

- 跨模态提示:支持更多模态(如视频、音频)的融合;

- 可解释性提示:用因果模型解释提示的效果(如Causal Prompting)。

8.2 挑战

- 长提示的性能问题:大模型的上下文窗口有限,长提示会占用更多tokens,导致成本上升和速度下降;

- 模型的局限性:有些任务需要领域知识,提示很难涵盖所有情况;

- 评估标准的缺失:目前还没有统一的标准来衡量提示的智能性(如准确性、相关性、适应性)。

结语:从“提示工程师”到“提示架构师”

提示工程的未来,不是“写更好的提示”,而是“设计更智能的提示系统”。作为提示架构师,我们需要从用户需求出发,结合上下文感知、自适应优化、场景化建模等策略,打造能“理解意图、自我进化、适配场景”的智能提示引擎。

希望本文分享的内部资料,能帮助你从“提示工程师”升级为“提示架构师”,在AI应用开发中占据先机。如果你有任何问题或想法,欢迎在评论区留言,我们一起探讨!

附录:代码仓库

本文所有代码示例均已上传至GitHub仓库:Intelligent-Prompt-Engineering,欢迎Star和Fork!

参考资料

- 《Prompt Engineering Guide》:https://www.promptingguide.ai/

- 《Mastering Prompt Engineering》:https://www.oreilly.com/library/view/mastering-prompt-engineering/9781098141848/

- OpenAI API文档:https://platform.openai.com/docs/introduction

- LangChain文档:https://python.langchain.com/docs/introduction

(注:本文中的代码示例均为简化版,实际应用中需要根据具体场景进行调整。)

更多推荐

已为社区贡献202条内容

已为社区贡献202条内容

所有评论(0)