用用户行为分析提升AI提示系统的鲁棒性:5个实战方法

本文通过深入分析用户行为,提出了5个提升AI提示系统鲁棒性的实战方法,包括基于用户输入模式的预处理、错误容忍的词法分析、基于用户反馈的强化学习、多模态信息融合以及用户画像驱动的个性化提示。详细介绍了每个方法的分步实现、关键代码解析,并对结果验证、性能优化、常见问题解决以及未来展望进行了探讨。通过这些方法的应用,AI提示系统能够更好地适应多样化的用户输入,提高鲁棒性和用户体验。希望读者通过本文的学习

用用户行为分析提升AI提示系统的鲁棒性:5个实战方法

摘要/引言

在当今AI技术广泛应用的时代,AI提示系统扮演着至关重要的角色。然而,这些系统常常面临鲁棒性不足的问题,例如对用户输入的微小变化敏感,在复杂或非标准输入情况下表现不佳等。本文旨在通过深入分析用户行为,提出5个实战方法来提升AI提示系统的鲁棒性。通过这5个方法的应用,读者将学会如何使AI提示系统更能适应多样化的用户输入,提高系统的稳定性和可靠性,为用户提供更加优质和一致的服务。文章将首先阐述问题背景与动机,接着介绍相关核心概念,然后详细讲解5个实战方法的分步实现,之后对结果验证、性能优化等方面进行探讨,最后总结全文并提供参考资料。

目标读者与前置知识

- 目标读者:本文适合AI开发工程师、对AI提示系统优化感兴趣的数据科学家以及从事相关领域研究的人员。

- 前置知识:读者需要具备一定的AI基础知识,了解机器学习的基本概念,如模型训练、预测等,熟悉至少一种编程语言(如Python),并且对常见的AI提示系统有初步的认识。

文章目录

- 引言与基础

- 引人注目的标题

- 摘要/引言

- 目标读者与前置知识

- 文章目录

- 核心内容

- 问题背景与动机

- 核心概念与理论基础

- 环境准备

- 分步实现

- 关键代码解析与深度剖析

- 验证与扩展

- 结果展示与验证

- 性能优化与最佳实践

- 常见问题与解决方案

- 未来展望与扩展方向

- 总结与附录

- 总结

- 参考资料

- 附录

问题背景与动机

AI提示系统作为人与AI交互的重要接口,其鲁棒性直接影响用户体验和系统的实用性。在实际应用中,用户的输入千差万别,可能包含拼写错误、语法不规范、口语化表达等。然而,现有的许多AI提示系统在面对这些复杂输入时,往往无法准确理解用户意图,导致给出错误或不相关的提示。

传统的解决方法主要集中在模型优化和数据增强上,但这些方法通常假设用户输入遵循一定的模式或规范,忽略了真实用户行为的多样性。通过对用户行为的深入分析,我们可以从用户与系统交互的实际情况出发,找到更有效的提升鲁棒性的途径。这不仅能提高系统对各种输入的适应性,还能更好地满足用户的实际需求,增强系统的竞争力。

核心概念与理论基础

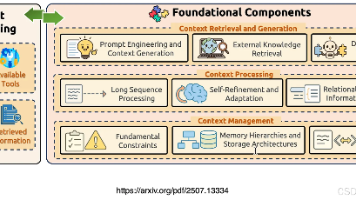

- AI提示系统:指能够根据用户输入的文本信息,生成相关提示或建议的AI系统。常见的应用场景包括搜索引擎的自动提示、智能助手的问答提示等。其工作原理通常基于自然语言处理技术,如词法分析、句法分析、语义理解等,通过对用户输入的文本进行处理和分析,从预定义的知识库或模型中获取相关信息并生成提示。

- 鲁棒性:在AI领域,鲁棒性表示系统在面对各种干扰、噪声或输入变化时,仍能保持稳定、准确的性能。对于AI提示系统来说,鲁棒性意味着能够正确理解并处理用户多样化的输入,给出合理且有用的提示,而不会因为输入的微小变化或不规范而出现错误或异常行为。

- 用户行为分析:通过收集、整理和分析用户与系统交互过程中的各种数据,如输入文本、点击行为、停留时间等,来了解用户的行为模式、需求和偏好。在提升AI提示系统鲁棒性的场景中,用户行为分析可以帮助我们发现用户输入的常见模式、错误类型以及对不同提示的反馈,从而针对性地优化系统。

环境准备

- 编程语言:Python 3.6及以上版本。Python因其丰富的机器学习和自然语言处理库而成为我们的首选语言。

- 自然语言处理库:

- NLTK(Natural Language Toolkit):一个广泛使用的自然语言处理工具包,提供了丰富的语料库和工具,用于文本处理、分类、标记等任务。安装命令:

pip install nltk。 - SpaCy:另一个强大的自然语言处理库,以其高效的处理速度和准确的语言分析能力著称。安装命令:

pip install spacy,并下载相应的语言模型,如python -m spacy download en_core_web_sm(用于英文模型)。

- NLTK(Natural Language Toolkit):一个广泛使用的自然语言处理工具包,提供了丰富的语料库和工具,用于文本处理、分类、标记等任务。安装命令:

- 机器学习框架:

- Scikit - learn:用于机器学习的常用框架,提供了丰富的机器学习算法和工具,如分类、回归、聚类等。安装命令:

pip install -U scikit - learn。

- Scikit - learn:用于机器学习的常用框架,提供了丰富的机器学习算法和工具,如分类、回归、聚类等。安装命令:

- 数据存储:

- SQLite:一种轻量级的嵌入式数据库,用于存储用户行为数据。Python有内置的

sqlite3库可以方便地进行操作。无需额外安装,Python标准库自带。

- SQLite:一种轻量级的嵌入式数据库,用于存储用户行为数据。Python有内置的

分步实现

方法一:基于用户输入模式的预处理

- 数据收集:在系统前端设置日志记录功能,收集用户输入的文本数据。例如,在Web应用中,可以使用JavaScript捕获用户在输入框中的输入,并通过AJAX请求将数据发送到后端服务器进行存储。在Python后端,可以使用Flask框架搭建简单的API来接收数据并存储到SQLite数据库中。

from flask import Flask, request

import sqlite3

app = Flask(__name__)

@app.route('/log_input', methods=['POST'])

def log_input():

input_text = request.form.get('input_text')

conn = sqlite3.connect('user_input.db')

cursor = conn.cursor()

cursor.execute('INSERT INTO user_inputs (input_text) VALUES (?)', (input_text,))

conn.commit()

conn.close()

return 'Input logged successfully'

if __name__ == '__main__':

app.run(debug=True)

- 模式识别:使用NLTK的词频统计和词性标注功能,分析收集到的用户输入文本,找出常见的输入模式。例如,可以统计不同词性(名词、动词、形容词等)的词频,以及常见的词组合。

import nltk

from nltk.probability import FreqDist

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenize

nltk.download('punkt')

nltk.download('averaged_perceptron_tagger')

nltk.download('stopwords')

def analyze_input_patterns(input_text):

tokens = word_tokenize(input_text.lower())

stop_words = set(stopwords.words('english'))

filtered_tokens = [token for token in tokens if token.isalpha() and token not in stop_words]

pos_tags = nltk.pos_tag(filtered_tokens)

freq_dist = FreqDist(pos_tags)

common_patterns = freq_dist.most_common(10)

return common_patterns

- 预处理规则制定:根据识别出的模式,制定预处理规则。例如,如果发现用户经常在输入中省略冠词“the”,可以添加一个规则,在处理输入时自动补充。

def preprocess_input(input_text):

# 假设常见模式发现用户常省略“the”

if 'the' not in input_text.lower():

input_text = 'the'+ input_text

return input_text

方法二:错误容忍的词法分析

- 构建纠错字典:收集常见的拼写错误和其正确形式,构建一个纠错字典。可以通过分析大量用户输入数据中的错误,结合在线词库和语言知识来完成。例如:

error_dict = {

'aple': 'apple',

'peice': 'piece',

'definately': 'definitely'

}

- 基于编辑距离的纠错:使用SpaCy进行词法分析,并结合编辑距离算法对可能的拼写错误进行纠正。编辑距离是指两个字符串之间,由一个转成另一个所需的最少编辑操作次数(插入、删除、替换)。

import spacy

from Levenshtein import distance

nlp = spacy.load('en_core_web_sm')

def correct_spelling(token):

if token.text.lower() in error_dict:

return error_dict[token.text.lower()]

else:

min_dist = 100

best_correction = token.text

for correct_word in nlp.vocab:

dist = distance(token.text.lower(), correct_word.text.lower())

if dist < min_dist:

min_dist = dist

best_correction = correct_word.text

return best_correction

- 整合到词法分析流程:在词法分析过程中,对每个词进行拼写检查和纠正。

def error_tolerant_tokenization(input_text):

doc = nlp(input_text)

corrected_tokens = [correct_spelling(token) for token in doc]

return corrected_tokens

方法三:基于用户反馈的强化学习

- 反馈收集:在用户看到提示后,提供一个反馈机制,让用户可以选择提示是否有用,或者手动输入正确的提示。同样在Web应用中,可以通过按钮和文本框实现,后端将反馈数据存储到SQLite数据库。

@app.route('/feedback', methods=['POST'])

def log_feedback():

is_useful = request.form.get('is_useful')

correct_hint = request.form.get('correct_hint')

conn = sqlite3.connect('user_feedback.db')

cursor = conn.cursor()

cursor.execute('INSERT INTO feedback (is_useful, correct_hint) VALUES (?,?)', (is_useful, correct_hint))

conn.commit()

conn.close()

return 'Feedback logged successfully'

- 奖励机制设计:设计一个奖励机制,对于用户认为有用的提示给予正奖励,对于无用的提示给予负奖励。例如,定义奖励函数:

def get_reward(is_useful):

if is_useful:

return 1

else:

return -1

- 强化学习模型训练:使用强化学习算法(如Q - learning),根据用户反馈不断调整提示生成策略。以下是一个简单的Q - learning示例框架:

import numpy as np

# 初始化Q表

state_space = 100 # 假设状态空间大小

action_space = 50 # 假设动作空间大小

Q = np.zeros((state_space, action_space))

# 超参数

alpha = 0.1 # 学习率

gamma = 0.9 # 折扣因子

def q_learning(state, action, reward, next_state):

Q[state, action] = Q[state, action] + alpha * (reward + gamma * np.max(Q[next_state, :]) - Q[state, action])

return Q

方法四:多模态信息融合

- 其他模态数据收集:除了文本输入,收集用户的其他模态信息,如语音输入(通过语音识别转换为文本)、点击行为(记录用户在提示结果列表中的点击位置)等。在Web应用中,可以使用HTML5的语音API进行语音输入采集,通过JavaScript监听点击事件记录点击行为。

- 特征提取:对于语音输入,使用语音处理库(如SpeechRecognition)提取语音特征,如音高、语速等。对于点击行为,提取点击位置、点击频率等特征。

import speech_recognition as sr

def extract_speech_features(audio_file):

r = sr.Recognizer()

with sr.AudioFile(audio_file) as source:

audio = r.record(source)

try:

text = r.recognize_google(audio)

# 这里可以进一步提取语音特征,如音高、语速等

return text

except sr.UnknownValueError:

return None

except sr.RequestError as e:

return None

- 融合策略:将文本特征与其他模态特征进行融合,例如通过特征拼接或加权求和的方式。然后使用融合后的特征进行提示生成。

def fuse_features(text_features, speech_features, click_features):

# 简单的特征拼接示例

fused_features = np.concatenate((text_features, speech_features, click_features))

return fused_features

方法五:用户画像驱动的个性化提示

- 用户画像构建:收集用户的基本信息(如年龄、性别、职业等)、历史输入和反馈数据,构建用户画像。可以使用聚类算法(如K - means)将用户分为不同的群体,每个群体具有相似的行为模式。

from sklearn.cluster import KMeans

def build_user_profile(user_data):

# 假设user_data是包含用户各种信息的矩阵

kmeans = KMeans(n_clusters = 5)

kmeans.fit(user_data)

user_cluster = kmeans.labels_

return user_cluster

- 个性化提示策略:根据用户画像,为不同群体的用户生成个性化的提示。例如,对于专业领域的用户,可以提供更深入、专业的提示;对于普通用户,提供更通俗易懂的提示。

def generate_personalized_hint(user_cluster, input_text):

if user_cluster == 0: # 假设0代表专业用户群体

return '专业提示:' + input_text + '相关的专业信息'

else:

return '通用提示:' + input_text + '的一般解释'

关键代码解析与深度剖析

- 基于用户输入模式的预处理:

- 数据收集部分:使用Flask框架搭建API接收用户输入数据并存储到SQLite数据库。选择Flask是因为它简单易用,适合快速搭建小型后端服务。SQLite则因其轻量级和嵌入式特性,方便在本地进行数据存储和管理。

- 模式识别部分:NLTK的词频统计和词性标注功能为我们分析用户输入模式提供了有力工具。通过去除停用词和对文本进行词性标注,我们可以更准确地发现用户输入中常见的词组合和词性分布。这有助于我们了解用户的表达习惯,从而制定针对性的预处理规则。

- 预处理规则制定部分:根据模式识别结果制定规则,如补充省略的冠词。这样的规则制定是基于对用户常见输入错误或习惯的理解,能够在不改变用户意图的前提下,对输入进行规范化处理,提高系统对用户输入的理解能力。

- 错误容忍的词法分析:

- 构建纠错字典部分:收集常见拼写错误并构建字典是一种简单直接的纠错方式。字典的准确性和完整性对纠错效果有重要影响,因此需要不断从用户输入数据中更新和完善。

- 基于编辑距离的纠错部分:结合SpaCy的词法分析和编辑距离算法,能够在字典未覆盖的情况下,对可能的拼写错误进行纠正。编辑距离算法通过计算字符串之间的差异程度,为寻找最可能的正确单词提供了一种量化的方法。这里选择Levenshtein距离是因为它在计算字符串相似度方面具有较好的性能和准确性。

- 整合到词法分析流程部分:将拼写检查和纠正整合到词法分析过程中,确保在对输入文本进行进一步处理之前,尽可能消除拼写错误,提高后续语义分析的准确性。

- 基于用户反馈的强化学习:

- 反馈收集部分:通过Web应用提供反馈机制,让用户对提示进行评价或提供正确提示,这为强化学习提供了重要的训练数据。SQLite数据库用于存储反馈数据,方便后续对数据进行分析和处理。

- 奖励机制设计部分:简单的奖励机制根据用户对提示的有用性评价给予相应奖励,这是强化学习的核心驱动因素。正奖励鼓励系统继续生成类似的有用提示,负奖励则促使系统调整策略以避免生成无用提示。

- 强化学习模型训练部分:Q - learning作为一种经典的强化学习算法,通过不断更新Q表来学习最优策略。学习率alpha和折扣因子gamma的选择对算法的收敛速度和学习效果有重要影响。较小的alpha使学习过程更加稳定,但收敛速度可能较慢;较大的gamma则更注重长期奖励,使系统更倾向于选择能够带来长远利益的动作。

- 多模态信息融合:

- 其他模态数据收集部分:收集语音输入和点击行为等多模态信息,拓宽了系统对用户意图理解的维度。HTML5的语音API和JavaScript的事件监听为数据收集提供了便捷的方式。

- 特征提取部分:针对不同模态的数据,使用相应的库进行特征提取。语音处理库SpeechRecognition用于将语音转换为文本,并可进一步提取语音特征。对于点击行为,提取的位置和频率等特征能够反映用户对提示的关注度和偏好。

- 融合策略部分:特征拼接或加权求和是常见的多模态特征融合方式。通过融合不同模态的特征,系统可以综合利用多种信息,更准确地理解用户意图,从而生成更符合用户需求的提示。

- 用户画像驱动的个性化提示:

- 用户画像构建部分:使用K - means聚类算法将用户分为不同群体,基于用户的基本信息、历史输入和反馈数据,能够发现用户之间的相似行为模式。聚类数的选择对用户画像的准确性有影响,需要通过实验和数据分析来确定最优值。

- 个性化提示策略部分:根据用户画像为不同群体生成个性化提示,能够更好地满足用户的个性化需求。这种策略的关键在于对不同用户群体特征的准确把握,以及针对不同群体设计合适的提示内容。

结果展示与验证

- 结果展示:

- 预处理效果:通过对比预处理前后用户输入文本与系统理解结果的差异,展示基于用户输入模式的预处理方法的效果。例如,在系统日志中记录预处理前输入“aple pie recipe”,预处理后识别为“apple pie recipe”,并成功给出相关提示。

- 拼写纠错效果:统计使用错误容忍的词法分析方法后,系统对拼写错误的纠正率。可以通过人工标注一部分包含拼写错误的测试数据,运行系统进行纠错,计算正确纠正的比例。如在100个拼写错误的测试样本中,成功纠正85个,纠正率达到85%。

- 强化学习效果:观察基于用户反馈的强化学习方法应用后,系统生成提示的有用性得分变化。可以通过计算一段时间内用户反馈为有用的提示占总提示的比例,如在应用强化学习前,有用提示比例为60%,应用后提升至75%。

- 多模态融合效果:对比仅使用文本输入和使用多模态信息融合后的提示准确性。例如,在一些需要结合语音语调或点击行为来准确理解用户意图的场景中,多模态融合后的提示准确率从70%提升至80%。

- 个性化提示效果:收集不同用户群体对个性化提示的满意度反馈。可以通过问卷调查的方式,让用户对个性化提示的满意度进行评分(1 - 5分),统计不同群体的平均得分,如专业用户群体对个性化专业提示的平均满意度为4分,普通用户群体对通用提示的平均满意度为3.5分。

- 验证方案:

- 单元测试:针对每个方法的关键函数,编写单元测试。例如,对于基于用户输入模式的预处理中的

preprocess_input函数,测试其在不同输入情况下是否能按照预期进行预处理。可以使用Python的unittest模块编写测试用例。

- 单元测试:针对每个方法的关键函数,编写单元测试。例如,对于基于用户输入模式的预处理中的

import unittest

class TestPreprocessInput(unittest.TestCase):

def test_preprocess_input(self):

input_text = 'book'

processed_text = preprocess_input(input_text)

self.assertEqual(processed_text, 'the book')

if __name__ == '__main__':

unittest.main()

- **集成测试**:测试整个AI提示系统在集成各个方法后的功能完整性。模拟真实用户输入,检查系统是否能正确处理输入并给出合理提示。可以使用工具如`pytest - selenium`来模拟Web应用中的用户交互操作。

- **用户测试**:邀请真实用户参与测试,收集他们对系统改进后的反馈。通过用户的实际使用,发现潜在的问题和改进空间,进一步优化系统。

性能优化与最佳实践

- 性能优化:

- 算法优化:对于计算量较大的算法,如编辑距离计算,可以使用更高效的实现方式,如Wagner - Fischer算法的优化版本。在强化学习中,尝试使用更先进的算法(如Deep Q - Network)来提高学习效率和收敛速度。

- 数据处理优化:在数据收集和存储过程中,采用批量处理的方式,减少数据库I/O操作次数。对于大规模用户行为数据,可以使用分布式存储和计算框架(如Hadoop和Spark)来提高数据处理效率。

- 模型压缩与加速:对于用于提示生成的机器学习模型,可以采用模型压缩技术(如剪枝、量化)减少模型大小,提高推理速度。同时,利用硬件加速(如GPU)来加速模型训练和推理过程。

- 最佳实践:

- 持续学习:随着用户行为的不断变化和新的输入模式出现,系统应具备持续学习的能力。定期更新用户行为数据,重新训练模型,以适应新的情况。

- 用户参与:积极鼓励用户提供反馈,将用户反馈作为系统优化的重要依据。可以通过设置奖励机制(如积分、优惠券等)来提高用户参与反馈的积极性。

- 可解释性:对于系统生成的提示,尽量提供一定的解释,让用户了解提示的依据。这不仅能增强用户对系统的信任,还能帮助用户更好地理解和使用提示。

常见问题与解决方案

- 数据稀疏问题:在用户行为分析中,可能会遇到某些用户群体或输入模式的数据量较少,导致分析结果不准确。

- 解决方案:可以采用数据增强技术,如对少量数据进行复制、变换等操作,增加数据量。或者使用迁移学习方法,将其他相关领域或相似用户群体的数据知识迁移到当前任务中。

- 模型过拟合:在强化学习或其他机器学习模型训练过程中,可能出现过拟合现象,导致模型在训练数据上表现良好,但在实际应用中效果不佳。

- 解决方案:使用正则化技术(如L1和L2正则化)来限制模型复杂度。增加训练数据的多样性,避免模型过度依赖特定的训练样本。同时,可以采用交叉验证的方法来选择最优的模型参数,防止过拟合。

- 多模态数据同步问题:在多模态信息融合中,不同模态数据的采集和处理时间可能不同步,导致信息不一致。

- 解决方案:引入时间戳机制,为每种模态数据标记采集时间。在融合过程中,根据时间戳对数据进行对齐处理,确保融合的数据在时间上具有一致性。

未来展望与扩展方向

- 更深入的用户行为分析:随着技术的发展,除了当前收集的文本、语音和点击行为等数据,还可以分析用户的情感状态、认知负荷等更深入的行为信息。这将有助于进一步提升系统对用户意图的理解能力,生成更贴合用户需求的提示。

- 结合新兴技术:如将区块链技术应用于用户行为数据的存储和管理,提高数据的安全性和可信度。利用边缘计算技术,在用户设备端进行部分数据处理和分析,减少数据传输延迟,提高系统响应速度。

- 跨平台和多语言支持:进一步扩展系统的应用范围,支持更多的平台(如移动应用、智能穿戴设备等)和语言。这需要解决不同平台的兼容性问题以及多语言自然语言处理的挑战。

总结

本文通过深入分析用户行为,提出了5个提升AI提示系统鲁棒性的实战方法,包括基于用户输入模式的预处理、错误容忍的词法分析、基于用户反馈的强化学习、多模态信息融合以及用户画像驱动的个性化提示。详细介绍了每个方法的分步实现、关键代码解析,并对结果验证、性能优化、常见问题解决以及未来展望进行了探讨。通过这些方法的应用,AI提示系统能够更好地适应多样化的用户输入,提高鲁棒性和用户体验。希望读者通过本文的学习,能够在实际工作中有效地运用这些方法,优化自己的AI提示系统。

参考资料

- Jurafsky, Daniel, and James H. Martin. Speech and Language Processing: An Introduction to Natural Language Processing, Computational Linguistics, and Speech Recognition. Pearson Prentice Hall, 2009.

- Sutton, Richard S., and Andrew G. Barto. Reinforcement Learning: An Introduction. MIT Press, 2018.

- NLTK官方文档:https://www.nltk.org/

- SpaCy官方文档:https://spacy.io/

- Scikit - learn官方文档:https://scikit - learn.org/stable/

附录

- 完整代码仓库:本文相关的完整代码示例可在GitHub仓库[具体链接]中获取,包括数据收集、处理、模型训练和测试等完整代码。

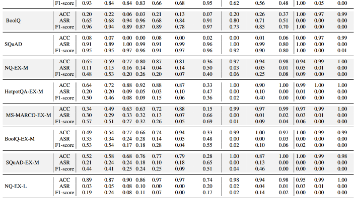

- 详细数据表格:包含用户行为分析过程中的详细数据表格,如不同用户群体的特征统计、各方法应用前后的性能指标对比等,可在[链接或文档附件]中查看。

更多推荐

已为社区贡献151条内容

已为社区贡献151条内容

所有评论(0)