vLLM API 服务启动日志详解

本文解析了vLLM API服务启动日志的功能。当执行vLLM服务启动命令后,终端会输出服务地址(http://0.0.0.0:8000)和可用API路由列表,包括系统路由、基础功能、大模型接口等。日志显示服务进程ID(2520)和启动完成状态,表明API服务已就绪,可通过指定端口访问交互式文档或调用各类模型接口。这些日志信息帮助用户了解服务运行状态和可用功能。

当我们使用vLLM终端命令行“VLLM_USE_MODELSCOPE=true vllm serve /root/autodl-tmp/Qwen/Qwen3-8B --served-model-name Qwen3-8B --max_model_len 8192 --reasoning-parser deepseek_r1”,调用API服务路由时,在终端会输出一些系列API服务日志,本篇文章将会解析其中的日志有什么作用。

第一步:调用VLLM_USE_MODELSCOPE=true vllm serve /root/autodl-tmp/Qwen/Qwen3-8B --served-model-name Qwen3-8B --max_model_len 8192 --reasoning-parser deepseek_r1

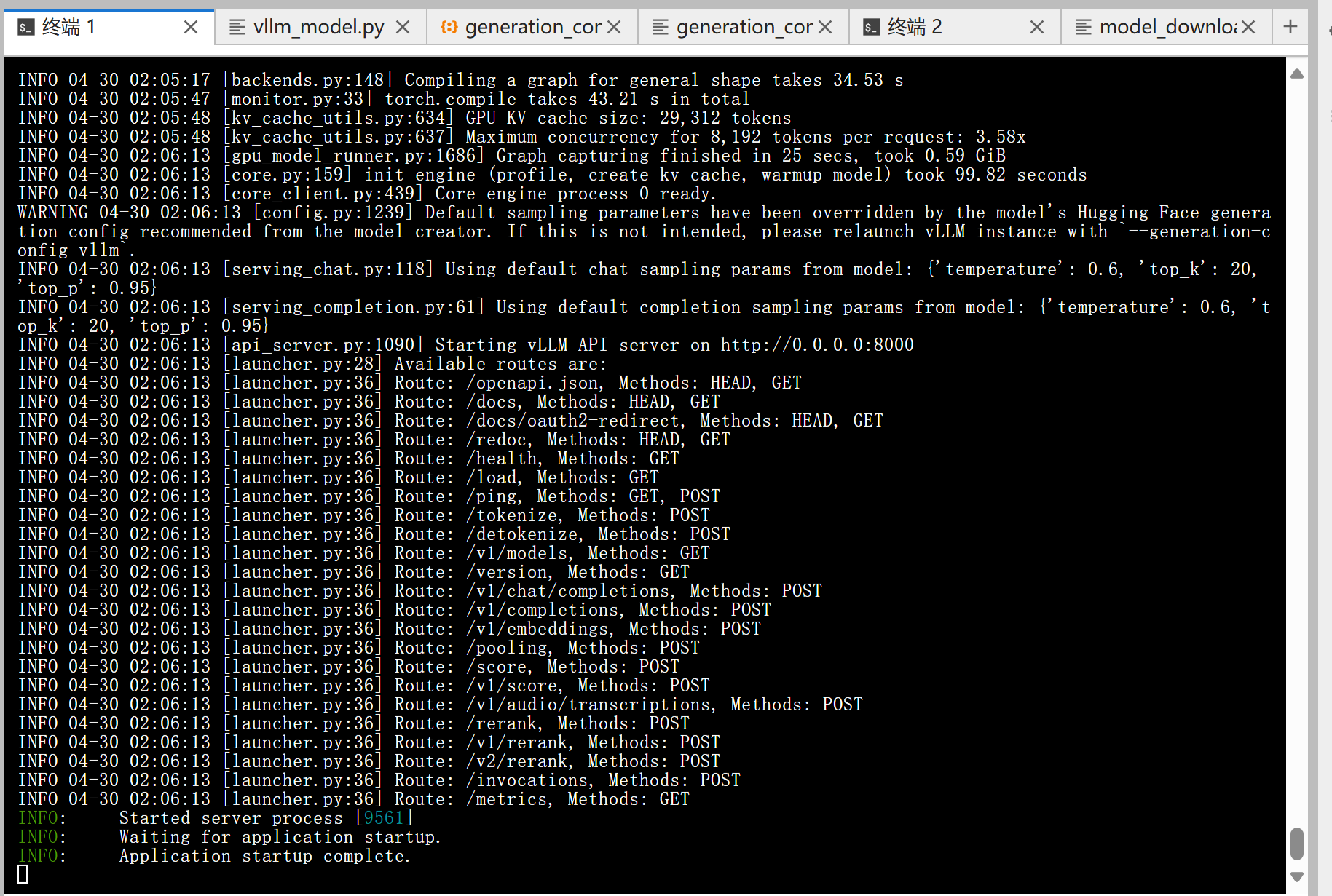

第二步:终端输出一系列vLLM API 服务启动日志,它在告诉你服务启动成功了,并且有哪些 API 路由 (endpoints) 可以调用,如下图所示

逐条解析如下:

1. 启动信息

(APIServer pid=2520) INFO 09-24 11:04:27 [api_server.py:1019] Starting vLLM API server 0 on http://0.0.0.0:8000

-

APIServer pid=2520:说明这是一个进程 ID(2520)对应的 API 服务。

-

**http://0.0.0.0:8000**:服务监听的地址,`0.0.0.0` 表示对所有网络接口开放,端口是

8000。

👉 也就是说你可以在本机通过http://localhost:8000或者在同一局域网其他机器用http://<你的IP>:8000访问。

2. 路由列表

接下来日志一条条列出了可用的 HTTP 路径 (API endpoints) 和对应的 方法 (GET, POST, HEAD)。

常见的系统路由

-

/openapi.json→ 返回 OpenAPI 规范,描述所有 API。 -

/docs→ Swagger UI 文档 (可视化交互式 API 页面)。 -

/redoc→ ReDoc 文档界面。 -

/health→ 健康检查 (GET)。 -

/metrics→ Prometheus 监控指标 (GET)。

基础功能

-

/tokenize(POST) → 将文本转换成 token。 -

/detokenize(POST) → 将 token 转回文本。 -

/v1/models(GET) → 查看已加载的模型列表。 -

/version(GET) → 返回 vLLM 版本号。

核心大模型接口 (兼容 OpenAI 风格)

-

/v1/completions(POST) → 传统的 completion 接口(给 prompt,返回生成的文本)。 -

/v1/chat/completions(POST) → Chat 接口(支持 role-based 格式)。 -

/v1/embeddings(POST) → 向量 embedding 生成。 -

/v1/audio/transcriptions(POST) → 语音转文字 (ASR)。 -

/v1/audio/translations(POST) → 语音翻译。

增强功能

-

/v1/responses(POST) → 新版统一接口 (experimental),更强大,支持多模态/流式响应。 -

/rerank,/v1/rerank,/v2/rerank(POST) → 语义排序接口。 -

/classify(POST) → 分类接口。 -

/score,/v1/score(POST) → 打分接口,比如评估生成的质量。 -

/pooling(POST) → 向量池化 (比如 mean pooling)。 -

/invocations(POST) → 通用调用入口。

伸缩/弹性相关

-

/scale_elastic_ep,/is_scaling_elastic_ep→ 和 弹性推理(elastic endpoint) 有关。 -

/load(GET),/ping(POST/GET) → 服务负载与连通性检查。

3. 最后几行

(APIServer pid=2520) INFO: Started server process [2520]

(APIServer pid=2520) INFO: Waiting for application startup.

(APIServer pid=2520) INFO: Application startup complete.

-

Started server process:说明 Flask/FastAPI 后端启动了。

-

Application startup complete:服务完全就绪,可以开始请求 API。

✅ 总结:

这段输出的意思是 vLLM API 服务已经启动并监听在 http://0.0.0.0:8000,并且列出了所有可用的 API 路由。

-

你可以在浏览器访问

http://localhost:8000/docs打开交互式文档。 -

如果要调用模型,可以直接用

curl或 Python 调用http://localhost:8000/v1/chat/completions这样的接口。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)