全面解读大模型数据蒸馏---基于架构优化的蒸馏LLaVA-MoD

全面解读大模型数据蒸馏---基于架构优化的蒸馏参考论文:LLaVA-MoD: Making LLaVA Tiny via MoE Knowledge Distillation论文地址:https://arxiv.org/pdf/2408.15881github代码地址:https://github.com/shufangxun/LLaVA-MoD这类方法通过优化学生模型的结构来提高知识蒸馏效率,其

全面解读大模型数据蒸馏—基于架构优化的蒸馏

参考论文:LLaVA-MoD: Making LLaVA Tiny via MoE Knowledge Distillation

论文地址:https://arxiv.org/pdf/2408.15881

github代码地址:https://github.com/shufangxun/LLaVA-MoD

这类方法通过优化学生模型的结构来提高知识蒸馏效率,其中最引人注目的是引入稀疏专家混合(MoE)架构。LLaVA-MoD是这一方向的代表工作,它采用了创新的Dense-to-Sparse蒸馏框架。

LLaVA-MoD的核心思想是将教师模型的知识分解为通用知识和专业知识,分阶段进行蒸馏。在第一阶段(模仿蒸馏),学生模型学习教师模型的通用视觉-语言表示;在第二阶段(偏好蒸馏),学生模型学习生成与教师模型偏好一致的输出,减少幻觉。这种方法仅需使用0.3%的数据和23%的激活参数,就能使2B参数的小模型在综合性能上超越7B大模型8.8%,并且在幻觉检测任务中反超教师模型。

这篇解读会带你一步步了解LLaVA-MoD这项让大模型“瘦身”的技术。下面这个表格汇总了它的核心情况,方便你快速把握全局。

| 方面 | 核心内容 |

|---|---|

| 核心目标 | 让强大的多模态大模型(能看懂图、理解文的"天才")变得小巧高效,能在普通设备上运行。 |

| 解决难题 | 1. 如何设计小模型:既能吸收老师的复杂知识,又保持轻量级身材。 2. 如何高效教学生:把老师的"毕生所学"完整有效地传授给小模型。 |

| 技术核心 | 1. 稀疏混合专家(Sparse MoE):给小模型配备一个"专家团队",需要时才调用,省时省力。 2. 渐进式知识蒸馏:分两步教学,先"模仿"再"超越"。 |

| 关键结果 | 仅用0.3% 的训练数据、23% 的可训练参数,2B参数的小模型性能反超7B参数的大模型8.8%,并在减少"幻觉"(胡说八道)上表现更好。 |

| 应用场景 | 手机、平板等移动设备上的智能助手,边缘计算设备(如智能摄像头、车载系统),以及其他计算资源受限但对实时性要求高的场景。 |

🔍 一、要解决什么问题?

多模态大模型(MLLM)功能强大,但庞大的体积和计算需求使其难以在手机等普通设备上运行。直接按比例缩小模型会严重损失其能力。LLaVA-MoD的核心目标就是解决这一矛盾:如何让一个小模型既能拥有大模型的核心能力,又能保持小巧高效。它主要应对两个挑战:

- 小模型架构设计:如何设计一个轻量级的模型结构,使其有足够的"容量"去吸收和理解大模型传来的复杂知识。

- 知识转移效率:如何将大模型中蕴含的丰富知识(包括通用知识、专业知识甚至价值判断)高效、完整地蒸馏到小模型中。

🧠 二、核心概念快速理解

理解LLaVA-MoD,需要先了解三个关键概念:

- 多模态大模型:能同时理解和处理多种类型信息(如文字、图片、声音)的AI模型。例如,你给它一张图片,它能用文字描述图片内容。

- 知识蒸馏:一种机器学习技术,类似于"师傅带徒弟"。让一个已经训练好的、能力强大的大模型(“教师模型”)去指导一个小模型(“学生模型”)学习。目标是让小模型用更少的资源,达到接近大模型的性能。

- 混合专家:一种模型设计思路。想象一下,不是让一个"全才"处理所有问题,而是组建一个由多位"专家"构成的团队,每位专家擅长特定领域。遇到问题时,由一个"调度员"决定请哪位或哪几位专家来处理。这样做的好处是,不需要每次都动用所有专家,从而大大提高效率。LLaVA-MoD采用的是稀疏混合专家,意思是每次只激活极少数的专家(比如Top-1或Top-2),实现极致的效率。

⚙️三、 LLaVA-MoD的运作方式

LLaVA-MoD的解决方案可以概括为"一个好架构"加上"一套好教法"。

1. 给小模型一个“专家团队”

传统的做法是直接缩小大模型,这好比让一个学生自学所有科目,负担重且深度不够。LLaVA-MoD则不同,它为学生模型(s-MLLM)的语言模型部分引入了稀疏混合专家架构。

- 专家分工:它将模型中的某些核心部件复制多份,每一份成为一个"专家"。

- 智能路由:引入一个"路由器",针对不同输入问题,动态选择最相关的一位或几位专家来工作。

- 效果:这相当于为小模型配备了一个"专家顾问团",可以根据任务需求精准调用知识,既保证了处理复杂任务的能力,又因为每次只激活部分专家而极大地节省了计算资源。

2. 循序渐进的“两阶段教学法”

有了好的学生胚子,还需要好的教学方法。LLaVA-MoD采用了一种渐进式蒸馏策略,分两步将教师模型的知识传授给学生。

-

第一阶段:模仿蒸馏 - “打好基础,专项突破”

这个阶段目标是让学生掌握老师的基础知识和专业技能,又分为两步:- 密集到密集蒸馏:此时学生模型还是一个普通的密集模型。使用通用的图像-文本对数据,让学生模仿老师的整体输出,学习通用性知识,打好底子。

- 密集到稀疏蒸馏:将学生模型切换到前面设计好的MoE稀疏架构。使用更复杂的多任务数据,让不同的"专家"去学习老师在不同专业领域(如视觉问答、文档理解)的特长。这一步是"专项突破"。

-

第二阶段:偏好蒸馏 - “学习判断,明辨对错”

这一步的目标是让学生不仅知道"是什么",还要学会"好不好",从而减少生成错误或虚构信息(即"幻觉")。这个过程受到直接偏好优化(DPO) 的启发。- 方法是给学生模型提供一些成对的示例,包括老师认为的"好的回答"和"不好的回答"。

- 训练目标是调整学生模型,使其为"好答案"分配的概率远高于"坏答案"。

- 这相当于老师教学生明辨是非,使得最终的小模型不仅在事实性上表现更好,甚至在减少幻觉方面能超越它的老师。

💡 四、创新、效果与应用

主要创新点

- 架构创新:将稀疏MoE架构成功应用于多模态小模型的设计,巧妙地在模型容量和计算效率之间取得平衡。

- 方法论创新:提出了 "模仿蒸馏+偏好蒸馏"的渐进式蒸馏框架,特别是将偏好优化引入多模态蒸馏,显著提升了小模型的可靠性和对齐能力。

实验结果

论文中的实验数据充分展示了其有效性:

- 资源消耗极低:仅需0.3% 的训练数据和23% 的可训练参数。

- 性能实现反超:其2B参数的小模型在多个多模态基准测试中,平均性能反而超过了7B参数的大模型(Qwen-VL-Chat-7B)8.8%。

- 抗幻觉能力更强:在幻觉检测基准上,其表现甚至优于使用了强化学习人类反馈的模型。

应用场景

这项技术让高性能的多模态AI在资源受限的场景中应用成为可能:

- 移动智能终端:在手机、平板电脑上运行强大的多模态助手,进行图片分析、问答等,更好地保护用户隐私。

- 边缘计算:部署在智能摄像头、车载系统、物联网设备上,实现低延迟、高效率的本地化视觉语言理解。

⚠️ 注意事项

尽管LLaVA-MoD取得了显著效果,但在实际应用中仍需考虑以下几点:

- 教师模型依赖性:学生模型的天花板很大程度上受限于教师模型的能力。如果教师模型在某些方面存在偏见或能力不足,也会直接影响学生模型。

- 路由机制挑战:MoE中的路由机制是关键技术,如何确保路由的稳定性、公平性(防止某些专家被过度使用或闲置)是需要持续研究的问题。

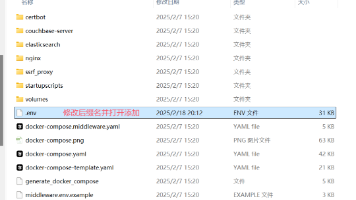

- 代码与复现:虽然论文已开源代码,但在实际部署和微调时,可能会遇到特定的环境配置、数据预处理等问题。

希望以上解读能帮助你全面了解LLaVA-MoD这项有趣的工作。如果你对某个具体的技术细节(比如DPO的具体损失函数形式)或者如何复现实验感兴趣,我们可以继续深入探讨。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)