《探索AI应用架构师:开启AI驱动数字转型的无限可能》

本文将以"AI应用架构师"为核心,从角色定位、核心能力、架构设计方法论到实战案例,全方位拆解这一新兴技术岗位如何成为企业AI驱动数字转型的"桥梁"与"引擎"。AI应用架构师与传统架构师、算法工程师有何本质区别?一个支撑业务规模化落地的AI应用架构,需要包含哪些核心组件?如何从0到1设计一套既满足当前需求、又具备扩展性的AI应用架构?面对数据孤岛、模型部署复杂、算力成本失控等挑战,AI应用架构师如何

探索AI应用架构师:开启AI驱动数字转型的无限可能

1. 标题 (Title)

以下是5个吸引人的标题选项,突出核心关键词"AI应用架构师"与"数字转型":

- 《AI应用架构师实战指南:从技术落地到驱动企业数字转型》

- 《解密AI应用架构师:打造支撑业务增长的智能系统架构》

- 《从0到1成为AI应用架构师:破解AI驱动数字转型的技术密码》

- 《AI应用架构师必读:构建稳健、可扩展的AI驱动业务系统》

- 《数字转型的幕后推手:AI应用架构师的核心能力与实践路径》

2. 引言 (Introduction)

痛点引入 (Hook)

“我们投入了数百万训练AI模型,准确率高达95%,但为什么业务部门还是抱怨‘用不起来’?”

“数据团队和算法团队各自为战,模型训练完就‘躺平’在服务器上,如何让AI真正融入业务流程?”

“企业数字化转型喊了多年,AI项目却总是‘试点成功,规模化失败’——问题到底出在哪里?”

如果你是技术负责人、架构师或AI从业者,这些问题或许并不陌生。在AI技术爆发的今天,企业对"AI驱动数字转型"的需求空前迫切,但**“有AI模型"≠"能创造价值”**。许多企业困于"模型与业务脱节"“技术架构支撑不足”“数据治理混乱"等问题,导致AI项目沦为"实验室成果”,无法转化为实际业务增长。

这一切的核心症结,往往在于缺乏一位能打通"AI技术-业务需求-系统架构"的关键角色——AI应用架构师。

文章内容概述 (What)

本文将以"AI应用架构师"为核心,从角色定位、核心能力、架构设计方法论到实战案例,全方位拆解这一新兴技术岗位如何成为企业AI驱动数字转型的"桥梁"与"引擎"。我们将回答:

- AI应用架构师与传统架构师、算法工程师有何本质区别?

- 一个支撑业务规模化落地的AI应用架构,需要包含哪些核心组件?

- 如何从0到1设计一套既满足当前需求、又具备扩展性的AI应用架构?

- 面对数据孤岛、模型部署复杂、算力成本失控等挑战,AI应用架构师如何破局?

读者收益 (Why)

读完本文,你将获得:

✅ 角色认知升级:清晰理解AI应用架构师的职责边界与价值定位,明确自身在AI项目中的成长方向;

✅ 架构设计方法论:掌握"业务需求→数据层→模型层→应用层→部署运维"的全链路AI架构设计思路;

✅ 实战落地能力:通过真实案例(智能推荐系统、工业质检平台)学习如何规避AI项目常见的架构陷阱;

✅ 技术选型框架:建立"数据存储-模型训练-推理部署-监控治理"全流程的技术选型决策逻辑;

✅ 数字转型视角:从企业战略层面理解AI架构如何支撑业务规模化、可持续增长,而非单纯的技术炫技。

3. 准备工作 (Prerequisites)

在深入探索AI应用架构师的世界前,建议你具备以下基础知识与经验,以便更好地理解本文内容:

技术栈/知识基础

- 软件工程与架构设计基础:了解传统应用架构(如微服务、分布式系统)的核心概念(服务拆分、API设计、数据一致性等);

- AI/ML基础认知:无需深入算法细节,但需知道常见机器学习模型类型(分类/回归/深度学习)、数据处理流程(清洗、特征工程、标注)、模型训练与推理的基本概念;

- 数据技术基础:了解结构化/非结构化数据存储方案(关系型数据库、数据湖、对象存储)、ETL/ELT流程、数据仓库设计原则;

- 云计算与DevOps概念:熟悉云服务(IaaS/PaaS/SaaS)、容器化(Docker)、编排工具(Kubernetes)、CI/CD流程的基本逻辑。

实践经验(加分项)

- 参与过至少一个AI相关项目(如数据标注、模型训练、API开发等),了解AI项目的典型生命周期;

- 遇到过AI项目落地问题(如模型部署延迟、数据获取困难、业务部门不配合等),有解决实际问题的思考。

4. 核心内容:AI应用架构师的实战指南

4.1 认知升级:AI应用架构师的角色与价值定位

4.1.1 从"技术实现"到"价值交付":AI应用架构师的独特性

传统架构师聚焦于"系统稳定性与性能",算法工程师聚焦于"模型准确率与训练效率",而AI应用架构师的核心使命是"让AI技术以可持续的方式创造业务价值"。

具体来说,AI应用架构师需要回答三个关键问题:

- “AI能解决什么业务问题?”:从业务需求中提炼可落地的AI场景(如"降低客服成本"→"智能客服对话系统"),而非为了AI而AI;

- “如何设计架构支撑AI场景规模化落地?”:平衡"模型效果"“系统性能”“开发效率”“成本控制”,确保AI功能能稳定、高效地融入现有业务流程;

- “如何让AI系统持续进化?”:设计数据反馈闭环、模型迭代机制,让AI系统随业务变化不断优化,避免"一锤子买卖"。

4.1.2 AI应用架构师的3大核心职责

- 业务与技术的翻译者:将业务需求(如"提升用户留存率")转化为技术可实现的AI目标(如"构建个性化推荐系统,CTR提升20%“),同时向业务方解释技术边界(如"实时推荐需要3秒延迟,受限于当前算力”);

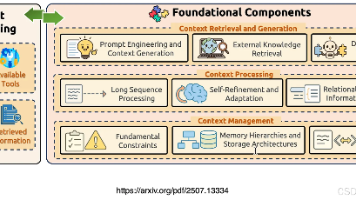

- AI系统的总设计师:设计端到端架构,包括数据层(数据采集、存储、治理)、模型层(训练、推理、优化)、应用层(API设计、业务集成)、运维层(监控、告警、成本控制);

- 跨团队协作的推动者:协调数据团队(数据采集/标注)、算法团队(模型训练)、工程团队(系统开发)、业务团队(需求对接),打破"数据孤岛"“技术壁垒”,确保AI项目全链路顺畅推进。

4.1.3 与其他角色的协作边界(附协作流程图)

为避免职责重叠,AI应用架构师需明确与其他角色的分工:

| 角色 | 核心职责 | AI应用架构师的协作点 |

|---|---|---|

| 业务产品经理 | 定义业务需求、用户场景、指标 | 共同评估AI技术可行性,明确架构设计的业务约束 |

| 数据工程师 | 数据采集、清洗、存储、治理 | 设计数据架构,提出数据质量与访问效率要求 |

| 算法工程师 | 模型选型、训练、优化(准确率) | 定义模型接口规范,协调推理性能与部署成本 |

| 后端工程师 | API开发、业务系统集成 | 设计服务拆分与接口协议,确保AI能力无缝接入 |

| DevOps工程师 | 部署、监控、运维 | 制定AI系统的部署策略(如容器化、弹性伸缩) |

协作流程示例:

业务产品经理提出"智能推荐需求" → AI应用架构师评估技术可行性,输出《AI架构设计方案》 → 数据工程师按架构要求准备用户行为数据 → 算法工程师基于数据训练推荐模型 → 后端工程师调用模型API开发推荐接口 → DevOps工程师按架构设计部署系统 → AI应用架构师全程监控各环节是否符合架构约束。

4.2 核心能力:AI应用架构师的"硬技能"与"软技能"

成为AI应用架构师,需同时具备"技术深度"与"业务广度",以下是必须掌握的6大核心能力:

4.2.1 业务需求解析能力:从"模糊需求"到"清晰目标"

核心挑战:业务方常说"我要一个智能系统",但无法明确"智能"的具体表现。

实战方法:

- 问题拆解法:将模糊需求拆分为可量化的子目标。例如,“智能客服"可拆解为"意图识别准确率≥85%” “自动回复覆盖率≥60%” “人工转接率降低30%”;

- ROI评估:用"成本-收益"模型判断AI是否为最优解。例如,"客户分群"需求,若数据量小、规则明确,用传统规则引擎可能比机器学习模型更高效;

- MVP思维:先定义"最小可行AI产品",例如推荐系统先实现"基于用户ID的简单协同过滤",验证业务价值后再迭代为深度学习模型。

4.2.2 数据架构设计能力:构建AI的"燃料系统"

数据是AI的"燃料",数据架构设计直接决定AI系统的效果与稳定性。AI应用架构师需关注:

1. 数据采集与集成

- 多源数据接入:设计数据管道(Data Pipeline),整合业务数据库(MySQL)、日志数据(ELK)、埋点数据(埋点SDK)、第三方API(如天气、支付数据);

- 实时vs离线:根据业务场景选择数据处理方式。例如,实时推荐需接入Kafka实时流数据,而用户画像分析可基于离线数据仓库(如Hive)。

2. 数据存储与治理

- 存储分层:按"访问频率-数据量级"分层存储:热数据(Redis,毫秒级访问)、温数据(MySQL/PostgreSQL,秒级访问)、冷数据(对象存储/数据湖,分钟级访问);

- 数据质量管控:设计数据校验规则(如缺失值、异常值检测),建立数据血缘追踪(Data Lineage),确保模型训练数据可追溯。

3. 数据安全与合规

- 隐私保护:对敏感数据(如用户手机号)采用"数据脱敏+联邦学习"方案,例如用差分隐私技术处理训练数据,避免用户信息泄露;

- 合规要求:遵循GDPR、中国《数据安全法》等法规,设计数据留存期限、跨境传输规则(如国内用户数据存储在境内服务器)。

4.2.3 模型层架构设计能力:平衡"效果-性能-成本"

模型是AI系统的"引擎",但"高精度模型"≠"好用的AI系统"。AI应用架构师需从"业务可用性"角度设计模型层:

1. 模型选型与抽象

- 技术选型框架:根据"业务场景-数据量级-实时性要求-算力成本"四要素选型。例如:

- 文本分类(短文本):数据量小时选朴素贝叶斯,数据量大时选BERT;

- 实时推理(延迟要求<100ms):优先选轻量级模型(如MobileNet)或模型压缩(剪枝/量化);

- 离线分析(如用户画像):可选用高精度但计算密集型模型(如GPT系列)。

- 模型接口标准化:定义统一的模型输入/输出格式(如JSON),例如推荐模型统一返回

{"item_id": "xxx", "score": 0.9, "reason": "基于用户历史偏好"}。

2. 模型训练与迭代架构

- 训练架构设计:小数据场景用单机训练,大数据场景设计分布式训练架构(如基于Spark MLlib、TensorFlow Distributed);

- 模型版本管理:用MLflow、DVC等工具跟踪模型版本(关联数据版本、代码版本、超参数),支持"模型回滚"(当新版本效果下降时)。

3. 模型推理与部署架构

- 部署模式选型:

- 在线推理:通过API服务(如Flask/FastAPI)提供实时调用,适合推荐、搜索等场景;

- 批量推理:定期(如每日)运行模型处理全量数据,适合用户画像、风险评级等场景;

- 边缘推理:将模型部署在边缘设备(如工厂传感器、手机端),适合低延迟、高隐私场景(如工业质检、本地语音助手)。

- 性能优化策略:

- 算力弹性伸缩:基于Kubernetes实现推理服务的自动扩缩容(如流量高峰时增加Pod数量);

- 模型缓存:对高频请求(如热门商品推荐)缓存推理结果,减少重复计算;

- 异步推理:对非实时请求(如邮件分类)采用"请求队列+后台Worker"模式,避免阻塞主线程。

4.2.4 应用层架构设计能力:让AI能力"无缝融入业务"

AI能力若无法接入现有业务系统,再先进的模型也无法创造价值。AI应用架构师需设计"业务友好型"的应用层架构:

1. AI服务化:从"模型"到"可用服务"

- 微服务拆分:将AI能力拆分为独立微服务(如推荐服务、NLP服务、图像识别服务),通过API网关统一暴露,例如:

- 推荐服务:

/api/v1/recommend?user_id=xxx&scene=homepage - NLP服务:

/api/v1/nlp/intent?text=用户提问内容

- 推荐服务:

- 接口设计原则:

- 幂等性:确保重复调用API不会产生副作用(如推荐结果一致);

- 降级策略:当AI服务不可用时,返回默认结果(如热门商品列表)而非直接报错;

- 限流保护:设置API调用频率限制(如每秒1000次),避免流量峰值压垮系统。

2. 业务系统集成

- 集成方式:

- 直接调用:业务系统通过HTTP/gRPC调用AI服务API(适合实时场景);

- 事件驱动:基于消息队列(Kafka/RabbitMQ)实现异步集成,例如用户下单后发送事件到Kafka,推荐服务消费事件更新用户偏好;

- 前端集成:设计"AI+UI"交互方案,例如在电商APP首页,前端调用推荐API获取商品列表并渲染,同时展示"为你推荐"标签增强用户感知。

4.2.5 运维与监控架构设计能力:确保AI系统"稳定可持续"

AI系统的运维比传统系统更复杂——数据漂移、模型衰减、算力波动都可能导致系统失效。AI应用架构师需设计全方位的监控与运维体系:

1. 核心监控指标

- 业务指标:AI功能对业务的实际影响(如推荐CTR、客服问题解决率);

- 技术指标:系统性能(延迟、吞吐量、错误率)、资源使用率(CPU/内存/GPU利用率);

- AI特有指标:

- 数据漂移:输入数据分布变化(如用户行为突然改变);

- 模型衰减:模型准确率、F1值等指标下降;

- 特征重要性变化:关键特征(如价格)对模型预测的影响度变化。

2. 监控工具链

- 系统监控:Prometheus+Grafana监控CPU/内存/延迟;

- 日志监控:ELK Stack(Elasticsearch+Logstash+Kibana)收集API调用日志、模型推理日志;

- AI监控:Weights & Biases、Evidently AI等工具监控数据漂移与模型衰减。

3. 故障处理机制

- 自动告警:设置多级告警阈值(如模型准确率下降5%警告,下降10%紧急告警);

- 自愈策略:简单故障自动恢复(如重启异常Pod),复杂故障触发人工介入流程;

- 灾备方案:关键AI服务(如支付风控)部署多区域实例,避免单点故障。

4.2.6 成本控制能力:让AI"用得起、用得值"

AI系统的算力、数据存储成本往往超出预期,AI应用架构师需具备"成本敏感度":

1. 成本优化策略

- 算力成本:

- 分时复用:利用云厂商的"竞价实例"(价格低60%-90%)运行非实时任务(如模型训练);

- 模型轻量化:用小模型替代大模型(如用BERT-base替代BERT-large),推理速度提升3倍,成本降低50%;

- 存储成本:

- 数据生命周期管理:冷数据迁移至低成本存储(如AWS S3 Glacier),热数据保留在高性能存储(如Redis);

- 去重与压缩:对重复数据(如用户行为日志)去重,对文本数据压缩存储(如GZIP)。

2. 成本监控与归因

- 按服务/模型维度统计成本(如推荐服务月均成本5万元,占AI总预算30%);

- 计算"单位业务价值成本"(如每1万次推荐调用成本20元,带来500元GMV,则ROI=25:1)。

4.3 实战案例:设计"电商智能推荐系统"的AI架构

为帮助你将理论转化为实践,我们以"电商平台智能推荐系统"为例,完整拆解AI应用架构师的设计过程。

阶段1:需求解析与架构目标

业务需求:为电商平台设计"首页个性化推荐"“商品详情页相关推荐”"购物车猜你喜欢"三个场景的推荐功能,核心指标:

- 推荐CTR(点击通过率)提升20%;

- 推荐模块GMV贡献占比达到15%;

- 系统响应延迟<300ms(首页推荐),<500ms(详情页推荐);

- 支持每日1000万用户访问,峰值QPS 1000。

架构设计目标:

- 可扩展性:支持未来新增推荐场景(如搜索结果推荐、APP Push推荐);

- 可迭代性:模型每周更新一次,数据每日更新;

- 成本可控:月均算力成本不超过10万元。

阶段2:数据层架构设计

数据需求:推荐系统依赖三类核心数据:

- 用户数据:基本信息(年龄、性别)、行为数据(点击、加购、购买、停留时长);

- 商品数据:属性(品类、价格、品牌)、内容(标题、描述、图片)、销量数据;

- 场景数据:用户当前页面(首页/详情页)、设备(手机/PC)、时间(工作日/周末)。

数据架构设计:

-

数据采集层:

- 实时数据:用户行为日志通过埋点SDK(如百度统计、神策)采集,发送至Kafka消息队列;

- 离线数据:业务数据库(MySQL)中的用户/商品基础数据,通过DataX每日同步至数据仓库。

-

数据存储层:

- 热数据(实时访问):

- 用户实时行为(如最近1小时点击):Redis(Key-Value结构,用户ID为Key);

- 热门商品列表(Top 1000):Redis Sorted Set(按销量/点击率排序);

- 温数据(每日更新):

- 用户画像(如偏好品类、价格敏感度):MySQL(结构化存储);

- 商品特征(如品类向量、价格区间):PostgreSQL(支持向量检索);

- 冷数据(历史归档):

- 全量用户行为日志:HDFS(低成本存储,用于模型训练)。

- 热数据(实时访问):

-

数据处理层:

- 实时特征工程:Flink流处理引擎实时计算用户"最近点击商品品类"“实时兴趣标签”;

- 离线特征工程:Spark每日批处理计算"用户历史购买金额""商品月均销量"等特征;

- 特征存储:Feast特征平台统一管理特征,提供"特征查询API"供模型训练与推理调用。

阶段3:模型层架构设计

模型需求:需支持多场景、多目标推荐(CTR预测、GMV最大化、多样性保证)。

模型架构设计:

-

模型选型:

- 首页推荐(场景复杂,需平衡多样性):DeepFM模型(融合用户/商品特征与交互特征);

- 详情页推荐(相关性优先):双塔模型(User Tower + Item Tower,高效计算用户-商品相似度);

- 购物车推荐(时效性强):简单协同过滤+规则兜底(如"购买A的人还买B")。

-

模型训练架构:

- 数据输入:从Feast特征平台拉取用户/商品特征,从HDFS读取历史行为数据;

- 训练环境:基于Kubernetes构建分布式训练集群(8台GPU服务器,每台8卡V100);

- 训练流程:

- 每日凌晨启动训练任务,加载前一天全量数据;

- 用TensorFlow训练DeepFM/双塔模型,保存模型参数至MLflow;

- 离线评估指标(CTR、GMV模拟),达标后推送至推理服务。

-

模型推理架构:

- 服务拆分:按场景拆分为"首页推荐服务"“详情页推荐服务”,独立部署与扩缩容;

- 部署方式:

- 模型打包为Docker镜像,基于Kubernetes部署为无状态服务;

- 推理API用FastAPI开发,支持HTTP/JSON调用;

- 性能优化:

- 模型量化:将FP32模型转为INT8,推理速度提升2倍,显存占用降低75%;

- 请求缓存:对高频用户(如DAU前10%)缓存推荐结果,缓存有效期10分钟;

- 预热与降级:服务启动时预热热门用户推荐结果;模型加载失败时,返回"热门商品列表"兜底。

阶段4:应用层架构设计

目标:将推荐能力无缝接入电商平台的Web/APP前端,同时支持业务灵活配置。

应用架构设计:

-

服务接口设计:

- 首页推荐API:

GET /api/v1/recommend/home?user_id=xxx&device=mobile&page=1

返回:{"items": [{"id": "p123", "title": "商品A", "price": 99, "img_url": "...", "reason": "为你精选"}], "has_more": true} - 详情页推荐API:

GET /api/v1/recommend/detail?item_id=p123&user_id=xxx

返回:{"items": [{"id": "p456", "title": "商品B", "relation": "相似商品"}]}

- 首页推荐API:

-

业务系统集成:

- 前端集成:APP/Web前端调用推荐API获取数据后,渲染为"个性化推荐栏",并添加"换一批"按钮(触发重新请求);

- 后端集成:用户点击推荐商品后,后端记录行为日志(发送至Kafka),用于数据反馈与模型迭代。

-

配置平台:

- 开发"推荐配置后台",支持业务运营人员:

- 调整推荐权重(如"促销商品权重+20%");

- 配置过滤规则(如"不推荐低于10元的商品");

- A/B测试管理(如同时上线DeepFM和Wide&Deep模型,对比效果)。

- 开发"推荐配置后台",支持业务运营人员:

阶段5:运维与监控架构设计

目标:确保推荐系统稳定运行,及时发现并解决问题。

运维监控设计:

-

监控指标体系:

- 业务指标:各场景CTR、加购率、GMV贡献、用户停留时长;

- 技术指标:API响应延迟(P99<500ms)、错误率(<0.1%)、服务可用性(99.99%);

- AI指标:模型准确率(离线CTR预测准确率>85%)、数据漂移(用户行为特征分布变化<10%/周)。

-

监控工具链:

- 系统监控:Prometheus+Grafana监控服务QPS、延迟、GPU利用率;

- 日志监控:ELK收集API调用日志,设置"连续5分钟错误率>1%→告警";

- AI监控:Evidently AI监控用户行为特征分布,当漂移超过阈值时自动触发特征重计算。

-

故障处理流程:

- 告警分级:P0(服务不可用)→ 技术负责人+架构师15分钟内响应;P1(CTR下降10%)→ 工作时间1小时内响应;

- 应急预案:服务不可用时,自动切换至"静态热门商品列表";模型效果下降时,回滚至上周版本。

阶段6:成本控制设计

目标:将推荐系统月均成本控制在10万元内。

成本优化措施:

- 算力优化:

- 训练任务:利用云厂商"深夜折扣算力"(00:00-06:00)运行,成本降低40%;

- 推理服务:基于KEDA实现"流量驱动扩缩容"(低峰期保留2个Pod,高峰期扩至20个Pod);

- 存储优化:

- 用户行为日志仅保留最近3个月热数据,历史数据归档至低成本对象存储;

- 特征数据去重(如用户重复点击同一商品的行为只保留最近一次);

- 效果验证:上线后首月成本8.5万元,CTR提升25%,GMV贡献占比18%,ROI达30:1,超额完成业务目标。

4.4 关键挑战与解决方案

AI应用架构设计中,常遇到以下挑战,AI应用架构师需掌握对应的破解之道:

挑战1:数据孤岛严重,AI模型"无米下锅"

场景:企业内部数据分散在多个业务系统(ERP、CRM、电商平台),数据格式不统一,权限管理严格,算法团队难以获取完整数据。

解决方案:

- 数据中台前置:推动企业建设数据中台,统一数据标准与访问权限;

- 联邦学习架构:无法直接聚合数据时,采用联邦学习(各数据方本地训练模型,仅共享模型参数);

- 数据API化:设计"数据访问网关",统一数据查询接口(如

/api/data/user?user_id=xxx),并通过网关控制权限(如算法团队仅能访问脱敏后的数据)。

挑战2:模型部署复杂,“训练完就忘”

场景:算法团队训练出高精度模型,但缺乏工程化能力,模型以"Python脚本"形式存在,无法接入业务系统,最终被束之高阁。

解决方案:

- MLOps平台建设:搭建"模型训练-评估-部署-监控"全流程自动化平台(如基于MLflow+Airflow);

- 模型服务化模板:提供标准化的模型服务模板(如FastAPI+Docker模板),算法团队只需填充模型加载与推理代码;

- 跨团队协作机制:建立"算法-工程"联合小组,共同负责模型从训练到部署的全链路。

挑战3:AI系统"黑箱问题",业务方不信任

场景:推荐系统推荐了某个商品,业务方质疑"为什么推荐这个?",但算法团队无法解释,导致业务方不愿大规模使用。

解决方案:

- 可解释AI(XAI)技术:在模型设计中融入解释性(如SHAP值分析特征重要性,LIME生成局部解释);

- 推荐理由生成:为每个推荐结果附加"人类可理解"的理由(如"基于你最近购买了运动鞋");

- 透明化运营:向业务方开放"推荐配置后台",允许调整规则与权重,增强信任感。

挑战4:算力成本失控,“用得起但不划算”

场景:某企业AI项目初期效果显著,但随着用户量增长,GPU算力成本每月飙升至百万级,远超预期。

解决方案:

- 成本归因分析:按模型/服务维度统计算力消耗,识别"高成本低价值"服务(如某NLP服务月均成本10万,仅带来1万GMV);

- 技术替代方案:用轻量级模型(如DistilBERT替代BERT)或传统方法(如规则引擎)替代高成本AI服务;

- 商业化变现:将AI能力对外输出(如SaaS服务),分摊算力成本(如电商推荐系统同时服务多个垂直品类商家)。

5. 进阶探讨 (Advanced Topics)

AI应用架构师的成长永无止境,以下进阶方向值得深入探索:

5.1 多模态AI架构设计

随着GPT-4、Midjourney等多模态模型的爆发,企业对"文本+图像+语音"融合的AI能力需求激增。多模态AI架构需解决:

- 数据融合:设计统一的多模态数据存储(如支持文本、图像、音频的混合数据库);

- 模型协同:多个单模态模型(如文本理解模型、图像识别模型)如何协作(如"先图像识别商品,再文本生成推荐理由");

- 推理优化:多模态模型计算密集,需设计"模型并行+数据并行"混合部署架构(如将文本处理与图像处理拆分到不同GPU)。

5.2 AI与边缘计算的融合架构

在工业、医疗、自动驾驶等领域,“低延迟”"高隐私"需求推动AI向边缘端渗透。边缘AI架构需关注:

- 模型轻量化:通过知识蒸馏、量化等技术将模型压缩至边缘设备可运行(如100MB以内);

- 云边协同:云端训练大模型,边缘端部署轻量级模型,定期(如每周)从云端更新模型参数;

- 资源受限环境优化:在CPU/内存有限的边缘设备上(如嵌入式芯片),采用"模型推理时间片调度"避免资源竞争。

5.3 AI伦理与合规架构

随着《生成式AI服务管理暂行办法》等法规出台,AI系统需满足伦理与合规要求。架构设计中需融入:

- 可追溯性:设计"AI决策日志",记录每次推理的输入数据、模型版本、输出结果,支持审计追溯;

- 偏见检测与消除:在模型层加入"偏见检测模块"(如检测推荐结果中性别/年龄偏见),自动调整推荐权重;

- 内容安全过滤:生成式AI(如智能客服话术生成)需接入内容安全API(如百度AI内容审核),过滤违规内容。

5.4 AI架构的可观测性与治理

随着企业AI应用增多(如10+个AI服务),需建立全局AI治理体系:

- AI资产盘点:通过"AI服务注册中心"记录所有AI服务(名称、负责人、技术栈、成本、业务价值);

- 跨服务依赖图谱:绘制AI服务调用关系图(如"推荐服务依赖用户画像服务,用户画像服务依赖NLP服务"),便于故障定位;

- 效能评估:定期(如每季度)评估各AI服务的"投入产出比",淘汰低价值服务,优化高价值服务。

6. 总结 (Conclusion)

回顾要点

本文从角色定位、核心能力、实战案例到进阶方向,全方位解析了"AI应用架构师"这一关键角色:

- 角色价值:AI应用架构师是"AI技术-业务需求-系统架构"的桥梁,核心使命是让AI创造可持续的业务价值;

- 核心能力:需掌握"业务解析-数据架构-模型架构-应用架构-运维监控-成本控制"六大能力,同时具备跨团队协作软技能;

- 实战方法:通过"需求解析→数据层→模型层→应用层→运维层"的全链路设计,将AI能力转化为业务可用的服务;

- 挑战破解:面对数据孤岛、部署复杂、成本失控等问题,需结合技术方案(如数据中台、MLOps)与协作机制(跨团队联合)。

成果与展望

通过本文的学习,你已理解AI应用架构师如何通过系统化的架构设计,将"实验室级AI模型"转化为"企业级AI应用",支撑业务从"数字化"向"智能化"跃升。

未来,随着大模型、边缘计算、多模态等技术的发展,AI应用架构师的角色将更加重要——他们不仅是技术的设计者,更是企业数字转型的"战略执行者"。

7. 行动号召 (Call to Action)

AI应用架构师的成长离不开实践与交流。现在,轮到你行动起来:

- 动手实践:选择一个你熟悉的业务场景(如客服、营销、生产),尝试用本文的方法论设计一套AI应用架构方案;

- 经验分享:如果你已在从事AI架构相关工作,欢迎在评论区分享你的"架构设计心得"或"踩坑经验";

- 问题讨论:遇到AI架构设计难题?留言提出你的困惑,我们一起探讨解决方案!

AI驱动的数字转型浪潮已至,AI应用架构师正是浪潮中的掌舵者。愿你通过持续学习与实践,成为企业智能化升级的核心力量!

让AI不再是"实验室里的奢侈品",而是"业务增长的必需品"——从你我开始。

更多推荐

已为社区贡献201条内容

已为社区贡献201条内容

所有评论(0)