大显存硬件实战:应对8K剪辑高效秘籍

【代码】大显存硬件实战:应对8K剪辑、AI训练的高效秘籍。

·

硬件选择与配置

- 显卡选型:分析NVIDIA RTX A6000、AMD Radeon Pro VII等专业显卡的显存容量、带宽及性价比。

- 多卡并联技术:探讨NVLink/SLI在不同场景下的性能提升效果,以及散热与功耗的平衡方案。

- CPU与内存协同:推荐线程撕裂者或至强处理器搭配高频率DDR5内存,避免数据吞吐瓶颈。

8K视频剪辑优化

- 代理工作流设计:通过Premiere Pro或DaVinci Resolve生成低分辨率代理,降低实时编辑对显存的压力。

- 显存分配策略:调整软件设置(如CUDA核心利用率)确保显存优先用于高分辨率素材解码。

- 存储加速方案:配置RAID 0 NVMe SSD阵列提升素材读取速度,减少显存中转负担。

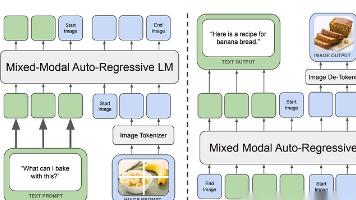

AI训练效率提升

- 混合精度训练:启用Tensor Core或ROCm的FP16/BF16支持,显存占用降低50%同时保持模型精度。

- 梯度检查点技术:通过牺牲10%-20%计算速度换取显存优化,支持更大Batch Size训练。

- 分布式训练框架:使用Horovod或PyTorch DDP实现多卡数据并行,显存利用率提升策略示例代码:

torch.cuda.empty_cache() # 手动释放碎片显存 model = nn.DataParallel(model, device_ids=[0,1,2,3])

散热与稳定性保障

- 风道设计原则:封闭式机箱需保证进风量>出风量,显卡间距≥2槽位避免热岛效应。

- 显存温度监控:通过HWInfo或GPU-Z实时监测GDDR6X显存温度,阈值建议控制在90℃以下。

- 电源冗余配置:单卡建议850W金牌电源,多卡系统需计算峰值功耗并预留20%余量。

软件栈调优实例

- CUDA版本匹配:PyTorch/TensorFlow与Driver兼容性对照表,避免因版本冲突导致显存泄漏。

- 内核参数调整:Linux系统下设置

vm.overcommit_memory=1预防OOM错误。 - 渲染器专属优化:OctaneRender启用OptiX去噪,显存占用降低30%对比传统降噪方式。

成本控制方案

- 二手专业卡选购:Tesla V100 32GB显存版本在eBay平台性价比分析,注意PCIE版本兼容性。

- 云显存租赁:AWS p4d.24xlarge实例按需使用方案,适合短期高负载项目。

- 硬件折旧计算:根据Amdahl定律评估升级显存与增加显卡数量的投资回报周期。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)