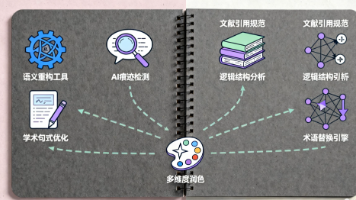

打造高质量AI:多轮对话数据全攻略

主要挑战规模与成本:大规模数据收集的高开销。主观性与偏差:标注员主观判断导致不一致。伦理与合规:数据隐私和用户授权问题。创新解决方案混合方法:结合真实数据和模拟生成。开源协作:利用社区数据集(如MultiWOZ)加速开发。伦理框架:建立数据使用规范。

·

一、引言:多轮对话数据的重要性与挑战

- 背景介绍:多轮对话在AI应用(如聊天机器人、虚拟助手)中的核心作用,高质量数据是模型性能的基础。

- 核心问题:现有数据集的常见缺陷(如噪声、偏差),强调高质量数据集的必要性。

- 文章目标:概述数据收集与标注的全流程,提供可落地的技术方案。

- 文章结构预览:简要介绍后续章节内容。

二、多轮对话数据收集方法

- 数据来源分类

- 真实对话数据:从用户日志、社交媒体等渠道收集,需处理隐私和伦理问题。

- 模拟对话生成:使用脚本或AI模型(如GPT系列)生成多样化的对话样本。

- 众包平台利用:通过平台(如Amazon Mechanical Turk)获取大规模数据,但需控制成本和质量。

- 收集策略

- 场景设计:定义对话主题(如客服、教育),确保数据覆盖多样性。

- 工具与技术:使用爬虫工具、API接口自动化收集。

- 挑战与解决方案

- 挑战:数据不平衡、隐私合规。

- 解决方案:匿名化处理、数据增强技术(如回译)。

三、数据标注流程与技术

- 标注内容定义

- 意图识别:标注用户意图(如查询、投诉)。

- 槽位填充:识别关键实体(如时间、地点)。

- 情感分析:标注情绪极性(正面、负面)。

- 对话连贯性:评估多轮上下文逻辑。

- 标注流程设计

- 步骤1:制定标注指南(统一标准)。

- 步骤2:标注工具选择(如开源工具BRAT或自定义UI)。

- 步骤3:标注员培训与任务分配。

- 标注质量控制

- 多人标注机制:使用多个标注员交叉验证。

- 一致性指标:计算Cohen's Kappa系数确保可靠性。

- 自动化辅助:结合预训练模型(如BERT)进行初步标注。

四、构建高质量数据集的核心技术

- 数据清洗与预处理

- 噪声去除:过滤无效对话(如短响应、重复内容)。

- 数据平衡:通过采样或合成确保话题和语言风格多样性。

- 质量评估指标

- 准确性:人工审核与模型测试结合。

- 多样性指标:计算熵值或覆盖率。

- 鲁棒性测试:在对抗样本下验证数据集稳定性。

- 高效标注优化

- 主动学习:优先标注高不确定性样本。

- 半自动化流程:AI辅助减少人工成本。

五、挑战与解决方案总结

- 主要挑战

- 规模与成本:大规模数据收集的高开销。

- 主观性与偏差:标注员主观判断导致不一致。

- 伦理与合规:数据隐私和用户授权问题。

- 创新解决方案

- 混合方法:结合真实数据和模拟生成。

- 开源协作:利用社区数据集(如MultiWOZ)加速开发。

- 伦理框架:建立数据使用规范。

六、结论与未来展望

- 核心总结:高质量多轮对话数据集的关键要素(多样性、准确性、一致性)。

- 实际影响:提升AI模型性能(如意图识别准确率)。

- 未来趋势:新技术融合(如Few-shot学习、数据增强),以及标准化数据集库的建设。

- 行动建议:为从业者提供实用指南(如从试点项目开始)。

此大纲基于行业最佳实践,确保每个部分可扩展为详细内容。文章可进一步添加案例分析和参考文献部分,以增强实用性。

更多推荐

已为社区贡献23条内容

已为社区贡献23条内容

所有评论(0)