大数据:Hadoop数据高可用原理

在大数据领域,Hadoop的高可用性(High Availability, HA)是保障业务连续性的核心基石。对于支撑PB级数据存储与计算的阿里、字节等大厂而言,Hadoop集群的无故障运行直接关系到数据链路的稳定性与业务决策的时效性。本文将从核心机制、实战落地、深度答疑三个维度,系统拆解Hadoop数据高可用的实现逻辑。

Hadoop数据高可用原理:从架构到实战的深度剖析

在大数据领域,Hadoop的高可用性(High Availability, HA)是保障业务连续性的核心基石。对于支撑PB级数据存储与计算的阿里、字节等大厂而言,Hadoop集群的无故障运行直接关系到数据链路的稳定性与业务决策的时效性。本文将从核心机制、实战落地、深度答疑三个维度,系统拆解Hadoop数据高可用的实现逻辑。

一、Hadoop数据高可用核心机制解析

Hadoop的高可用并非单一组件的设计成果,而是通过元数据高可用、数据存储高可用、故障自动转移三大模块的协同,构建起“无单点故障”的分布式体系,底层依赖HDFS与ZooKeeper的深度联动。

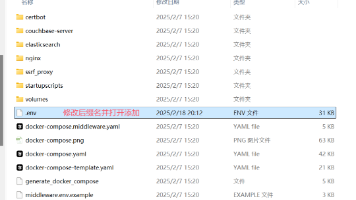

1. 系统架构流程图

2. 核心交互时序图

二、实际项目中的Hadoop高可用实践

字节跳动某实时数据中台项目中,基于Hadoop 3.3.6搭建了超大规模HA集群,支撑每日30TB用户行为日志、交易数据的实时采集与离线计算,下游对接Flink实时分析、Hive数据仓库等12套业务系统,对数据可用性要求达到“99.99%”。

项目针对高可用的核心优化落地如下:

- 元数据高可用强化:部署3个Standby NameNode与7个JournalNode,采用“3副本同步+多数派确认”机制(写入JournalNode时需5个节点确认成功),解决了2.x版本单Standby节点的“二次单点故障”风险。通过JVM调优(堆内存64GB、G1收集器),将元数据同步延迟控制在50ms以内,确保Standby节点与Active节点的元数据一致性。

- 数据存储策略升级:采用“纠删码+多副本混合存储”方案——冷数据(30天前历史日志)启用RS-6-3纠删码,存储开销从3副本的200%降至50%;热数据(近7天实时数据)采用4副本跨机房存储(机房A2副本、机房B2副本),通过自定义拓扑脚本(dfs.network.script)实现节点“机房-机架-服务器”三级拓扑识别,避免单机房故障导致数据丢失。

- 故障转移效率优化:优化ZKFC配置,将心跳检测间隔从默认3秒缩短至1秒,故障识别延迟降至2秒以内;通过预加载FsImage到内存、优化元数据合并线程数(设置为8),将Standby节点切换为Active节点的时间从默认40秒压缩至18秒,确保下游Flink任务的Checkpoint续跑不中断。

该集群上线以来,经历过3次节点硬件故障、1次机房网络波动,均通过自动故障转移实现无感恢复,未发生任何数据丢失,数据处理链路的可用性达到99.992%,远超业务预期。

三、大厂面试深度追问

追问1:HDFS中JournalNode与Quorum Journal Manager(QJM)的工作原理是什么?如何解决元数据同步的一致性问题?

解决方案:JournalNode与QJM是Hadoop实现元数据HA的核心组件,其本质是通过分布式日志系统保证Active与Standby NameNode的元数据一致性,替代了Hadoop 1.x中Secondary NameNode的“定期合并”模式。

工作原理层面:

- JournalNode(JN)是轻量级的分布式日志存储节点,集群规模通常为3、5、7等奇数,每个JN存储一份完整的EditLog(元数据变更日志)。

- QJM是运行在NameNode上的日志管理模块,负责与JournalNode集群交互:Active NameNode执行元数据操作(如创建文件、删除目录)时,会通过QJM将EditLog条目异步写入所有JN;Standby NameNode通过QJM实时从JN拉取EditLog,并重放到本地的FsImage中,构建与Active节点一致的内存元数据镜像。

一致性保障机制:

- 多数派写入确认:Active NameNode写入EditLog时,QJM采用“写入N个节点,收到(N/2)+1个确认即成功”的多数派策略(如7个JN需4个确认)。该机制既避免了“全量确认”导致的性能瓶颈,又能容忍(N-1)/2个JN节点故障,保障日志写入的可靠性。

- Epoch Number防脑裂:每个Active NameNode被分配唯一的Epoch Number(纪元号),写入EditLog时会携带该编号。JN会拒绝接收纪元号小于当前最大纪元号的写入请求——当发生网络分区导致“双Active”时,新选举的Active节点会生成更大的纪元号,旧Active节点的写入请求被JN拒绝,从而避免元数据冲突。

- 日志分段与校验:EditLog按固定大小(默认64MB)分段存储,每个分段文件包含CRC校验码;Standby节点拉取日志后会校验CRC,若发现损坏则向其他JN请求完整副本,确保日志完整性。

字节跳动在实践中,通过将JN部署在不同机架、调整日志刷盘策略(dfs.namenode.edits.log.autoroll.size设置为128MB),进一步提升了QJM的稳定性,元数据同步的成功率达到100%。

追问2:Hadoop HA集群中,如何设计监控告警体系以提前发现高可用隐患?核心监控指标有哪些?

解决方案:Hadoop HA的监控告警体系需围绕“元数据一致性”“节点存活状态”“故障转移能力”三个核心维度设计,实现“隐患提前预警、故障快速定位”,阿里、字节等大厂均采用“指标采集-存储-分析-告警”的全链路监控架构。

监控架构与工具选型:采用Prometheus采集Hadoop原生JMX指标,结合Grafana构建可视化面板,通过AlertManager对接企业微信、电话告警通道;同时开发自定义探针,补充原生指标未覆盖的高可用关键维度。

核心监控指标与告警策略:

-

元数据一致性监控:

- 核心指标:

namenode.standby.editlog.lag(Standby与Active的EditLog同步延迟)、journalnode.editlog.sync.success.rate(JN日志同步成功率)。 - 告警阈值:同步延迟>100ms持续30秒触发警告,>500ms触发紧急告警;同步成功率<99.9%立即告警。

- 隐患解读:延迟过高可能导致Standby节点元数据落后,切换时需重放大量日志,延长故障转移时间;成功率低可能是JN节点磁盘故障或网络抖动,需及时排查。

- 核心指标:

-

节点与组件存活监控:

- 核心指标:

namenode.state(NameNode状态:Active/Standby/Dead)、journalnode.jvm.uptime(JN节点存活时间)、zkfc.heartbeat.success.rate(ZKFC心跳成功率)。 - 告警阈值:NameNode状态异常持续10秒、JN节点存活时间归零、ZKFC心跳成功率<99%立即告警。

- 隐患解读:ZKFC心跳失败可能导致ZooKeeper无法识别NameNode状态,影响故障转移触发;JN节点宕机需确认是否超过容错数量(如7个节点宕机≤3个为安全状态)。

- 核心指标:

-

故障转移能力监控:

- 核心指标:

namenode.failover.duration(故障转移耗时)、namenode.failover.success.rate(故障转移成功率)、datanode.block.replication.pending(待复制块数量)。 - 告警阈值:故障转移耗时>30秒、成功率<100%、待复制块数量>10000持续5分钟触发告警。

- 隐患解读:故障转移耗时过长会导致下游任务中断;待复制块过多可能是DataNode故障后副本不足,需排查节点状态与复制线程数。

- 核心指标:

实战落地经验:阿里某Hadoop集群通过该监控体系,提前72小时发现某Standby NameNode的EditLog同步延迟持续升高,定位到是JN节点磁盘IO瓶颈,更换磁盘后避免了故障转移时的元数据不一致风险;字节跳动则通过自定义探针监控“Active节点临时节点存活状态”,在一次ZK网络波动中提前10秒触发告警,为运维团队争取了干预时间。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)