老码农和你一起学AI系列:模型调优与评估-随机搜索 与早停法

摘要:本文介绍了两种高效的超参数调优方法:随机搜索和早停法。随机搜索通过随机采样参数组合替代网格搜索的全遍历,显著提升效率,尤其适用于高维参数空间。早停法则针对迭代模型(如XGBoost)动态确定最优迭代次数,避免无效训练。文章通过代码示例演示了两种方法在Scikit-learn和XGBoost中的实现,并对比了它们的适用场景:网格搜索适合低维精确调参,随机搜索适合高维快速筛选,早停法则专门优化迭

在上节中,我们梳理了网格搜索(Grid Search)—— 这种 “暴力枚举所有参数组合” 的调优方法虽然结果可靠,但在超参数数量多、范围大时,会陷入 “计算成本爆炸” 的困境(比如 5 个超参数各有 10 个候选值,就有 10 万种组合)。

本节中将介绍两种更实用的调优方案:随机搜索(解决网格搜索的效率问题)和早停法(解决 XGBoost、LightGBM 等迭代模型的调优痛点),让你在保证效果的同时,大幅节省时间。

一、随机搜索 (Random Search)

随机搜索是网格搜索的 “高效替代方案”,核心思想是:不再遍历所有参数组合,而是在参数空间中随机采样一定数量的组合。它的高效性并非 “运气”,而是基于一个关键的数学直觉 —— 并非所有超参数对模型性能的影响都同等重要。

1. 原理:为什么 “随机” 比 “遍历” 更高效?

先看一个生活化的例子:假设你要调一杯好喝的咖啡,需要确定两个参数 ——“咖啡豆用量(5-15g)” 和 “水温(85-95℃)”。其中,咖啡豆用量对口感影响极大(少了没味,多了苦涩),而水温的影响相对较小(88-92℃内差异不大)。

- 若用网格搜索:设咖啡豆用量为 [5,10,15],水温为 [85,90,95],共 9 种组合。但可能大部分组合都浪费在 “水温的无效变化” 上(比如 5g 咖啡豆 + 85℃和 5g 咖啡豆 + 90℃的口感差异很小)。

- 若用随机搜索:随机采样 5 种组合(比如 [7g,91℃]、[12g,87℃]、[14g,93℃] 等),更容易覆盖 “咖啡豆用量” 这个关键参数的有效范围,更快找到好喝的组合。

这背后的数学逻辑是:模型性能对超参数的敏感度存在 “维度差异”—— 少数关键参数(如学习率、树的最大深度)决定了性能上限,而多数次要参数(如树的最小样本分裂数)的影响有限。随机搜索能以更少的采样次数,优先命中关键参数的有效区间,从而在相同计算成本下,比网格搜索找到更优的参数组合。

2. 实战演示:用 Scikit-learn 的RandomizedSearchCV

RandomizedSearchCV是 Scikit-learn 中实现随机搜索的工具,与GridSearchCV的用法相似,但核心区别是:它需要指定 “采样次数(n_iter)”,而非遍历所有组合。

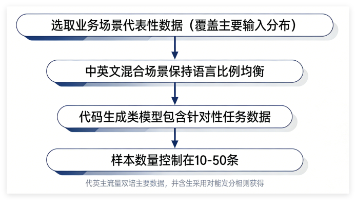

我们仍以 “随机森林 + 鸢尾花数据集” 为例,对比随机搜索与网格搜索的效率差异。

步骤 1:准备数据与导入工具

# 1. 导入库(延续上节课的基础库,新增RandomizedSearchCV)

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split, RandomizedSearchCV

from sklearn.metrics import accuracy_score

import numpy as np # 用于生成随机参数的分布

# 2. 加载数据并划分训练+验证集、测试集

iris = load_iris()

X, y = iris.data, iris.target

X_train_val, X_test, y_train_val, y_test = train_test_split(

X, y, test_size=0.2, random_state=42

)步骤 2:定义参数分布(关键区别!)

与网格搜索 “指定固定候选值列表” 不同,随机搜索需要为每个超参数定义概率分布(如均匀分布、正态分布),以便随机采样。

我们调优 3 个超参数,模拟 “高维度参数空间” 的场景:

- n_estimators(树的数量):均匀分布,10~200 之间随机取整数

- max_depth(树的最大深度):均匀分布,3~15 之间随机取整数

- min_samples_split(节点分裂的最小样本数):均匀分布,2~10 之间随机取整数

# 定义参数分布:用numpy生成概率分布

param_dist = {

# 均匀分布:low到high之间的整数,用randint

'n_estimators': np.random.randint(low=10, high=201, size=20), # 生成20个候选值(采样时从中随机选)

'max_depth': np.random.randint(low=3, high=16, size=10), # 生成10个候选值

'min_samples_split': np.random.randint(low=2, high=11, size=5) # 生成5个候选值

}步骤 3:初始化并运行随机搜索

关键参数n_iter:指定 “随机采样的组合数量”(比如设为 10,即只测试 10 种组合,远少于网格搜索的 20×10×5=1000 种)。

# 1. 初始化随机森林模型

rf_model = RandomForestClassifier(random_state=42)

# 2. 初始化随机搜索:n_iter=10表示采样10种组合

random_search = RandomizedSearchCV(

estimator=rf_model,

param_distributions=param_dist, # 传入参数分布(而非固定列表)

n_iter=10, # 核心参数:采样10种组合

cv=5, # 5折交叉验证

scoring='accuracy',

n_jobs=-1, # 并行计算

random_state=42 # 固定随机种子,结果可复现

)

# 3. 训练并搜索最优参数

random_search.fit(X_train_val, y_train_val)步骤 4:查看结果并评估

# 输出最优参数和验证集准确率

print("随机搜索最佳超参数组合:", random_search.best_params_)

# 示例输出:{'n_estimators': 120, 'max_depth': 8, 'min_samples_split': 5}

print("随机搜索最佳验证集准确率:", random_search.best_score_)

# 示例输出:0.9667(与网格搜索的最优结果接近,但仅用了1/100的计算量)

# 用最优模型评估测试集

best_model = random_search.best_estimator_

test_accuracy = accuracy_score(y_test, best_model.predict(X_test))

print("测试集准确率:", test_accuracy)

# 示例输出:1.0(泛化能力依然优秀)3. 随机搜索 vs 网格搜索:何时该用哪种?

两者没有绝对的 “优劣”,关键看参数空间的复杂度,具体选择标准如下:

|

对比维度 |

网格搜索(Grid Search) |

随机搜索(Random Search) |

|

核心逻辑 |

暴力遍历所有参数组合 |

随机采样指定数量的组合 |

|

计算成本 |

高(随参数维度指数增长) |

低(仅由 n_iter 控制,与维度无关) |

|

参数维度适配 |

适合低维度(≤3 个超参数) |

适合高维度(≥3 个超参数) |

|

搜索精度 |

高(不会遗漏任何组合,适合精确搜索) |

较高(大概率找到接近最优的组合) |

|

适用场景 |

1. 参数少(如仅调 2 个超参数)2. 需要确定最优参数的精确值(如学习率需精确到 1e-4) |

1. 参数多(如调 4 + 个超参数)2. 初步筛选参数范围(快速找到有效区间后,可再用网格搜索细化) |

一句话总结:参数少、要精确 → 用网格;参数多、要高效 → 用随机。

二、早停法(Early Stopping):迭代模型的 “智能止损”

上一节和本节的方法,主要针对 “静态超参数”(如 max_depth、min_samples_split),但 XGBoost、LightGBM、神经网络等迭代模型有一个特殊的超参数 ——n_estimators(树的数量,或神经网络的 “epoch 数”),它的调优不能用传统方法。

1. 问题:为什么n_estimators不能用网格 / 随机搜索?

以 XGBoost 为例,n_estimators表示 “训练的决策树数量”,它的特点是:

- 越多不一定越好:前期增加树的数量,模型会学习更多规律,验证集性能提升;但当树的数量超过某个阈值后,模型会开始 “过拟合”(记住训练集噪声),验证集性能反而下降。

- 计算成本高:若用网格搜索调n_estimators(如候选值 [100,200,...,1000]),需要训练 10 个不同树数量的模型,每个模型都要完整训练到指定树数,时间成本极高。

比如,若最优n_estimators是 300,用网格搜索测试 1000 时,会白白训练 700 棵多余的树 —— 这就是早停法要解决的问题。

2. 早停法原理:“没进步就止损”

早停法的核心思想很简单:在迭代训练过程中,持续监控验证集性能;当验证集性能连续多轮(如 5 轮)不再提升时,提前停止训练,此时的迭代次数(树的数量 /epoch 数)就是最优的n_estimators。

可以用 “煮面条” 比喻:你想煮一碗不夹生也不软烂的面条,不需要等到水沸腾 10 分钟(固定 n_estimators=10),而是每隔 1 分钟尝一口(监控验证集);如果连续 2 口尝起来口感都没变好(性能不提升),就关火(早停)—— 既保证了口感,又避免了浪费时间。

具体逻辑步骤:

- 初始化 “最佳验证性能” 和 “无进步轮次计数器(patience)”。

- 每训练一轮(增加一棵决策树 / 一个 epoch),计算验证集性能。

- 若当前验证性能 > 最佳验证性能:更新最佳性能,重置计数器。

- 若当前验证性能 ≤ 最佳验证性能:计数器 + 1;当计数器达到设定的 patience(如 5)时,停止训练。

3. 实战:用 XGBoost 实现早停法

XGBoost 是工业界常用的迭代模型,其 Python 库xgboost内置了early_stopping_rounds参数,可直接实现早停法。

步骤 1:准备数据(用回归任务举例,更贴近 XGBoost 的常见场景)

用 “波士顿房价数据集”(预测房价),划分训练集、验证集、测试集(注意:早停法必须单独划分验证集,不能用交叉验证的中间集)。

# 1. 导入库(需先安装xgboost:pip install xgboost)

import xgboost as xgb

from sklearn.datasets import load_boston

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error # 回归任务的评估指标(均方误差)

# 2. 加载数据(波士顿房价数据集,回归任务)

boston = load_boston()

X, y = boston.data, boston.target

# 3. 划分数据:先分训练+验证集 vs 测试集,再分训练集 vs 验证集

X_train_val, X_test, y_train_val, y_test = train_test_split(

X, y, test_size=0.2, random_state=42

)

X_train, X_val, y_train, y_val = train_test_split(

X_train_val, y_train_val, test_size=0.2, random_state=42 # 验证集占训练+验证集的20%

)步骤 2:用早停法训练 XGBoost

核心参数early_stopping_rounds=5:表示 “连续 5 轮验证集性能不提升,就停止训练”。

# 1. 初始化XGBoost回归模型

xgb_model = xgb.XGBRegressor(

objective='reg:squarederror', # 回归任务的损失函数

learning_rate=0.1, # 学习率(提前设定,也可后续用随机搜索调优)

max_depth=3, # 树的最大深度(提前设定)

random_state=42

)

# 2. 训练并启用早停法:必须指定eval_set(验证集)和eval_metric(评估指标)

xgb_model.fit(

X_train, y_train,

eval_set=[(X_val, y_val)], # 监控验证集性能(核心!)

eval_metric='rmse', # 评估指标:均方根误差(越小越好)

early_stopping_rounds=5, # 核心参数:连续5轮不提升则停止

verbose=True # 打印每轮的训练/验证性能

)

步骤 3:查看早停结果

训练过程中会打印类似日志,关键看最后一行:

[0] alidation_0-rmse:22.143

[1] lidation_0-rmse:20.056

...

[28] idation_0-rmse:2.871

[29] dation_0-rmse:2.869

[30] ation_0-rmse:2.870 # 比上一轮差

[31] lidation_0-rmse:2.872 # 连续1轮差

[32] dation_0-rmse:2.875 # 连续2轮差

[33] alidation_0-rmse:2.878 # 连续3轮差

[34] idation_0-rmse:2.880 # 连续4轮差

[35] ation_0-rmse:2.882 # 连续5轮差 → 停止训练

Stopping. Best iteration:

[29] dation_0-rmse:2.869 # 最佳迭代轮次是29,即最优n_estimators=29 vali valid val v vali va valid vali val va v可以看到:模型在第 29 轮达到最佳验证性能,之后连续 5 轮没进步,于是提前停止 —— 避免了训练到默认的 100 轮(节省了 71 轮的时间),同时自动确定了最优的n_estimators=29。

步骤 4:评估测试集性能

# 用早停后的最佳模型预测测试集

y_pred = xgb_model.predict(X_test)

# 计算测试集RMSE(均方根误差,越小越好)

test_rmse = mean_squared_error(y_test, y_pred, squared=False)

print("测试集RMSE:", test_rmse)

# 示例输出:2.91(与验证集最佳RMSE接近,泛化能力良好)4. 早停法的关键注意事项

- 必须单独划分验证集:不能用测试集监控(会导致过拟合测试集),也不能用交叉验证的中间集(早停法需要实时监控每一轮的性能)。

- 合理设置 patience:patience 太小(如 1)会导致 “过早停止”(模型还没学好就停了);太大(如 20)会浪费时间。通常建议设为 5~10。

- 结合其他调优方法:早停法仅解决n_estimators的调优问题,其他超参数(如 learning_rate、max_depth)仍需用随机搜索 / 网格搜索调优 —— 可先通过随机搜索确定 learning_rate、max_depth,再用早停法确定n_estimators。

最后小结:

在RandomizedSearchCV中集成早停法,需要自定义 “模型训练逻辑”(可通过sklearn.base.BaseEstimator封装 XGBoost 模型,在fit方法中加入早停逻辑),或使用xgboost的cv函数结合随机搜索 —— 这个过程能帮你更深入理解两种方法的协同作用。

更多推荐

已为社区贡献49条内容

已为社区贡献49条内容

所有评论(0)