教你如何简单在本地部署一个属于自己的大模型

本文介绍了如何通过Ollama和OpenWebUI快速搭建本地大模型博客系统。首先下载Ollama并运行模型,然后通过OpenWebUI提供可视化界面,支持多模型对话、语音输入、图像生成等功能。该系统完全离线运行,保障数据隐私,同时提供个性化定制选项。安装过程简单,支持Docker和pip等多种方式,适合没有编程基础的用户快速部署AI辅助博客,实现智能内容生成和问答功能。

简介:

无需专业代码能力,半小时即可拥有专属本地大模型博客!本指南以 “简单三步” 为核心,从基础工具准备(仅需普通电脑 + Docker + 轻量模型),到拉取模板、配置路径、一键启动,全程无复杂操作。博客不仅能存储笔记、感悟,更支持大模型实时生成内容、智能回答文章相关问题,兼顾数据隐私保护与 AI 创作便利。后续还提供卡顿优化、样式自定义等实用技巧,是新手快速搭建 AI 辅助博客的绝佳参考。

一、下载Ollama

进入官网下载Ollama

ollama serve:启动ollama。ollama create:从模型文件创建模型。ollama show:显示模型信息。ollama run:运行模型,会先自动下载模型。ollama pull:从注册仓库中拉取模型。ollama push:将模型推送到注册仓库。ollama list:列出已下载模型。ollama ps:列出正在运行的模型。ollama rm:删除模型。

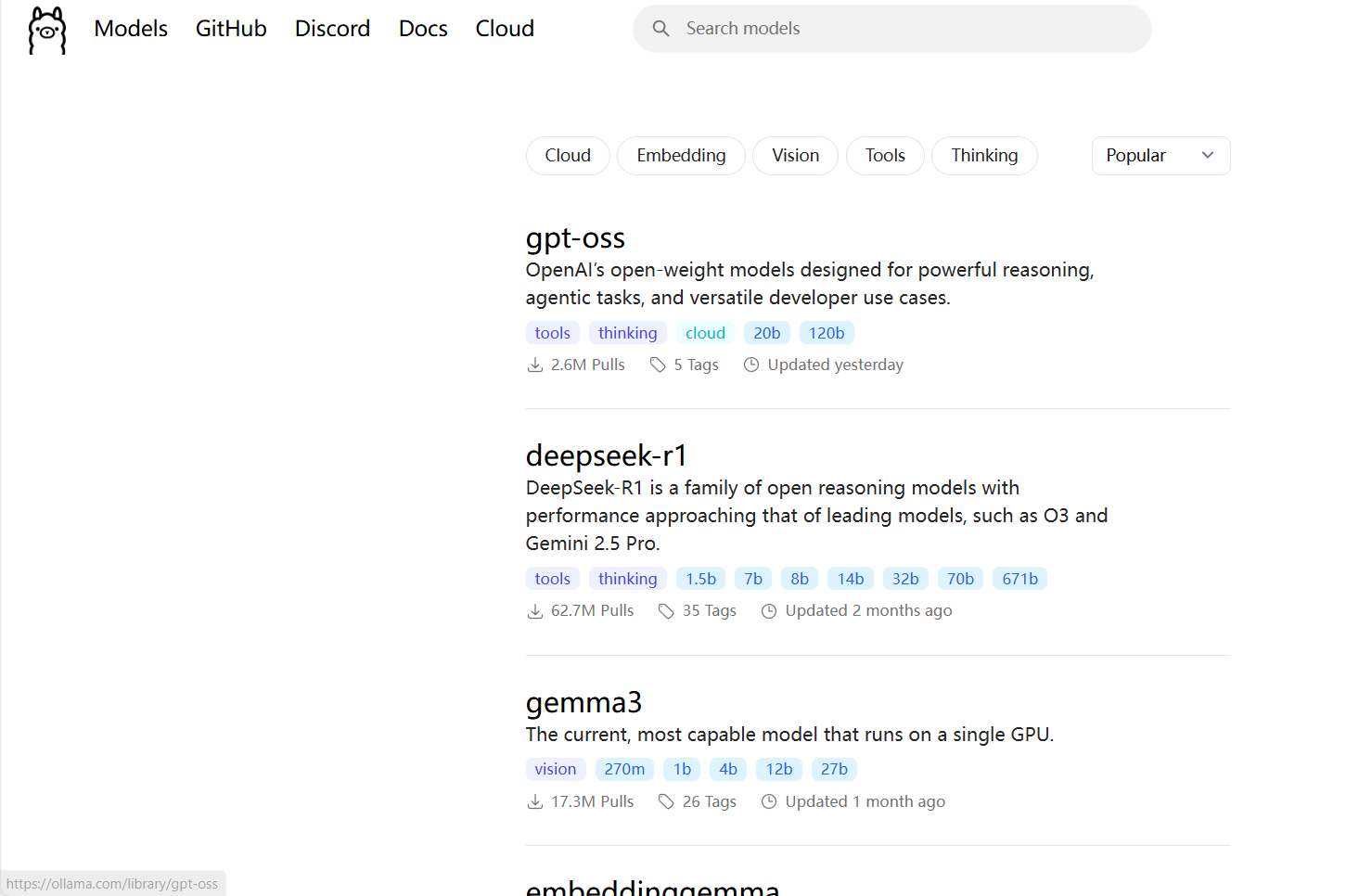

然后点击模型,去选择自己想下载的模型文件。

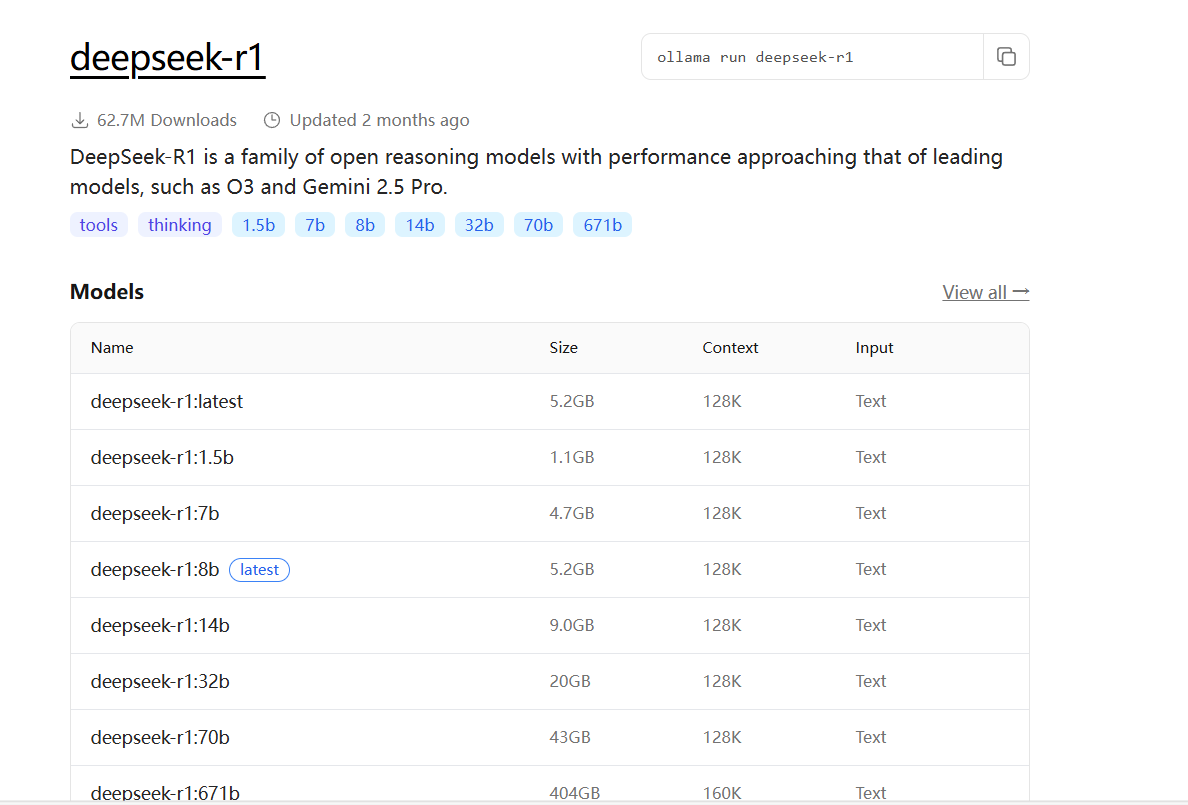

比如这里我想下载deepseek

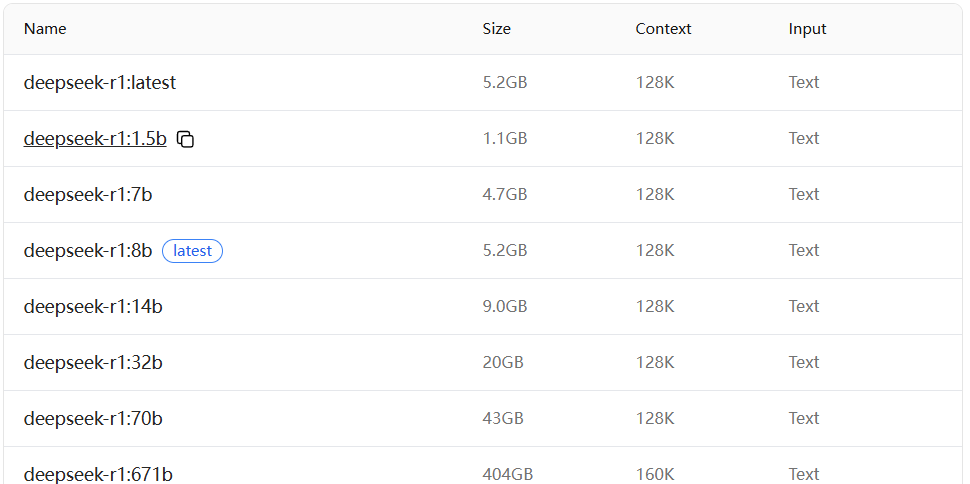

如果你是笔记本这里下载size比较小的模型

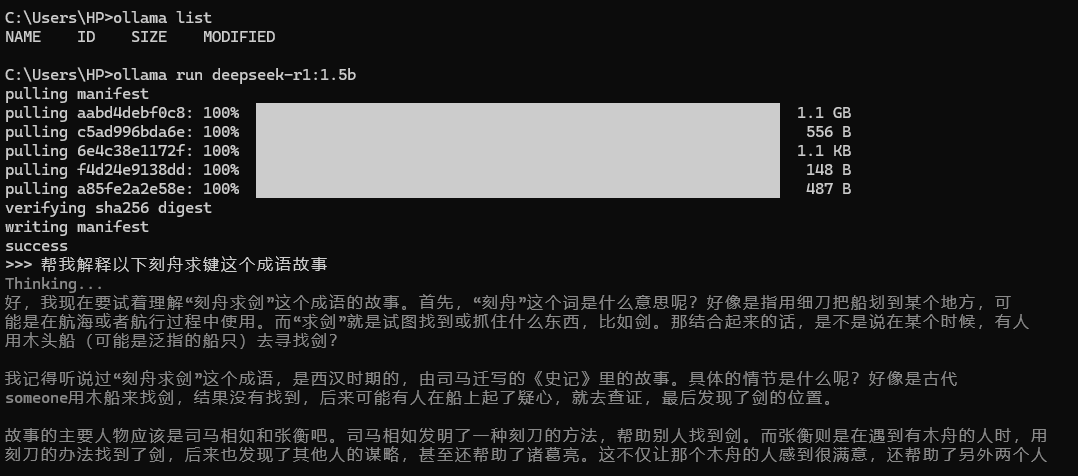

复制名称,进入cmd输入命令

ollama run 名称

然后下载完成就可以使用大模型了,就可以进行对话了。但是这没有页面,就黑黑的我们能不能将它变成前端那样呢,但是我们又没学过前端知识,怎么办呢?

二、Open WebUI

1.简介

Open WebUI 是一个可扩展、功能丰富、用户友好的自托管 WebUI,专为大型语言模型(LLM)设计,旨在完全离线操作。它提供了直观且响应式的用户界面,使用户能够方便地加载、配置、运行和监控各种 AI 模型,而无需编写代码或使用命令行界面。一、主要功能

- 支持多种 LLM:Open WebUI 支持多种大型语言模型运行器,包括 Ollama 和 OpenAI 兼容的 API。

- 多模型对话:用户可以轻松地与多个模型同时互动,利用它们的独特优势获得最佳响应。

- 协作聊天:支持多用户协作聊天,利用多个模型的集体智能进行群聊。

- 再生历史访问记录:允许用户轻松回顾和探索整个再生历史记录。

- 导入 / 导出聊天历史:支持无缝地移入和移出聊天数据。

- 语音输入支持:提供语音输入功能,用户可以通过语音与模型互动。

- 高级参数微调:允许用户通过调整参数(如温度)并定义系统提示,以定制对话到特定偏好和需求。

- 图像生成集成:无缝集成图像生成功能,如 AUTOMATIC1111 API 和 DALL-E,用动态视觉内容丰富聊天体验。

- OpenAI API 集成:无缝集成和定制各种兼容 OpenAI 的 API,增强聊天互动的多功能性。

- 外部 Ollama 服务器连接:支持配置环境变量以连接到托管在不同地址的外部 Ollama 服务器。

- 多个 Ollama 实例负载均衡:支持将聊天请求分布在多个 Ollama 实例上,以提高性能和可靠性。

- 多用户管理:提供直观的管理面板以监督和管理用户。

- 基于角色的访问控制(RBAC):通过限制权限确保安全访问,只有授权的个人才能访问 Ollama,管理员保留专属的模型创建 / 拉取权限。

2.部署与安装

- 支持多种部署方式:Open WebUI 支持 Docker 和 Kubernetes、等容器化技术安装或 pip 直接手动安装,用户可以通过简单的配置和命令实现快速部署和高效管理。官网:http://docs.openwebui.com/

- 安装:安装过程可能涉及配置环境变量、安装必要的依赖项(如 Python 和 Node.js)、下载和配置模型文件等步骤。具体安装步骤可能因操作系统和用户需求而有所不同。三、应用场景

- 本地模型调试与调用:Open WebUI 为本地大语言模型提供了图形化界面,方便用户进行模型调试和调用。

- 离线运行:由于 Open WebUI 旨在完全离线操作,因此它非常适合在没有网络连接或需要保护数据隐私的环境中使用。

- 个性化定制:用户可以根据自己的需求对 Open WebUI 进行个性化定制,如调整界面布局、添加自定义功能等。

进入官网

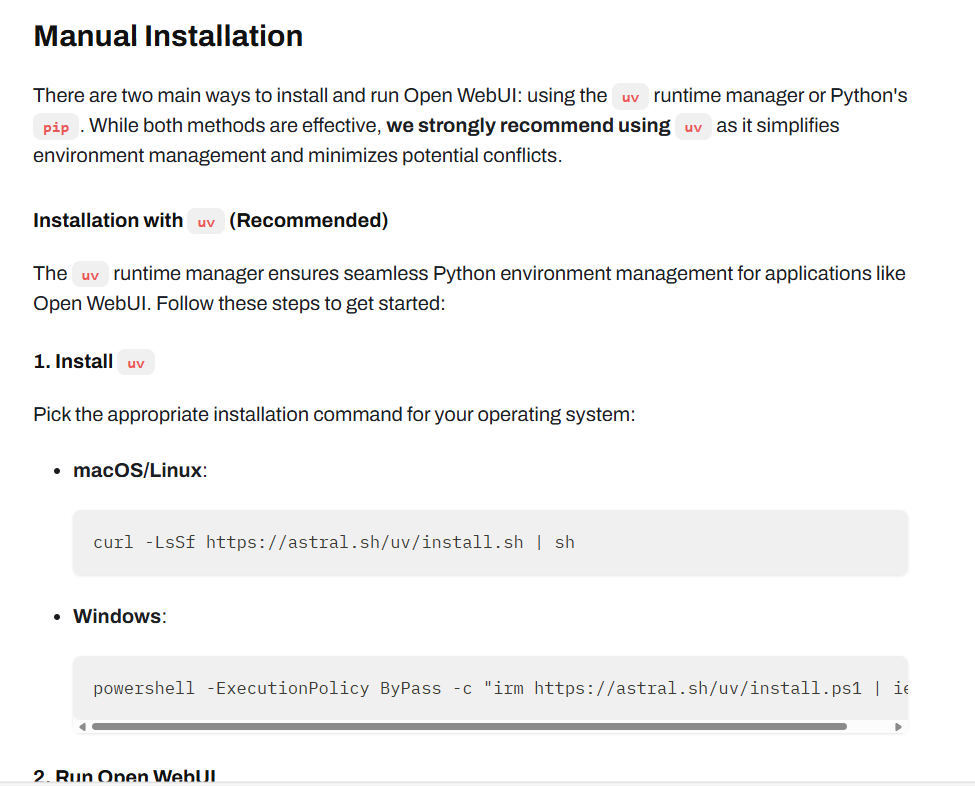

下拉到Manual Installation安装方式

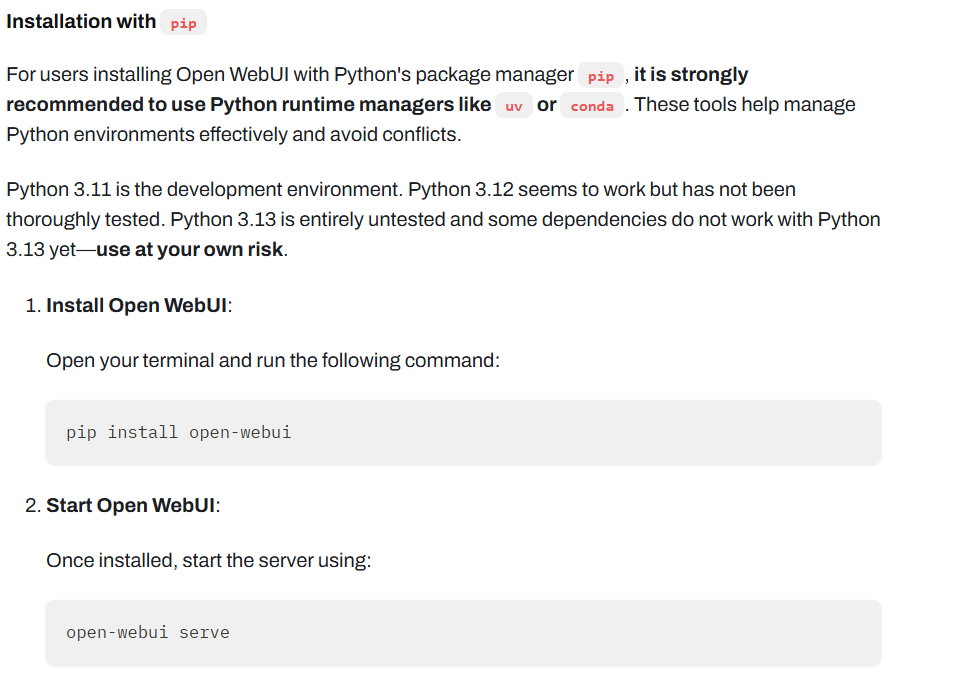

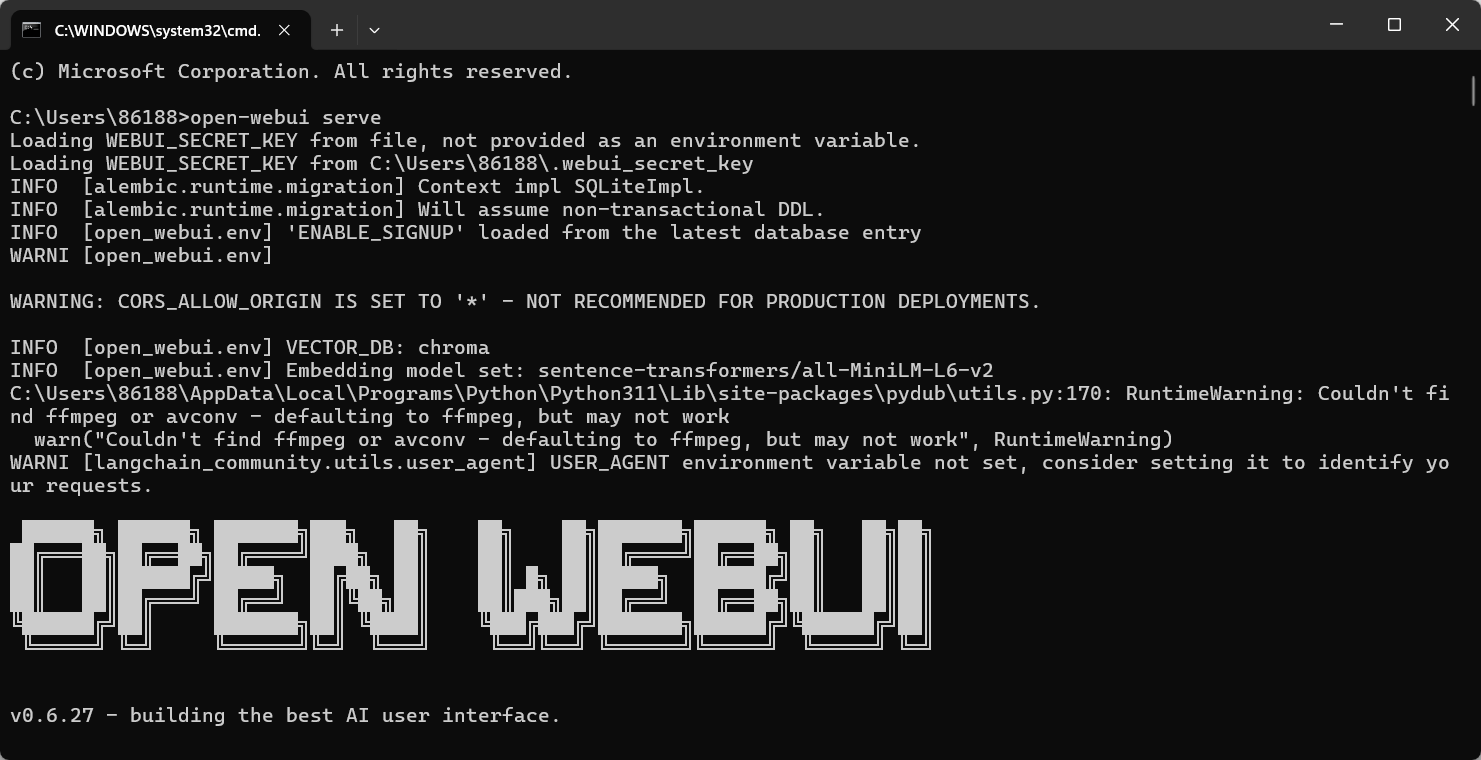

在终端输入pip命令下载,然后启动服务。

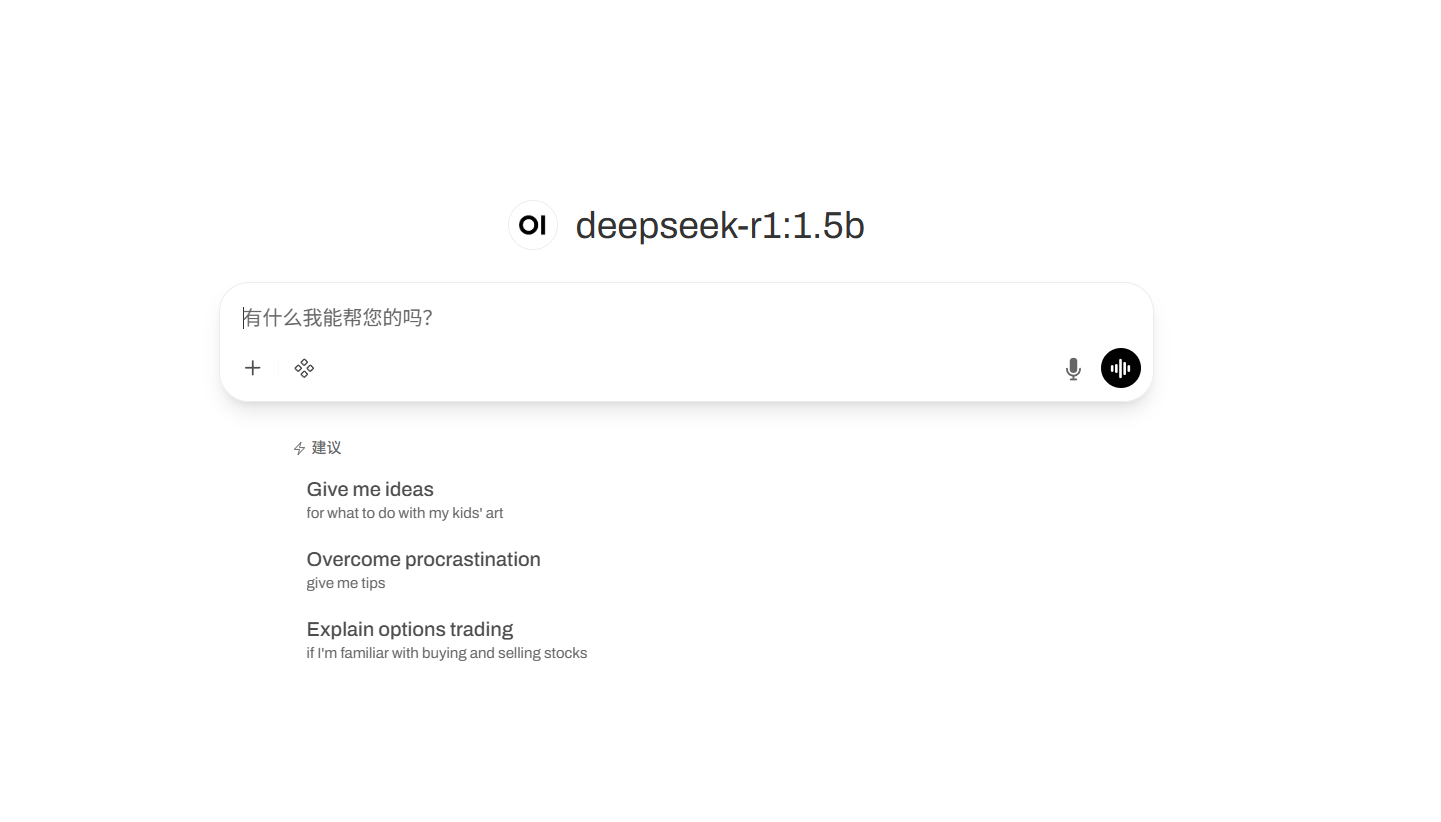

然后打开这个网站,就可以进入本地大模型页面

然后在这里我们还可以对本地大模型进行微调等操作后面会详细介绍哟

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)