AI智能体第4期——深入了解人工智能智能体的不同类型:反应式、规划式等

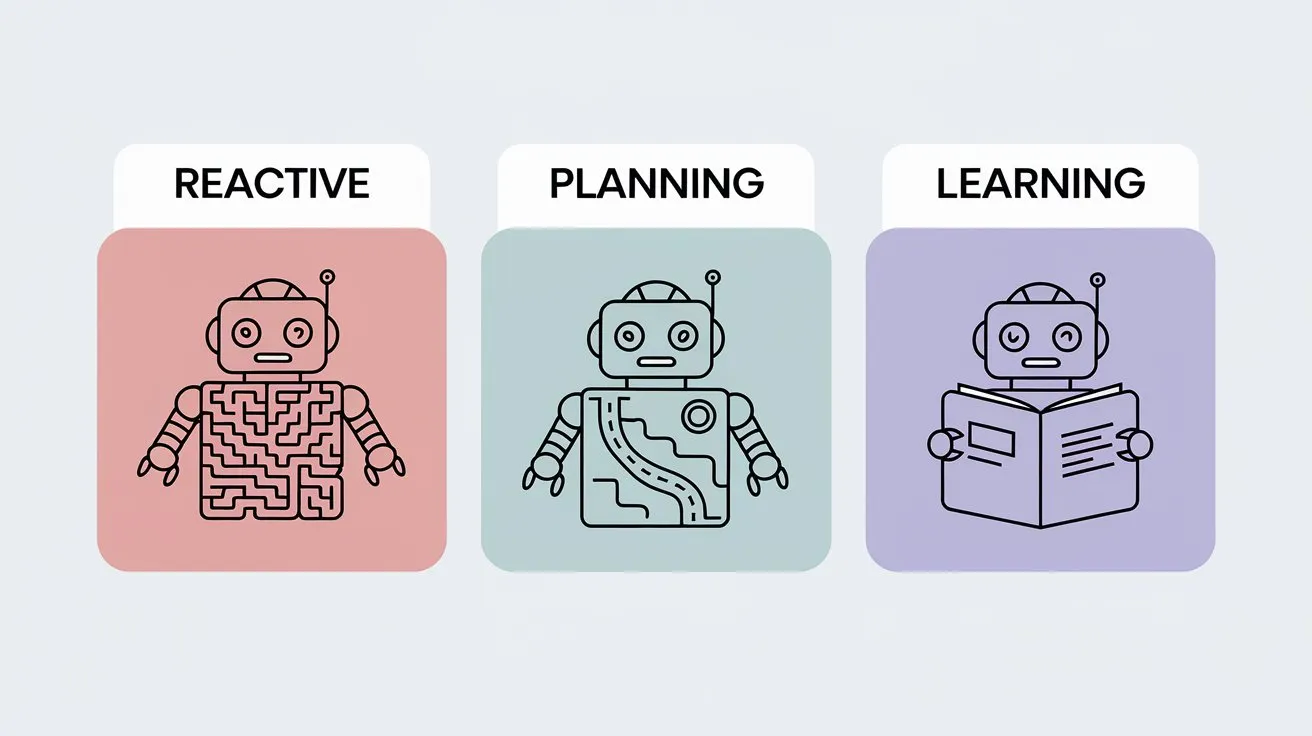

AI智能体类型解析:从反应式到学习型智能体 本文系统介绍了人工智能智能体的主要类型及其特性。人工智能智能体作为能够感知环境、自主决策并执行的系统,正从简单规则驱动向复杂自主学习演进。文章重点分析了6类智能体:仅响应当前输入的反应式智能体;具备内部状态记忆的模型反射智能体;以目标为导向的决策系统;基于效用最大化的优化型智能体;能够自我改进的学习型智能体;以及融合多种方法的混合智能体。通过对比表格展示

*大家好,我是AI拉呱,一个专注于人工智领域与网络安全方面的博主,现任资深算法研究员一职,热爱机器学习和深度学习算法应用,拥有丰富的AI项目经验,希望和你一起成长交流。关注AI拉呱一起学习更多AI知识。

AI智能体第4期——深入了解人工智能智能体的不同类型:反应式、规划式等

随着人工智能从基于规则的系统向自主实体演进,“智能体人工智能”(Agentic AI)这一概念逐渐成为关键范式。其核心是人工智能智能体——一种能够感知周围环境、做出决策并自主采取行动以实现目标的系统。

按回车键或点击即可查看完整尺寸图片

本文是“智能体人工智能”系列的第四篇,深入探讨了人工智能智能体的各类类型,从简单的基于反射的系统到复杂的效用最大化学习系统不等。这些智能体架构是各类人工智能系统的基础,涵盖聊天机器人、自动驾驶汽车以及自动化交易平台等。

无论你从事智能助手还是自主机器人领域的开发工作,了解这些智能体类型对于打造高效的人工智能系统都至关重要。

什么是人工智能智能体?

人工智能智能体指具备以下能力的实体:

- 通过传感器感知环境

- 根据感知结果和内部模型决定采取何种行动

- 通过执行器对环境施加影响

+-----------------+

| 传感器 |<-- 感知环境

+--------+--------+

|

v

+--------+--------+

| 人工智能智能体 |

| - 感知模块 |

| - 决策模块 |

| - 行动模块 |

+--------+--------+

|

v

+--------+--------+

| 执行器 |--> 影响环境

+-----------------+

这种“感知-思考-行动”的循环,让智能体能够与周围环境进行动态交互。

人工智能智能体的分类维度

人工智能智能体可从多个维度进行区分:

- 反应性:智能体仅能做出反应,还是具备规划能力?

- 记忆能力:智能体仅使用当前输入,还是会结合历史数据?

- 学习能力:智能体能否随时间推移进行自我调整?

- 目标导向性:智能体是否为实现特定结果而设计?

人工智能智能体类型概览

| 智能体类型 | 是否使用记忆 | 是否目标导向 | 是否具备学习能力 | 复杂程度 | 示例 |

|---|---|---|---|---|---|

| 反应式智能体 | ❌ | ❌ | ❌ | 低 | 恒温器、基础机器人 |

| 基于模型的反射智能体 | ✅ | ❌ | ❌ | 中 | 导航系统 |

| 目标导向智能体 | ✅ | ✅ | ❌ | 中 | 游戏人工智能、机械臂 |

| 效用导向智能体 | ✅ | ✅ | ❌ | 高 | 股票交易机器人、助手 |

| 学习型智能体 | ✅ | ✅ | ✅ | 极高 | 自动驾驶汽车 |

| 混合式智能体 | ✅ | ✅ | ✅ | 极高 | 机器人、虚拟智能体 |

反应式智能体

反应式智能体是一种实时运行的智能实体,仅对来自周围环境的感官输入做出响应。它们不会提前思考、规划或回忆过往经历,只会单纯地做出反应。

这类智能体遵循“感知-行动”循环,具体流程为:

- 感知当前发生的情况

- 依据固定规则采取行动

可以将其理解为“反射行为”——简单、迅速且直接。

反应式智能体的特征

| 特征 | 描述 |

|---|---|

| 无记忆功能 | 不存储也不使用任何历史信息,所有决策均基于当前输入 |

| 无规划能力 | 无法模拟未来事件,也无法计算长期后果 |

| 快速高效 | 由于无需内部处理,反应几乎即时发生 |

| 基于规则的行为 | 受预设的“如果-那么”(if-this-then-that)规则约束 |

| 智能有限 | 不具备适应性,也无法随时间推移学习新能力 |

实际应用案例

- 调节温度的恒温器

- 基础避障机器人

- 简单视频游戏中的非玩家角色(NPC)

工作原理

遵循“如果满足条件,则执行行动”(IF condition THEN action)的逻辑。例如,扫地机器人可能遵循以下规则:

如果检测到碰撞(bump_detected),则向右转(turn_right)

反应式智能体的Python实现示例

class ReactiveVacuumAgent:

def __init__(self):

pass

def perceive_and_act(self, percept):

if percept == "dirty":

return "suck" # 感知到灰尘,执行吸尘动作

elif percept == "bump":

return "turn_right" # 感知到碰撞,执行右转动作

else:

return "move_forward" # 无特殊情况,执行前进动作

# 实例化智能体并测试

agent = ReactiveVacuumAgent()

print(agent.perceive_and_act("dirty")) # 输出:suck

优缺点分析

| 优点 | 缺点 |

|---|---|

| 实现简单 | 无学习能力,不具备适应性 |

| 响应迅速 | 无法应对复杂环境 |

| 资源消耗低 | 无法理解未来结果 |

基于模型的反射智能体

基于模型的反射智能体在简单反射智能体的基础上新增了“内部世界模型”,从而扩展了功能。该模型能让智能体跟踪环境状态随时间的变化,使其在复杂、动态或部分可观测的场景中表现得更智能。

核心特征

- 维护内部世界模型:智能体根据当前和过往的感知结果,跟踪环境状态。即便在某一时刻无法获取完整数据,这种记忆能力也能让智能体做出决策。

- 更优的决策能力:与仅对当前输入做出响应的简单反射智能体不同,基于模型的智能体可利用内部模型推断环境中未被观测到的部分,从而在动态环境中表现出更智能的行为。

- 带记忆的规则驱动:决策过程仍基于“条件-行动”规则(if-then逻辑),但会借助存储的信息实现上下文感知的行动。

- 随时间适应:内部状态会随每次新的感知结果更新,使智能体能随着环境变化调整自身行为。

架构流程

输入 → 传感器 → 状态更新 → 规则匹配 → 行动

实际应用案例

- 导航系统:谷歌地图等GPS应用会记录过往路线、交通模式或绕行信息,从而提供更智能的导航决策。

- 智能家居助手:恒温器、照明系统等设备会根据时间、用户习惯和过往活动进行调整,例如观察到用户的睡前习惯后,在晚上自动调暗灯光。

- 自主火星探测器:“毅力号”“好奇号”等探测器会分析地形历史数据,调整行进路线、避开障碍物,或根据过往观测优化样本采集方案。

基于模型的反射智能体Python实现示例

class ModelBasedAgent:

def __init__(self):

self.world_model = {} # 初始化内部世界模型,用于存储环境状态

def update_model(self, percept):

# 根据感知结果更新模型(示例:记录上一次感知到的信息)

self.world_model["last_percept"] = percept

def act(self):

# 基于内部模型决策

if self.world_model.get("last_percept") == "obstacle":

return "turn" # 若上一次感知到障碍物,则执行转向动作

else:

return "move_forward" # 否则执行前进动作

def perceive_and_act(self, percept):

self.update_model(percept) # 先更新模型

return self.act() # 再执行行动

目标导向智能体

与即时响应事件的反射式智能体不同,目标导向智能体的决策依据是期望达成的结果。它们会通过预测不同行动的后果,选择能更接近特定目标的行动方案。

目标导向智能体的核心特征

| 特征 | 描述 |

|---|---|

| 目标制定 | 明确智能体旨在实现的期望结果 |

| 规划/搜索 | 利用算法寻找实现目标的路径或行动序列 |

| 决策能力 | 评估并选择有助于实现目标的行动 |

| 适应性 | 通过灵活规划,有效应对新场景或复杂情况 |

实际应用场景

| 应用场景 | 描述 |

|---|---|

| 游戏人工智能 | 通过预判对手动作,制定获胜策略 |

| 制造业机械臂 | 确定最高效的动作序列,完成零件组装 |

| 自主无人机 | 利用动态环境数据,寻找前往目的地的最优路径 |

| 配送机器人 | 在变化的环境中导航,同时避开障碍物 |

| 虚拟助手 | 根据用户目标和上下文,规划响应内容或行动步骤 |

目标导向智能体流程图

[目标制定] → [搜索/规划] → [选择行动] → [执行]

基于A*算法的目标导向智能体规划实现

import heapq

def a_star_search(start, goal, neighbors_fn, heuristic_fn):

"""

A*算法实现目标导向的路径规划

参数:

- start: 起始节点

- goal: 目标节点

- neighbors_fn: 函数,输入节点返回其相邻节点列表

- heuristic_fn: 启发函数,估算节点到目标的距离

返回:

- came_from: 字典,记录每个节点的前驱节点,用于回溯路径

"""

frontier = [(0, start)] # 优先队列,存储(优先级, 节点)

came_from = {start: None} # 记录路径

cost_so_far = {start: 0} # 记录从起始节点到当前节点的累计成本

while frontier:

_, current = heapq.heappop(frontier) # 取出优先级最高的节点

if current == goal: # 到达目标节点,终止搜索

break

# 遍历当前节点的所有相邻节点

for next_node in neighbors_fn(current):

new_cost = cost_so_far[current] + 1 # 假设每步成本为1(均匀成本)

# 若相邻节点未被访问,或发现更优路径

if next_node not in cost_so_far or new_cost < cost_so_far[next_node]:

cost_so_far[next_node] = new_cost

# 计算优先级:累计成本 + 启发函数估算的剩余成本

priority = new_cost + heuristic_fn(next_node, goal)

heapq.heappush(frontier, (priority, next_node))

came_from[next_node] = current # 更新前驱节点

return came_from

当目标发生变化或获取到新信息时,上述循环可能会重复执行。

效用导向智能体

目标导向智能体关注“是否达成目标”,而效用导向智能体则提出了一个更具深度的问题:“哪种行动能带来最理想的结果?”。

这种思维转变让智能体具备了更强的灵活性、细致的推理能力和应对不确定性的优化能力,使其成为金融、医疗、电商等领域先进人工智能系统的基础。

效用导向智能体的核心构成

效用导向智能体的核心是效用函数——一种将每个可能状态或结果映射为实数(效用值)的数学模型。智能体的目标不是简单地达成“非黑即白”的目标,而是选择能最大化期望效用的行动。

| 组件 | 描述 |

|---|---|

| 感知模块 | 收集当前环境状态信息 |

| 模型模块 | 预测不同行动可能产生的结果 |

| 效用函数 | 量化每个结果的理想程度 |

| 决策函数 | 选择能最大化期望效用的行动 |

效用函数:将偏好形式化

def utility_function(state):

"""

示例效用函数:为不同状态分配效用值(0-1之间)

状态描述:

- high_profit_low_risk: 高收益低风险

- moderate_profit_low_risk: 中收益低风险

- high_profit_high_risk: 高收益高风险

- 其他状态:默认低效用

"""

if state == "high_profit_low_risk":

return 0.9

elif state == "moderate_profit_low_risk":

return 0.7

elif state == "high_profit_high_risk":

return 0.6

else:

return 0.3

智能体可模拟行动(如买卖股票)的后果,并通过该效用函数评估最终状态的价值。

效用导向智能体的Python实现示例

def expected_utility(action, transition_model, utility_function):

"""

计算某一行动的期望效用

参数:

- action: 待评估的行动

- transition_model: 转移模型,记录行动到各状态的概率

- utility_function: 效用函数

返回:

- expected: 该行动的期望效用

"""

expected = 0

# 遍历行动可能导致的所有状态及对应概率

for state, prob in transition_model[action].items():

expected += prob * utility_function(state) # 概率加权求和

return expected

# 示例:股票交易的转移模型(行动"买入股票"对应的状态概率分布)

transition_model = {

"buy_stock": {

"high_profit_low_risk": 0.4,

"moderate_profit_low_risk": 0.3,

"high_profit_high_risk": 0.2,

"low_profit_low_risk": 0.1

}

}

# 评估"买入股票"行动的期望效用

action = "buy_stock"

eu = expected_utility(action, transition_model, utility_function)

print(f"行动'{action}'的期望效用:{eu:.2f}")

效用导向智能体的应用场景

| 行业 | 应用示例 |

|---|---|

| 金融领域 | 投资组合管理、算法交易 |

| 医疗领域 | 平衡疗效、成本和副作用的治疗方案规划 |

| 电商领域 | 基于用户和商业效用的定价与推荐系统 |

| 自主系统领域 | 平衡时间、安全性和燃油效率的自动驾驶汽车 |

效用导向智能体的优势

| 优势 | 解释 |

|---|---|

| 灵活性 | 可评估并比较多个相互竞争的结果 |

| 适应性 | 通过重新评估期望效用,应对动态环境 |

| 稳健性 | 即使结果存在不确定性,也能做出最优决策 |

| 符合人类偏好 | 可设计为反映现实世界中复杂的权衡关系 |

目标导向与效用导向智能体对比

| 特征 | 目标导向智能体 | 效用导向智能体 |

|---|---|---|

| 目标 | 达成特定目标 | 最大化结果的价值 |

| 决策标准 | 是否达成目标? | 哪种结果最优? |

| 权衡处理能力 | 无 | 有 |

| 灵活性 | 中等 | 高 |

| 应用场景 | 导航、机器人技术 | 金融、推荐系统 |

学习型智能体

学习型智能体是一种通过与环境交互,不断提升自身行为和决策能力的智能系统。与仅依赖预设规则的静态智能体不同,学习型智能体可通过分析反馈、优化策略,更高效地应对动态、不确定或复杂的场景。

学习型智能体的核心组件

- 学习模块:学习型智能体的核心,负责更新智能体的知识并改进决策过程。它会根据从环境中收集的数据和获取的反馈,调整智能体的策略或规则。常见的学习方法包括:

- 监督学习(从带标签样本中学习)

- 强化学习(从奖励和惩罚中学习)

- 无监督学习(无需明确反馈,自主发现模式)。

- 执行模块:直接与环境交互,根据智能体当前的知识或策略选择行动。它通过决定下一步行动来实现智能体的行为,目标是最大化性能或达成特定目标。

- 评估模块(评估器):通过将智能体的行动及其结果与某种性能指标对比,评估智能体的表现。它通常以奖励或误差信号的形式提供反馈,指导学习模块改进未来决策。

- 问题生成模块:为避免智能体行为停滞、提升学习效果,该模块会鼓励智能体探索新的行动或策略,可能带来更优性能。在智能体需探索新解决方案而非仅依赖已知方法的复杂环境中,探索行为至关重要。

实际应用案例

- 从交通模式中学习的自动驾驶汽车

- 不断优化推荐内容的推荐引擎

- 通过自我对弈提升水平的游戏智能体

基于强化学习的Q学习智能体(简化版)

import random

class QLearningAgent:

def __init__(self, actions, alpha=0.5, gamma=0.9, epsilon=0.1):

"""

初始化Q学习智能体

参数:

- actions: 智能体可执行的行动列表

- alpha: 学习率(0-1),控制更新幅度

- gamma: 折扣因子(0-1),控制未来奖励的权重

- epsilon: 探索率(0-1),控制随机探索的概率

"""

self.q = {} # Q表:存储(state, action)到Q值的映射

self.actions = actions

self.alpha = alpha

self.gamma = gamma

self.epsilon = epsilon

def get_q(self, state, action):

"""获取(state, action)对应的Q值,默认0.0"""

return self.q.get((state, action), 0.0)

def choose_action(self, state):

"""基于ε-贪心策略选择行动:兼顾探索与利用"""

if random.random() < self.epsilon:

# 探索:随机选择行动

return random.choice(self.actions)

# 利用:选择当前Q值最大的行动

q_values = [self.get_q(state, a) for a in self.actions]

max_q = max(q_values)

return self.actions[q_values.index(max_q)]

def learn(self, state, action, reward, next_state):

"""根据Q学习公式更新Q值"""

old_q = self.get_q(state, action)

# 计算下一状态的最大Q值

future_q = max([self.get_q(next_state, a) for a in self.actions])

# Q值更新公式:Q(s,a) = Q(s,a) + α[R + γ·maxQ(s',a') - Q(s,a)]

self.q[(state, action)] = old_q + self.alpha * (reward + self.gamma * future_q - old_q)

优缺点分析

| 优点 | 缺点 |

|---|---|

| 随时间推移不断改进 | 需要大量数据或试验样本 |

| 可适应动态变化 | 可能出现过拟合或收敛效果差的问题 |

| 适用于复杂任务 | 训练过程计算成本高 |

混合式智能体

在复杂、动态的环境中,单一的智能体架构无法应对所有决策任务。混合式智能体通过融合反应式、慎思式(目标导向或效用导向)和学习型等多种人工智能范式,构建出灵活且稳健的系统。这类智能体充分利用每种模型的优势,既能实现快速反射,也能进行审慎规划。

混合式智能体的架构类型

1. 分层架构

- 描述:架构按层级组织,每一层对应一种特定行为模式。

- 示例层级:

- 反应层:对环境刺激做出即时响应

- 慎思层:基于目标进行规划和决策

- 元层:随时间推移进行学习和适应

- 协作方式:各层级可并行工作或按层级协作,通常采用基于优先级的覆盖机制(例如,安全关键行为优先)。

- 类比:类似人类大脑——既能反射性地将手从火中缩回(反应式),也能规划公路旅行(慎思式),还能学习新路线(学习型)。

2. BDI模型(信念-愿望-意图模型)

- 信念(Beliefs):智能体对世界的内部认知(已知信息)

- 愿望(Desires):智能体希望实现的目标或状态

- 意图(Intentions):为实现愿望而承诺采取的特定计划或行动

- 优势:模拟人类推理方式,具备适应性,支持目标修正和计划更新。

- 应用领域:自主系统、游戏智能体、机器人技术

实际应用案例:自动驾驶汽车

自动驾驶汽车是混合式智能体的典型例子,集成了多个智能层级:

| 策略类型 | 在汽车中的作用 |

|---|---|

| 反应式 | 当突然出现障碍物时,立即停车或转向 |

| 目标导向 | 规划并遵循从当前位置到目的地的路线 |

| 效用导向 | 基于成本函数(如最短距离、最安全路线、交通最少路线)从多条可能路线中选择 |

| 学习型 | 学习驾驶员偏好(如偏爱高速公路)和城市交通模式(如下午5点的交通状况) |

这种组合让自动驾驶汽车兼具响应性、目的性、高效性和适应性——这些都是高效混合式智能体的核心特征。

混合式智能体的结构

+-------------------------+

| 学习组件 | <- 随时间优化决策

+-------------------------+

| 效用导向规划组件 | <- 评估长期最优结果

+-------------------------+

| 目标导向模块 | <- 规划实现目标的路径

+-------------------------+

| 反应式系统 | <- 对即时刺激做出响应

+-------------------------+

混合式智能体的优势

- 灵活性:可根据上下文在反应式行动和慎思式行动之间切换。

- 稳健性:若规划失败,可依赖更简单的行为模式,降低故障风险。

- 可扩展性:模块化设计便于扩展新功能(如情感建模)。

- 适应性:能从经验中学习,随时间提升性能。

面临的挑战

- 协作复杂性:要实现各层级无冲突集成并非易事。

- 资源消耗:更复杂的智能体需要更多计算能力和内存。

- 设计难度:需精心设计架构,平衡响应速度与智能水平。

各类智能体对比总结

| 智能体类型 | 是否具备记忆 | 是否目标导向 | 是否具备学习能力 | 是否具备规划能力 | 是否具备效用感知 | 应用场景 |

|---|---|---|---|---|---|---|

| 反应式智能体 | ❌ | ❌ | ❌ | ❌ | ❌ | 恒温器、避障系统 |

| 基于模型的反射智能体 | ✅ | ❌ | ❌ | ❌ | ❌ | 智能设备、扫地机器人 |

| 目标导向智能体 | ✅ | ✅ | ❌ | ✅ | ❌ | 游戏人工智能、自主导航 |

| 效用导向智能体 | ✅ | ✅ | ❌ | ✅ | ✅ | 金融机器人、智能助手 |

| 学习型智能体 | ✅ | ✅ | ✅ | ✅ | ✅ | 自动驾驶汽车、推荐系统 |

| 混合式智能体 | ✅ | ✅ | ✅ | ✅ | ✅ | 机器人、大型语言模型智能体、辅助系统 |

智能体人工智能的未来

我们正步入一个新的时代——智能体不再受限于简单规则或僵化架构。未来的发展方向主要包括以下几个方面:

多智能体系统

在物流、国防、多机器人协作等复杂应用中,多个智能体将通过协作或竞争实现目标。协调、协商和分布式智能将成为关键能力。

基于大型语言模型(LLM)的智能体

GPT、Claude、Gemini等语言模型正推动新一代认知智能体的发展,这类智能体将自然语言理解与规划、推理能力相结合。它们能遵循自然语言指令(如“规划一次1500美元以内的假期”),而LangChain、AutoGen、CrewAI等工具正推动这类智能体走向实际应用(若你对这些工具感兴趣,可参考本系列上一篇文章)。

具身人工智能与传感器融合

智能体与物理硬件(机器人、无人机)及多模态传感器的集成,将使其能在现实世界中行动并适应环境。

持续学习与元学习

未来的智能体将具备以下能力:

- 跨任务、跨时间持续学习

- 无需重新训练即可适应不同领域

- 借助元学习实现“学会如何学习”。

伦理与对齐

随着智能体自主性的提升,与人类意图的对齐变得至关重要,具体包括:

- 价值观对齐

- 决策透明化

- 防护机制与控制手段。

在“智能体人工智能”系列的第四篇文章中,我们探讨了人工智能智能体的多样类型——从简单的基于规则的反射式智能体,到融合学习与效用优化的复杂混合式智能体。

本系列的下一篇文章将深入探讨基于大型语言模型的智能体,分析LangChain、AutoGen等工具如何重新定义现代智能体架构,以及如何构建自己的GPT驱动型智能体。

#人工智能 #机器学习 #智能体人工智能 #人工智能智能体 #人工智

关注“AI拉呱”一起学习更多AI知识!

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)