大显存硬件实战:应对 8K 剪辑、AI 训练的高效秘籍

8K剪辑与AI训练对大显存硬件有核心需求:8K剪辑因海量数据缓存、特效渲染和导出编码需要16GB以上显存;AI训练则需存储模型参数、批量数据和中间结果,70亿参数模型FP16训练需140GB显存。硬件配置上,8K剪辑推荐RTX 4090 24GB或专业级RTX A6000 48GB,搭配高速存储和64-128GB内存;AI训练根据模型规模选择RTX 4090(10亿参数内)或A100/H100(1

在专业内容创作与人工智能技术爆发的当下,8K 剪辑与 AI 训练已从 “高端需求” 转变为行业标配。然而,这两大场景对硬件的核心诉求高度聚焦于显存性能——8K 素材的海量数据吞吐、AI 模型的参数存储与计算,都需要大显存作为 “数据战场”。本文将从实战角度出发,拆解 8K 剪辑与 AI 训练的显存痛点,提供硬件选型、配置优化、场景适配的全流程解决方案,让大显存硬件真正发挥 “效率倍增器” 的作用。

一、核心认知:为什么 8K 剪辑与 AI 训练离不开大显存?

(一)8K 剪辑的显存 “刚需”:从素材加载到特效渲染的全链路消耗

8K 视频(分辨率 7680×4320)单帧未压缩数据量约33MB(按 10bit RGB 计算),1 分钟 60 帧的素材容量可达118.8GB,即便采用 H.265 编码压缩,1 小时素材仍需 50-100GB 存储空间。这种 “海量数据” 特性,对显存提出三重考验:

- 素材缓存瓶颈

剪辑软件(如 Premiere Pro、DaVinci Resolve)会将待处理的视频片段、音频轨道、字幕文件加载至显存临时存储。若显存不足(如 8GB 及以下),软件需频繁在 “显存 - 内存 - 硬盘” 之间交换数据,导致时间线卡顿、拖拽掉帧,甚至出现 “素材加载失败” 报错。

▶ 实战数据:用 DaVinci Resolve 剪辑 8K H.265 素材,添加 3 层叠加轨道 + LUT 调色,16GB 显存可流畅操作,8GB 显存则每 30 秒出现 1 次卡顿(测试环境:RTX 4070 12GB vs RTX 4080 16GB)。 - 特效与合成的显存占用峰值

当添加复杂特效(如粒子效果、3D 合成、动态模糊)或进行多轨叠加时,显存占用会呈 “阶梯式飙升”。例如,在 After Effects 中为 8K 视频添加 “CC Particle World” 特效,单帧显存占用可达4-6GB,若同时处理 10 帧预渲染,需至少 40GB 显存才能避免崩溃。 - 导出渲染的 “隐形消耗”

8K 视频导出时(尤其是 H.265 10bit 编码),GPU 需同时处理 “编码计算” 与 “帧缓存” 双重任务。以导出 1 小时 8K 视频为例,NVIDIA NVENC 编码器需占用8-12GB 显存存储编码参数与临时帧数据,若显存不足,会自动切换至 CPU 软编码,速度下降 70% 以上。

(二)AI 训练的显存 “黑洞”:模型参数与计算过程的双重压力

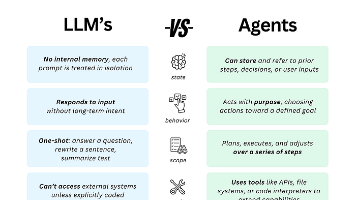

AI 训练的显存消耗遵循 “模型参数 + 批量数据 + 中间计算结果” 的叠加逻辑,尤其是大语言模型(LLM)与计算机视觉(CV)模型,对显存的需求呈指数级增长:

|

模型类型 |

代表模型 |

参数量 |

单卡训练最低显存 |

批量大小(Batch Size)与显存关系(以 A100 为例) |

|

图像生成模型 |

Stable Diffusion 1.5 |

12 亿 |

12GB(FP32) |

Batch Size=8(16GB)→ Batch Size=32(40GB) |

|

大语言模型 |

LLaMA 2 7B |

70 亿 |

24GB(FP16) |

Batch Size=4(24GB)→ Batch Size=16(64GB) |

|

计算机视觉模型 |

ViT-B/16 |

13 亿 |

8GB(FP32) |

Batch Size=32(8GB)→ Batch Size=128(32GB) |

1、模型参数存储

模型权重的精度直接决定显存占用:FP32(单精度)每参数占 4 字节,FP16(半精度)占 2 字节,BF16(脑半精度)占 2 字节,INT8(量化)占 1 字节。例如,70 亿参数的 LLaMA 2 用 FP32 训练需 280GB 显存,用 FP16 可降至 140GB,而 INT8 量化后仅需 70GB,但会损失部分精度。

2、批量数据加载

训练时每次送入 GPU 的 “批量样本”(如 16 张图片、32 条文本)需全部存入显存。以 ViT 模型处理 224×224 分辨率图像为例,单张图片(3 通道、FP32)占 60MB,Batch Size=64 时仅数据加载就需 3.84GB 显存,叠加模型参数后,总占用轻松突破 10GB。

3、中间计算结果缓存

反向传播过程中,GPU 需缓存每一层网络的输入输出特征图(Feature Map),这部分消耗往往是模型参数的 2-3 倍。例如,训练 Stable Diffusion 时,UNet 网络的中间特征图缓存占比达 60%,12GB 显存仅能支持 Batch Size=2,而 48GB 显存可将 Batch Size 提升至 16,训练速度提升 8 倍。

二、8K 剪辑大显存硬件实战:从单机配置到协同优化

(一)核心硬件选型:“GPU + 存储 + 内存” 黄金三角

8K 剪辑的硬件配置需围绕 “显存优先、存储提速、内存兜底” 原则,不同预算下的配置方案差异显著:

1. 消费级方案(预算 2-3 万元):兼顾性价比与流畅度

- GPU(核心):优先选择NVIDIA RTX 4090 24GB或AMD RX 7900 XTX 24GB

RTX 4090:凭借 CUDA 核心与 NVENC 编码器,在 Premiere Pro 中 8K 导出速度比 RTX 4080 快 40%,支持 DaVinci Resolve 的 GPU 加速调色,24GB GDDR6X 显存可满足 4 层 8K 轨道叠加 + 复杂特效。

RX 7900 XTX:性价比更高,24GB GDDR6 显存支持 OpenCL 加速,适合以 DaVinci Resolve 为主的剪辑场景,但在 Adobe 系列软件中兼容性略逊于 NVIDIA。

- 存储:双盘方案 ——1TB PCIe 4.0 NVMe(系统 + 软件)+ 4TB SSD(素材缓存)

推荐型号:三星 990 Pro(读取 7450MB/s)、西数 SN850X(读取 7300MB/s),避免使用 SATA 接口硬盘(速度不足 500MB/s,素材加载延迟高)。

- 内存:64GB DDR5 5600MHz(双通道)

当显存不足时,系统会调用内存作为 “虚拟显存”,64GB 内存可避免 8K 多轨剪辑时的内存溢出,单通道内存会导致带宽不足,拖慢数据交换速度。

2. 专业级方案(预算 5-8 万元):满足电影级制作需求

- GPU:NVIDIA RTX A6000 48GB或AMD Radeon Pro V620 32GB

RTX A6000:专业卡级别的稳定性,48GB GDDR6 显存支持 8 层 8K H.265 素材实时预览 + 8K HDR 导出,兼容 Adobe Mercury Engine 与 Avid Media Composer 加速协议,适合电视台、影视工作室。

若需多卡协同:可组建 2 张 RTX A6000(NVLink 桥接),显存叠加至 96GB,支持 16 轨 8K 剪辑,但需搭配 X299 或 TRX40 主板。

- 存储:2TB PCIe 5.0 NVMe(系统)+ 2×8TB U.2 SSD(素材阵列)

推荐:英特尔傲腾 P5800X(读取 7500MB/s,延迟 10μs)+ 希捷 Exos 2X14(企业级 U.2 接口,容错率高),通过 RAID 0 阵列将读写速度提升至 15000MB/s 以上。

- 内存:128GB DDR5 6400MHz(四通道)

搭配 Intel i9-14900X 或 AMD Ryzen 9 7950X3D CPU,四通道内存带宽达 100GB/s,确保显存与内存的数据交换无瓶颈。

(二)软件与流程优化:让大显存 “物尽其用”

- 剪辑软件设置技巧

DaVinci Resolve:在 “项目设置 - 内存和缓存” 中,将 “GPU 显存限制” 设为 “最大可用显存的 90%”(如 24GB 显存设为 21.6GB),同时开启 “优化媒体”,将 8K 素材转为 1080P 代理文件(剪辑时用代理,导出时自动关联原素材),显存占用降低 60%。

Premiere Pro:在 “编辑 - 首选项 - 媒体缓存” 中,勾选 “使用 GPU 加速渲染” 和 “硬件加速编码”,并在时间线设置中选择 “Mercury Playback Engine GPU 加速(CUDA)”,避免使用 “仅软件” 模式。 - 特效与导出优化

避免 “嵌套轨道过多”:每增加 1 层嵌套轨道,显存占用增加 15%-20%,建议将复杂特效预渲染为单独片段(Ctrl+M 导出为 ProRes 4444 格式),再导入时间线。

8K 导出编码选择:优先用 H.265(HEVC)编码,在 Premiere Pro 中选择 “Match Source - High Bitrate”,比特率设为 80-100Mbps,同时勾选 “使用硬件加速”,24GB 显存可实现 8K 60fps 视频 1:1.2 实时导出(即 1 小时视频 1.2 小时导出完成)。 - 实战案例:8K 纪录片《自然之美》剪辑配置

场景需求:6 层 8K H.265 素材(每段 30 分钟)+ 动态字幕 + 无人机航拍防抖 + LUT 调色 + 粒子特效。

硬件配置:RTX A6000 48GB + i9-14900X + 128GB DDR5 + 2×8TB U.2 SSD(RAID 0)。

优化效果:时间线实时预览无卡顿(60fps),添加 5 层特效后显存占用稳定在 32GB,导出 1 小时 8K HDR 视频仅需 55 分钟(对比 16GB 显存配置的 2 小时 40 分钟)。

三、AI 训练大显存硬件实战:从单卡训练到分布式部署

(一)核心硬件选型:“显存容量 + 算力精度 + 扩展性” 三重考量

AI 训练的硬件配置需根据模型规模与训练目标(速度 / 精度 / 成本)灵活调整,以下为三类典型场景方案:

1. 个人 / 实验室入门(模型参数量<10 亿,预算 3-5 万元)

- GPU:NVIDIA RTX 4090 24GB或RTX 3090 Ti 24GB

优势:24GB GDDR6X 显存支持 FP16 精度训练 Stable Diffusion、ViT-B 等模型,CUDA 核心数达 16384(RTX 4090),单卡训练 Stable Diffusion 微调任务(Batch Size=8)耗时约 4 小时。

局限:无法承载 7B 以上参数 LLM 训练,需通过 “模型量化”(如 INT8)或 “梯度累积”(Gradient Accumulation)变相提升 Batch Size。

- CPU:AMD Ryzen 9 7950X3D(16 核 32 线程)

大缓存(128MB L3)可加速数据预处理,避免 CPU 成为数据加载瓶颈。

- 内存:64GB DDR5 6000MHz(双通道)

满足数据加载与模型临时参数存储,若启用 “CPU Offloading”(将部分模型参数放入内存),建议升级至 128GB。

2. 企业级单机(模型参数量 10-100 亿,预算 15-30 万元)

- GPU:NVIDIA A100 40GB/80GB或H100 80GB

A100 80GB:采用 HBM2e 显存(带宽 1935GB/s),支持 FP16/BF16 混合精度训练,80GB 显存可单卡训练 LLaMA 2 7B(FP16,Batch Size=16),训练速度比 RTX 4090 快 3 倍。

H100 80GB:新一代 Hopper 架构,支持 FP8 精度(每参数 1 字节),80GB 显存可训练 LLaMA 2 13B(FP8,Batch Size=24),相比 A100 能耗降低 50%。

- 主板与电源:NVIDIA DGX Station A100(集成 4 张 A100 40GB)或华硕 Pro WS WRX80E-SAGE SE WIFI(支持 2 张 H100)

需搭配 1600W 以上服务器级电源(如海盗船 AX1600i),确保多卡供电稳定。

- 存储:4TB PCIe 4.0 NVMe(系统)+ 16TB HDD(数据集)

推荐:三星 PM9A3(企业级 NVMe,耐用性达 3000TBW)+ 西部数据 Ultrastar DC HC550(企业级 HDD,适合存储 TB 级数据集)。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)