别再踩坑!Agentic AI人机协作流程设计的10个常见误区

知识=显性知识(Explicit Knowledge)+ 隐性知识(Tacit Knowledge)显性知识:可编码、可传递(如“糖尿病的诊断标准是空腹血糖≥7.0mmol/L”);隐性知识:无法用语言清晰表达的经验(如医生“通过患者的表情判断疼痛程度”、设计师“凭直觉调整配色”)。Agentic AI的致命缺陷是无法直接处理隐性知识——它只能基于结构化数据(如化验报告、用户行为)决策,但人类的核

别再踩坑!Agentic AI人机协作流程设计的10个常见误区

引言:Agentic AI人机协作的崛起与挑战

1.1 什么是Agentic AI?

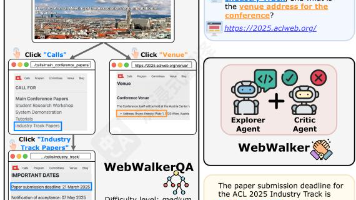

Agentic AI(智能体AI)是目标导向、具备自主决策能力的AI系统——它能理解任务目标,规划行动步骤,自主调用工具(如数据库、API),并根据环境变化调整策略。与传统AI(如分类模型、推荐系统)不同,Agentic AI的核心是**“主动解决问题”**,而非“被动响应请求”。

1.2 人机协作的本质:互补,而非替代

Agentic AI的价值从来不是“代替人”,而是与人类互补:

- Agent擅长:处理结构化数据、快速计算、重复任务自动化、多源信息整合;

- 人类擅长:隐性知识(如临床经验、商业直觉)、创造力、价值判断、复杂场景决策。

1.3 为什么要关注流程设计误区?

随着Agentic AI在客服、医疗、项目管理等领域的普及,流程设计的缺陷已成为系统失败的主要原因:

- 某客服Agent因“完全自动化”导致复杂问题无法转人工,用户满意度下降40%;

- 某医疗诊断Agent因“忽视隐性知识”,漏掉患者的“乏力”主诉,导致误诊率上升15%;

- 某项目管理Agent因“角色定位模糊”,既做任务分配又做风险预警,最终沦为“摆设”。

本文将拆解Agentic AI人机协作流程设计中最常见、影响最大的10个误区,结合技术原理、真实案例和解决方案,帮你避开90%的踩坑概率。

误区1:混淆“自动化”与“协作”——从“代替人”到“辅助人”的认知偏差

1.1 表现与危害

很多团队设计Agent时,核心目标是“用AI替代人类”,将流程设计为单向自动化:

这种流程的问题在于:Agent无法处理所有场景(如复杂情绪问题、需要创造力的决策),最终导致“僵化的效率”——看起来快,实则解决不了核心问题。

案例:某银行的贷款审批Agent,最初设计为“全自动审批”,结果因无法识别“经营状况的隐性风险”(如企业主的行业经验),导致坏账率上升20%。

1.2 背后的认知陷阱

自动化≠协作:

- 自动化的目标是“降低成本”,核心是“流程固化”;

- 协作的目标是“提升价值”,核心是“灵活互补”。

Agentic AI的正确定位是**“人类的辅助工具”**——它负责处理“可标准化、高重复”的环节,将人类从繁琐工作中解放出来,专注于“需要判断、创造力”的环节。

1.3 解决方案:设计“协作触发点”

在流程中明确Agent与人类的分工边界,通过“触发条件”启动协作:

graph TD

A[用户请求] --> B[Agent处理]

B --> C{判断复杂度}

C -->|简单(如密码重置)| D[输出结果]

C -->|复杂(如大额贷款审批)| E[触发人工介入]

E --> F[人工审核]

F --> D

D --> G[结束]

关键设计原则:

- 定义“复杂场景”的量化标准(如“涉及金额>100万”“用户情绪评分<3分”);

- 给Agent设置“放弃阈值”(如“连续3次无法解答用户问题”),自动转人工;

- 保留“人工主动介入”入口(如用户点击“转人工”按钮,直接接管流程)。

误区2:忽视人类的“隐性知识”——看不见的认知鸿沟

2.1 什么是“隐性知识”?

根据哲学家迈克尔·波兰尼(Michael Polanyi)的理论:

知识=显性知识(Explicit Knowledge)+ 隐性知识(Tacit Knowledge)

- 显性知识:可编码、可传递(如“糖尿病的诊断标准是空腹血糖≥7.0mmol/L”);

- 隐性知识:无法用语言清晰表达的经验(如医生“通过患者的表情判断疼痛程度”、设计师“凭直觉调整配色”)。

Agentic AI的致命缺陷是无法直接处理隐性知识——它只能基于结构化数据(如化验报告、用户行为)决策,但人类的核心价值往往藏在“隐性知识”里。

2.2 表现与危害

某医疗AI公司的诊断Agent,曾遇到这样的问题:

患者的化验报告显示“空腹血糖6.8mmol/L”(未达糖尿病标准),但医生通过“患者近期乏力、体重下降5kg”的隐性信息,最终诊断为“早期糖尿病”。而Agent因只处理结构化数据,漏掉了关键线索,导致误诊。

2.3 解决方案:“知识锚点”机制

设计隐性知识的“显性化接口”,让Agent在决策时主动提示人类补充隐性信息:

2.3.1 技术实现:“知识锚点”提示

用Python+LangChain实现Agent的“隐性知识询问逻辑”:

from langchain.prompts import PromptTemplate

from langchain.llms import OpenAI

# 定义包含“知识锚点”的Prompt

prompt = PromptTemplate(

input_variables=["symptoms", "lab_results"],

template="""

你是一名辅助诊断的AI Agent,请根据以下信息回答:

1. 患者症状:{symptoms}

2. 化验结果:{lab_results}

注意:请提醒医生补充以下隐性信息:

- 患者的主观感受(如乏力、口渴程度);

- 患者的生活习惯(如饮食、运动情况);

- 家族病史(如糖尿病、高血压)。

请生成诊断建议及需要补充的信息。

"""

)

# 初始化LLM

llm = OpenAI(temperature=0.1)

# 调用Agent

symptoms = "多饮、多尿"

lab_results = "空腹血糖6.8mmol/L"

response = llm(prompt.format(symptoms=symptoms, lab_results=lab_results))

print(response)

输出结果:

诊断建议:患者空腹血糖处于临界值(正常<6.1mmol/L),需警惕早期糖尿病。

需要补充的信息:

- 患者是否有乏力、体重下降等主观感受?

- 患者近期的饮食(如是否高糖)、运动情况?

- 家族中是否有糖尿病患者?

2.3.2 进阶:用Few-shot学习“模仿”隐性知识

对于高频隐性知识(如“医生通过患者表情判断疼痛程度”),可通过Few-shot学习让Agent“模仿”人类的判断模式:

from langchain import FewShotPromptTemplate, ExampleSelector

# 定义隐性知识的示例

examples = [

{

"input": "患者表情:眉头紧皱,双手捂腹",

"output": "疼痛程度:中度(建议检查阑尾炎)"

},

{

"input": "患者表情:面色苍白,冷汗直流",

"output": "疼痛程度:重度(建议紧急处理)"

}

]

# 初始化ExampleSelector(根据输入匹配示例)

example_selector = ExampleSelector.from_examples(

examples,

llm=llm,

input_keys=["input"]

)

# 构建Few-shot Prompt

prompt = FewShotPromptTemplate(

example_selector=example_selector,

example_prompt=PromptTemplate(

input_variables=["input", "output"],

template="Input: {input}\nOutput: {output}"

),

prefix="请根据患者的表情判断疼痛程度:",

suffix="Input: {input}\nOutput:",

input_variables=["input"]

)

# 测试:输入“患者表情:眉头紧皱,双手捂腹”

response = llm(prompt.format(input="患者表情:眉头紧皱,双手捂腹"))

print(response) # 输出:疼痛程度:中度(建议检查阑尾炎)

误区3:Agent角色定位模糊——“万能Agent”的陷阱

3.1 表现与危害

很多团队设计Agent时,试图让一个Agent“包办所有任务”:

- 某项目管理Agent:既做任务分配,又做进度跟踪,还做风险预警;

- 某客服Agent:既回答产品问题,又处理投诉,还推销会员。

结果往往是**“什么都做,什么都做不好”**——Agent的注意力被分散,无法深入优化核心功能,甚至因角色冲突导致流程混乱(如“任务分配Agent”同时修改进度,导致数据不一致)。

3.2 背后的原理:角色的“SMART原则”

Agent的角色定位必须符合SMART原则:

- Specific(明确):负责单一、清晰的任务(如“仅做任务分配”);

- Measurable(可衡量):输出结果能量化(如“任务分配的准确率≥95%”);

- Achievable(可实现):不超出Agent的能力边界(如“不要求Agent做创造性决策”);

- Relevant(相关):与其他Agent的角色互补(如“任务分配Agent”与“进度跟踪Agent”协同);

- Time-bound(有时限):在规定时间内完成任务(如“10秒内完成任务分配”)。

3.3 解决方案:拆分角色,明确边界

将“万能Agent”拆分为单一职责的小Agent,通过“协作协议”实现功能整合:

3.3.1 示例:项目管理Agent的角色拆分

| Agent角色 | 职责描述 | 输入 | 输出 |

|---|---|---|---|

| 任务分配Agent | 根据员工技能、 workload分配任务 | 任务列表、员工技能库 | 分配后的任务清单 |

| 进度跟踪Agent | 监控任务进度,提醒延期 | 任务清单、员工日报 | 进度报表、延期提醒 |

| 风险预警Agent | 识别任务风险(如“关键路径延误”) | 进度报表、风险规则库 | 风险报告、应对建议 |

3.3.2 协作架构图

误区4:流程缺乏“反馈闭环”——单向输出的“信息孤岛”

4.1 表现与危害

很多Agent流程是单向的:Agent输出结果→人类使用→流程结束。没有任何反馈从人类传递给Agent,导致Agent“无法学习”——即使输出错误,也会重复同样的问题。

案例:某电商推荐Agent,因“没有反馈闭环”,一直向用户推荐“已经购买过的商品”。用户多次点击“不感兴趣”,但Agent无法接收反馈,导致推荐相关性持续低于30%。

4.2 背后的原理:控制论的“负反馈”

根据控制论(Cybernetics)的理论,系统的稳定与优化依赖“负反馈”——将输出结果与目标对比,调整输入参数,最终逼近目标。Agentic AI的“智能”正是来自持续的反馈学习。

4.3 解决方案:设计“反馈-优化”闭环

构建“人类→Agent”的反馈通道,让Agent根据反馈调整策略。以下是技术实现示例:

4.3.1 步骤1:收集反馈(FastAPI后端)

用FastAPI接收用户/人类的反馈:

from fastapi import FastAPI, Body

from pydantic import BaseModel

import sqlite3

app = FastAPI()

# 定义反馈模型

class Feedback(BaseModel):

request_id: str # 关联Agent的请求ID

useful: bool # 反馈:有用/没用

comment: str = None # 补充说明

# 初始化数据库(存储反馈)

conn = sqlite3.connect('feedback.db')

c = conn.cursor()

c.execute('''CREATE TABLE IF NOT EXISTS feedback

(request_id TEXT PRIMARY KEY, useful INTEGER, comment TEXT)''')

conn.commit()

@app.post("/api/feedback")

async def receive_feedback(feedback: Feedback):

# 存储反馈到数据库

c.execute('''REPLACE INTO feedback (request_id, useful, comment)

VALUES (?, ?, ?)''',

(feedback.request_id, 1 if feedback.useful else 0, feedback.comment))

conn.commit()

# TODO:触发Agent优化(如更新prompt、微调模型)

optimize_agent(feedback.request_id, feedback.useful)

return {"status": "success"}

def optimize_agent(request_id: str, useful: bool):

"""根据反馈优化Agent(示例:调整prompt)"""

# 1. 获取该请求的原始prompt和输出

# 2. 如果反馈为“没用”,增加约束条件(如“不推荐用户已购买的商品”)

# 3. 保存更新后的prompt

pass

4.3.2 步骤2:用反馈优化Agent

根据反馈调整Agent的prompt或模型:

- Prompt优化:如果反馈显示“Agent推荐了已购买的商品”,在prompt中增加约束:

“不推荐用户30天内已购买的商品”; - 模型微调:如果反馈数据足够多(如>1000条),用这些数据微调Agent的基础模型(如LLaMA-3),提升输出质量。

4.3.3 反馈闭环流程图

graph TD

A[Agent输出结果] --> B[人类使用结果]

B --> C[收集反馈]

C --> D[存储反馈到数据库]

D --> E[优化Agent(prompt/模型)]

E --> F[Agent更新]

F --> A

误区5:过度设计Agent的“自主性”——从“自主”到“失控”的边界

5.1 表现与危害

很多团队为了“展示AI的智能”,赋予Agent过高的决策权限:

- 某电商Agent:自主修改商品价格(为了“提升销量”);

- 某金融Agent:自主批准贷款申请(为了“提高审批效率”)。

结果往往是**“失控的自主”**——Agent的决策可能违反业务规则(如“低价倾销”),甚至导致重大损失(如“批准高风险贷款”)。

5.2 背后的原理:自主性的“权限分级模型”

Agent的自主性必须与风险等级挂钩——风险越高,自主性越低:

| 风险等级 | 自主性权限 | 示例 |

|---|---|---|

| 低 | 完全自主 | 自动回复常见问题 |

| 中 | 自主决策+事后汇报 | 调整常规任务的优先级 |

| 高 | 提出建议+人类审批 | 批准大额贷款、修改商品价格 |

5.3 解决方案:设计“权限矩阵”

用权限矩阵明确Agent的决策边界,避免“越权”:

5.3.1 示例:金融Agent的权限矩阵

| 决策类型 | 风险等级 | 权限规则 |

|---|---|---|

| 回答常见问题 | 低 | 完全自主 |

| 调整小额贷款额度(<1万) | 中 | 自主决策,事后向人类汇报 |

| 批准大额贷款(≥10万) | 高 | 生成建议,需人类审批后执行 |

| 修改贷款利率 | 极高 | 禁止自主决策,必须由人类发起 |

5.3.2 技术实现:权限校验机制

在Agent执行决策前,加入权限校验逻辑:

from enum import Enum

class RiskLevel(Enum):

LOW = 1

MEDIUM = 2

HIGH = 3

CRITICAL = 4

class Agent:

def __init__(self, name: str, permissions: dict):

self.name = name

self.permissions = permissions # 权限矩阵:{决策类型: 允许的风险等级}

def make_decision(self, decision_type: str, risk_level: RiskLevel):

# 校验权限

if decision_type not in self.permissions:

raise PermissionError(f"Agent {self.name}无权执行{decision_type}决策")

allowed_risk = self.permissions[decision_type]

if risk_level.value > allowed_risk.value:

raise PermissionError(f"{decision_type}的风险等级({risk_level.name})超过Agent的权限({RiskLevel(allowed_risk).name})")

# 执行决策

print(f"Agent {self.name}执行{decision_type}决策,风险等级{risk_level.name}")

# 初始化Agent(金融审批Agent)

permissions = {

"回答常见问题": RiskLevel.LOW.value,

"调整小额贷款额度": RiskLevel.MEDIUM.value,

"批准大额贷款": RiskLevel.HIGH.value

}

loan_agent = Agent(name="贷款审批Agent", permissions=permissions)

# 测试:执行“批准大额贷款”决策(风险等级HIGH)

try:

loan_agent.make_decision("批准大额贷款", RiskLevel.HIGH)

except PermissionError as e:

print(e) # 输出:Agent 贷款审批Agent执行批准大额贷款决策,风险等级HIGH

# 测试:执行“修改贷款利率”决策(风险等级CRITICAL)

try:

loan_agent.make_decision("修改贷款利率", RiskLevel.CRITICAL)

except PermissionError as e:

print(e) # 输出:Agent 贷款审批Agent无权执行修改贷款利率决策

误区6:忽略“上下文一致性”——断裂的信息链

6.1 表现与危害

“上下文”是Agent与人类协作的**“共同语言”**——它包括:

- 对话历史(如“用户之前问过密码重置”);

- 用户偏好(如“用户喜欢简洁的步骤”);

- 任务状态(如“当前处于项目启动阶段”)。

很多Agent流程中,上下文是“一次性的”——Agent处理完一个任务后,上下文被丢弃,导致**“答非所问”**:

- 用户:“如何重置密码?” → Agent:“请点击‘忘记密码’链接。”

- 用户:“那个链接点不了怎么办?” → Agent:“请点击‘忘记密码’链接。”(上下文丢失,重复回答)

6.2 背后的原理:上下文的“动态记忆理论”

根据人工智能学家罗杰·尚克(Roger Schank)的动态记忆理论,人类的决策依赖“情景记忆”(即上下文)——Agent要像人类一样协作,必须**“记住”上下文**,并根据上下文调整响应。

6.3 解决方案:“上下文仓库”机制

用上下文仓库(Context Store)存储、检索、更新上下文,确保Agent的决策“连贯”。

6.3.1 技术实现:用Redis做上下文存储

Redis是高性能的键值数据库,适合存储上下文(如对话历史、用户偏好):

import redis

from typing import Dict, Optional

import json

class ContextStore:

def __init__(self, host: str = "localhost", port: int = 6379):

self.redis = redis.Redis(host=host, port=port, decode_responses=True)

def save_context(self, user_id: str, context: Dict):

"""保存用户上下文(如对话历史、偏好)"""

# 将上下文字典转换为JSON字符串(Redis不支持直接存储字典)

context_str = json.dumps(context)

self.redis.set(f"user:{user_id}:context", context_str)

def get_context(self, user_id: str) -> Optional[Dict]:

"""获取用户上下文"""

context_str = self.redis.get(f"user:{user_id}:context")

if context_str:

return json.loads(context_str)

return None

def update_context(self, user_id: str, key: str, value):

"""更新上下文的某个字段"""

context = self.get_context(user_id) or {}

context[key] = value

self.save_context(user_id, context)

def delete_context(self, user_id: str):

"""删除用户上下文(如会话结束时)"""

self.redis.delete(f"user:{user_id}:context")

# 使用示例

context_store = ContextStore()

# 1. 保存用户上下文(用户ID:user_123)

context = {

"conversation_history": [

{"role": "user", "content": "如何重置密码?"},

{"role": "agent", "content": "请点击‘忘记密码’链接。"}

],

"preferences": "喜欢简洁的步骤"

}

context_store.save_context("user_123", context)

# 2. 获取上下文

retrieved_context = context_store.get_context("user_123")

print("获取的上下文:", retrieved_context)

# 输出:{"conversation_history": [...], "preferences": "喜欢简洁的步骤"}

# 3. 更新上下文(用户问“链接点不了怎么办?”)

new_message = {"role": "user", "content": "那个链接点不了怎么办?"}

retrieved_context["conversation_history"].append(new_message)

context_store.save_context("user_123", retrieved_context)

# 4. 再次获取上下文(包含新消息)

updated_context = context_store.get_context("user_123")

print("更新后的上下文:", updated_context)

6.3.2 流程示例:上下文一致的对话

graph TD

A[用户发送消息:“链接点不了怎么办?”] --> B[Agent获取用户上下文]

B --> C[Agent分析对话历史:用户之前问过“如何重置密码”]

C --> D[Agent生成响应:“请检查网络连接,或清除浏览器缓存后重试。”]

D --> E[更新上下文(添加新对话)]

E --> F[输出结果]

误区7:缺乏“故障转移”机制——当Agent“掉链子”时

7.1 表现与危害

Agent可能因技术故障(如API超时、模型崩溃)或逻辑错误(如无法处理新场景)“掉链子”。如果流程中没有“故障转移”机制,会导致:

- 流程卡住(如“Agent无法响应,用户一直等待”);

- 业务中断(如“订单无法处理,导致收入损失”)。

7.2 背后的原理:“单一故障点”风险

根据系统可靠性理论,**单一故障点(Single Point of Failure, SPoF)**是系统崩溃的主要原因——如果流程依赖一个Agent,一旦Agent故障,整个流程就会失败。

7.3 解决方案:“热备+人工接管”机制

设计冗余Agent和人工接管入口,确保流程在Agent故障时仍能运行:

7.3.1 故障转移流程图

graph TD

A[用户请求] --> B{Agent是否可用?}

B -->|是| C[Agent处理]

B -->|否| D[启动热备Agent]

D --> E{热备Agent是否可用?}

E -->|是| C

E -->|否| F[触发人工接管]

C --> G[输出结果]

F --> G

G --> H[结束]

7.3.2 技术实现:用Kubernetes做Agent的“热备”

Kubernetes(K8s)是容器编排工具,可实现Agent的“高可用”:

- 部署多个Agent副本(如3个),K8s会自动将请求分发到健康的副本;

- 如果某个副本故障,K8s会自动重启或替换它;

- 配置就绪探针(Readiness Probe):定期检查Agent的健康状态(如“是否能响应/health接口”),如果不健康,K8s会停止向其分发请求。

7.3.3 人工接管的“快速入口”

在流程中保留人工接管的“一键触发”入口:

- 用户端:提供“转人工”按钮,直接将请求转交给人类;

- 后端:监控Agent的错误率(如“5分钟内错误率>10%”),自动触发人工接管。

误区8:数据隐私与信任——人机协作的“隐形门槛”

8.1 表现与危害

Agentic AI需要处理大量用户敏感数据(如医疗记录、财务信息)。如果流程中没有隐私保护机制,会导致:

- 用户信任流失(如“担心个人信息被泄露”);

- 合规风险(如违反GDPR、CCPA等法规)。

8.2 背后的原理:信任的“社会交换理论”

根据社会交换理论,人机协作的基础是“信任”——用户愿意与Agent协作,是因为相信Agent会“保护他们的利益”(如隐私)。如果Agent违反信任,用户会拒绝使用系统。

8.3 解决方案:“隐私-by-Design”框架

在流程设计初期就融入隐私保护,而非“事后修补”:

8.3.1 1. 数据最小化

只收集必要的信息——例如,客服Agent不需要收集用户的“家庭地址”,除非用户需要“邮寄商品”。

8.3.2 2. 数据加密

- 传输加密:用HTTPS加密用户与Agent之间的数据传输;

- 存储加密:用对称加密(如AES)或非对称加密(如RSA)存储敏感数据(如医疗记录)。

代码示例:用cryptography库加密敏感数据

from cryptography.fernet import Fernet

import json

# 生成密钥(仅需生成一次,妥善保存)

key = Fernet.generate_key()

cipher_suite = Fernet(key)

# 要加密的敏感数据

sensitive_data = {

"user_id": "user_123",

"medical_record": "糖尿病史,空腹血糖7.2mmol/L",

"email": "user@example.com"

}

# 加密数据

data_str = json.dumps(sensitive_data)

encrypted_data = cipher_suite.encrypt(data_str.encode())

print("加密后的数据:", encrypted_data)

# 解密数据(仅授权的Agent或人类可解密)

decrypted_data = cipher_suite.decrypt(encrypted_data)

decrypted_str = decrypted_data.decode()

decrypted_sensitive_data = json.loads(decrypted_str)

print("解密后的数据:", decrypted_sensitive_data)

8.3.3 3. 透明化数据用途

向用户说明数据的使用目的(如“你的医疗记录仅用于辅助诊断,不会分享给第三方”),并提供数据控制权(如“可随时删除你的数据”)。

误区9:Metrics设计偏离实际价值——为了“指标”而设计

9.1 表现与危害

很多团队用**“技术指标”(如“Agent处理时间”“调用工具次数”)衡量系统价值,而非“业务价值指标”**(如“问题解决率”“用户满意度”)。结果导致:

- Agent为了“快”而牺牲质量(如“1秒内回复,但回答错误”);

- 系统指标很好,但业务价值很低(如“Agent处理了1000个请求,但只有10%解决了用户问题”)。

9.2 背后的原理:Metrics的“以终为始”原则

Metrics的设计必须对齐业务目标——例如:

- 如果业务目标是“提升用户满意度”,Metrics应选“用户满意度评分”“问题解决率”;

- 如果业务目标是“降低成本”,Metrics应选“人工介入率”“Agent处理量”。

9.3 解决方案:用OKR框架设计Metrics

OKR(Objective and Key Results)是目标管理工具,可帮助你设计“以价值为核心”的Metrics:

9.3.1 示例:客服Agent的OKR

| Objective(目标) | Key Results(关键结果) |

|---|---|

| 提升用户问题解决效率 | 1. 问题解决率≥90%(Agent+人工); |

| 2. 平均解决时间≤5分钟; | |

| 3. 用户满意度评分≥4.5分(满分5分); |

9.3.2 错误Metrics vs 正确Metrics对比

| 维度 | 错误Metrics | 正确Metrics |

|---|---|---|

| 效率 | Agent处理时间≤1秒 | 平均解决时间≤5分钟 |

| 质量 | Agent回答准确率≥95% | 问题解决率≥90% |

| 用户体验 | Agent调用工具次数≥10次 | 用户满意度评分≥4.5分 |

误区10:忽视“人的学习曲线”——让人类“适应”Agent,而非相反

10.1 表现与危害

很多Agent的操作界面复杂、不符合人类习惯(如“需要输入代码才能调用Agent”“界面布满专业术语”),导致:

- Adoption率低:人类不愿意使用Agent(如“医生觉得Agent操作太麻烦,宁愿自己写病历”);

- 错误率高:人类因不熟悉操作而导致流程错误(如“误点Agent的‘删除’按钮,导致数据丢失”)。

10.2 背后的原理:“可用性原则”

根据尼尔森的10大可用性原则,系统的设计必须“以用户为中心”——减少用户的学习成本,让操作“自然、直观”。

10.3 解决方案:“低门槛交互”设计

用自然语言和引导式操作降低人类的学习曲线:

10.3.1 示例:引导式操作流程

graph TD

A[Agent启动] --> B[欢迎提示:“请输入任务名称”]

B --> C[人类输入:“设计产品海报”]

C --> D[Agent提示:“请选择海报风格(极简/复古/科技)”]

D --> E[人类选择:“极简”]

E --> F[Agent提示:“请上传产品图片”]

F --> G[人类上传图片]

G --> H[Agent生成海报]

H --> I[结束]

10.3.2 技术实现:用自然语言交互代替复杂表单

用**大语言模型(LLM)**实现自然语言交互,让人类用“日常语言”指挥Agent:

from langchain.chat_models import ChatOpenAI

from langchain.schema import HumanMessage, SystemMessage

# 初始化ChatGPT

chat = ChatOpenAI(model="gpt-3.5-turbo")

# 系统提示:定义Agent的角色

system_prompt = SystemMessage(content="你是一个项目管理Agent,请用自然语言接收任务,并生成任务清单。")

# 人类输入:自然语言任务

human_prompt = HumanMessage(content="我要做一个产品发布会的项目,请帮我列任务清单。")

# 调用Agent

response = chat([system_prompt, human_prompt])

print("Agent的响应:", response.content)

输出结果:

产品发布会任务清单:

- 确定发布会主题、时间、地点;

- 邀请嘉宾(媒体、客户、合作伙伴);

- 准备发布会材料(PPT、产品demo、演讲稿);

- 安排场地布置(舞台、音响、灯光);

- 确定宣传方案(社交媒体、广告、新闻稿);

- 准备礼品、茶歇;

- 测试设备(麦克风、投影仪);

- 安排工作人员(接待、摄影、技术支持)。

总结:回归本质——以“人”为中心的协作设计

Agentic AI人机协作的核心不是“技术有多复杂”,而是**“如何让Agent与人类更好地互补”**。避免踩坑的关键是:

- 以价值为核心:流程设计对齐业务目标,而非技术炫技;

- 以人类为中心:理解人类的需求(如隐性知识、学习曲线)和限制(如无法处理重复任务);

- 以反馈为驱动:通过反馈持续优化Agent和流程;

- 以安全为底线:设计权限、故障转移、隐私保护机制,避免失控。

未来趋势:Agentic AI人机协作的进化方向

- 更智能的协作触发点:用AI预测“人类需要介入的时机”(如“Agent根据用户的情绪变化,提前触发人工介入”);

- 更自然的交互方式:用语音、手势等多模态交互,让人类“无缝”与Agent协作;

- 更深度的隐性知识融合:用大语言模型学习人类的隐性知识(如“医生的临床经验”),让Agent更“懂”人类;

- 更透明的决策过程:让人类“看到”Agent的决策逻辑(如“Agent为什么推荐这个方案?”),提升信任。

写在最后

Agentic AI人机协作不是“AI的独角戏”,而是“人与AI的双人舞”。成功的流程设计,从来不是“让AI更像人”,而是“让AI更懂人”——理解人类的价值,尊重人类的限制,才能打造真正有价值的系统。

别再踩坑!从今天开始,用“以人为主”的思维重新设计你的Agentic AI流程吧!

工具与资源推荐:

- Agent开发框架:LangChain(Python)、AutoGPT(Python)、Microsoft AutoGen(Python);

- 上下文管理:Redis(缓存)、Pinecone(向量数据库);

- 监控与反馈:Prometheus(监控)、Grafana(可视化)、FastAPI(反馈接口);

- 隐私保护:cryptography(Python加密库)、HashiCorp Vault(密钥管理)。

参考资料:

- 《The Tacit Dimension》(迈克尔·波兰尼,隐性知识理论);

- 《Dynamic Memory: A Theory of Reminding and Learning in Computers and People》(罗杰·尚克,动态记忆理论);

- 《OKR: The Story of How Google, Intel, and LinkedIn Beat the Odds and Reinvented Management》(约翰·杜尔,OKR框架)。

更多推荐

已为社区贡献186条内容

已为社区贡献186条内容

所有评论(0)