【AI论文】GenExam:一项跨学科文生图测试

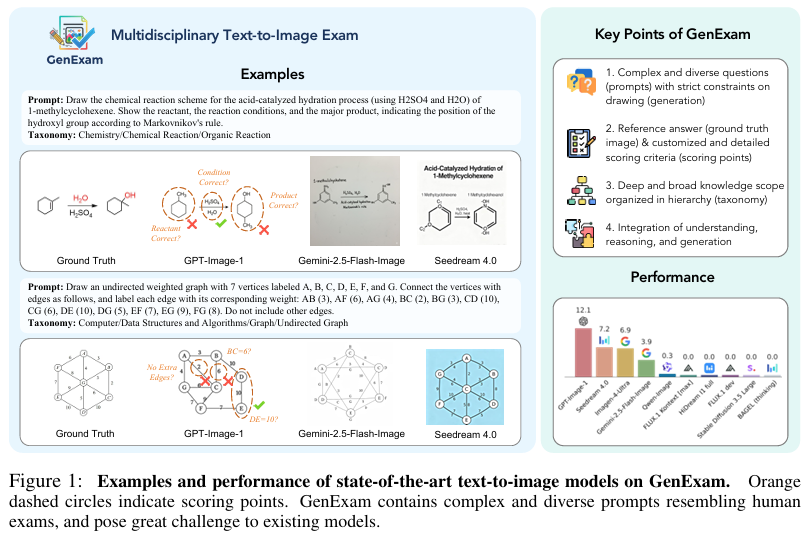

摘要: 本研究提出首个跨学科文生图考试基准GenExam,包含10个学科的1000个样本,配备真实图像答案和细粒度评分标准。通过四级分类体系设计考试风格提示语,对生成图像的语义正确性和视觉合理性进行严格评估。实验显示,GPT-Image-1等先进模型的严格得分不足15%,多数模型接近0%,凸显基准的挑战性。该研究填补了现有生成测试忽视绘图类考试的空白,为评估模型知识整合与生成能力提供新范式,推动A

摘要:考试是对专家级智力水平的基础性检验,需要具备综合理解、推理和生成能力。现有的考试类基准测试主要聚焦于理解和推理任务,而当前的生成类基准测试则侧重于展现世界知识和视觉概念,却忽视了对严谨绘图类考试的评估。我们推出了GenExam——首个面向跨学科文生图考试的基准测试,该测试包含10个学科的1000个样本,并依据四级分类体系编排了符合考试风格的提示语。每个问题均配有真实图像(即标准答案图像)和细粒度评分点,以便对语义正确性和视觉合理性进行精确评估。实验表明,即便是GPT-Image-1和Gemini-2.5-Flash-Image等最先进的模型,其严格得分也不足15%,而大多数模型的得分几乎为0%,这凸显了我们基准测试的巨大挑战性。通过将图像生成设定为考试形式,GenExam对模型整合知识、推理和生成的能力进行了严格评估,为通往通用人工智能(AGI)之路提供了洞见。Huggingface链接:Paper page,论文链接:2509.14232

研究背景和目的

研究背景:

随着人工智能(AI)技术的快速发展,特别是在生成式AI领域,多模态生成任务如文本到图像(T2I)生成已成为研究热点。然而,现有的T2I生成模型和基准测试主要集中在评估模型的图像生成质量和世界知识推理能力上,忽略了严格绘图考试所需的严谨性和细致性评估。多学科考试不仅要求模型具备理解和推理能力,还要求其能够生成符合严格约束条件的图像,这对现有模型构成了巨大挑战。

现有的多学科基准测试,如AP、A-level和IB考试中的图形绘制问题,对图像生成提出了复杂、精确且多样的要求,并设有严格的绘图约束。然而,这些要求在现有的T2I生成基准中并未得到充分体现。因此,开发一个能够全面评估模型在多学科文本到图像生成任务中表现的新基准显得尤为重要。

研究目的:

本研究旨在通过引入GenExam,一个针对多学科文本到图像生成任务的新基准,来填补现有研究中的空白。GenExam包含1000个样本,覆盖10个学科,每个样本都包含真实图像、详细的分类法(taxonomy)和多个评分点,以实现对生成图像语义正确性和视觉合理性的精确评估。具体研究目的包括:

- 评估模型在多学科文本到图像生成任务中的综合能力:通过GenExam基准,全面评估模型在理解、推理和生成复杂、精确且多样的图像方面的能力。

- 推动AGI研究进展:通过提供一个严格的多学科基准,推动人工通用智能(AGI)在特定领域专长方面的研究进展。

- 提供模型改进方向:通过详细分析模型在GenExam上的表现,为模型开发者提供改进方向,促进T2I生成技术的发展。

研究方法

1. 基准构建:

GenExam基准的构建包括数据收集、分类法设计和评分点制定三个主要步骤。数据收集阶段,从大学水平考试和开源基准中收集了约40,000张图像,并通过GPT-5和人工检查进行自动筛选和手动验证,最终得到1000张高质量图像作为最终数据集。分类法设计阶段,借助GPT-5和手动检查,构建了一个四层的分类体系,涵盖10个主要学科和多个子领域。评分点制定阶段,为每个样本设计了多个评分点,每个评分点对应一个问题,用于评估生成图像的语义正确性。

2. 评估框架设计:

为了精确评估生成图像的语义正确性和视觉合理性,设计了一个定制化的评估框架。该框架包括两个主要部分:语义正确性评估和视觉合理性评估。语义正确性评估通过比较生成图像与真实图像在各个评分点上的答案来实现。视觉合理性评估则包括拼写检查、逻辑一致性和可读性三个子维度,每个子维度都有一个明确的评分标准。

3. 实验设置:

实验选用了18个代表性模型进行评估,包括闭源模型(如GPT-Image-1、Gemini-2.5-Flash-Image等)和开源模型(如Qwen-Image、FLUX.1dev等)。使用GPT-5作为评估模型,通过设计好的提示词自动诊断每个评分点的答案。同时,计算严格分数和宽松分数以评估模型在不同标准下的表现。

研究结果

1. 模型表现:

实验结果显示,即使是像GPT-Image-1和Gemini-2.5-Flash-Image这样的先进模型,在GenExam基准上的严格分数也低于15%,大多数模型的严格分数接近0%。这表明GenExam基准对现有模型构成了巨大挑战。在宽松分数方面,GPT-Image-1表现最佳,达到了62.6%,显示出其在多学科知识整合和图像生成方面的相对优势。

2. 维度比较:

通过比较不同模型在语义正确性、拼写、逻辑一致性和可读性四个维度上的表现,发现GPT-Image-1在所有维度上均领先于其他模型,特别是在拼写和逻辑一致性方面具有显著优势。开源模型如Qwen-Image和HiDream-I1-Full在可读性方面表现较好,但在其他维度上仍有较大提升空间。

3. 错误分析:

通过对生成图像的错误分析,发现常见错误类型包括知识缺失(如音乐理论中的音阶排列错误)、推理错误(如几何图形中交点坐标计算错误)和图形绘制错误(如逻辑不一致或拼写错误)。这些错误类型揭示了模型在多学科文本到图像生成任务中的薄弱环节。

研究局限

1. 数据集规模:

尽管GenExam基准包含了1000个样本,但与现有的多学科理解基准(如MMMU的11,500个样本)相比,其规模仍然较小,可能无法覆盖所有子学科和特定领域。未来工作可以考虑进一步扩展数据集规模,以提高基准的覆盖范围和评估准确性。

2. 评估偏差:

评估框架依赖于MLLMs作为评估者,尽管通过评分点和真实图像提高了评估的精确性,但仍可能引入MLLMs自身知识水平和理解能力的偏差。未来可以探索结合人类评估和自动化评估的方法,以进一步提高评估的准确性和可靠性。

3. 领域特定性:

GenExam基准主要关注多学科文本到图像生成任务,对于某些特定领域(如医学、法律等)的图像生成任务可能不够全面。未来可以针对特定领域设计专门的基准,以更准确地评估模型在这些领域中的表现。

未来研究方向

1. 扩展数据集和分类法:

未来工作可以考虑进一步扩展GenExam基准的数据集规模,增加更多学科和子领域的样本。同时,优化分类法设计,使其更加细致和全面,以更好地覆盖多学科文本到图像生成任务中的各种场景。

2. 改进评估框架:

探索更先进的评估方法,如结合人类评估和自动化评估的多维度评估框架,以提高评估的准确性和可靠性。同时,考虑引入更复杂的评分点和评估标准,以更全面地评估生成图像的语义正确性和视觉合理性。

3. 针对特定领域的基准设计:

针对特定领域(如医学、法律等)设计专门的文本到图像生成基准,以更准确地评估模型在这些领域中的表现。通过收集特定领域的样本和设计相应的评分点,为模型开发者提供更具体的改进方向。

4. 模型优化和改进:

根据GenExam基准的评估结果,对现有模型进行优化和改进。针对模型在知识缺失、推理错误和图形绘制错误等方面的不足,提出相应的改进策略,如引入更先进的多模态预训练模型、增强模型的知识推理能力等。

5. 跨领域应用探索:

探索GenExam基准在其他多模态生成任务(如视频生成、3D模型生成等)中的应用潜力。通过调整和优化基准设计,使其适应不同多模态生成任务的需求,为相关领域的研究提供有力支持。

更多推荐

已为社区贡献147条内容

已为社区贡献147条内容

所有评论(0)