深入分析Python的进阶部分---协程(新手建议收藏)

Python协程深度解析:从原理到实践 本文系统介绍了Python协程的核心技术与应用。协程作为用户态轻量级线程,通过非抢占式调度实现单线程并发,规避GIL限制。演进历程包括生成器、async/await语法和asyncio生态三个阶段。关键机制涉及事件循环调度和协程状态机,支持高并发I/O处理。文章对比了不同实现方式,详细解析了核心API与设计模式,并给出Web爬虫等实战案例。同时探讨了性能优化

以下是对Python协程的深度解析,涵盖其核心原理、实现方式、应用场景及最佳实践,结合技术细节与代码示例:

一、协程的本质与演进

1.1 协程定义

协程(Coroutine)是用户态的轻量级线程,由程序自主控制调度,通过协作式多任务处理实现并发。其核心特征包括:

-

状态保存:暂停时保存上下文(寄存器、栈帧),恢复时从断点继续执行。

-

非抢占式调度:任务主动让出控制权(通过

await),避免线程切换的操作系统介入。 -

单线程并发:在单线程内实现多任务交替执行,规避GIL限制。

1.2 演进历程

-

生成器时代(Python 2.5):通过

yield实现协程雏形,需手动调用send()切换。 -

async/await语法(Python 3.5+):引入原生协程支持,简化异步代码结构。

-

asyncio生态(Python 3.7+):提供事件循环、Task、Future等标准接口,完善异步I/O支持。

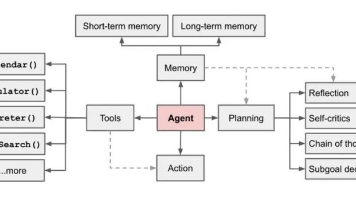

二、协程的核心机制

2.1 事件循环(Event Loop)

事件循环是协程的调度核心,工作流程如下:

-

任务队列管理:维护就绪队列(Ready Queue)和等待队列(Wait Queue)。

-

I/O多路复用:通过

epoll/kqueue监听文件描述符,触发事件回调。 -

协程状态切换:遇到

await时保存上下文,切换至其他就绪协程执行。

2.2 协程状态机

每个协程被编译为生成器对象,其状态转换如下:

-

Pending:未启动

-

Running:正在执行

-

Suspended:因

await暂停 -

Completed:执行完毕

# 示例:协程状态跟踪

import asyncio

async def demo():

print("Start")

await asyncio.sleep(1)

print("End")

coro = demo() # Pending

asyncio.run(coro) # 执行流程:Start → 暂停 → End三、协程实现方式对比

|

技术 |

实现原理 |

特点 |

适用场景 |

|---|---|---|---|

|

生成器 |

基于 |

低级控制,需显式 |

学习协程原理 |

|

Greenlet |

C扩展实现协程切换 |

手动 |

低级并发控制 |

|

Gevent |

基于Greenlet + Monkey Patching |

自动识别阻塞操作(如 |

异步网络编程 |

|

asyncio |

原生协程 + 事件循环 |

标准化API,支持 |

现代异步应用开发 |

四、协程核心API与模式

4.1 基础语法

import asyncio

async def fetch_data(url):

print(f"Fetching {url}")

await asyncio.sleep(1) # 模拟I/O阻塞

return f"Data from {url}"

async def main():

# 并发执行多个协程

tasks = [fetch_data(f"url_{i}") for i in range(5)]

results = await asyncio.gather(*tasks)

print(results)

asyncio.run(main()) # 输出:[Data from url_0, ..., Data from url_4]4.2 关键模式

-

生产者-消费者模型

async def producer(queue): for i in range(5): await queue.put(i) await asyncio.sleep(0.1) async def consumer(queue): while True: item = await queue.get() if item is None: break print(f"Consumed {item}") queue.task_done() async def main(): queue = asyncio.Queue() await asyncio.gather(producer(queue), consumer(queue)) -

超时控制

async def long_task(): await asyncio.sleep(10) async def main(): try: await asyncio.wait_for(long_task(), timeout=1.0) except asyncio.TimeoutError: print("Task timed out")

五、协程性能优化策略

5.1 减少上下文切换

-

批量处理:聚合多个I/O请求(如

aiohttp的ClientSession复用连接)。 -

限制并发量:使用

asyncio.Semaphore控制同时运行的协程数。

5.2 避免阻塞操作

-

异步替代同步库:如用

aiohttp代替requests,aiofiles代替open()。 -

线程池隔离阻塞:通过

loop.run_in_executor()执行CPU密集型任务。

async def cpu_intensive_task():

loop = asyncio.get_event_loop()

result = await loop.run_in_executor(None, heavy_computation)

return result六、协程调试与监控

6.1 调试技巧

-

启用调试模式:

asyncio.run(main(), debug=True) -

日志记录:使用

logging模块跟踪协程执行流。

6.2 性能分析

-

cProfile:定位耗时协程。

python -m cProfile -o profile.prof main.py -

asyncio自检:

import asyncio print(asyncio.all_tasks()) # 查看所有活跃任务

七、协程实战案例

7.1 高并发Web爬虫

import aiohttp

import asyncio

async def fetch(url):

async with aiohttp.ClientSession() as session:

async with session.get(url) as response:

return await response.text()

async def main():

urls = [f"https://example.com/page_{i}" for i in range(100)]

tasks = [fetch(url) for url in urls]

results = await asyncio.gather(*tasks)

print(f"Fetched {len(results)} pages")

asyncio.run(main())7.2 异步WebSocket服务器

from aiohttp import web

async def websocket_handler(request):

ws = web.WebSocketResponse()

await ws.prepare(request)

async for msg in ws:

if msg.type == web.WSMsgType.TEXT:

await ws.send_str(f"Echo: {msg.data}")

return ws

app = web.Application()

app.router.add_get('/ws', websocket_handler)

web.run_app(app)八、协程的局限与应对

8.1 单核限制

-

解决方案:结合多进程(

multiprocessing)实现分布式协程。from multiprocessing import Process import asyncio def run_async_task(): asyncio.run(async_main()) if __name__ == "__main__": processes = [Process(target=run_async_task) for _ in range(4)] for p in processes: p.start() for p in processes: p.join()

8.2 异常传播

-

问题:未捕获的异常会导致事件循环终止。

-

解决方案:全局异常处理器。

async def main(): try: await asyncio.gather(task1(), task2()) except Exception as e: print(f"Global error handler: {e}")

九、协程未来趋势

-

结构化并发:通过

TaskGroup(Python 3.11+)实现任务生命周期管理。 -

异步原生库生态:如异步ORM(SQLAlchemy 2.0+)、异步GUI框架(PyQt6 Async)。

-

编译器优化:如PyPy对协程的JIT优化,提升执行效率。

总结

Python协程通过事件循环+非阻塞I/O实现了高效的并发模型,其核心优势在于:

-

高吞吐量:单线程处理数万并发连接。

-

低资源消耗:协程切换成本仅为线程的1/100。

-

简洁语法:

async/await使异步代码更易读。

开发者需掌握协程设计模式、性能调优技巧及多进程协同方案,以充分发挥其潜力。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)