【干货收藏】MCP入门到精通:解锁大模型的“双手“,提升AI应用能力!

MCP(Model Context Protocol)是Anthropic推出的模型上下文协议,充当大模型的"双手",使其能访问外部资源执行实际任务。文章详细介绍了MCP的架构、工作原理及与Function Calling的区别,通过Client-Server模式连接大模型与外部服务,提供资源、工具和提示三种功能。文中提供了实践指南,包括在Cherry Studio中配置MCP服务的步骤,展示了如

简介

MCP(Model Context Protocol)是Anthropic推出的模型上下文协议,充当大模型的"双手",使其能访问外部资源执行实际任务。文章详细介绍了MCP的架构、工作原理及与Function Calling的区别,通过Client-Server模式连接大模型与外部服务,提供资源、工具和提示三种功能。文中提供了实践指南,包括在Cherry Studio中配置MCP服务的步骤,展示了如何让AI助手通过MCP实现网页内容获取、路线规划等实际操作,帮助开发者扩展大模型的应用能力。

一、文章背景

今天面试了一家全栈工程师,因为简历上写了MCP相关的内容,面试官看到了问道:你知道什么是MCP吗?项目中怎么用的?我脱口而出,MCP是按照某种协议实现的插件,项目使用MCP就是直接调用MCP服务,然而这样回答面试官好像并不满意,晚上来恶补一下MCP的相关知识。

二、为什么需要MCP

随着AI大语言模式的崛起,全球呈现出大语言模型百家争鸣的盛举,从最开始2022年ChatGPT突然出现在大众的视野,到后来国内各种大模型也纷纷逐渐跟随ChatGPT的脚步,到后来DeepSeek直接一夜爆火,打破大模型需要昂贵的训练资源要求,也是成功把大模型的价格打了下来,各大大模型厂商也争先恐后的推出自家的大语言模型,到现在全民皆可用AI的盛世。好了,为什么需要MCP呢?

大家有没有发现,大语言模型只是提供了一种人机交互的界面,本质上是一个聊天助手,用户和AI采用一问一答的形式,如果把大语言模型比作“一个大脑”,这个大脑有嘴巴,但是却没有“手”,他只能进行语言交流,MCP就是充当“手”的存在,有了手才能去实践,去完成具体的任务,去实践到实处。

举一个荔枝:

比如:我们电脑上有一些excel文件,里面存放着一些资料,你可用很容易的打开这些excel文件,但是对于AI来说就很为难了,它无法直接读取电脑文件夹里面的文件和文件内容,甚至修改文件内容,于是,你不得不手动把文件内容告诉它,让它给出相关的内容,然后自己在手动粘贴到对应的文件里面。既然我们都上AI了,不妨直接让它读取电脑中文件夹里面的文件,按照要求修改文件里面的内容,岂不快哉,这个时候MCP充当了“手”的作用了。

大模型的智商虽然很高,但是没有手足,也是寸步难行,MCP因此诞生。

三、什么是MCP

2024年11月,Anthropic公司发布了MCP(Model Context Protocol)协议,翻译过来就是:模型上下文协议,注意它是一种协议,可以理解为一种规范,比如手机的充电头TOP-C接口一样,只要充电器厂商使用了这种接口进行制作,手机就能够充电,为了方便手机充电,国内的绝大多数手机充电口已经统一为TOP-C接口,除了苹果。

MCP的出现成功让大模型提供了访问外部服务的机会,从靠嘴巴改变世界 -> 靠双手和嘴巴改变世界。

这时候如果懂一点编程的人会想到,这个和方法调用(Function Calling)有什么区别?

这两种技术都是增强AI大语言模型与外界的交互能力,但是MCP不止可以增强AI模型,还可以连接其他的应用系统。

| 类别 | MCP | Function Calling |

|---|---|---|

| 性质 | 协议 | 功能 |

| 范围 | 通用 | 特定场景 |

| 目标 | 统一接口,实现交互操作 | 扩展模型能力 |

| 实现 | 基于标准协议 | 依赖特定模型实现 |

| 开发复杂度 | 低:通过统一的协议开发 | 高:需要为每个任务开发函数 |

| 复用性 | 高:一次开发,多场景使用 | 低:函数通常是特定任务设计 |

| 灵活性 | 高:支持动态适配和扩展 | 低:功能扩展需要额外开发 |

| 场景场景 | 复杂场景,如数据访问和整合 | 简单任务,如数据查询 |

四、MCP核心概念

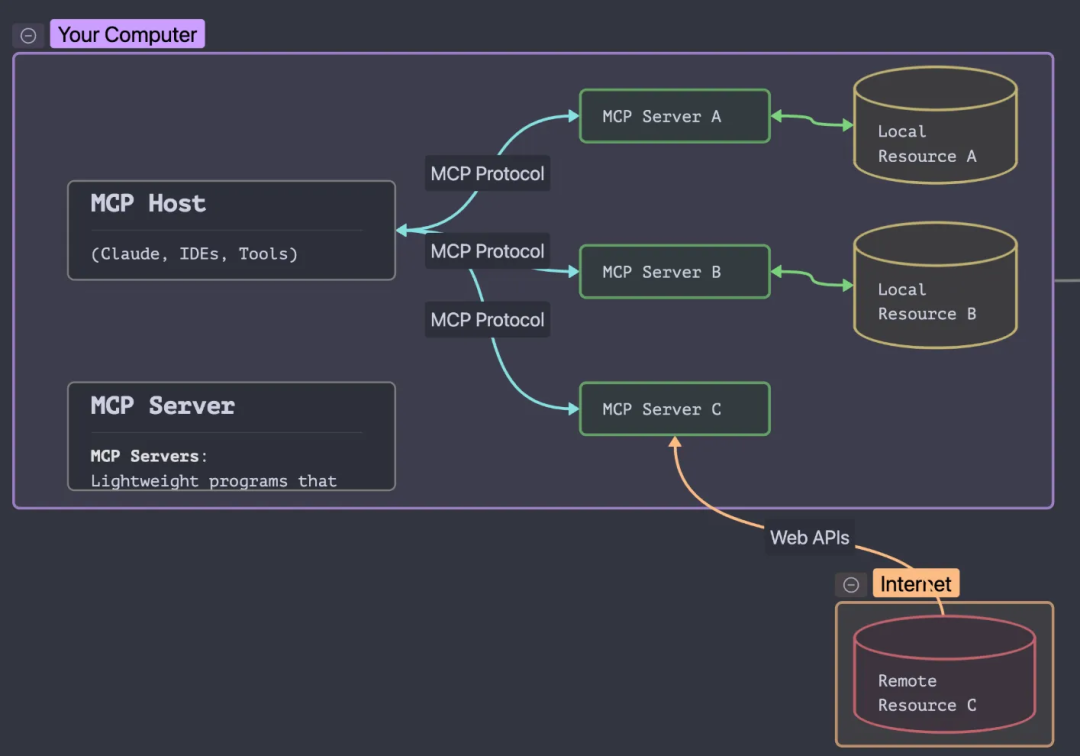

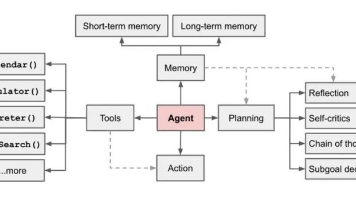

4.1 架构模式和工作原理

| 架构组件 | 描述 |

|---|---|

| MCP Host | 通过 MCP 访问数据的 Claude Desktop、IDE 、 AI 工具或自己开发应用等程序 |

| MCP Clients | 与服务器保持 1:1 连接的协议客户端 |

| MCP Servers | 轻量级程序,每个程序都通过标准化的 Model Context Protocol 公开特定功能 |

| Local Data Sources | MCP 服务器可以安全访问的计算机文件、数据库和服务 |

| Remote Services | MCP 服务器可以连接到的 Internet 上可用的外部系统(例如,通过 API) |

MCP协议将大模型和资源之间划分为了三个部分:客户端、服务端和资源。

下面我们用一个MCP的工作流程来解释:

- 初始化连接:客户端向服务端发送连接请求,建立通信通道。

- 发送请求:客户端根据需求构建请求消息,发送给服务端。

- 处理请求:服务端接收到消息后,解析消息,执行相应的操作,比如:查询数据,读写文件等。

- 返回结果:服务端将处理结果封装成响应结果,发送给客户端。

- 断开连接:任务完成后,客户端主动关闭连接或等待服务端连接超时。

举一个荔枝:

我们想让大模型查看今天北京的天气怎么样?

俩角色:大模型(客户端)- 高德天气(服务端)

提前告知大模型,你可以通过高德天气查询天气信息哦,当用户给大模型发送查看北京的天气,大模型 就会去 调用 高德天气,高德天气去查询今天北京的天气信息,查询完成后,把天气信息返回给大模型,最后将信息进行提炼,优化响应给到我们相关的天气信息。

一直在更新,更多的大模型学习和面试资料已经上传带到CSDN的官方了,有需要的朋友可以扫描下方二维码免费领取【保证100%免费】👇👇

4.2 MCP Client

MCP Client 充当 LLM 和 MCP Server 之间的桥梁,MCP Client 的工作流程如下:

- MCP Client 首先从 MCP Server 获取可用的工具列表。将用户的查询连同工具描述通过 function calling 一起发送给 LLM。

- LLM 决定是否需要使用工具以及使用哪些工具。如果需要使用工具,MCP Client 会通过 MCP Server 执行相应的工具调用。工具调用的结果会被发送回 LLM。

- LLM 基于所有信息生成自然语言响应。最后将响应展示给用户。

4.3 MCP Server

MCP Server 是 MCP 架构中的关键组件,它可以提供 3 种主要类型的功能:

- 资源(Resources):类似文件的数据,可以被客户端读取,如 API 响应或文件内容。

- 工具(Tools):可以被 LLM 调用的函数(需要用户批准)。

- 提示(Prompts):预先编写的模板,帮助用户完成特定任务。

这些功能使 MCP server 能够为 AI 应用提供丰富的上下文信息和操作能力,从而增强 LLM 的实用性和灵活性。

下面是全网比较全的MCP服务端资源,可以直接使用,提供给大家:

国外MCP服务器:https://mcpservers.org/

国内MCP服务器:https://mcpmarket.com/zh

阿里云百炼MCP:https://bailian.console.aliyun.com/?spm=5176.29619931.J__Z58Z6CX7MY__Ll8p1ZOR.1.3b24521cr2ypKX&tab=mcp#/mcp-market

Corsor专属MCP:https://cursor.directory/mcp

Smithery:https://smithery.ai/

MCP综合性平台:https://www.pulsemcp.com/

Awesome MCP:https://mcp.so/

专注MCP服务器:https://mcpserverhub.com/

魔搭社区MCP:https://www.modelscope.cn/mcp

五、MCP常见案例

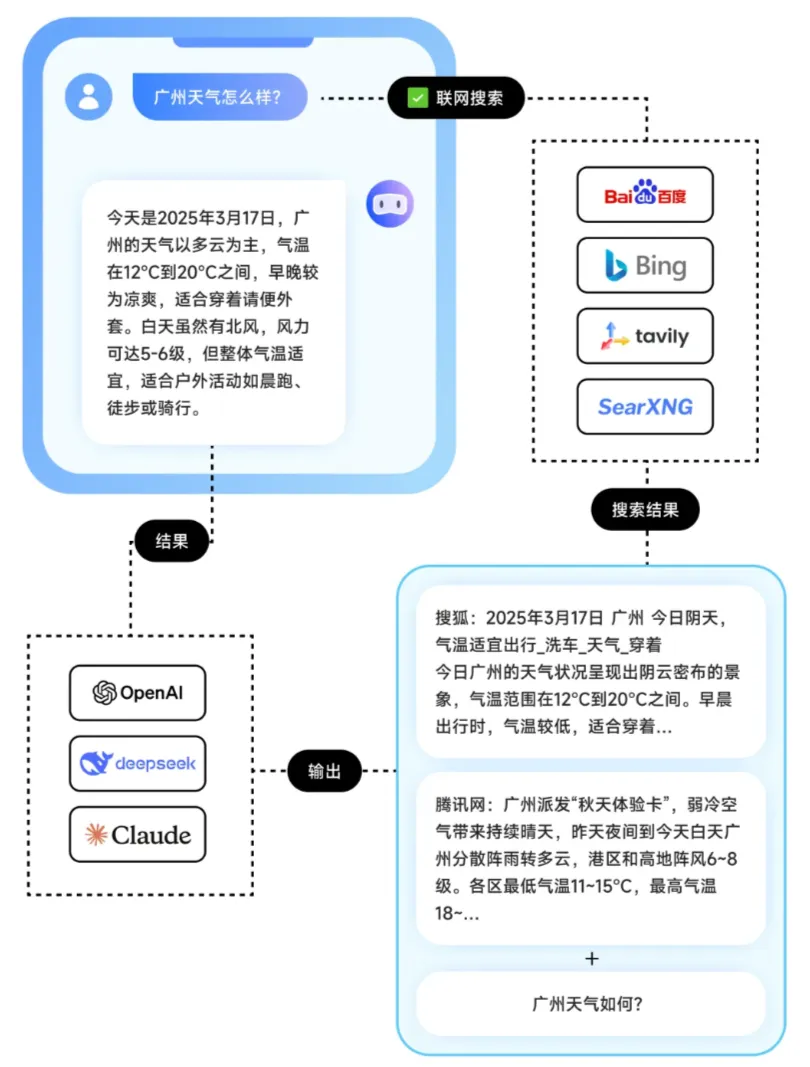

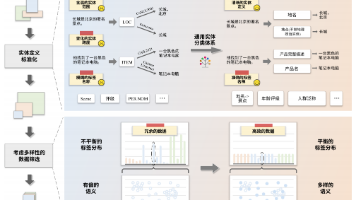

5.1 通过联网搜索向AI提供最新信息

常见的 AI 助手采用通过联网搜索获取实时信息。当用户开启联网搜索时,助手先将用户的请求发送至搜索引擎,再将返回内容与用户输入一起提供给大模型,最终生成回答。搜索引擎在此作为实时信息源,为大语言模型提供额外的上下文。

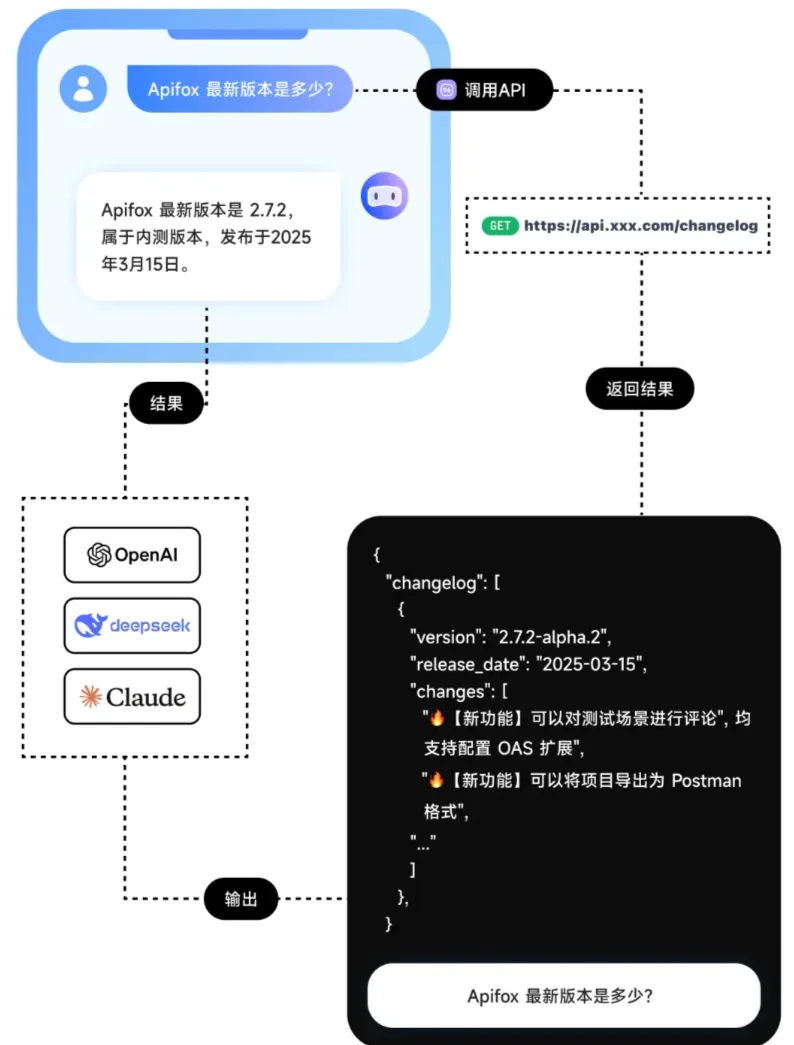

5.2 通过API向AI提供自有系统数据

如果希望 AI 能提供行业内部信息、或者研发的自有系统内的信息,AI 联网搜索的效果就很不好,甚至无法实现。用户可以自行搭建 AI 代理,将自有系统的数据通过 API 的形式接入 AI 助手,为大语言模型补充提供丰富的上下文信息。

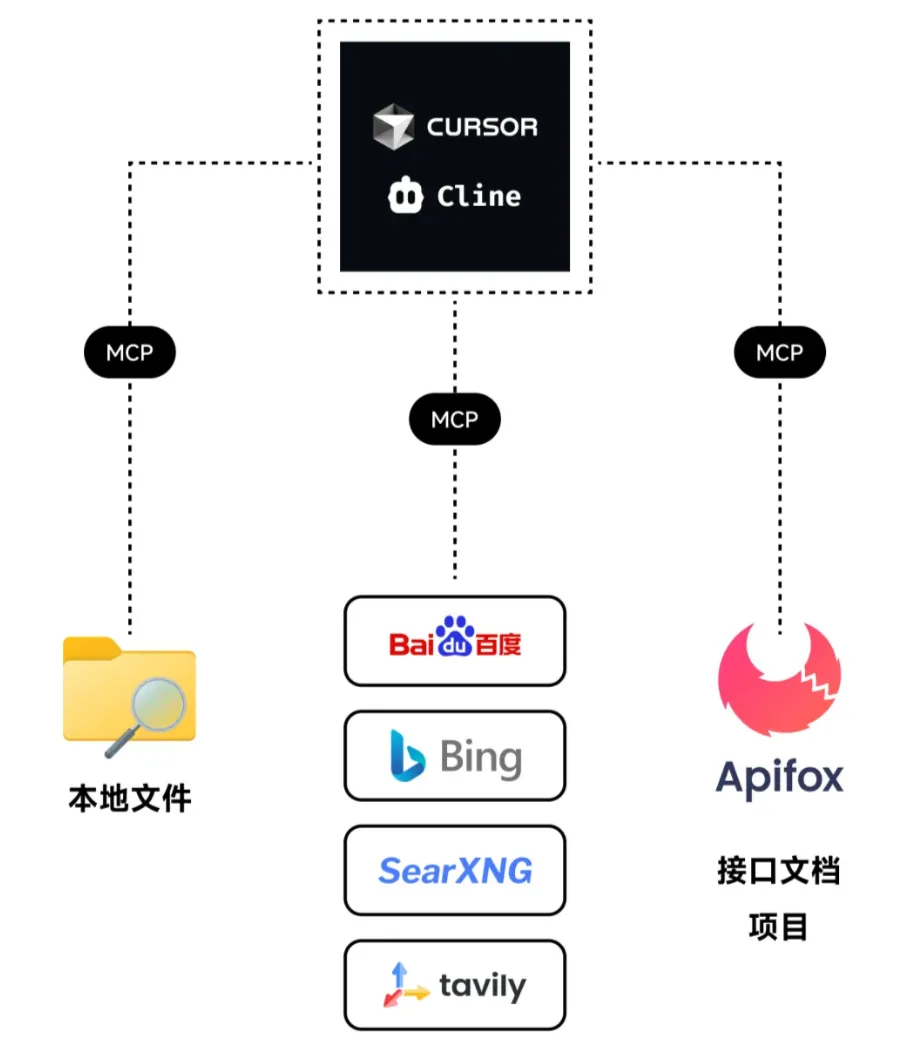

5.3 通过MCP服务器向AI提供上下文信息

MCP 协议解决了 AI 大模型与数据源集成碎片化的问题,提供统一标准,让开发者无需为每个数据源和 AI 助手单独开发连接器。通过 MCP,数据源和 AI 工具可建立安全双向连接,使 AI 在不同工具和数据集间流畅协作,实现更可持续的架构。

六、手动实践MCP插件

6.1 安装Cherry Studio 客户端

请首先安装 1.2.9 版本及以上的 Cherry Studio 客户端,并确保已通过配置合适的模型API,能在Cherry Studio里使用模型进行基本对话,

https://www.cherry-ai.com/download

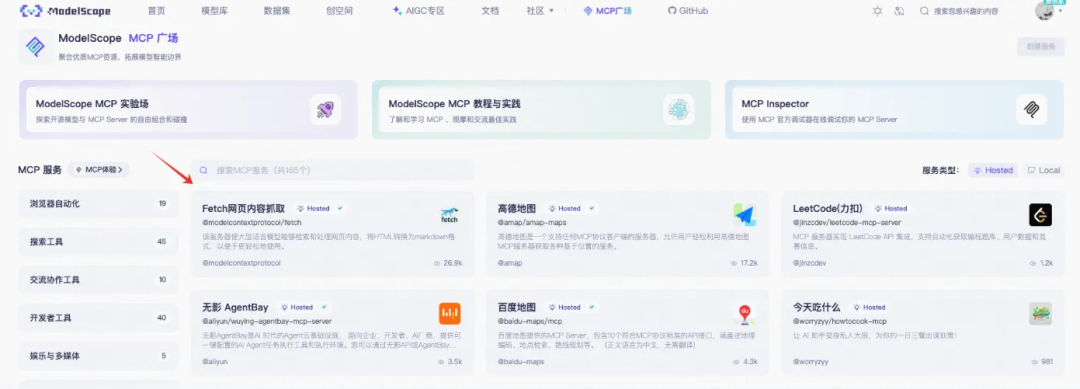

6.2 在魔搭社区MCP搜索MCP服务

ModelScope通过 MCP广场 为广大开发者提供了海量的MCP服务。可以直接在ModelScope平台上实现托管,供包括Cherry-Studio在内的不同客户端直接集成使用。

6.3 在Cherry Studio中配置ModelScope MCP的同步

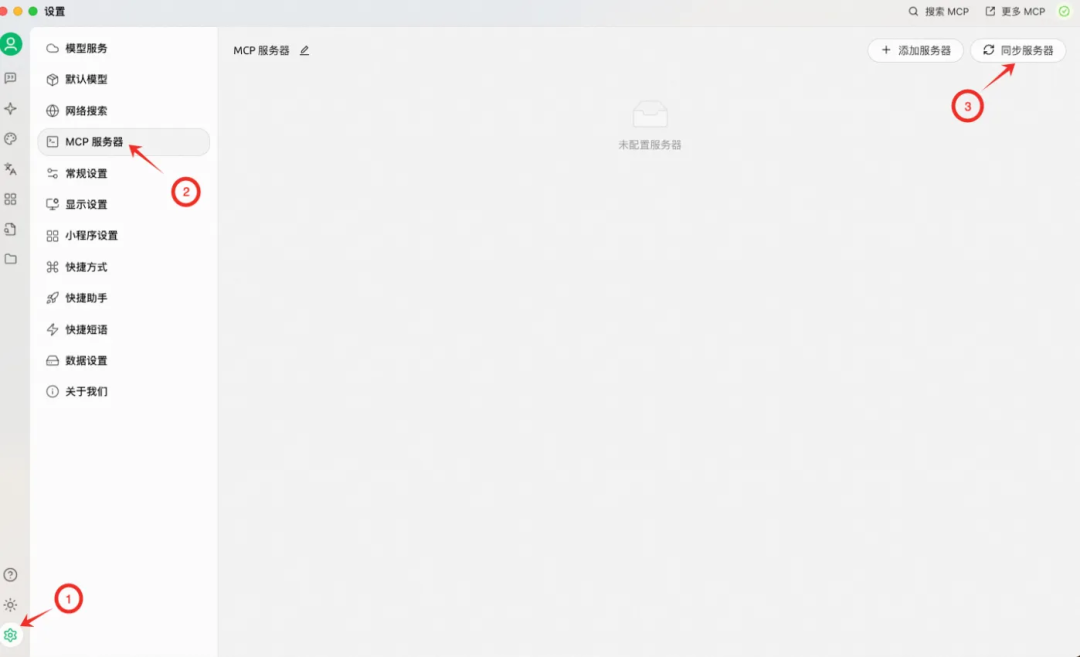

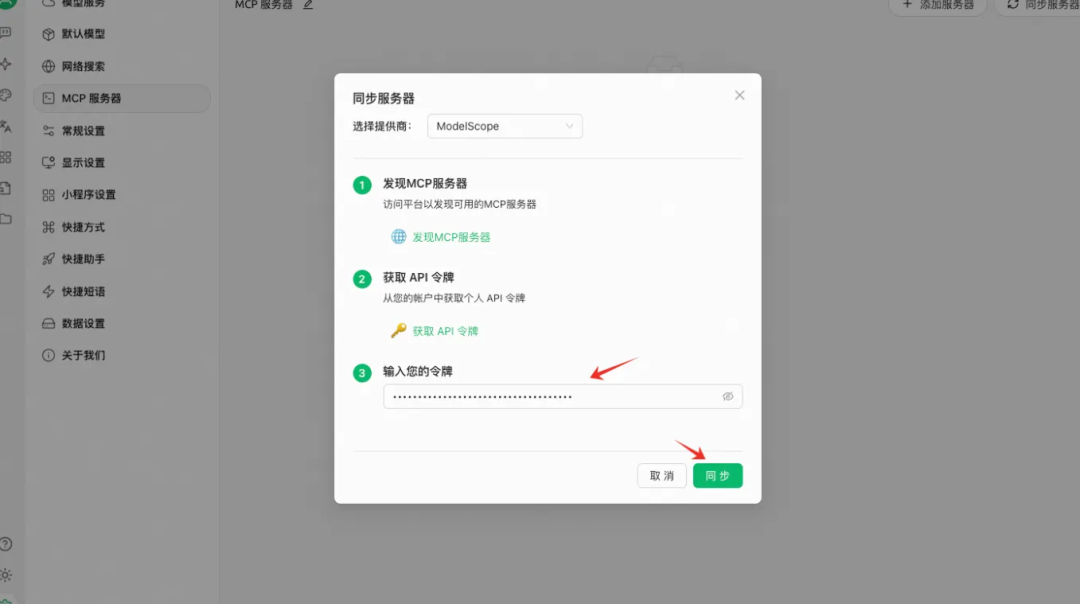

在Cherry Studio启用MCP服务需要在「设置」中添加可用的MCP服务配置。可以前往“设置-MCP服务器-同步服务器”快速同步ModelScope MCP服务。

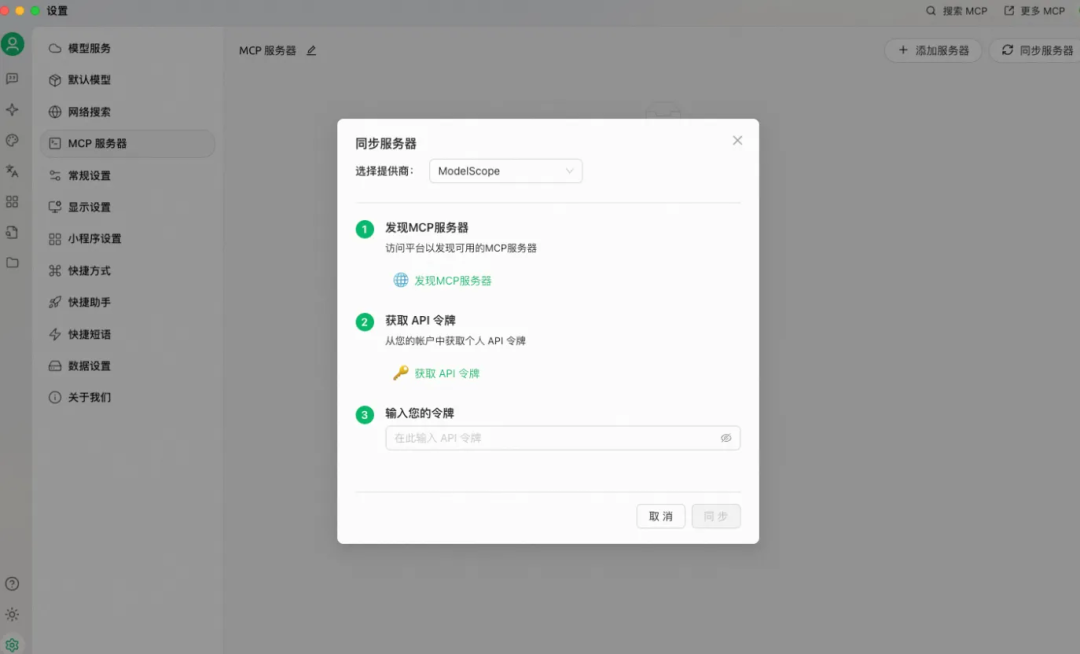

进入后可以看到 CherryStudio默认选中 ModelScope 作为 MCP 服务提供商。Cherry Studio 与ModelScope(魔搭) 达成官方合作,只需要简单的输入您的魔搭 API 令牌,即可一键同步魔搭账号下所有已经配置托管的 MCP 服务配置。

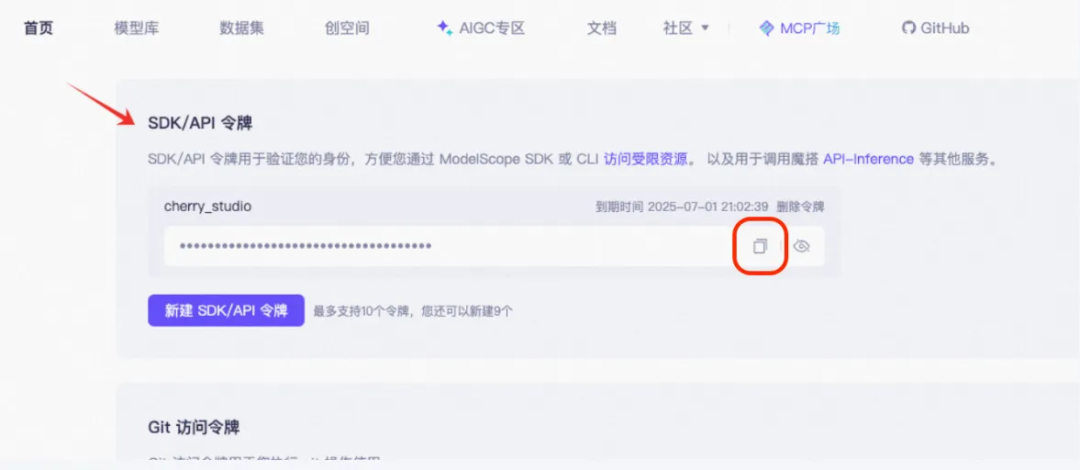

其中 API 令牌可以通过访问“魔搭首页-访问令牌”页面获取。

在获取ModelScope API令牌后,粘贴到步骤3的空格中,并点击「同步」按钮。

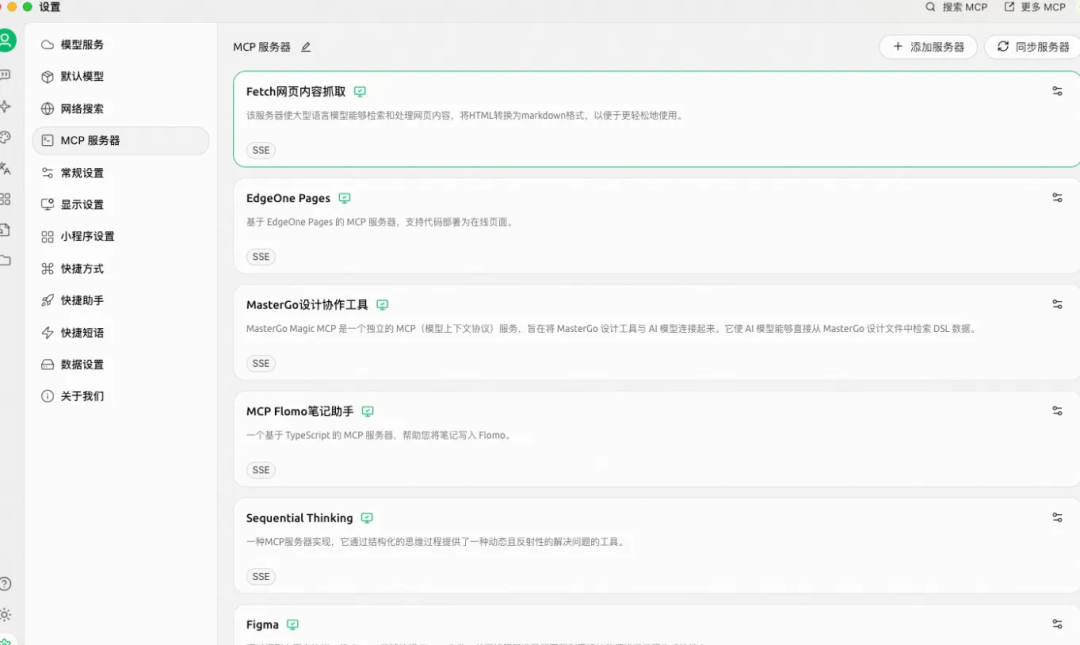

可以看到所有已经配置连接的魔搭Hosted MCP服务,都已经同步在Cherry Studio可用MCP服务器列表中。

然后可以愉快地在 Cherry Studio 中体验 AI 助手调用MCP服务完成任务~

6.4 在Cherry Studio中结合模型与MCP的使用

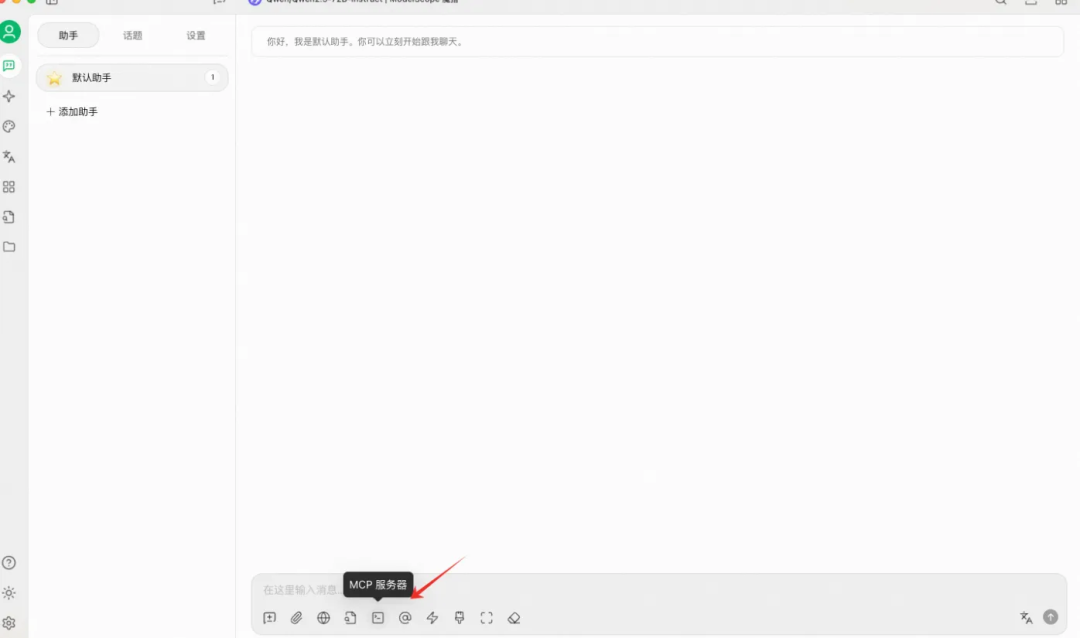

同步MCP服务后,可以在Cherry Studio客户端AI助手消息输入框看到新增的“MCP服务器”图标。

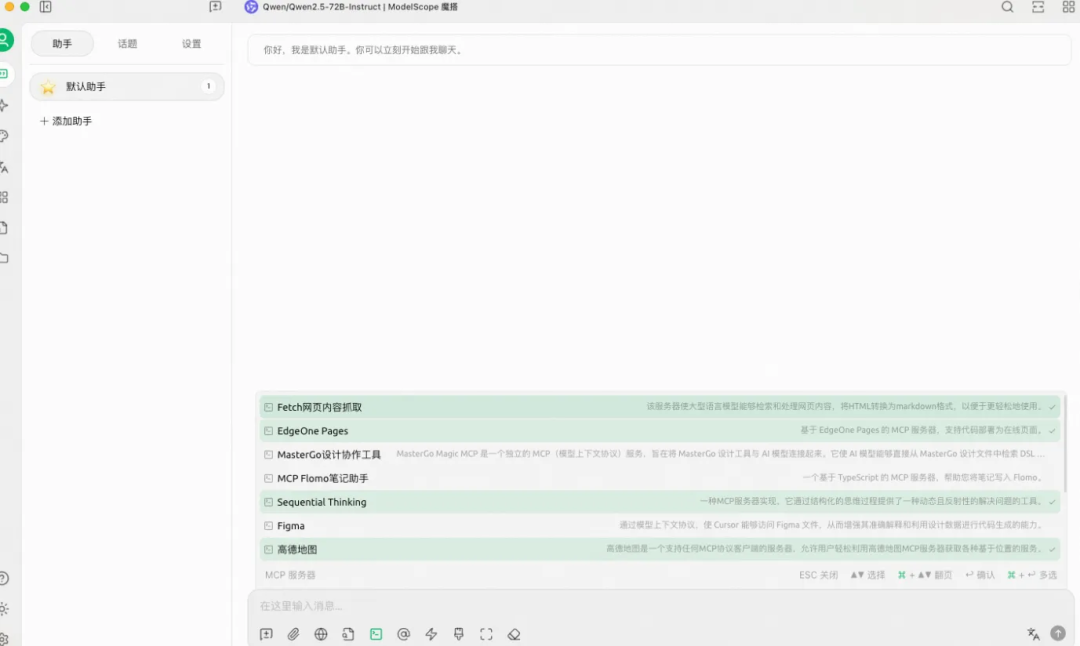

点击即可查看,通过之前同步操作已导入到Cherry Studio中,可直接使用的MCP服务列表。可从这个列表中,多选本次对话期望启用的MCP。

6.5 效果示例

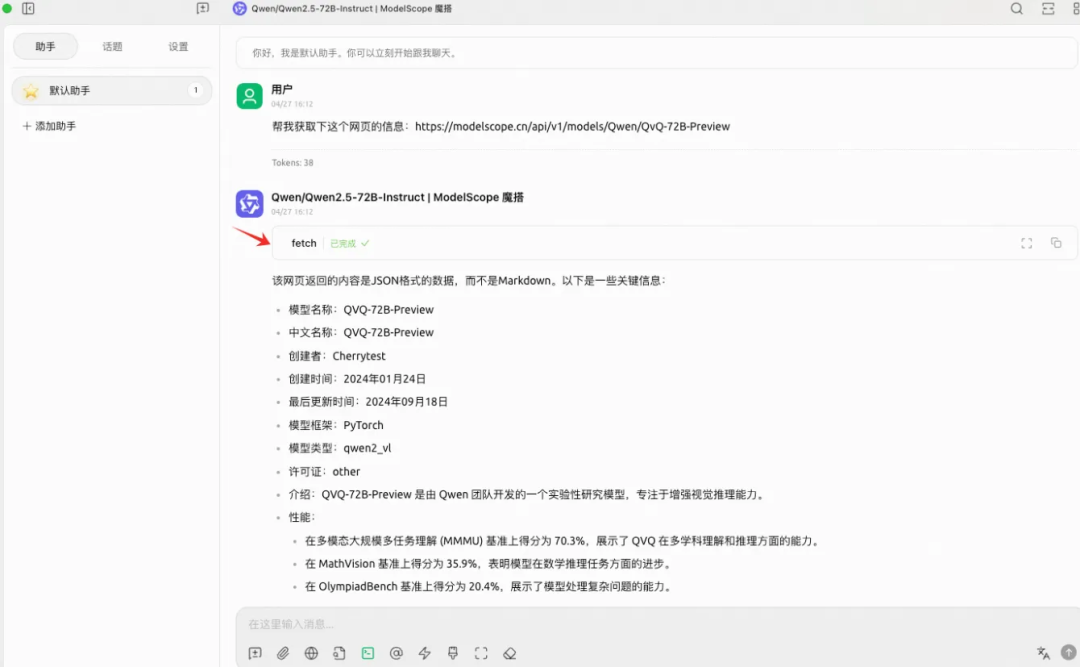

以Fetch网页内容提取 MCP为例,可以看到当我们要求 AI 助手获取相关网页信息时,AI助手调用了“Fetch网页内容获取”MCP服务的工具来完成任务。

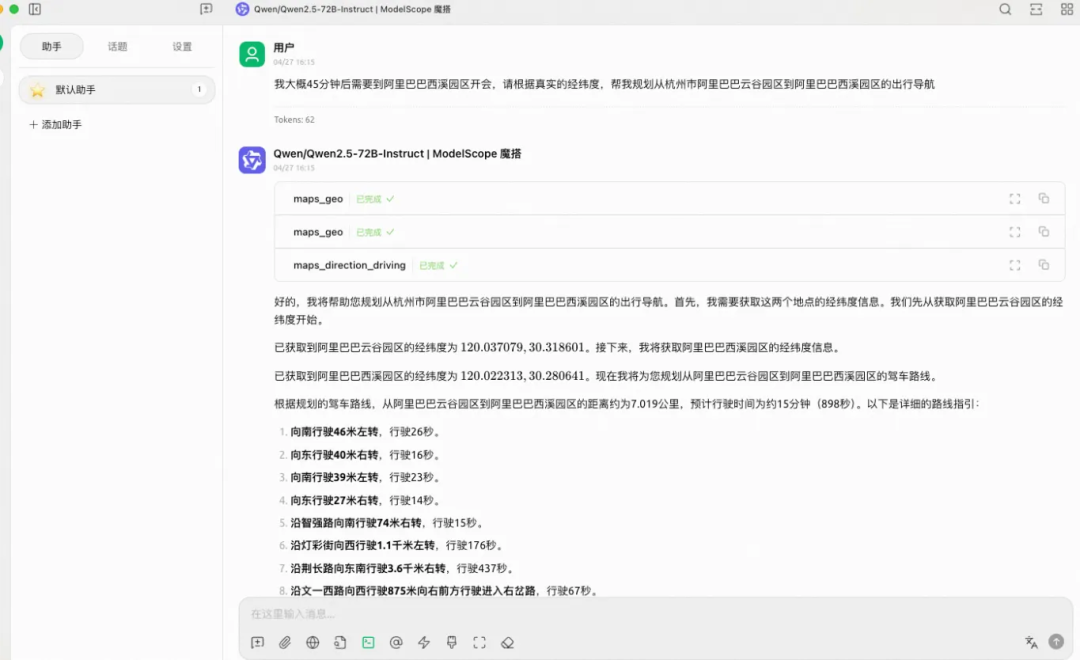

同样的,如果其他MCP已经被启用,也可以被AI助手自由调用。例如以下例子,就展示了使用高德地图MCP 来完成完成路线规划。

七、最后总结

纵观人类千年发展历史:从石器时代、铁器时代、蒸汽时代、电气时代、互联网时代,到现在的AI时代,每一个时代都是人类的一个转折点,每个时代的兴起不同职业的从业者都有滞后性,只有不断学习,才能跟上时代发展。

人工智能会取代大多数低级枯燥的工作,当然也会诞生一些新的工种,就像汽车发明之后,马车夫失业,汽车司机上岗,如果只是一味的守着马车,那么不久的将来可能会被时代淘汰。

八、AI大模型从0到精通全套学习大礼包

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

只要你是真心想学AI大模型,我这份资料就可以无偿共享给你学习。大模型行业确实也需要更多的有志之士加入进来,我也真心希望帮助大家学好这门技术,如果日后有什么学习上的问题,欢迎找我交流,有技术上面的问题,我是很愿意去帮助大家的!

如果你也想通过学大模型技术去帮助就业和转行,可以扫描下方链接👇👇

大模型重磅福利:入门进阶全套104G学习资源包免费分享!

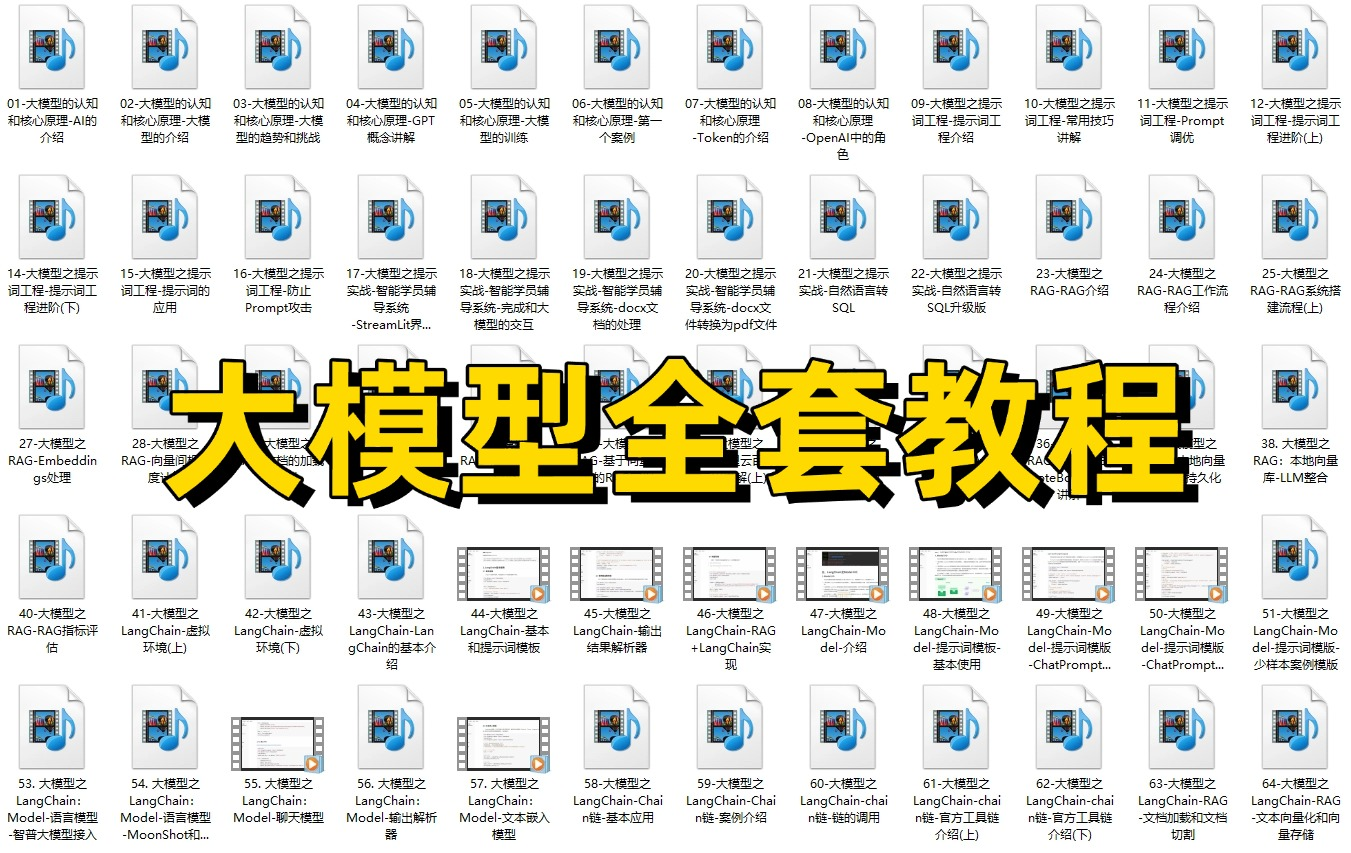

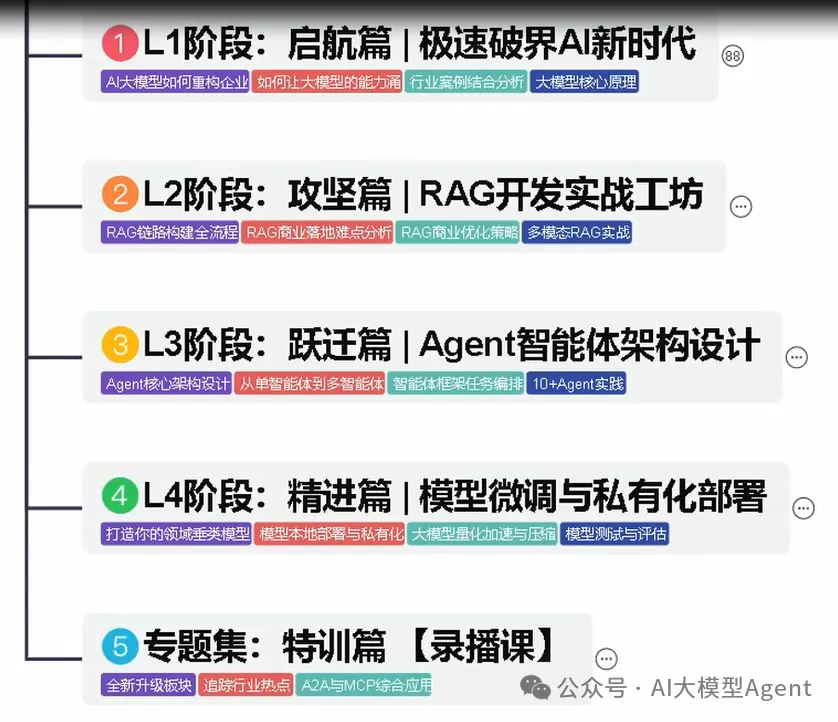

01.从入门到精通的全套视频教程

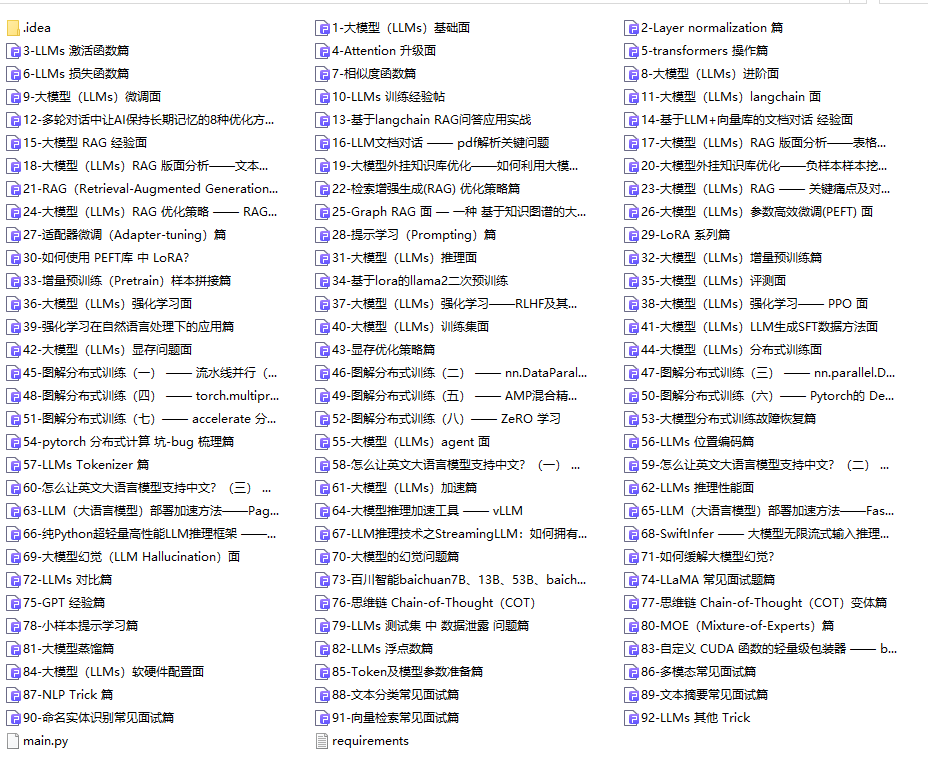

包含提示词工程、RAG、Agent等技术点

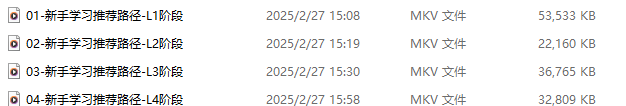

02.AI大模型学习路线图(还有视频解说)

全过程AI大模型学习路线

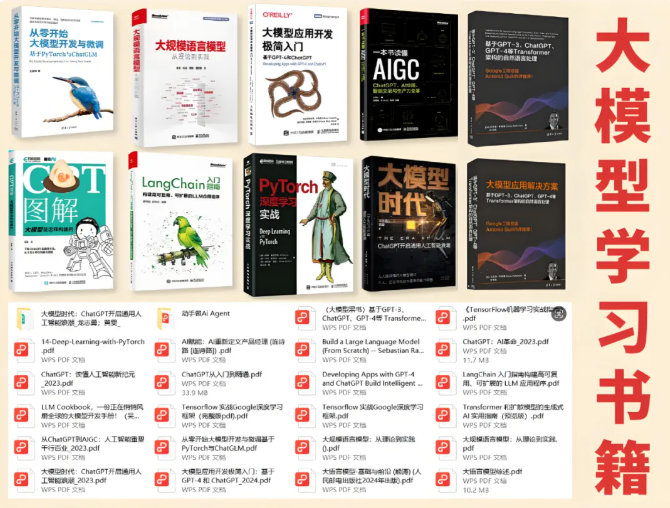

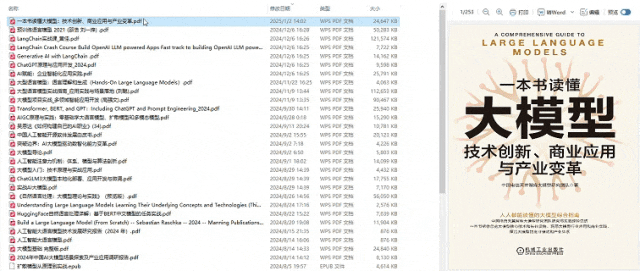

03.学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

04.大模型面试题目详解

05.这些资料真的有用吗?

这份资料由我和鲁为民博士共同整理,鲁为民博士先后获得了北京清华大学学士和美国加州理工学院博士学位,在包括IEEE Transactions等学术期刊和诸多国际会议上发表了超过50篇学术论文、取得了多项美国和中国发明专利,同时还斩获了吴文俊人工智能科学技术奖。目前我正在和鲁博士共同进行人工智能的研究。

所有的视频由智泊AI老师录制,且资料与智泊AI共享,相互补充。这份学习大礼包应该算是现在最全面的大模型学习资料了。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

智泊AI始终秉持着“让每个人平等享受到优质教育资源”的育人理念,通过动态追踪大模型开发、数据标注伦理等前沿技术趋势,构建起"前沿课程+智能实训+精准就业"的高效培养体系。

课堂上不光教理论,还带着学员做了十多个真实项目。学员要亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

如果说你是以下人群中的其中一类,都可以来智泊AI学习人工智能,找到高薪工作,一次小小的“投资”换来的是终身受益!

应届毕业生:无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型:非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能 突破瓶颈:传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献364条内容

已为社区贡献364条内容

所有评论(0)