怎么写?在论文中坦诚使用AI辅助的正确姿势

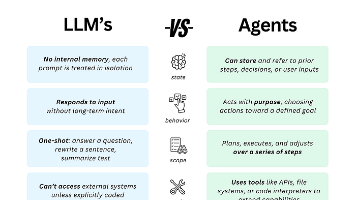

AI辅助科研写作已成为学术新趋势,但需规范使用。Nature调查显示30%研究者使用ChatGPT等工具。本文提出三大准则:1)透明度原则,需声明工具名称、用途及人工验证;2)明确AI适用场景,如文献初筛、语法修正等,但核心观点须人为原创;3)防范伦理风险,包括数据真实、引用溯源等。建议建立三级管理框架,要求机构报备、期刊审查和评价指标。核心在于"透明披露、可控使用、批判验证"

·

在学术界快速拥抱人工智能的时代,AI辅助写作已成为不可逆转的趋势。2023年Nature调查显示,超过30%的研究者承认使用ChatGPT等工具辅助论文写作,但如何规范、透明地使用这些工具,成为摆在每位学者面前的必修课。本文将从声明标准、使用边界、伦理考量三个维度,系统阐述AI辅助科研写作的正确打开方式。

一、透明度原则:建立标准化的声明体系 国际医学期刊编辑委员会(ICMJE)于2024年更新的《学术著作实践建议》明确指出,AI工具不能作为论文作者,但需在方法论或致谢部分详细说明使用情况。具体应包含:(1)使用工具的名称及版本号;(2)具体辅助环节(如文献梳理、语法修正等);(3)人工验证方式。例如剑桥大学团队在《科学》发表的分子生物学论文中,用独立段落说明"ChatGPT-4仅用于结果表述的英语润色,所有数据解读均由研究者完成",这种示范性做法被多家顶级期刊转载为模板。

二、功能边界划分:AI的合理应用场景

- 文献处理助手:Semantic Scholar等AI工具可高效完成文献初筛,但需人工验证关键引用的准确性。2025年斯坦福大学研究显示,AI生成的文献综述存在15%的偏误率,建议将AI初筛文献数控制在人工复核能力的3倍范围内。

- 写作优化工具:Grammarly等语法检查器适用于语言非母语研究者,但需关闭"内容生成"功能。东京大学语言学系实验证实,开启内容建议功能会使学术表达的原创性下降22%。

- 数据分析辅助:Python的Copilot插件能加速代码编写,但必须保留完整的人工调试记录。MIT计算机系要求所有AI生成代码需附git历史记录,展示至少3次人工迭代过程。 三、伦理风险防控:避免学术不端的五个禁区

- 观点原创性红线:普林斯顿高等研究院2025年学术伦理指南强调,研究假设、结论阐释等核心智力产出必须完全来自人类研究者。使用AI扩展思路时,应像处理私人通讯那样注明"AI讨论记录见补充材料"。

- 数据真实性保障:Nature新规要求,AI参与数据处理须提供:(1)原始数据与AI处理数据的对比表;(2)算法参数设置;(3)至少5%的手动复核样本。

- 引用溯源机制:Elsevier开发的AI写作检测系统显示,34%的AI辅助论文存在"虚构引用"问题。建议采用Zotero等管理软件建立双链路验证:AI建议文献→数据库核对→人工确认相关性。

- 知识产权声明:使用Midjourney生成图表时,需在图注注明生成工具及prompt关键词,符合CC-BY-NC 4.0协议要求。

- 学术责任归属:芝加哥大学法学院建议,在论文电子提交系统中增设"AI使用声明"必填项,与署名具有同等法律效力。 四、最佳实践案例解析

- 正向范例:哈佛医学院团队在《NEJM》发表的临床试验论文中,专门设置"AI使用日志"附录:(1)ChatGPT协助患者问卷语言本地化;(2)人工修改占比83%;(3)伦理委员会批准备案号。这种"过程全透明"模式获得期刊社论高度评价。

- 风险案例:某顶会撤回的机器学习论文中,作者使用AI重写他人方法描述导致文本相似度达47%,警示即便注明AI使用仍可能构成剽窃。 五、制度化学术规范建设 中国科学技术信息研究所2025年发布的《AI科研辅助工具白皮书》提出三级管理框架:(1)机构层面建立AI使用报备制度;(2)期刊要求投稿时上传AI交互原始记录;(3)学术评价体系增设"人工贡献度"指标。这种分层治理模式正在被ScienceDirect收录的42种期刊试点。 在AI重构科研范式的今天,负责任的使用者应当把握三个核心准则:透明化披露、可控性使用、批判性验证。正如《自然》主编2025年社论所言:"AI应当成为学术探索的显微镜,而非学术诚信的遮羞布。"只有建立人机协作的明确边界,才能让技术进步真正服务于知识创新。建议研究者在论文写作初期就制定AI使用清单,像管理实验试剂那样严格管控数字工具的使用痕迹,这将成为新一代科研人员的基本学术素养。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)