【AAAI 2023 Oral】TSCD —— 基于自对应蒸馏的端到端弱监督语义分割

中科院自动化所等机构提出的TSCD方法在AAAI 2023获Oral论文,该研究通过自对应蒸馏(SCD)和变分感知优化模块(VARM),构建了端到端Transformer弱监督语义分割框架。在PASCAL VOC和COCO数据集上达到SOTA性能,VOC val集65.0% mIoU,显著优于同类方法。该工作创新性地利用网络自身CAM特征对应关系进行蒸馏,无需外部监督,为弱监督分割提供了新思路。

🚀 突破性进展:AAAI 2023 Oral 论文 TSCD —— 基于自对应蒸馏的端到端弱监督语义分割

我们很高兴地宣布,由中国科学院自动化研究所、北京邮电大学等单位合作完成的论文 《Self Correspondence Distillation for End-to-End Weakly-Supervised Semantic Segmentation》 已被 AAAI 2023 接收为 Oral 论文,并即将在会上进行报告。

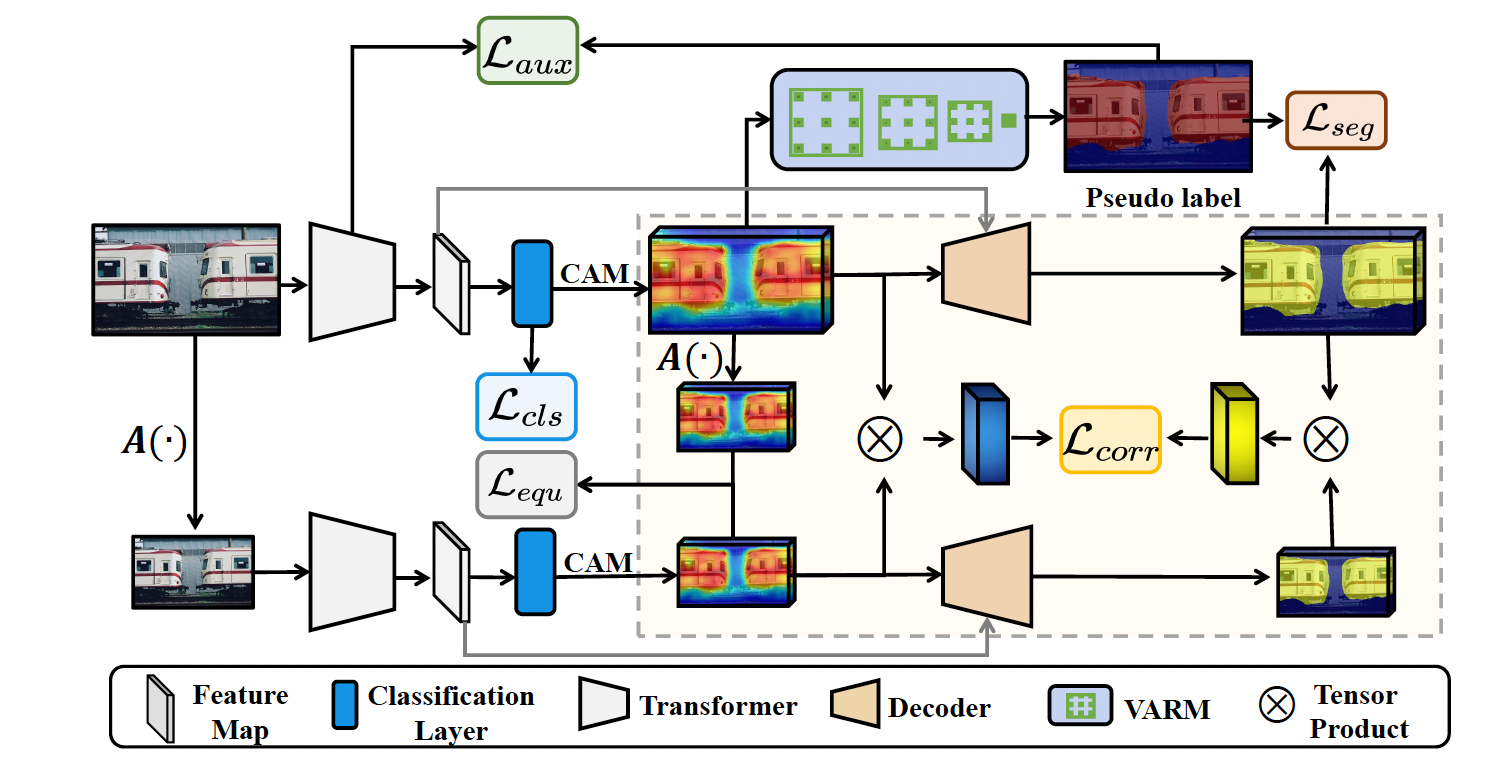

该研究提出了一种新颖的 自对应蒸馏(Self Correspondence Distillation, SCD) 方法,结合 变分感知优化模块(Variation-aware Refine Module, VARM),构建了一个端到端的 Transformer 弱监督语义分割框架——TSCD。

🌟 核心贡献:

-

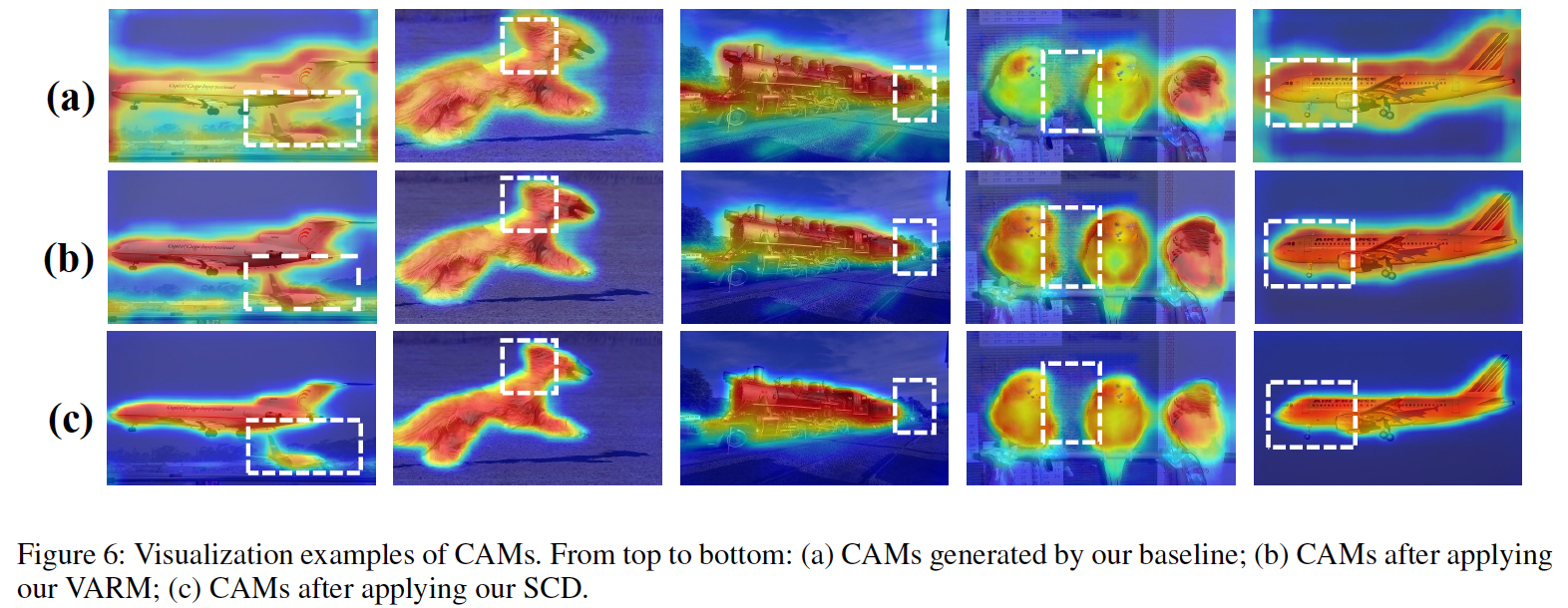

自对应蒸馏(SCD):

首次利用网络自身生成的类激活图(CAM)特征对应关系作为蒸馏目标,无需外部监督即可增强语义信息的完整性与一致性。 -

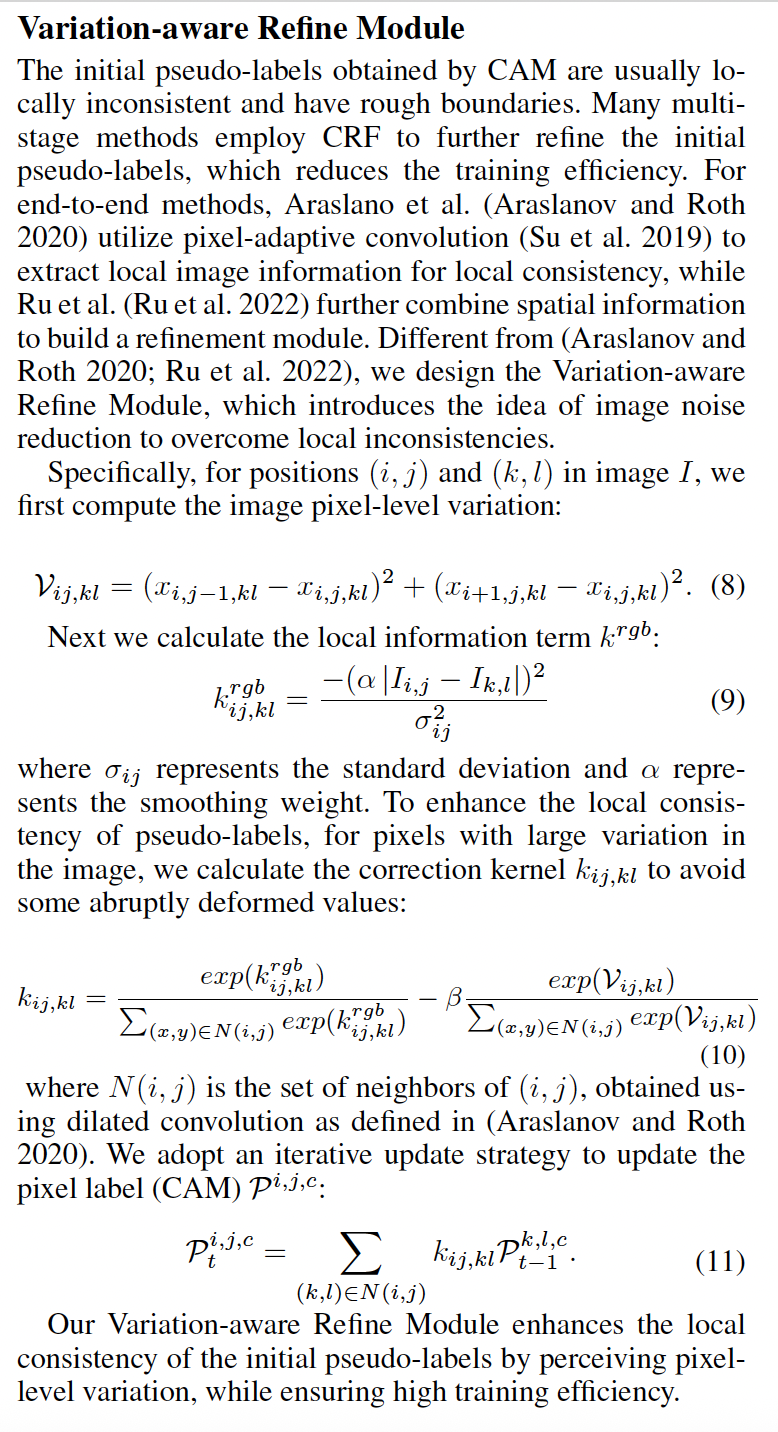

变分感知优化模块(VARM):

通过感知图像像素级变化,提升伪标签的局部一致性,显著改善边界质量。

-

端到端 Transformer 框架(TSCD):

集成 SCD 与 VARM,在仅使用图像级标签的情况下,实现了与全监督方法相媲美的语义分割性能。

📊 实验结果:

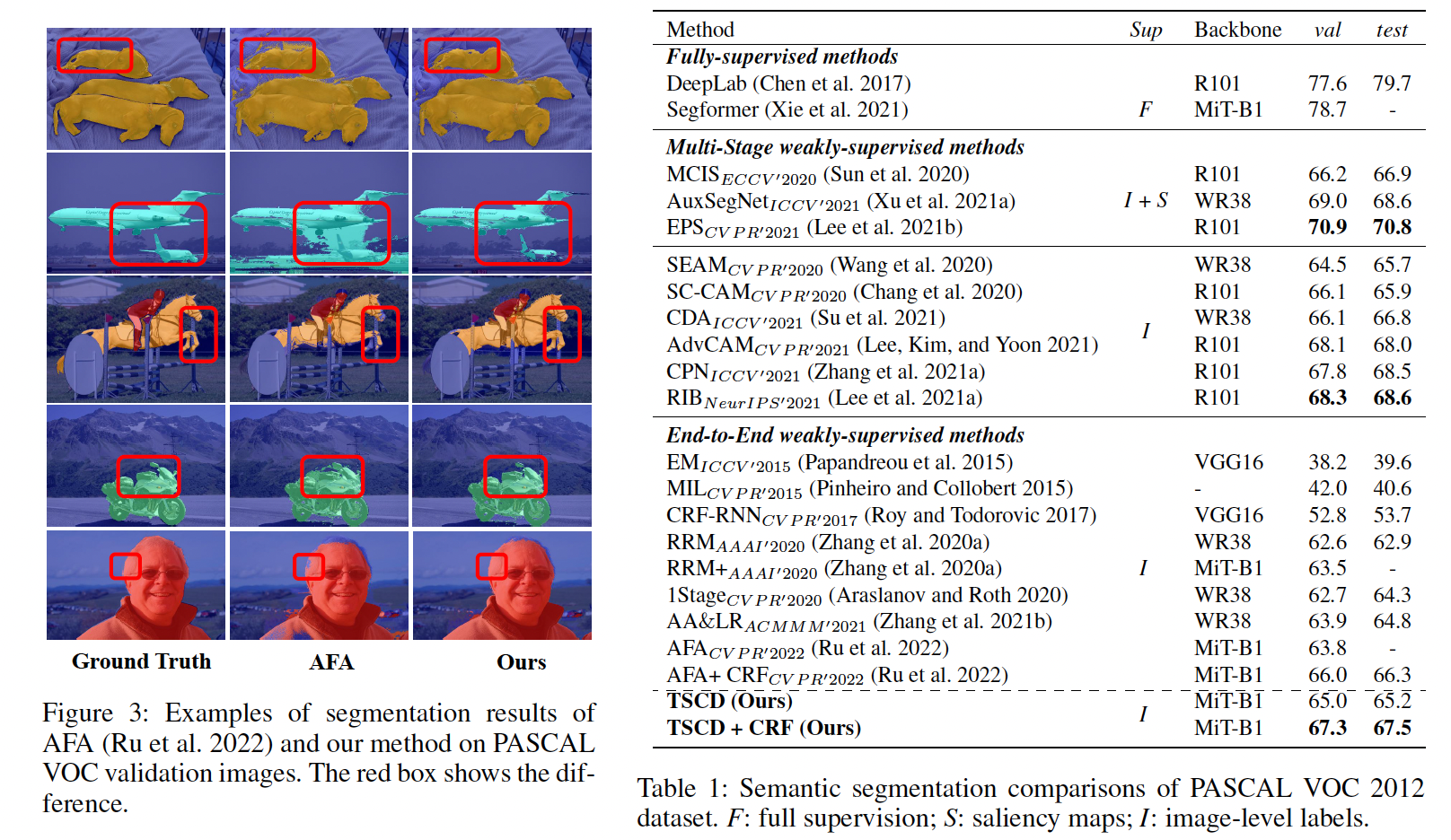

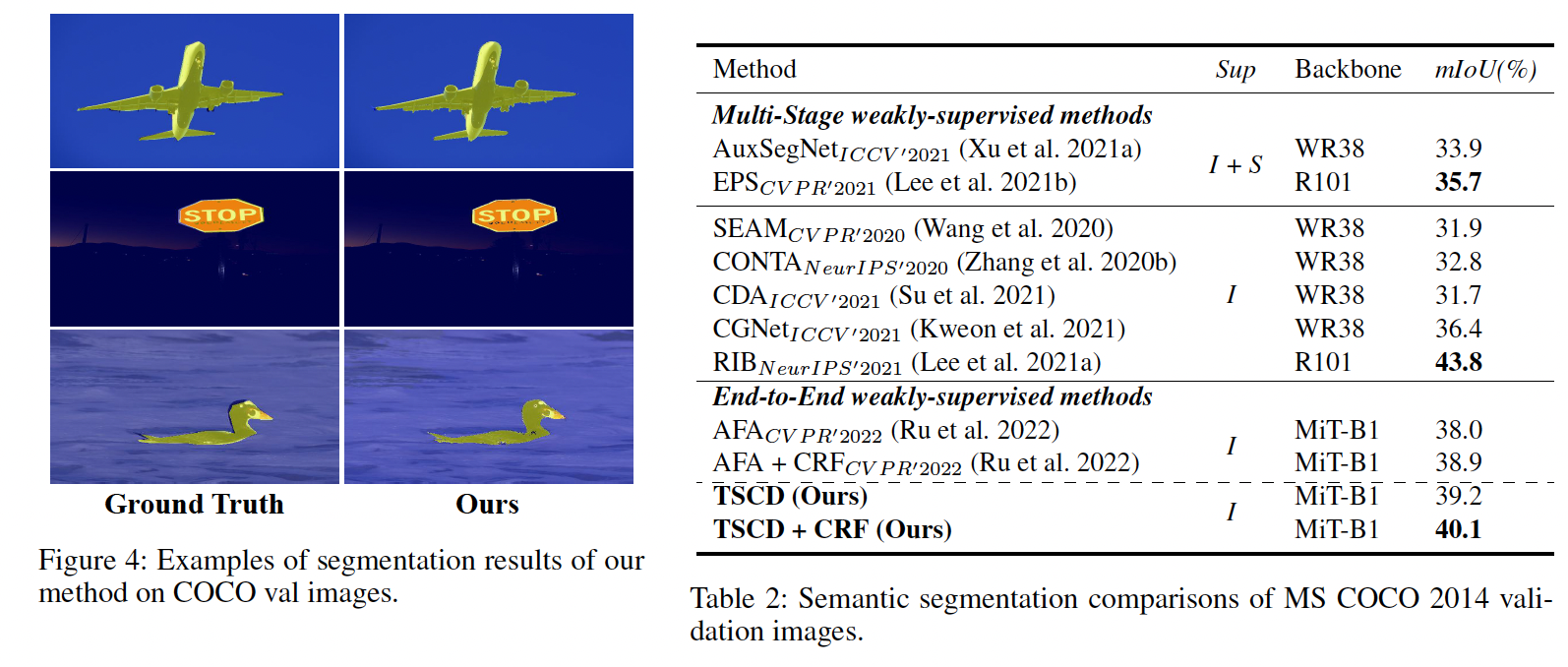

- 在 PASCAL VOC 2012 和 MS COCO 2014 数据集上,TSCD 均达到了当前最优(SOTA)性能。

- 在 VOC 2012 val 集上达到 65.0% mIoU,test 集上达到 65.2% mIoU,显著优于同类端到端方法。

- 在 COCO 2014 上达到 40.1% mIoU,相比基线方法提升显著。

📄 论文信息:

- 标题:Self Correspondence Distillation for End-to-End Weakly-Supervised Semantic Segmentation

- 作者:Rongtao Xu, Changwei Wang, Jiaxi Sun, Shibiao Xu, Weiliang Meng, Xiaopeng Zhang

- 单位:中科院自动化所、北京邮电大学、国科大

- 会议:AAAI 2023 (Oral)

我们相信,TSCD 不仅为弱监督语义分割提供了新的思路,也为自监督学习与知识蒸馏的结合开辟了新的方向。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)