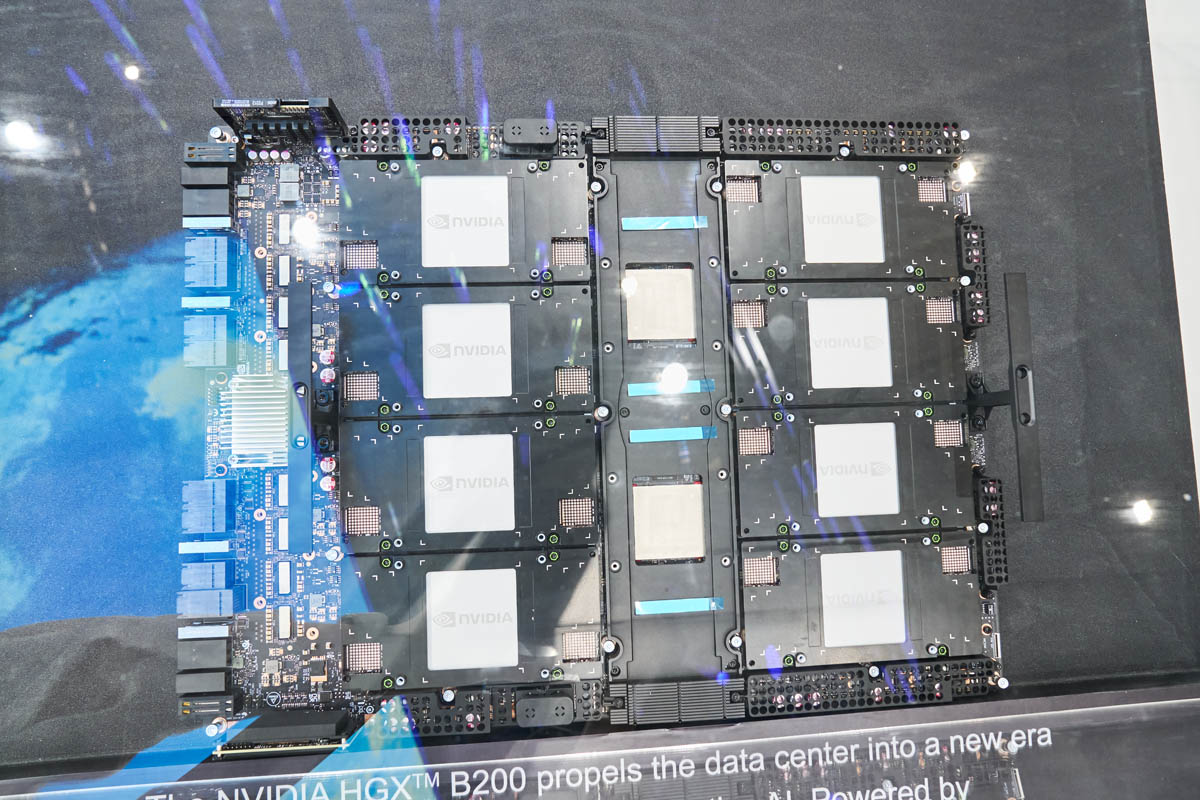

英伟达NVIDIA B200 基座模块:服务器的核心承载与互联平台

英伟达B200基座模块是B200 GPU服务器的核心承载平台,为AI大模型训练、推理及高性能计算提供硬件基础。该模块具备高速互连、电源管理、系统监控和扩展能力,支持NVLink、PCIe Gen5等高速接口,单卡功耗超700W。应用场景涵盖大型语言模型训练、科学计算、云服务和私有超算,部署形态包括独立节点、超算集群和混合平台。需结合电源、散热等系统设计确保稳定运行。

英伟达B200 基座模块:NVIDIA B200 基座模块并非普通扩展卡,而是 B200 GPU 系列服务器的核心承载与互联核心平台。其为从单节点到超大规模集群的 AI 大模型训练、推理及高性能科学计算提供坚实硬件基础,是高算力数据中心建设中不可或缺的关键组件。

实际部署时,需综合考量电源供给、散热方案、机架结构及网络拓扑,并结合 NVIDIA HGX/B200 参考架构或 OEM 合作方案开展系统整体设计,确保硬件兼容性与运行稳定性。

1. 模块定位

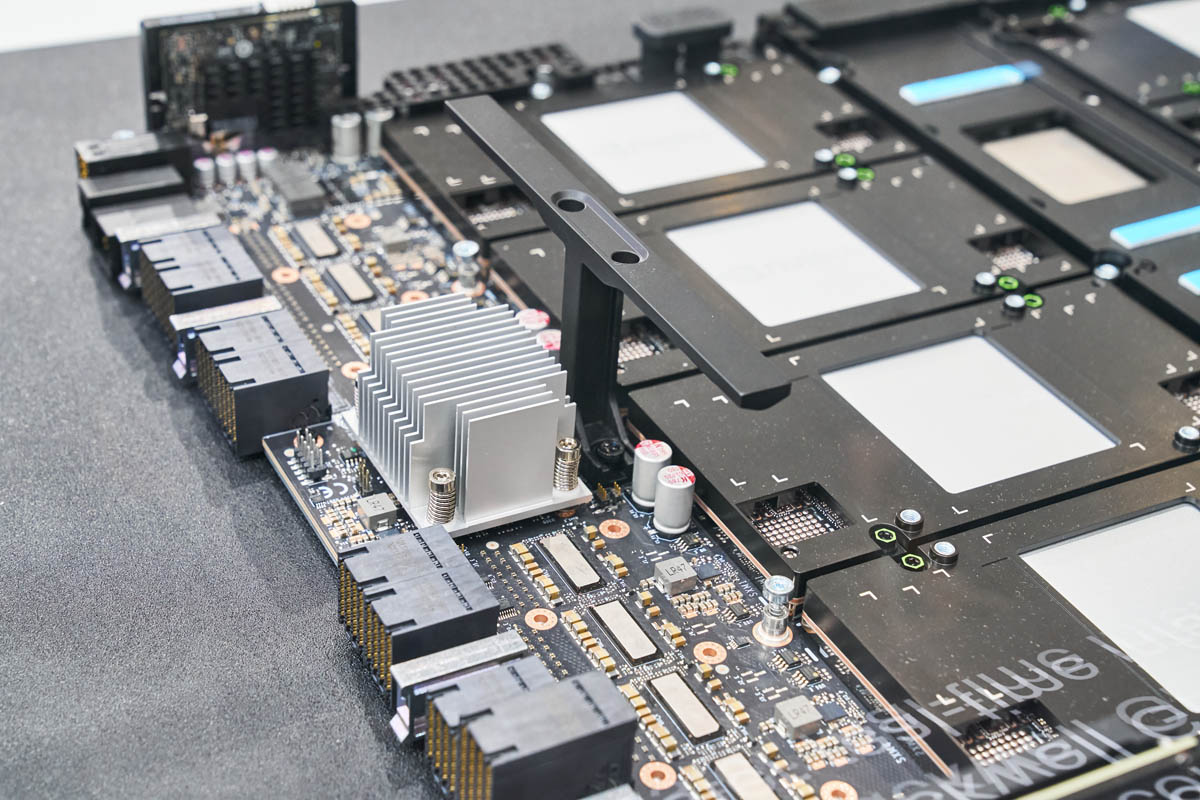

NVIDIA B200 基座模块是 B200 GPU 计算卡的系统主板(Baseboard/Carrier Board),核心职责是连接 GPU 计算核心与服务器其他关键组件。作为 B200 GPU 系列服务器的承载与集成核心平台,其在整体系统中承担电源分配、高速信号传输、I/O 扩展及远程管理等核心任务,保障各硬件模块协同运行。

2. 核心功能

|

功能类别 |

主要作用 |

|

高速互连 |

通过 NVLink、NVSwitch 或 PCIe Gen5 高速接口,实现多块 B200 GPU、Grace CPU 与高速存储 / 网络组件的高效互联,为超大规模并行计算提供低延迟、高带宽的互连支撑。 |

|

电源与散热管理 |

提供稳定高功率供电(单卡功耗可超 700W),同时实时监测硬件温度、电压等关键参数,动态协调风扇风冷或液冷系统,确保模块在安全工况下稳定运行。 |

|

系统管理 |

集成 BMC/IPMI 或 Redfish 远程管理协议,支持远程硬件监控、固件升级及节点健康状态管理,降低运维成本与复杂度。 |

|

可扩展性 |

预留 OCP NIC 3.0、InfiniBand/NVLink Switch 标准插槽,支持硬件模块灵活扩展,可便捷实现横向扩容至大规模集群架构。 |

3. 典型应用场景

B200 基座模块广泛应用于高性能 AI 与 HPC(High-Performance Computing)计算环境,核心场景包括:

- 大型语言模型训练与推理:作为 HGX Grace Hopper/B200 超算平台的核心节点,支持多 GPU NVLink 高速互联,可高效完成百亿至万亿参数规模语言模型的训练与推理任务,满足大模型算力需求。

- 高性能科学计算(HPC):适用于气候模拟、分子动力学分析、量子化学计算等场景,可提供极高并行浮点算力,支撑高复杂度科学计算任务高效推进。

- 数据中心云服务:为云服务厂商提供 GPU 加速的弹性算力池,可支撑 AI 推理、图像智能处理、视频编解码等云侧加速场景,提升云服务响应效率。

- 企业私有超算:面向金融风控建模、智能制造数据分析、自动驾驶仿真测试等企业级场景,可支撑企业自建 GPU 集群,满足定制化高性能计算需求。

4. 部署形态

- 独立 GPU 服务器节点:采用 4U/8U 标准机架式设计,搭载多块 B200 计算模块,典型方案如 DGX H200、HGX B200,可作为独立高性能计算节点部署。

- 超大规模集群机柜:将多个 B200 基座节点通过 InfiniBand/NVLink Switch 高速互联,可构建包含数千 GPU 的 AI 超级集群,满足超大规模算力需求。

- 混合 CPU+GPU 平台:与 Grace CPU Superchip 深度配套,构建统一内存架构的 AI/HPC 融合计算节点,实现 CPU 与 GPU 算力协同调度,提升整体计算效率。

更多有关NVIDIA B200 基座模块技术资讯,请浏览朴实赋能公众号。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)