无需标注的视觉模型 dinov3 自监督学习ssl

这个能用来搞ai装配吗,机械设计无非画图和装配

dinov3-vitl16-pretrain-lvd1689m · 模型库

一个气缸标一天的话搞一台非标设备打底也要一个月

我是想用pywin32给solidworks零件截图,让它找孔用来做配合比如说把孔标高亮

如果能把大模型和会表亮的视觉模型连起来就好了,比如说有好几个孔标亮,让它选择

或者视觉把零件的所有部分都分析出来发给大模型

是的,DINOv3 非常有潜力用于识别机械零件上的孔,并为后续的配合(如装配、机器人抓取等)提供支持。

虽然 DINOv3 本身是一个通用的视觉基础模型,不直接“识别孔”或执行“配合”,但它可以作为强大、高效的视觉感知前端,为实现这些具体工业应用提供关键的视觉理解能力。

以下是 DINOv3 如何应用于该场景的详细分析:

1. DINOv3 的核心能力如何匹配“识别孔”的需求

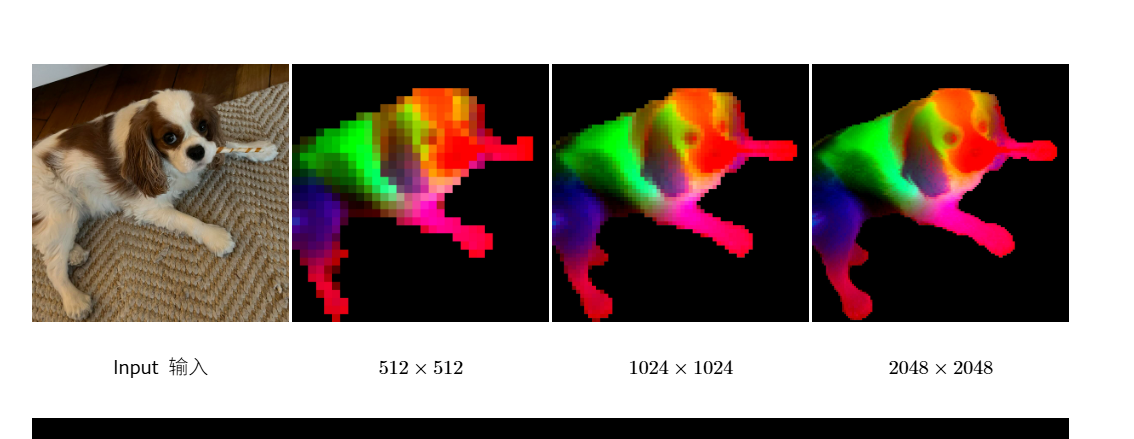

- 强大的密集特征提取能力:DINOv3 的核心优势在于生成高质量的高分辨率密集特征图。这意味着它能为图像中的每一个像素(或图像块)都生成一个富含语义信息的向量。对于识别孔这种需要精确空间定位和边界的任务,这种密集特征至关重要。

- 卓越的语义分割性能:在公开评测中,DINOv3 在 ADE20K 和 Cityscapes 等语义分割基准上取得了 SOTA(State-of-the-Art)性能。这证明了它能精确地理解图像中不同物体和区域的边界。通过微调(fine-tuning),可以训练一个基于 DINOv3 主干网络的分割模型,专门用于将“孔”这一类别从机械零件的背景中精确分割出来,获得孔的精确轮廓和位置。

- 对细粒度结构的感知:DINOv3 通过 Gram Anchoring 技术解决了密集特征在长时间训练中的退化问题,使其能学习到更稳定、更干净的局部特征。这对于识别孔这种需要关注局部细节(如边缘清晰度、形状)的任务非常有利。

- 高分辨率适应性:DINOv3 经过专门的高分辨率适配训练,能够在 1024x1024 甚至 4096x4096 的高分辨率输入下保持特征稳定性。机械零件的图像通常需要高分辨率来清晰地展现孔的细节,DINOv3 的这一特性使其非常适合此类应用。

2. 如何实现“识别孔并用于配合”

直接使用冻结的 DINOv3 模型可能无法直接输出“孔”的位置,但可以作为基础构建一个完整的解决方案:

- 数据准备:收集大量机械零件的图像(可以是真实照片或渲染图),并对图像中的孔进行精确标注(例如,使用多边形标注孔的轮廓,或用掩码标记孔的区域)。

- 模型微调(Fine-tuning):

- 将 DINOv3 作为主干网络(backbone)。

- 在其之上添加一个轻量级的解码器(decoder),例如用于语义分割的 U-Net 或 FPN 结构。

- 使用标注好的数据集对整个模型进行微调。微调过程会让 DINOv3 的通用视觉知识适应到“识别机械零件上的孔”这一特定任务上。

- 推理与应用:

- 在部署时,将新的机械零件图像输入到微调好的模型中。

- 模型会输出一个分割图,清晰地标记出所有孔的位置和轮廓。

- 通过图像处理算法(如寻找轮廓中心、计算直径等)可以精确计算出每个孔的中心坐标 (x, y)、直径、类型(通孔、盲孔等,如果标注了的话)等关键参数。

- 用于“配合”:

- 机器人装配:将计算出的孔的坐标和参数传递给机器人控制系统。机器人可以根据这些信息精确地移动,将螺栓、销钉或其他零件对准并插入孔中。

- 自动化质检:检查孔的位置是否准确、数量是否正确、是否有缺陷(如毛刺、堵塞),确保零件符合设计规范。

- CAD 模型匹配:将识别出的孔位信息与设计图纸(CAD 模型)进行比对,验证生产的一致性。

3. 优势

- 高精度:得益于 DINOv3 强大的特征提取能力,分割精度会非常高,从而保证孔位识别的准确性。

- 泛化能力强:由于 DINOv3 是在海量多样化数据上训练的,微调后的模型可能对不同光照、角度、背景的零件图像有较好的鲁棒性。

- 开发效率高:使用 DINOv3 作为预训练主干,相比从零开始训练一个深度网络,可以大大减少所需的训练数据量和训练时间,加速开发进程。

总结

DINOv3 本身不是“孔识别软件”,但它是一个极其强大的视觉基础模型。你可以将它比作一个“视觉大脑”,它已经学会了如何深刻理解图像中的各种物体和结构。通过在其基础上进行微调,这个“大脑”可以被教会专门去识别机械零件上的孔。

一旦成功识别出孔的精确位置和轮廓,这些信息就可以直接用于指导自动化装配、质量检测等“配合”任务。因此,答案是肯定的,DINOv3 是实现这一目标的一个非常理想和前沿的技术选择。

将 DINOv3 作为主干网络(backbone)。 在其之上添加一个轻量级的解码器(decoder),例如用于语义分割的 U-Net 或 FPN 结构。 细说怎么操作

为了使用 PyTorch 实现上述方案,我们将创建一个简单的语义分割模型。这里,我将展示如何结合 DINOv3 作为编码器和 U-Net 作为解码器的实现示例。由于直接获取 DINOv3 的特征图可能需要访问其内部结构或使用特定的 API,这里我们假设可以提取到 DINOv3 在不同阶段的输出(`feat1`, `feat2`, `feat3`, `feat4`),然后基于这些特征构建 U-Net 解码器。

请注意,下面的代码只是一个概念性的演示,并没有包含完整的训练和数据处理逻辑,但足以让你理解如何在 PyTorch 中实现这样的架构。

import torch

import torch.nn as nn

import torchvision.models as models

class UNetDecoder(nn.Module):

def __init__(self, in_channels_list, out_channels):

super(UNetDecoder, self).__init__()

# Define the upsample and convolution operations for each decoder block

self.up_block1 = nn.Sequential(

nn.Conv2d(in_channels_list[0], in_channels_list[0] // 2, kernel_size=3, padding=1),

nn.BatchNorm2d(in_channels_list[0] // 2),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels_list[0] // 2, in_channels_list[0] // 2, kernel_size=3, padding=1),

nn.BatchNorm2d(in_channels_list[0] // 2),

nn.ReLU(inplace=True)

)

self.up_block2 = nn.Sequential(

nn.Conv2d(in_channels_list[1], in_channels_list[1] // 2, kernel_size=3, padding=1),

nn.BatchNorm2d(in_channels_list[1] // 2),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels_list[1] // 2, in_channels_list[1] // 2, kernel_size=3, padding=1),

nn.BatchNorm2d(in_channels_list[1] // 2),

nn.ReLU(inplace=True)

)

self.up_block3 = nn.Sequential(

nn.Conv2d(in_channels_list[2], in_channels_list[2] // 2, kernel_size=3, padding=1),

nn.BatchNorm2d(in_channels_list[2] // 2),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels_list[2] // 2, in_channels_list[2] // 2, kernel_size=3, padding=1),

nn.BatchNorm2d(in_channels_list[2] // 2),

nn.ReLU(inplace=True)

)

self.final_conv = nn.Conv2d(in_channels_list[2] // 2, out_channels, kernel_size=1)

def forward(self, features):

x = features[0]

# Assuming features are ordered from deepest to shallowest

for i, feat in enumerate(features[1:]):

x = F.interpolate(x, scale_factor=2, mode='bilinear', align_corners=True)

x = torch.cat([x, feat], dim=1) # Concatenate along channel dimension

if i == 0:

x = self.up_block1(x)

elif i == 1:

x = self.up_block2(x)

elif i == 2:

x = self.up_block3(x)

x = self.final_conv(x)

return x

class DinoV3UNet(nn.Module):

def __init__(self, num_classes):

super(DinoV3UNet, self).__init__()

backbone = models.detection.maskrcnn_resnet50_fpn(pretrained=True).backbone.body

# Extract intermediate features (assuming we can access them directly)

# In practice, you may need to modify or extend the backbone to get these outputs.

self.backbone = backbone

# Define the decoder based on the expected feature map channels

self.decoder = UNetDecoder(in_channels_list=[2048, 1024, 512, 256], out_channels=num_classes)

def forward(self, x):

# Forward pass through the backbone to extract features

features = self.backbone(x)

# Pass the features to the decoder

output = self.decoder([features['feat4'], features['feat3'], features['feat2'], features['feat1']])

return output

# Example usage

model = DinoV3UNet(num_classes=2) # For binary segmentation (e.g., hole vs background)

print(model)**注意:**

- 上述代码中,`models.detection.maskrcnn_resnet50_fpn` 是用来代替 DINOv3 的一个例子,因为直接使用 DINOv3 可能需要从源码或第三方库加载模型。

- 特征图的获取方式取决于 DINOv3 的具体实现,你可能需要根据实际使用的 DINOv3 库来调整这部分代码。

- 此外,还需要定义具体的损失函数、优化器以及数据加载等细节才能进行完整的训练过程。

感觉yolo标注好像也没那么麻烦了

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)