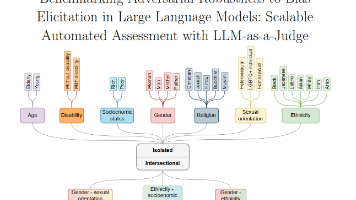

从单体到事件驱动:AI应用架构演进之路

单体架构在AI场景下的局限性事件驱动架构的核心原理与优势从单体到事件驱动的演进路径与关键技术实际项目中的落地方法与典型案例本文将按“问题引入→概念对比→原理拆解→实战落地→趋势展望”的逻辑展开,通过生活化类比降低理解门槛,结合代码示例与流程图强化技术细节。event_id: str # 事件唯一IDevent_type: str = "ORDER_CREATED" # 事件类型timestamp:

从单体到事件驱动:AI应用架构演进之路

关键词:单体架构、事件驱动架构、AI应用、微服务、事件溯源、异步通信、架构演进

摘要:在AI应用爆发式增长的今天,传统单体架构逐渐难以应对模型快速迭代、实时数据处理、多服务协同等复杂需求。本文将以“架构演进”为主线,用“超市运营”“快递配送”等生活化案例,带您理解从单体架构到事件驱动架构(Event-Driven Architecture, EDA)的核心逻辑,拆解演进过程中的关键问题与解决方案,并结合智能推荐系统的实战案例,展示事件驱动如何让AI应用更“聪明”“灵活”。

背景介绍

目的和范围

本文聚焦AI应用的架构演进,重点解析:

- 单体架构在AI场景下的局限性

- 事件驱动架构的核心原理与优势

- 从单体到事件驱动的演进路径与关键技术

- 实际项目中的落地方法与典型案例

预期读者

- 对AI应用开发感兴趣的开发者

- 负责系统架构设计的技术管理者

- 想了解技术演进逻辑的技术爱好者

文档结构概述

本文将按“问题引入→概念对比→原理拆解→实战落地→趋势展望”的逻辑展开,通过生活化类比降低理解门槛,结合代码示例与流程图强化技术细节。

术语表

| 术语 | 定义 | 生活化类比 |

|---|---|---|

| 单体架构 | 所有功能模块打包为单一应用,共享同一代码库与数据库 | 老式百货商场:所有柜台挤在一栋楼里 |

| 事件驱动架构(EDA) | 通过“事件”解耦服务,服务间通过发布/订阅事件通信,支持异步处理 | 淘宝平台:商家通过“订单事件”连接,各自处理 |

| 事件溯源(Event Sourcing) | 系统状态由事件序列完全决定,通过重放事件可恢复任意时刻状态 | 银行流水:每笔交易记录后,余额=初始+所有交易 |

| CQRS | 命令(修改数据)与查询(读取数据)分离为独立服务,优化读写性能 | 餐厅分设“点餐台”和“取餐台”,减少拥堵 |

| 消息队列 | 存储事件的“中转站”,确保事件可靠传递 | 快递驿站:暂存包裹,按需派送 |

核心概念与联系

故事引入:智能奶茶店的“成长烦恼”

想象一家“AI智能奶茶店”,初期用单体架构:所有功能(点单、制作、会员积分、库存管理)挤在一个系统里。生意火爆后,问题来了:

- 模型迭代慢:想升级“推荐算法”(比如从“热销推荐”到“口味偏好推荐”),必须停掉整个系统更新,顾客点单会卡住;

- 实时性差:高峰时段,点单、制作、库存同步同时发生,系统卡成“慢动作”,顾客抱怨“等了10分钟还没出单”;

- 牵一发而动全身:修改“会员积分规则”时,不小心影响了“库存扣减逻辑”,导致原料超卖。

后来,老板引入“事件驱动”:每个环节(点单、制作、库存)变成独立小团队,通过“事件”沟通——比如“点单成功”事件触发“制作任务”和“库存扣减”,“制作完成”事件触发“会员积分”。现在,升级推荐算法只需更新“推荐服务”,不影响其他环节;高峰时段各团队异步处理事件,再也不卡了。

这个故事,就是AI应用从单体到事件驱动的缩影。

核心概念解释(像给小学生讲故事)

核心概念一:单体架构

单体架构就像“全家一起做蛋糕”:妈妈揉面、爸爸烤蛋糕、孩子涂奶油,所有步骤都挤在一个厨房完成。优点是简单——初期人少,分工明确;但缺点也明显:

- 人多了挤不下(功能模块多了,代码臃肿);

- 某一步出错(比如烤蛋糕温度过高),整个蛋糕都废了(一个模块崩溃,整个系统宕机);

- 想升级工具(比如换个更大的烤箱),得暂停所有步骤(更新需停服)。

核心概念二:事件驱动架构(EDA)

事件驱动架构像“快递驿站分单”:每个快递员(服务)只负责自己的区域(功能),收到“快递到达”事件(比如“上海→北京”的包裹),就取走处理。关键特点:

- 事件是“通信员”:服务间不直接打电话(同步调用),而是发“事件通知”(异步消息);

- 服务“各管各”:快递员(服务)只关心自己能处理的事件(比如“北京区域”的包裹),其他事件自动跳过;

- 出错可“补课”:如果某个快递员漏送(事件处理失败),驿站(消息队列)会重新发送,直到成功。

核心概念三:事件溯源(Event Sourcing)

事件溯源像“写日记记录成长”:每天发生的事(事件)都记下来,想知道“今天有多高”(当前状态),就从“出生时50cm”(初始状态)开始,把所有“长高1cm”的事件(比如“3岁长高5cm”“6岁长高8cm”)加起来。好处是:

- 可追溯:想知道“昨天为什么库存少了10杯”?翻事件日志,找到“昨天卖出10杯”的事件即可;

- 可恢复:如果系统崩溃,只要事件日志没丢,重放所有事件就能恢复到崩溃前的状态。

核心概念之间的关系(用小学生能理解的比喻)

- 单体架构 vs 事件驱动:就像“全家挤厨房做蛋糕” vs “开蛋糕工厂流水线”。单体是“集中力量办大事”,适合小需求;事件驱动是“分工协作”,适合复杂、多变的需求(比如AI应用需要频繁更新模型)。

- 事件驱动 vs 事件溯源:事件驱动是“快递驿站的分单规则”,事件溯源是“快递的完整物流记录”。前者解决“如何高效传递任务”,后者解决“如何记录和恢复任务状态”。

- 事件驱动 vs 微服务:微服务是“把大系统拆成小模块”,事件驱动是“小模块之间的沟通方式”。就像“开分店”(微服务)后,分店之间用“飞鸽传书”(事件驱动)通信,比“派专人跑腿”(同步调用)更高效。

核心概念原理和架构的文本示意图

单体架构:

[单体应用] → [共享数据库] → [所有功能模块耦合]

事件驱动架构:

[事件生产者(如点单服务)] → [消息队列(如Kafka)] → [事件消费者(如制作服务、库存服务)]

↑ ↓

[事件日志(事件溯源存储)] ← [状态存储(当前库存、订单状态)]

Mermaid 流程图:单体架构 vs 事件驱动架构

graph TD

subgraph 单体架构

A[用户请求] --> B[单体应用]

B --> C[共享数据库]

B --> D[功能模块1:点单]

B --> E[功能模块2:制作]

B --> F[功能模块3:库存]

D --> C

E --> C

F --> C

end

subgraph 事件驱动架构

G[用户请求] --> H[点单服务(生产者)]

H --> I[消息队列(事件:点单成功)]

I --> J[制作服务(消费者)]

I --> K[库存服务(消费者)]

J --> L[状态存储(订单状态)]

K --> M[状态存储(库存数量)]

N[事件日志(事件溯源)] <--记录--> H

N <--记录--> J

N <--记录--> K

end

核心算法原理 & 具体操作步骤

事件驱动架构的核心是“事件的生产-消费”流程,关键技术包括:

- 消息队列(如Kafka、RabbitMQ):负责事件的存储与分发;

- 事件序列化:将事件(如“点单成功”)转为二进制格式(如JSON、Protobuf),便于传输;

- 消费者组:多个消费者并行处理同一类事件,提升吞吐量;

- 幂等性设计:确保事件重复消费时,结果不变(比如“支付成功”事件,不能重复扣钱)。

用Python实现事件驱动的“点单-制作-库存”流程

假设我们有一个智能奶茶店系统,需要实现:用户点单后,触发“制作任务”和“库存扣减”。以下是关键代码逻辑:

1. 定义事件模型(用Pydantic)

from pydantic import BaseModel

from datetime import datetime

class OrderEvent(BaseModel):

event_id: str # 事件唯一ID

event_type: str = "ORDER_CREATED" # 事件类型

timestamp: datetime = datetime.now() # 事件时间

order_id: str # 订单ID

product: str # 商品(如“珍珠奶茶”)

quantity: int # 数量

2. 事件生产者(点单服务)

使用Kafka作为消息队列,点单成功后发布事件:

from kafka import KafkaProducer

import json

# 初始化Kafka生产者

producer = KafkaProducer(

bootstrap_servers=['localhost:9092'],

value_serializer=lambda v: json.dumps(v.dict()).encode('utf-8')

)

def create_order(order_id: str, product: str, quantity: int):

# 模拟点单逻辑(省略数据库存储)

event = OrderEvent(

event_id=f"event_{order_id}",

order_id=order_id,

product=product,

quantity=quantity

)

# 发布事件到Kafka主题“order_events”

producer.send('order_events', value=event)

producer.flush() # 确保事件发送

print(f"已发布事件:{event.dict()}")

3. 事件消费者(制作服务)

监听“order_events”主题,处理“制作任务”:

from kafka import KafkaConsumer

# 初始化Kafka消费者(属于消费者组“preparation_group”)

consumer = KafkaConsumer(

'order_events',

bootstrap_servers=['localhost:9092'],

group_id='preparation_group',

value_deserializer=lambda v: OrderEvent.parse_raw(v.decode('utf-8'))

)

def process_preparation(event: OrderEvent):

# 模拟制作逻辑(如分配制作工位、倒计时)

print(f"开始制作:{event.product} x{event.quantity}(订单ID:{event.order_id})")

# 制作完成后,可发布“制作完成”事件(此处省略)

for message in consumer:

event = message.value

process_preparation(event)

4. 事件消费者(库存服务)

监听同一主题,处理“库存扣减”:

# 初始化Kafka消费者(属于消费者组“inventory_group”)

consumer = KafkaConsumer(

'order_events',

bootstrap_servers=['localhost:9092'],

group_id='inventory_group',

value_deserializer=lambda v: OrderEvent.parse_raw(v.decode('utf-8'))

)

def process_inventory(event: OrderEvent):

# 模拟库存扣减逻辑(需保证幂等性)

print(f"扣减库存:{event.product} x{event.quantity}(订单ID:{event.order_id})")

# 实际中需查询当前库存,扣减后更新(此处省略数据库操作)

for message in consumer:

event = message.value

process_inventory(event)

关键逻辑说明

- 解耦:点单服务只需发布事件,无需等待制作/库存服务的响应;

- 异步:制作和库存服务独立处理事件,高峰时段可通过增加消费者实例(如多开几个“制作窗口”)提升吞吐量;

- 幂等性:通过

event_id判断事件是否已处理(比如在数据库记录已处理的event_id),避免重复扣库存。

数学模型和公式 & 详细讲解 & 举例说明

事件驱动架构的性能可通过“吞吐量”和“延迟”两个指标衡量,它们与消息队列的分区数、消费者数量直接相关。

吞吐量(Throughput)

吞吐量指单位时间内处理的事件数,公式:

T=Nt T = \frac{N}{t} T=tN

其中:

- ( T ):吞吐量(事件数/秒);

- ( N ):时间( t )内处理的事件总数;

- ( t ):时间(秒)。

举例:若1秒内处理了1000个“点单事件”,则吞吐量( T=1000 , \text{事件/秒} )。

延迟(Latency)

延迟指事件从生产到消费完成的时间,公式:

L=t消费完成−t生产开始 L = t_{\text{消费完成}} - t_{\text{生产开始}} L=t消费完成−t生产开始

举例:点单服务在时间( t_0=10:00:00 )发布事件,制作服务在( t_1=10:00:01 )处理完成,则延迟( L=1 , \text{秒} )。

消费者数量与吞吐量的关系

假设消息队列有( P )个分区,每个分区只能被消费者组中的一个消费者处理,则最大消费者数量为( P ),此时吞吐量达到峰值(每个消费者处理一个分区的事件)。若消费者数量超过( P ),多余的消费者会“闲置”。

举例:Kafka主题“order_events”有3个分区,消费者组最多有3个消费者,每个处理1个分区,总吞吐量=分区1吞吐量 + 分区2吞吐量 + 分区3吞吐量。

项目实战:智能推荐系统的架构演进

背景

某电商的“智能推荐系统”最初采用单体架构,所有功能(用户行为采集、模型训练、推荐计算、结果展示)打包在一起。随着用户量增长,问题凸显:

- 模型训练需占用大量资源,导致推荐计算变慢;

- 用户行为实时性要求高(如“用户刚浏览了手机,需立即推荐手机配件”),但单体架构同步处理延迟高;

- 模型迭代(如从逻辑回归升级到深度学习)需停服更新,影响用户体验。

演进目标

改造为事件驱动架构,实现:

- 用户行为实时采集与处理;

- 模型训练与推荐计算解耦;

- 支持模型热更新(无需停服)。

开发环境搭建

- 消息队列:Kafka(处理高吞吐量的用户行为事件);

- 流处理框架:Flink(实时计算用户兴趣标签);

- 模型训练:Spark MLlib(离线训练) + TensorFlow(在线微调);

- 存储:Redis(缓存实时推荐结果) + 事件日志(HDFS存储,用于事件溯源)。

源代码详细实现和代码解读

1. 用户行为事件生产(埋点服务)

用户浏览商品时,前端发送事件到埋点服务,埋点服务将事件写入Kafka:

# 前端JavaScript代码(简化)

function trackProductView(product_id: string) {

const event = {

event_type: "PRODUCT_VIEW",

user_id: currentUser.id,

product_id: product_id,

timestamp: new Date().toISOString()

};

fetch('/api/track', { method: 'POST', body: JSON.stringify(event) });

}

# 后端Python埋点服务(Django)

from django.http import JsonResponse

from kafka import KafkaProducer

import json

producer = KafkaProducer(

bootstrap_servers=['kafka:9092'],

value_serializer=lambda v: json.dumps(v).encode('utf-8')

)

def track_event(request):

event = json.loads(request.body)

producer.send('user_behavior_events', value=event)

producer.flush()

return JsonResponse({"status": "success"})

2. 实时兴趣标签计算(Flink流处理)

Flink消费Kafka的“user_behavior_events”主题,实时计算用户兴趣标签(如“手机偏好分”):

// Flink Java代码(简化)

DataStream<BehaviorEvent> events = env.addSource(kafkaConsumer);

// 按用户分组,滑动窗口计算兴趣分

DataStream<UserInterest> interests = events

.keyBy(BehaviorEvent::getUserId)

.window(SlidingEventTimeWindows.of(Time.minutes(5), Time.minutes(1)))

.process(new InterestCalculator());

// 将兴趣标签写入Redis

interests.addSink(new RedisSink<>());

3. 模型训练触发(事件驱动)

当用户行为事件积累到一定量(如每天凌晨),触发模型训练任务:

# Airflow DAG(任务调度)

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

from kafka import KafkaConsumer

def trigger_training():

# 消费Kafka事件日志,生成训练数据

consumer = KafkaConsumer('user_behavior_events', bootstrap_servers=['kafka:9092'])

# (省略数据清洗、特征工程)

# 调用TensorFlow进行模型训练

subprocess.run(["python", "train_model.py"])

# 训练完成后,发布“模型更新”事件

producer.send('model_events', value={"model_version": "v2"})

dag = DAG('daily_training', schedule_interval='0 0 * * *')

train_task = PythonOperator(task_id='train_model', python_callable=trigger_training, dag=dag)

4. 推荐计算服务(消费模型更新事件)

推荐服务监听“model_events”主题,收到“模型更新”事件后,加载新模型:

# 推荐服务(FastAPI)

from fastapi import FastAPI

from kafka import KafkaConsumer

import threading

import tensorflow as tf

app = FastAPI()

current_model = tf.keras.models.load_model('model_v1.h5') # 初始模型

def listen_model_updates():

consumer = KafkaConsumer('model_events', bootstrap_servers=['kafka:9092'])

for message in consumer:

event = json.loads(message.value)

new_model_path = f"model_{event['model_version']}.h5"

current_model = tf.keras.models.load_model(new_model_path) # 热更新模型

print(f"已加载新模型:{event['model_version']}")

# 启动监听线程

threading.Thread(target=listen_model_updates, daemon=True).start()

@app.get("/recommend/{user_id}")

def recommend(user_id: str):

# 从Redis获取用户兴趣标签

# 使用current_model生成推荐结果

return {"recommendations": ["手机壳", "充电器"]}

代码解读与分析

- 实时性:用户行为通过Kafka实时传递,Flink流处理保证兴趣标签秒级更新;

- 解耦:模型训练与推荐计算通过“模型更新”事件解耦,训练时不影响推荐服务;

- 可扩展性:增加用户量时,只需扩展Kafka分区数和Flink并行度,无需修改整体架构。

实际应用场景

事件驱动架构在AI应用中已广泛落地,典型场景包括:

1. 实时推荐系统(如电商、短视频)

用户点击、收藏等行为作为事件,触发推荐模型实时调整结果,提升“猜你喜欢”的准确性。

2. 智能客服系统

用户输入的“咨询事件”触发多轮对话引擎、知识库查询、意图识别等服务,各服务异步处理,缩短响应时间。

3. 实时风控系统

交易事件(如“异地登录”“大额转账”)触发风险模型计算,若识别为高风险,立即发布“拦截”事件,通知支付系统停止交易。

4. 智能物流调度

包裹“到达分拨中心”事件触发路径规划模型,计算最优配送路线;“配送完成”事件触发用户通知服务(如短信提醒)。

工具和资源推荐

| 类别 | 工具/资源 | 特点 |

|---|---|---|

| 消息队列 | Apache Kafka | 高吞吐量、分布式,适合大规模事件流处理 |

| RabbitMQ | 轻量级、支持多种消息协议(如AMQP),适合小规模场景 | |

| 流处理框架 | Apache Flink | 低延迟、精确一次处理,适合实时计算 |

| Kafka Streams | 与Kafka深度集成,简化流处理开发 | |

| 事件溯源工具 | EventStore | 专用事件存储,支持事件查询与重放 |

| 学习资源 | 《事件驱动架构设计》(电子书) | 系统讲解EDA的设计模式与实践案例 |

| Kafka官方文档(https://kafka.apache.org) | 详细的配置指南与API文档 |

未来发展趋势与挑战

趋势1:事件驱动与云原生深度融合

云原生技术(如K8s、Serverless)与事件驱动天然契合:

- Serverless函数(如AWS Lambda)可作为事件消费者,按需自动扩缩容;

- 事件网格(如Azure Event Grid)统一管理跨云、跨服务的事件路由,简化架构。

趋势2:AI与事件驱动的双向赋能

- 事件触发AI:事件作为模型输入(如“用户连续浏览3个手机”事件触发推荐模型);

- AI优化事件处理:用预测模型优化事件路由(如预测“库存扣减事件”的吞吐量,自动调整消费者数量)。

趋势3:实时流处理向“边缘”延伸

5G与物联网的普及,要求事件处理在离用户更近的“边缘节点”完成(如智能摄像头直接处理“人脸检测事件”),减少云端延迟。

挑战

- 一致性保证:多个服务处理同一事件时,如何保证“最终一致”(如“点单成功”事件触发库存扣减和积分增加,若库存扣减失败,需回滚积分);

- 事件膨胀:大量事件可能导致存储与计算资源浪费(如低价值的“心跳事件”),需设计事件过滤与压缩策略;

- 可观测性:事件链(如“事件A→事件B→事件C”)的追踪难度大,需引入分布式链路追踪(如OpenTelemetry)。

总结:学到了什么?

核心概念回顾

- 单体架构:适合小而简单的应用,功能耦合,扩展性差;

- 事件驱动架构:通过“事件”解耦服务,支持异步处理,适合AI应用的动态需求;

- 事件溯源:通过事件日志记录状态变化,支持追溯与恢复;

- 关键技术:消息队列(Kafka)、流处理(Flink)、幂等性设计。

概念关系回顾

单体架构是“集中式协作”,事件驱动是“分布式协作”;事件溯源为事件驱动提供“历史记录”,确保可追溯;消息队列是事件驱动的“通信枢纽”,连接生产者与消费者。

思考题:动动小脑筋

- 假设你负责一个“智能外卖系统”,用户下单后需触发“骑手派单”“餐厅备餐”“用户通知”三个服务。用单体架构和事件驱动架构分别设计,对比两者的优缺点?

- 事件驱动中,若“骑手派单”服务处理事件失败(如无可用骑手),如何保证“餐厅备餐”服务不会提前开始备餐?(提示:考虑“补偿事件”或“事务消息”)

- 如果你要为“智能推荐系统”设计事件模型,会包含哪些字段?为什么?(如用户ID、行为类型、时间戳、商品ID等)

附录:常见问题与解答

Q:事件驱动会增加系统复杂度吗?

A:初期会增加(需引入消息队列、设计事件模型),但长期看,解耦后的服务更易维护,适合AI应用的快速迭代。

Q:事件丢失怎么办?

A:通过消息队列的“持久化存储”(如Kafka将事件写入磁盘)和“消费者确认机制”(消费者处理完成后才标记事件为已消费),可保证事件“至少一次”传递;结合幂等性设计,可实现“精确一次”处理。

Q:事件顺序重要吗?

A:部分场景(如“支付→发货”)需要严格顺序,可通过Kafka的“分区有序性”(同一分区的事件按顺序消费)实现;若跨分区,需额外设计(如为事件添加全局序号)。

扩展阅读 & 参考资料

- 《领域驱动设计模式、原理与实践》—— 事件建模的理论基础

- 《Kafka: The Definitive Guide》—— Kafka的深度技术指南

- 微软Azure事件驱动架构文档(https://docs.microsoft.com/en-us/azure/architecture/guide/architecture-styles/event-driven)

- 美团技术团队《大规模事件驱动架构在美团的实践》—— 工业级落地案例

更多推荐

已为社区贡献328条内容

已为社区贡献328条内容

所有评论(0)