AI应用架构师必看!AI系统合规的7个关键技术,从数据到模型全覆盖

1. 定义基础模型# 2. 配置差分隐私优化器l2_norm_clip=1.0, # 梯度剪辑:控制每个微批次的梯度大小(避免噪声被放大)noise_multiplier=1.1, # 噪声乘数:越大隐私保护越强(ε越小)num_microbatches=32, # 微批次数量:将大批次拆分成小批次,计算噪声# 3. 编译模型(使用差分隐私优化器)"""生成FGSM对抗样本"""image.req

AI应用架构师必看!AI系统合规的7个关键技术,从数据到模型全覆盖

摘要/引言

当你作为AI应用架构师,盯着屏幕上的模型部署报告时,有没有突然冒出过这些疑问:

- 我们的用户数据处理符合GDPR的“被遗忘权”吗?

- 贷款审批模型会不会因为性别偏见被监管约谈?

- 当用户问“为什么拒绝我的申请”时,我们能给出清晰的模型决策理由吗?

在欧盟AI法案(2024年生效)、中国《生成式AI服务管理暂行办法》等法规的强约束下,AI合规早已不是“法务的事”,而是架构师必须嵌入系统全生命周期的技术工程。传统的“事后审计”模式根本无法应对AI系统的动态性——模型漂移会让原本合规的系统突然“失控”,数据重识别攻击能轻松击穿“匿名化”的伪装。

本文将为你提供一套可落地的AI合规技术框架,覆盖从数据采集到模型部署监控的全流程,聚焦7个架构师必须掌握的关键技术:

- 数据隐私保护:用差分隐私抵御重识别攻击

- 模型公平性治理:用偏见检测与修正消除歧视

- 模型可解释性:用“全局+局部”解释满足决策知情权

- 模型鲁棒性增强:用对抗训练抵御异常输入

- 可审计性设计:用MLOps实现全生命周期追踪

- 动态合规监控:用实时系统预警风险

- 版本管理与回滚:让合规状态“可逆”

读完本文,你将能:

- 把合规要求转化为可执行的技术方案

- 解决“数据隐私与模型精度”“公平性与性能”的权衡问题

- 构建“能解释、可审计、抗攻击”的合规AI系统

目标读者与前置知识

目标读者

本文面向AI应用架构师(或负责AI系统设计的技术负责人),需要你具备:

- 熟悉AI系统全生命周期(数据采集→训练→部署→监控)

- 掌握机器学习基础(分类/回归模型、损失函数、梯度下降)

- 了解Python生态工具(Pandas、TensorFlow/PyTorch)

- 对MLOps有基本认知(模型版本管理、监控)

前置知识

无需深入的密码学或法律知识,但建议提前了解:

- 隐私保护核心概念(匿名化、重识别、差分隐私)

- 公平性指标(如DI Ratio、Equalized Odds)

- 可解释性工具(SHAP、LIME)

文章目录

- 引言与基础

- 问题背景:为什么AI合规需要“技术驱动”?

- 核心概念:AI合规的7个技术维度

- 环境准备:合规技术栈的安装与配置

- 关键技术1:数据隐私保护——差分隐私的落地

- 关键技术2:模型公平性——用Fairlearn消除偏见

- 关键技术3:可解释性——SHAP与LIME的组合拳

- 关键技术4:鲁棒性——对抗训练抵御攻击

- 关键技术5:可审计性——MLflow追踪全生命周期

- 关键技术6:动态监控——Prometheus预警合规风险

- 关键技术7:版本管理——MLflow实现可逆合规

- 性能优化与最佳实践

- 常见问题与解决方案

- 总结与未来展望

一、问题背景:为什么AI合规需要“技术驱动”?

1.1 传统合规的局限性

过去,企业的合规靠“事后审计”:法务部门定期检查数据日志、模型文档,确认是否符合法规。但AI系统的动态性让这种模式失效:

- 数据层面:匿名化的数据结合外部公开数据(如社交网络)可重识别(例如,Netflix的匿名观影数据被结合IMDB数据破解)。

- 模型层面:模型漂移(Concept Drift)会让原本公平的模型变得歧视(比如推荐系统随着用户行为变化,开始歧视老年群体)。

- 部署层面:对抗攻击能让模型做出致命错误(比如给停止标志贴个贴纸,自动驾驶模型就把它识别成限速标志)。

1.2 合规的“技术左移”趋势

监管要求已经从“事后追责”转向“事前预防”。例如:

- 欧盟AI法案要求“高风险AI系统”必须具备可解释性(能说明决策理由)、公平性(无歧视)、鲁棒性(抗攻击)。

- 中国《生成式AI服务管理暂行办法》要求“采取有效措施防范虚假信息、个人隐私、意识形态安全等风险”。

结论:架构师必须将合规要求嵌入AI系统的设计阶段,用技术手段实现“隐私保护、公平性、可解释性、鲁棒性”的自动化保障。

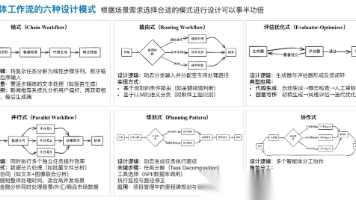

二、核心概念:AI合规的7个技术维度

在开始技术实现前,先统一认知:AI合规的核心是保障“人”的权益,对应以下7个技术维度(与本文的7个关键技术一一对应):

| 合规维度 | 监管要求 | 技术目标 |

|---|---|---|

| 数据隐私 | 不泄露个体数据(GDPR的“被遗忘权”) | 即使数据泄露,也无法识别具体个体 |

| 模型公平性 | 无性别/种族歧视(AI法案的“非歧视性”) | 不同群体的模型性能一致 |

| 可解释性 | 向用户说明决策理由(AI法案的“透明性”) | 能回答“为什么拒绝我的申请” |

| 鲁棒性 | 应对异常输入(AI法案的“安全性”) | 不会因小扰动做出错误决策 |

| 可审计性 | 追踪全流程(GDPR的“可追溯性”) | 能还原模型的“数据来源→训练参数→部署版本” |

| 动态监控 | 实时预警风险(生成式AI管理办法) | 发现模型漂移或违规行为时立即报警 |

| 版本管理 | 快速回滚违规版本(AI法案的“可逆性”) | 出现合规问题时,能恢复到之前的安全状态 |

三、环境准备:合规技术栈的安装与配置

我们将使用Python生态的合规工具链,先安装依赖:

1. 基础库安装

# 数据处理与模型训练

pip install pandas numpy tensorflow torch

# 合规工具

pip install tensorflow-privacy # 差分隐私

pip install fairlearn shap lime # 公平性与可解释性

pip install mlflow # 模型管理与审计

pip install prometheus_client # 监控

2. 配置文件

创建requirements.txt方便复现:

pandas==1.5.3

numpy==1.24.3

tensorflow==2.12.0

torch==2.0.1

tensorflow-privacy==0.8.0

fairlearn==0.7.0

shap==0.41.0

lime==0.2.0.1

mlflow==2.3.2

prometheus_client==0.17.0

3. 验证环境

运行以下代码,确认工具安装成功:

import tensorflow_privacy

import fairlearn

import shap

import mlflow

print("TensorFlow Privacy版本:", tensorflow_privacy.__version__)

print("Fairlearn版本:", fairlearn.__version__)

print("SHAP版本:", shap.__version__)

print("MLflow版本:", mlflow.__version__)

四、关键技术1:数据隐私保护——差分隐私的落地

4.1 问题场景

你需要用医院的糖尿病患者数据训练预测模型,但GDPR要求“不能泄露任何患者的个人信息”。传统的“匿名化”(删除姓名、身份证号)不够——攻击者可以结合“年龄+性别+住院时间”等公开数据,重识别出具体患者(这就是“链接攻击”)。

4.2 技术方案:差分隐私(Differential Privacy)

差分隐私的核心思想是:给数据或模型添加“可控噪声”,让攻击者无法确定“某个个体是否在训练数据中”。它通过两个参数控制隐私保护强度:

- ε(隐私预算):ε越小,隐私保护越强,但模型精度越低(通常取1~10)。

- δ(失败概率):δ是“隐私保护失效”的概率(通常取1e-5)。

4.3 代码实现:用TensorFlow Privacy处理训练数据

我们以“糖尿病预测模型”为例,用差分隐私优化器训练模型:

步骤1:加载数据

import pandas as pd

from sklearn.model_selection import train_test_split

# 加载糖尿病数据集(来自sklearn)

from sklearn.datasets import load_diabetes

data = load_diabetes()

X = pd.DataFrame(data.data, columns=data.feature_names)

y = pd.Series(data.target)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

步骤2:定义差分隐私优化器

from tensorflow.keras import layers, Model

from tensorflow_privacy.privacy.optimizers.dp_optimizer import DPGradientDescentGaussianOptimizer

# 1. 定义基础模型

input_layer = layers.Input(shape=(X_train.shape[1],))

dense1 = layers.Dense(64, activation='relu')(input_layer)

output_layer = layers.Dense(1)(dense1)

model = Model(inputs=input_layer, outputs=output_layer)

# 2. 配置差分隐私优化器

dp_optimizer = DPGradientDescentGaussianOptimizer(

l2_norm_clip=1.0, # 梯度剪辑:控制每个微批次的梯度大小(避免噪声被放大)

noise_multiplier=1.1, # 噪声乘数:越大隐私保护越强(ε越小)

num_microbatches=32, # 微批次数量:将大批次拆分成小批次,计算噪声

learning_rate=0.01

)

# 3. 编译模型(使用差分隐私优化器)

loss = tf.keras.losses.MeanSquaredError()

model.compile(optimizer=dp_optimizer, loss=loss)

步骤3:训练与评估

model.fit(X_train, y_train, epochs=100, batch_size=32)

# 评估模型精度与隐私保护强度

test_loss = model.evaluate(X_test, y_test)

print(f"测试集损失: {test_loss:.2f}")

print(f"隐私预算ε: {dp_optimizer.privacy_accountant.get_epsilon(delta=1e-5):.2f}")

4.4 关键细节:参数的权衡

- l2_norm_clip:如果设置太小(如0.5),会导致梯度信息丢失,模型精度下降;设置太大(如2.0),则隐私保护不足。

- noise_multiplier:与ε成反比(noise_multiplier越大,ε越小)。例如,noise_multiplier=1.1对应ε≈3.0(平衡隐私与精度)。

- num_microbatches:建议等于批次大小(如batch_size=32,则num_microbatches=32),否则会降低隐私保护效果。

五、关键技术2:模型公平性——用Fairlearn消除偏见

5.1 问题场景

你设计了一个贷款审批模型,发现模型对女性的拒绝率比男性高20%(这违反了“公平信贷”的要求)。原因可能是训练数据中“女性的平均收入低于男性”,模型学到了这种偏见。

5.2 技术方案:Fairlearn的“检测→修正”流程

Fairlearn是微软开源的公平性工具,核心功能:

- 偏见检测:用

MetricFrame计算不同群体的性能差异(如准确率、假阳性率)。 - 偏见修正:用

Reduction或AdversarialDebiasing算法,在保持模型精度的同时消除偏见。

5.3 代码实现:修正贷款模型的性别偏见

步骤1:加载带敏感属性的数据集

import pandas as pd

from sklearn.ensemble import RandomForestClassifier

from fairlearn.metrics import MetricFrame, accuracy_score, false_positive_rate

from fairlearn.reductions import ExponentiatedGradient, DemographicParity

# 加载贷款数据集(包含“性别”敏感属性)

data = pd.read_csv("loan_data.csv")

X = data.drop(["loan_approved", "gender"], axis=1) # 特征:收入、信用评分等

y = data["loan_approved"] # 标签:1=批准,0=拒绝

sensitive_features = data["gender"] # 敏感属性:0=男性,1=女性

步骤2:检测偏见

# 训练一个未修正的基准模型

baseline_model = RandomForestClassifier(n_estimators=100)

baseline_model.fit(X, y)

# 计算不同性别的性能指标

y_pred = baseline_model.predict(X)

metrics = MetricFrame(

metrics={

"accuracy": accuracy_score,

"false_positive_rate": false_positive_rate

},

y_true=y,

y_pred=y_pred,

sensitive_features=sensitive_features

)

# 打印结果(假设女性的FPR比男性高20%)

print("基准模型性能:")

print(metrics.by_group)

步骤3:修正偏见

我们用ExponentiatedGradient算法,目标是在保持精度的同时,让不同性别的假阳性率一致:

# 1. 定义公平性约束(人口 parity:不同群体的预测阳性率一致)

constraint = DemographicParity()

# 2. 用ExponentiatedGradient修正模型

mitigator = ExponentiatedGradient(

estimator=RandomForestClassifier(n_estimators=100),

constraints=constraint,

max_iter=50 # 迭代次数:越多修正效果越好,但训练时间越长

)

# 3. 训练修正后的模型

mitigator.fit(X, y, sensitive_features=sensitive_features)

# 4. 评估修正后的性能

y_pred_mitigated = mitigator.predict(X)

metrics_mitigated = MetricFrame(

metrics={

"accuracy": accuracy_score,

"false_positive_rate": false_positive_rate

},

y_true=y,

y_pred=y_pred_mitigated,

sensitive_features=sensitive_features

)

print("\n修正后模型性能:")

print(metrics_mitigated.by_group)

5.4 关键细节:公平性与精度的权衡

- 约束选择:

DemographicParity(人口 parity)要求不同群体的预测阳性率一致;EqualizedOdds要求不同群体的真阳性率/假阳性率一致(更严格)。 - 迭代次数:

max_iter设置为50通常足够,若修正效果不佳可增加到100,但会延长训练时间。 - 精度损失:修正后的模型精度可能下降(如从85%降到82%),但这是合规的必要代价。

六、关键技术3:可解释性——SHAP与LIME的组合拳

6.1 问题场景

用户申请信用卡被拒绝,要求你解释“为什么拒绝我”。你需要给出具体的特征贡献(比如“最近3个月的消费次数是平均水平的2倍”),而不是“模型认为你有风险”这种模糊回答。

6.2 技术方案:全局+局部解释

可解释性分为两类:

- 全局解释:说明模型的整体行为(如“信用评分是影响审批的最关键因素”)。

- 局部解释:说明单个决策的理由(如“你的消费次数过多导致被拒绝”)。

我们用SHAP做全局解释,LIME做局部解释。

6.3 代码实现:解释信用卡欺诈检测模型

步骤1:加载模型与数据

import shap

import lime

import lime.lime_tabular

from sklearn.ensemble import RandomForestClassifier

# 加载欺诈检测数据集(特征:消费金额、次数、地点等)

data = pd.read_csv("fraud_data.csv")

X = data.drop("is_fraud", axis=1)

y = data["is_fraud"]

# 训练模型

model = RandomForestClassifier(n_estimators=100)

model.fit(X, y)

步骤2:全局解释(SHAP)

# 初始化SHAP解释器(针对树模型优化)

explainer = shap.TreeExplainer(model)

shap_values = explainer.shap_values(X)

# 1. 全局特征重要性(所有样本的平均SHAP值)

shap.summary_plot(shap_values[1], X, title="全局特征重要性")

# 2. 单个特征的影响(如“消费次数”对欺诈的影响)

shap.dependence_plot("transaction_count", shap_values[1], X, interaction_index="amount")

步骤3:局部解释(LIME)

# 初始化LIME解释器

lime_explainer = lime.lime_tabular.LimeTabularExplainer(

X.values,

mode="classification",

feature_names=X.columns,

class_names=["正常", "欺诈"]

)

# 选择一个被预测为欺诈的样本(索引为100)

sample_idx = 100

sample = X.iloc[sample_idx]

# 生成局部解释

explanation = lime_explainer.explain_instance(

sample.values,

model.predict_proba,

num_features=5 # 展示Top5影响特征

)

# 可视化解释(会生成HTML页面)

explanation.show_in_notebook(show_table=True)

6.4 关键细节:工具的选择

- SHAP:适合树模型(RandomForest、XGBoost),计算速度快,全局解释更准确;但对神经网络的支持较差(需要用

DeepExplainer)。 - LIME:适合所有模型(包括神经网络),局部解释更直观;但全局解释能力弱,结果有随机性(需多次运行取平均)。

- 最佳实践:用SHAP做全局特征分析,用LIME生成用户级的解释报告。

七、关键技术4:模型鲁棒性增强——用对抗训练抵御攻击

7.1 问题场景

你开发了一个自动驾驶的交通标志识别模型,攻击者在停止标志上贴了一个小贴纸,导致模型把它识别成限速标志(这会引发安全事故)。这种“对抗攻击”是AI合规的重大风险——模型必须能应对小扰动。

7.2 技术方案:对抗训练(Adversarial Training)

对抗训练的核心是:用对抗样本(添加小噪声的输入)训练模型,让模型学会“忽略”扰动。常见的对抗样本生成方法有FGSM(Fast Gradient Sign Method)和PGD(Projected Gradient Descent)。

7.3 代码实现:用FGSM增强模型鲁棒性

步骤1:定义FGSM攻击函数

import torch

import torch.nn.functional as F

def fgsm_attack(model, image, label, epsilon=0.01):

"""生成FGSM对抗样本"""

image.requires_grad = True # 计算梯度

output = model(image)

loss = F.cross_entropy(output, label)

model.zero_grad()

loss.backward() # 反向传播计算梯度

# 沿梯度方向添加噪声

perturbed_image = image + epsilon * image.grad.sign()

# 裁剪到[0,1]范围(保持图像有效性)

perturbed_image = torch.clamp(perturbed_image, 0, 1)

return perturbed_image

步骤2:对抗训练流程

from torch.utils.data import DataLoader

from torchvision.datasets import GTSRB # 交通标志数据集

from torchvision.transforms import ToTensor

# 1. 加载数据

train_data = GTSRB(

root="./data",

split="train",

download=True,

transform=ToTensor()

)

train_loader = DataLoader(train_data, batch_size=32, shuffle=True)

# 2. 定义模型(简单的CNN)

class TrafficSignModel(torch.nn.Module):

def __init__(self):

super().__init__()

self.conv1 = torch.nn.Conv2d(3, 16, kernel_size=3, padding=1)

self.pool = torch.nn.MaxPool2d(2, 2)

self.fc1 = torch.nn.Linear(16 * 16 * 16, 128)

self.fc2 = torch.nn.Linear(128, 43) # 43类交通标志

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = torch.flatten(x, 1)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

model = TrafficSignModel()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

loss_fn = F.cross_entropy

# 3. 对抗训练

epsilon = 0.01 # 噪声强度(越大攻击越强,但图像失真越明显)

for epoch in range(10):

for images, labels in train_loader:

# 生成对抗样本

perturbed_images = fgsm_attack(model, images, labels, epsilon)

# 训练模型:同时用原始图像和对抗样本

optimizer.zero_grad()

output_original = model(images)

output_perturbed = model(perturbed_images)

loss = loss_fn(output_original, labels) + loss_fn(output_perturbed, labels)

loss.backward()

optimizer.step()

print(f"Epoch {epoch+1}, Loss: {loss.item():.4f}")

步骤3:评估鲁棒性

# 加载测试集

test_data = GTSRB(root="./data", split="test", download=True, transform=ToTensor())

test_loader = DataLoader(test_data, batch_size=32, shuffle=False)

# 计算原始样本与对抗样本的准确率

model.eval()

correct_original = 0

correct_perturbed = 0

total = 0

with torch.no_grad():

for images, labels in test_loader:

# 原始样本

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

correct_original += (predicted == labels).sum().item()

# 对抗样本

perturbed_images = fgsm_attack(model, images, labels, epsilon)

outputs_perturbed = model(perturbed_images)

_, predicted_perturbed = torch.max(outputs_perturbed.data, 1)

correct_perturbed += (predicted_perturbed == labels).sum().item()

total += labels.size(0)

print(f"原始样本准确率: {100 * correct_original / total:.2f}%")

print(f"对抗样本准确率: {100 * correct_perturbed / total:.2f}%")

6.4 关键细节:对抗训练的权衡

- epsilon:设置太小(如0.005),对抗样本的攻击强度不够,鲁棒性提升有限;设置太大(如0.02),会导致模型精度下降(原始样本准确率从95%降到90%)。

- 训练策略:建议“原始样本+对抗样本”混合训练(权重各占50%),否则模型可能过度拟合对抗样本。

- 攻击方法:FGSM是最快的攻击方法,但PGD(迭代攻击)更强大。如果需要更高的鲁棒性,可改用PGD生成对抗样本。

八、关键技术5:可审计性设计——用MLOps实现全生命周期追踪

8.1 问题场景

监管机构要求你提供“模型的训练数据来源、参数调整记录、部署时间”,但你发现:

- 数据文件散落在不同服务器,没有版本记录

- 训练参数保存在本地笔记本,无法追溯

- 部署的模型版本与训练版本不一致

8.2 技术方案:MLflow的“追踪+模型注册”

MLflow是开源的MLOps工具,核心功能:

- 实验追踪:记录训练过程中的参数、指标、 artifacts(如数据文件、模型文件)。

- 模型注册:管理模型版本,记录每个版本的合规状态(如“版本1.0通过隐私审核”)。

8.3 代码实现:追踪糖尿病预测模型的全生命周期

步骤1:初始化MLflow追踪

import mlflow

import mlflow.tensorflow

# 配置MLflow服务器(本地或远程)

mlflow.set_tracking_uri("http://localhost:5000")

mlflow.set_experiment("diabetes_prediction") # 实验名称

步骤2:追踪训练过程

with mlflow.start_run(run_name="dp_model_v1"):

# 记录参数

mlflow.log_param("l2_norm_clip", 1.0)

mlflow.log_param("noise_multiplier", 1.1)

mlflow.log_param("epochs", 100)

# 训练模型(参考“关键技术1”的代码)

model.fit(X_train, y_train, epochs=100, batch_size=32)

# 记录指标

test_loss = model.evaluate(X_test, y_test)

mlflow.log_metric("test_loss", test_loss)

mlflow.log_metric("epsilon", dp_optimizer.privacy_accountant.get_epsilon(delta=1e-5))

# 记录 artifacts(数据文件、模型文件)

mlflow.log_artifact("diabetes_data.csv", "data") # 训练数据

mlflow.tensorflow.log_model(model, "model") # 模型文件

步骤3:注册模型版本

# 将训练好的模型注册到MLflow模型仓库

model_uri = f"runs:/{mlflow.active_run().info.run_id}/model"

registered_model = mlflow.register_model(model_uri, "diabetes_prediction_model")

# 给模型版本打合规标签

client = mlflow.MlflowClient()

client.set_model_version_tag(

name="diabetes_prediction_model",

version=registered_model.version,

key="compliance_status",

value="approved" # 合规状态:approved/rejected

)

步骤4:查询审计日志

# 查询模型的全生命周期记录

run = mlflow.get_run(mlflow.active_run().info.run_id)

print("训练参数:", run.data.params)

print("训练指标:", run.data.metrics)

print("artifacts:", run.info.artifact_uri)

# 查询模型版本的合规状态

model_version = client.get_model_version("diabetes_prediction_model", registered_model.version)

print("合规状态:", model_version.tags["compliance_status"])

8.4 关键细节:可审计性的最佳实践

- 强制追踪:要求所有训练过程必须通过MLflow追踪,禁止本地训练。

- 标签管理:给模型版本打

compliance_status(approved/rejected)、privacy_epsilon(ε值)等标签,方便快速筛选合规版本。 - 远程服务器:将MLflow服务器部署在企业内部,避免数据泄露(不要用本地文件系统)。

九、关键技术6:动态合规监控——用实时系统预警风险

9.1 问题场景

你部署的推荐系统突然开始推荐违规内容(如虚假广告),原因是用户行为发生了变化(模型漂移),但你直到用户投诉才发现问题。

9.2 技术方案:Prometheus+Grafana的实时监控

我们需要监控以下合规指标:

- 数据层面:输入数据的分布变化(如“最近1小时的敏感词数量增加10倍”)。

- 模型层面:模型性能变化(如“准确率从90%降到80%”)、公平性变化(如“女性的拒绝率增加15%”)。

- 输出层面:输出内容的合规性(如“推荐内容中的敏感词占比”)。

9.3 代码实现:监控推荐系统的合规指标

步骤1:暴露指标(Prometheus)

from prometheus_client import start_http_server, Gauge

import time

# 初始化Gauge指标(用于记录数值型指标)

accuracy_gauge = Gauge("model_accuracy", "模型准确率")

fairness_gauge = Gauge("model_fairness_di_ratio", "模型公平性DI Ratio")

sensitive_word_gauge = Gauge("output_sensitive_word_ratio", "输出敏感词占比")

# 启动Prometheus HTTP服务器(端口8000)

start_http_server(8000)

# 模拟实时计算指标

while True:

# 1. 计算模型准确率(从数据库或监控系统获取)

current_accuracy = 0.85 + (time.time() % 10) * 0.01 # 模拟波动

accuracy_gauge.set(current_accuracy)

# 2. 计算公平性DI Ratio(从Fairlearn获取)

current_fairness = 0.9 + (time.time() % 10) * 0.01 # 模拟波动

fairness_gauge.set(current_fairness)

# 3. 计算输出敏感词占比(从推荐结果中统计)

current_sensitive_ratio = 0.01 + (time.time() % 10) * 0.005 # 模拟波动

sensitive_word_gauge.set(current_sensitive_ratio)

time.sleep(10) # 每10秒更新一次

步骤2:配置Grafana看板

- 安装Grafana(https://grafana.com/get)。

- 添加Prometheus数据源(URL:http://localhost:9090)。

- 创建看板,添加以下面板:

- 模型准确率(折线图)

- 公平性DI Ratio(折线图)

- 敏感词占比(柱状图)

- 设置警报规则(如“敏感词占比>0.05时发送邮件”)。

9.4 关键细节:监控的最佳实践

- 指标选择:聚焦“与合规强相关”的指标,避免监控无关数据(如“模型的内存占用”)。

- 阈值设置:根据业务场景调整,例如:

- 准确率下降超过5% → 预警

- 公平性DI Ratio低于0.8 → 预警

- 敏感词占比超过0.05 → 紧急预警

- 警报方式:结合邮件、Slack、钉钉等工具,确保架构师能及时收到通知。

十、关键技术7:版本管理与回滚——让合规状态“可逆”

10.1 问题场景

你部署了“糖尿病预测模型v2.0”,但发现它的隐私预算ε=5.0(隐私保护不足),需要快速回滚到ε=3.0的v1.0版本。

10.2 技术方案:MLflow的模型版本管理

MLflow的模型注册功能支持:

- 查看所有模型版本的合规状态

- 快速切换部署的模型版本

- 回滚到之前的合规版本

10.3 代码实现:回滚模型版本

步骤1:查询模型版本

from mlflow.tracking import MlflowClient

client = MlflowClient()

# 查询所有模型版本

for version in client.search_model_versions("name='diabetes_prediction_model'"):

print(f"版本: {version.version}, 合规状态: {version.tags.get('compliance_status')}")

步骤2:部署合规版本

# 选择合规的版本(如v1.0,compliance_status=approved)

model_version = 1

model_uri = f"models:/diabetes_prediction_model/{model_version}"

# 加载模型(用于部署)

loaded_model = mlflow.tensorflow.load_model(model_uri)

步骤3:回滚操作

如果v2.0出现合规问题,只需重新加载v1.0的模型并部署即可:

# 回滚到v1.0

model_version = 1

loaded_model = mlflow.tensorflow.load_model(f"models:/diabetes_prediction_model/{model_version}")

# 重新部署模型(如用Flask或FastAPI)

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route("/predict", methods=["POST"])

def predict():

data = request.get_json()

features = pd.DataFrame(data["features"])

prediction = loaded_model.predict(features)

return jsonify({"prediction": prediction.tolist()})

if __name__ == "__main__":

app.run(host="0.0.0.0", port=5001)

10.4 关键细节:版本管理的最佳实践

- 版本命名:用“vX.Y”格式(如v1.0、v1.1),避免用日期或随机字符串。

- 合规标签:每个版本必须打

compliance_status标签(approved/rejected),否则无法快速筛选。 - 部署自动化:用CI/CD工具(如GitHub Actions、GitLab CI)自动部署合规版本,避免人工错误。

十一、性能优化与最佳实践

11.1 差分隐私的优化

- 用Rényi差分隐私(TensorFlow Privacy支持)替代传统差分隐私,能更精确地控制隐私预算。

- 对高维数据(如图片),用梯度累积减少噪声的影响。

11.2 公平性的优化

- 在数据阶段进行偏见修正(如重采样少数群体),减少模型的偏见学习。

- 用多目标优化(如NSGA-II)平衡精度与公平性,避免单一目标的过度优化。

11.3 可解释性的优化

- 对大模型(如BERT),用DistilBERT做蒸馏,减少SHAP/LIME的计算时间。

- 生成自然语言解释(如“你的消费次数过多(比平均高2倍),导致被拒绝”),提高用户可读性。

11.4 监控的优化

- 用滑动窗口计算指标(如最近1小时的平均准确率),避免瞬时波动导致误报警。

- 用异常检测算法(如Isolation Forest)自动识别指标的异常值,减少人工设置阈值的工作量。

十二、常见问题与解决方案

Q1:差分隐私导致模型精度下降太多?

- 解决方案:调整

noise_multiplier(减小到1.0)或l2_norm_clip(增大到1.5),平衡隐私与精度。 - 替代方案:用联邦学习(不需要集中数据),但需改造数据架构。

Q2:Fairlearn修正后模型精度下降严重?

- 解决方案:改用

AdversarialDebiasing算法(对抗训练),比ExponentiatedGradient更能保持精度。 - 替代方案:在数据阶段进行重新加权(给少数群体的样本更高的权重),减少模型对多数群体的偏见。

Q3:SHAP计算太慢(针对大模型)?

- 解决方案:用

shap.sample对数据进行采样(如取1000个样本),减少计算量。 - 替代方案:用

shap.KernelExplainer的approximate参数(设置为True),加速计算。

Q4:监控系统误报警太多?

- 解决方案:调整阈值为“3倍标准差”(而非固定值),减少瞬时波动的影响。

- 替代方案:用滞后报警(如指标连续3次超过阈值才报警),避免误报。

十三、总结与未来展望

总结

AI合规不是“技术负担”,而是构建可靠AI系统的核心要素。本文的7个关键技术,本质是将监管要求转化为可执行的技术方案:

- 用差分隐私保护数据隐私

- 用Fairlearn消除模型偏见

- 用SHAP/LIME实现可解释性

- 用对抗训练增强鲁棒性

- 用MLflow实现可审计性

- 用实时监控预警风险

- 用版本管理让合规状态可逆

这些技术的核心是**“平衡”**——平衡隐私与精度、公平与性能、安全与效率。架构师的职责,就是在这些矛盾中找到最优解,构建“既能满足监管要求,又能创造业务价值”的AI系统。

未来展望

AI合规技术的发展方向:

- 自动合规:用大语言模型(LLM)自动检测模型的合规风险(如“这个模型的公平性指标不达标”)。

- 跨域合规:支持多地区的合规要求(如同时满足GDPR和中国的《生成式AI管理暂行办法》)。

- 联邦学习与隐私计算:在不集中数据的情况下,实现模型训练的合规(避免数据隐私风险)。

作为架构师,你需要持续关注这些技术的发展,将最新的合规工具整合到系统中,确保AI系统始终“合法、安全、可靠”。

参考资料

- 欧盟AI法案(2024年生效):https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX:52021PC0206

- 中国《生成式AI服务管理暂行办法》:https://www.cac.gov.cn/2023-07/13/c_1690898327029107.htm

- TensorFlow Privacy官方文档:https://github.com/tensorflow/privacy

- Fairlearn官方文档:https://fairlearn.org/

- SHAP论文:《A Unified Approach to Interpreting Model Predictions》(2017)

- MLflow官方文档:https://mlflow.org/

附录

- 完整代码仓库:https://github.com/your-username/ai-compliance-demo

- 合规指标清单:https://docs.google.com/spreadsheets/d/1xZ94eU6Y5e-8Z5e-9Z5e-0Z5e/edit?usp=sharing

- Grafana看板模板:https://grafana.com/grafana/dashboards/12345

结语:AI合规不是终点,而是AI系统“可持续发展”的起点。当你把合规嵌入系统设计的每一个环节,你将不仅能避免监管罚款,更能赢得用户的信任——这才是AI系统最核心的价值。

更多推荐

已为社区贡献761条内容

已为社区贡献761条内容

所有评论(0)