大模型面试题解析 | 深度学习核心概念详解(激活函数、Dropout、交叉熵和自注意力机制)干货收藏!

文章介绍了深度学习的四个核心概念:激活函数为神经网络引入非线性并稳定训练;Dropout通过随机丢弃神经元提高模型泛化能力;交叉熵用于衡量预测分布与真实分布的差距,分为多分类和二分类形式;自注意力机制中除以dk是为了防止softmax函数进入饱和区,保持梯度有效流动。这些概念是理解和构建深度学习模型的基础。

文章介绍了深度学习的四个核心概念:激活函数为神经网络引入非线性并稳定训练;Dropout通过随机丢弃神经元提高模型泛化能力;交叉熵用于衡量预测分布与真实分布的差距,分为多分类和二分类形式;自注意力机制中除以dk是为了防止softmax函数进入饱和区,保持梯度有效流动。这些概念是理解和构建深度学习模型的基础。

一、激活函数的作用是什么?

激活函数(Activation Function)是 神经网络的核心非线性模块,它的作用非常关键,可以总结为以下几点:

- 引入非线性(最重要的作用)

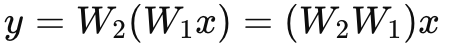

- 如果没有激活函数,神经网络就是多层线性变换:

不管堆多少层,本质上还是 一个线性函数,不能拟合复杂的非线性关系。

- 激活函数提供了 非线性映射能力,让神经网络能够近似任意复杂函数(通用逼近理论)。

- 控制输出范围,稳定训练

- 有些激活函数会把输出“压缩”到某个区间:

-

Sigmoid:(0, 1)

-

Tanh:(-1, 1)

- 这样可以防止数值过大,提高训练稳定性。

- 引入稀疏性与门控机制

- ReLU 及其变种(Leaky ReLU、ELU 等)会对负值直接输出 0。

- 这会让一部分神经元“关闭”,提高表示的稀疏性,增强特征选择能力。

- 改善梯度传播

- 合适的激活函数能缓解 梯度消失 或 梯度爆炸 问题。

-

Sigmoid 在极端输入下会饱和 → 梯度趋近 0(梯度消失)

-

ReLU 在正区间梯度恒为 1,能有效保持梯度流动。

- 选择不同的激活函数,往往直接影响训练效果。

- 增强网络表达能力

- 激活函数赋予网络“非线性组合能力”,

- 例如 CNN + ReLU 可以学到边缘/纹理等复杂特征,

- Transformer 里的 GeLU/Tanh 激活能让注意力机制表达更丰富的上下文信息。

小结:

激活函数 = 给网络“加大脑”,让它能学习非线性映射,同时保持训练稳定。

二、解释一下dropout,它能提高泛化性吗

- 什么是 Dropout?

Dropout 是一种 正则化方法,最早由 Hinton 在 2012 年提出。

核心思想:

- 在每次训练时,随机“丢弃”(drop out)一部分神经元(通常丢弃概率为 0.2 ~ 0.5)。

- 被丢弃的神经元在该次前向传播和反向传播中都不参与计算,相当于暂时从网络中移除。

- 在推理阶段(测试/预测时),不会真正丢弃,而是将权重缩放,以补偿训练时丢失的激活。

简单理解:

Dropout 就像让网络中的神经元“随机缺席”,避免它们之间形成“固定依赖关系”,迫使网络学到更鲁棒的特征。

- Dropout 的作用

主要作用是 减少过拟合,提高模型泛化性。

- 打破神经元的共适应性(co-adaptation):

如果某些神经元总是一起工作,网络就容易只记住训练数据而不具备泛化能力。Dropout 迫使它们不能“抱团”,必须学会独立提取特征。

- 相当于训练了很多子网络:

每次训练“丢弃”的神经元不同,可以看作是在训练不同的子网络。最终的网络效果类似于多个子网络的集成(ensemble),而集成学习本身就能提高泛化性。

- Dropout 就能提高泛化性吗?

👉 不一定,效果依赖场景。

✅ 通常有效:

在全连接层(尤其是较深的神经网络、参数很多的模型)里,Dropout 能显著降低过拟合。

⚠️ 但不是万能的:

-

如果模型本身容量不大(比如小型网络、参数少),Dropout 可能导致 欠拟合。

-

在一些结构中(如卷积层、RNN/LSTM),Dropout 不一定效果好,可能需要特别的变体(例如 SpatialDropout、Variational Dropout)。

-

Dropout 对训练速度有一定负面影响(需要更长时间收敛)。

🆚 现代模型(比如 Transformer、ResNet 等)往往结合 BatchNorm、LayerNorm、权重衰减、数据增强 等手段,有时候 Dropout 反而不是最主要的正则化方式。

- 小结

- Dropout 是一种正则化方法,本质是随机屏蔽部分神经元,减少过拟合。

- 它能提高泛化性,但不是保证,要结合模型规模、网络结构、任务场景来判断。

- 实际工程里,Dropout 通常和 数据增强、权重衰减(L2正则)、早停(early stopping)、BatchNorm/LayerNorm 等一起使用。

三、交叉熵的公式是什么

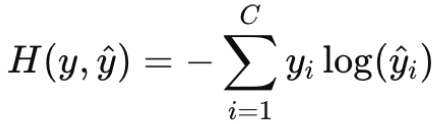

- 一般交叉熵(Cross-Entropy)

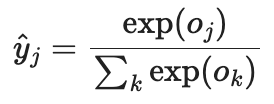

用于多分类问题(softmax输出)。

设真实分布为y,预测分布为ŷ:

- y是one-hot向量(某个类别为1,其余为0)

- ŷi是模型对第i类的预测概率(softmax输出)

公式:

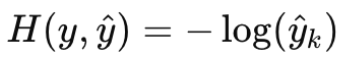

如果真实类别是k,则:

解释:

交叉熵衡量“真实分布”和”预测分布“之间的差距。

预测越接近真实类别,损失越小。

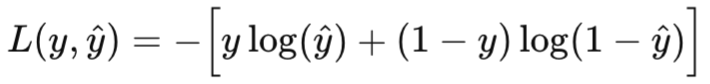

- 二元交叉熵(Binary Cross-Entropy, BCE)

用于二分类问题(sigmod输出)

设:

- 真实标签:y∈{0, 1}

- 预测概率:ŷ=σ(z)∈(0, 1), 其中σ是sigmod

公式:

解释:

- 如果y=1,损失就是-log(ŷ),希望ŷ越接近1越好。

- 如果y=0,损失就是-log(1-ŷ),希望ŷ越接近0越好。

- 本质上是交叉熵在二分类下的特例。

- 区别总结

- 交叉熵(CE):多分类,结合softmax使用。

- 二元交叉熵(BCE):二分类,结合sigmod使用。

- BCE可以看作CE在C=2的情况。

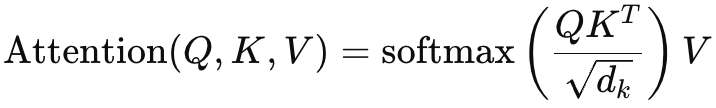

四、自注意力机制中为什么除以dk

自注意力机制的计算公式为:

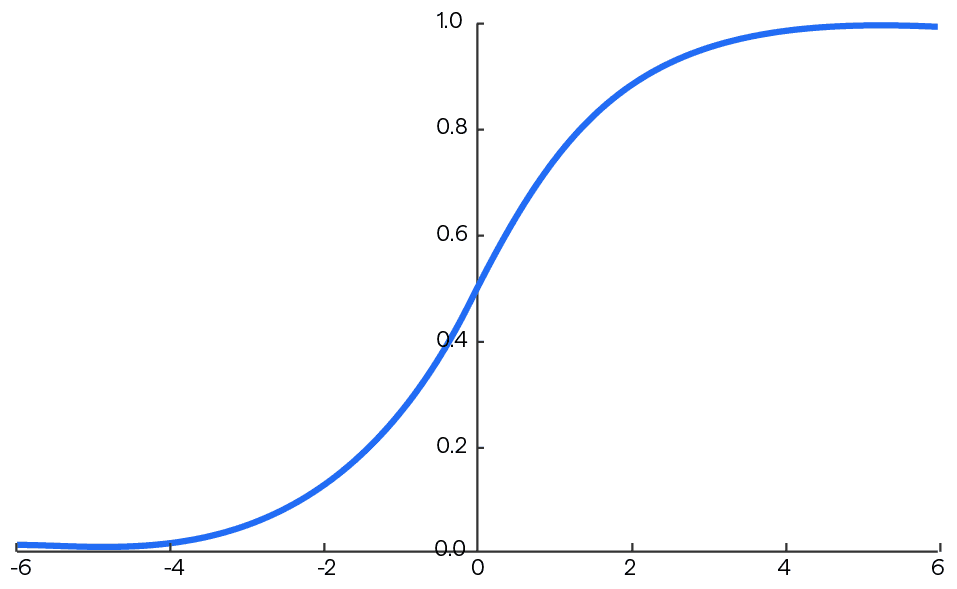

softmax函数图像:

简单一句话的答案:通过除以dk,可以将点积的结果缩小到一个合理的范围,避免softmax激活函数值进入饱和区。

解释:

- 中间区:输出变化快,梯度大,学习效果好;

- 饱和区:输出接近 0 或 1,梯度很小,参数更新几乎停滞。

如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 大模型行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

更多推荐

已为社区贡献130条内容

已为社区贡献130条内容

所有评论(0)