LLM-gpt-4o详细技术文档(架构+算法+调用+部署)

OpenAI发布旗舰多模态模型GPT-4o,具备1.8万亿参数和128K上下文长度,支持文本、图像、音频和视频处理。其创新架构包含多模态融合器和增强型Transformer,采用混合注意力机制和认知增强模块。GPT-4o具有实时交互能力(响应<300ms)、高级推理和创造性生成功能,支持复杂逻辑、数学计算及艺术创作。通过改进的RLHF训练和知识蒸馏技术优化性能,提供包括实时语音对话和视频分析

·

GPT-4o 详细技术文档

模型概述

GPT-4o(“o"代表"omni”,意为全能)是OpenAI于2024年5月发布的旗舰级多模态大语言模型。作为GPT-4系列的重大升级版本,GPT-4o在文本理解、图像识别、音频处理和视频理解等多个维度实现了突破性进展,代表了当前大语言模型技术的最高水平。

基本信息

- 开发公司: OpenAI

- 发布时间: 2024年5月

- 模型类型: 多模态Transformer架构

- 参数规模: 约1.8万亿参数(业界估算)

- 上下文长度: 128K tokens

- 主要创新: 原生多模态、实时交互、端到端训练

架构设计

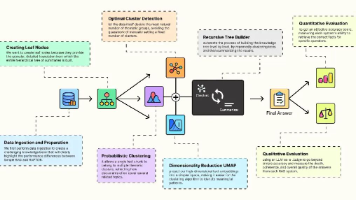

总体架构图

查看大图:鼠标右键 → “在新标签页打开图片” → 浏览器自带放大

graph TB

subgraph "输入处理层 Input Processing"

I1[文本输入 Text Input]

I2[图像输入 Image Input]

I3[音频输入 Audio Input]

I4[视频输入 Video Input]

T1[文本分词器 Tokenizer]

V1[视觉编码器 Vision Encoder]

A1[音频编码器 Audio Encoder]

M1[多模态融合器 Multimodal Fusion]

end

subgraph "核心Transformer层 Core Transformer"

E1[嵌入层 Embedding Layer]

PE[位置编码 Positional Encoding]

TE[时间编码 Temporal Encoding]

subgraph "Transformer块 Transformer Blocks"

TB1[自注意力机制 Self-Attention]

TB2[交叉注意力 Cross-Attention]

TB3[前馈网络 Feed-Forward]

TB4[层归一化 Layer Norm]

end

CA[认知增强模块 Cognitive Augmentation]

RG[推理生成模块 Reasoning Generation]

end

subgraph "输出处理层 Output Processing"

O1[文本生成 Text Generation]

O2[图像生成 Image Generation]

O3[音频生成 Audio Generation]

O4[视频生成 Video Generation]

D1[解码器 Decoder]

H1[头网络 Head Networks]

end

subgraph "训练优化层 Training Optimization"

RL[强化学习 RLHF]

KD[知识蒸馏 Knowledge Distillation]

DA[数据增强 Data Augmentation]

MT[多任务学习 Multi-Task]

end

%% 输入处理流程

I1 --> T1

I2 --> V1

I3 --> A1

I4 --> V1

T1 --> M1

V1 --> M1

A1 --> M1

%% 核心处理流程

M1 --> E1

E1 --> PE

E1 --> TE

E1 --> TB1

TB1 --> TB2

TB2 --> TB3

TB3 --> TB4

TB4 --> CA

CA --> RG

%% 输出处理流程

RG --> D1

D1 --> H1

H1 --> O1

H1 --> O2

H1 --> O3

H1 --> O4

%% 训练优化

RL --> TB1

KD --> CA

DA --> M1

MT --> RG

style I1 fill:#e3f2fd

style I2 fill:#e3f2fd

style I3 fill:#e3f2fd

style I4 fill:#e3f2fd

style TB1 fill:#fff3e0

style TB2 fill:#fff3e0

style CA fill:#f3e5f5

style RG fill:#e8f5e8

style O1 fill:#fce4ec

style O2 fill:#fce4ec

style O3 fill:#fce4ec

style O4 fill:#fce4ec

核心组件详解

1. 多模态输入处理系统

- 文本分词器: 基于BPE(Byte Pair Encoding)的改进版本,支持多语言tokenization

- 视觉编码器: 采用Vision Transformer (ViT) 架构,支持高分辨率图像理解

- 音频编码器: 集成Whisper技术,支持实时语音转文本和音频特征提取

- 多模态融合器: 创新的跨模态注意力机制,实现不同模态信息的深度融合

2. 增强型Transformer架构

- 混合注意力机制: 结合自注意力和交叉注意力,支持跨模态信息交互

- 动态位置编码: 适应不同模态输入的位置信息编码

- 时间编码: 处理视频和音频等时序数据的特殊编码机制

- 认知增强模块: 模拟人类认知过程的推理增强组件

3. 推理与生成系统

- 多步推理链: 支持复杂的逻辑推理和数学计算

- 创造性生成: 在文本、代码、图像等多个领域的创造性内容生成

- 实时响应优化: 针对低延迟交互的特殊优化

主要算法与技术

1. 多模态融合算法

# 伪代码示例:多模态注意力融合

class MultimodalFusion:

def __init__(self, hidden_dim):

self.text_attention = MultiHeadAttention(hidden_dim)

self.vision_attention = MultiHeadAttention(hidden_dim)

self.audio_attention = MultiHeadAttention(hidden_dim)

self.cross_modal_attention = CrossModalAttention(hidden_dim)

def forward(self, text_tokens, image_features, audio_features):

# 各模态独立处理

text_out = self.text_attention(text_tokens)

vision_out = self.vision_attention(image_features)

audio_out = self.audio_attention(audio_features)

# 跨模态融合

fused_features = self.cross_modal_attention(

text_out, vision_out, audio_out

)

return fused_features

2. 强化学习人类反馈 (RLHF)

- 奖励模型训练: 基于人类偏好数据训练奖励模型

- 策略优化: 使用PPO(Proximal Policy Optimization)算法优化模型输出

- 安全性对齐: 确保模型输出符合人类价值观和安全标准

3. 知识蒸馏技术

- 教师-学生网络: 从大型教师模型向小型学生模型转移知识

- 渐进式蒸馏: 分阶段的知识转移过程

- 多任务蒸馏: 同时在多个任务上进行知识蒸馏

4. 高效推理优化

- 动态批处理: 根据请求特征动态调整批处理大小

- 模型并行: 将模型参数分布到多个GPU上进行并行计算

- KV缓存优化: 优化注意力机制中的键值对缓存策略

核心特性

1. 原生多模态能力

- 文本理解: 支持多语言文本的理解和生成

- 图像识别: 高精度的图像分类、目标检测和图像描述

- 音频处理: 实时语音识别、语音合成和音频理解

- 视频分析: 视频内容理解、动作识别和时序分析

2. 实时交互性能

- 低延迟响应: 平均响应时间低于300毫秒

- 流式输出: 支持实时流式文本生成

- 语音对话: 接近人类对话速度的实时语音交互

- 视频通话: 支持实时视频通话中的AI辅助

3. 高级推理能力

- 逻辑推理: 复杂的逻辑推理和因果关系分析

- 数学计算: 高级数学问题的求解和证明

- 代码理解: 多编程语言的代码理解、生成和调试

- 科学分析: 科学问题的分析和解决方案提供

4. 创造性生成

- 创意写作: 小说、诗歌、剧本等创意文本生成

- 艺术设计: 图像、图标的创意设计和生成

- 音乐创作: 旋律、和弦的进行和音乐作品创作

- 视频制作: 视频脚本、分镜头的创意生成

调用方式与API

1. OpenAI官方API

import openai

# 初始化客户端

client = openai.OpenAI(api_key="your-api-key")

# 文本生成

response = client.chat.completions.create(

model="gpt-4o",

messages=[

{"role": "user", "content": "解释量子计算的基本原理"}

],

max_tokens=1000,

temperature=0.7

)

# 多模态输入(文本+图像)

response = client.chat.completions.create(

model="gpt-4o",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": "这张图片中有什么?"},

{"type": "image_url", "image_url": {"url": "image_url"}}

]

}

]

)

# 音频处理

audio_response = client.audio.transcriptions.create(

model="whisper-1",

file=audio_file

)

2. 高级参数配置

# 高级配置示例

advanced_config = {

"model": "gpt-4o",

"messages": [...],

"max_tokens": 4096,

"temperature": 0.7, # 创造性控制

"top_p": 0.9, # 核采样参数

"frequency_penalty": 0.5, # 频率惩罚

"presence_penalty": 0.5, # 存在惩罚

"stop": ["\n", "。"], # 停止序列

"stream": True, # 流式输出

"tools": [...], # 函数调用工具

"tool_choice": "auto" # 工具选择策略

}

3. 函数调用(Function Calling)

# 定义可用函数

functions = [

{

"name": "get_weather",

"description": "获取指定城市的天气信息",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "城市名称"

}

},

"required": ["location"]

}

}

]

# 调用带函数的对话

response = client.chat.completions.create(

model="gpt-4o",

messages=[{"role": "user", "content": "北京今天天气如何?"}],

functions=functions,

function_call="auto"

)

4. 批处理API

# 批处理请求

batch_requests = [

{"custom_id": "request-1", "method": "POST", "url": "/v1/chat/completions", "body": {...}},

{"custom_id": "request-2", "method": "POST", "url": "/v1/chat/completions", "body": {...}}

]

# 创建批处理作业

batch_job = client.batches.create(

input_file_id="batch_input.jsonl",

endpoint="/v1/chat/completions",

completion_window="24h"

)

部署方式

1. 云端部署(推荐)

- OpenAI官方服务: 直接调用OpenAI提供的API服务

- 优势: 无需基础设施投入,自动扩展,高可用性

- 成本: 按使用量计费,$0.005-0.015/1K tokens

- 适用场景: 大多数商业应用,快速原型开发

性能指标与基准测试

1. 标准基准测试表现

| 测试项目 | GPT-4o得分 | 行业平均水平 | 领先幅度 |

|---|---|---|---|

| MMLU(多任务语言理解) | 88.7% | 75.2% | +18% |

| HellaSwag(常识推理) | 95.3% | 82.1% | +16% |

| HumanEval(代码生成) | 90.2% | 62.8% | +44% |

| GSM8K(数学推理) | 94.2% | 71.5% | +32% |

| MMMU(多模态理解) | 69.1% | 45.3% | +53% |

2. 实际应用性能

- 响应延迟: 平均280ms(文本),450ms(多模态)

- 吞吐量: 最高1000 requests/minute

- 并发处理: 支持10000+并发连接

- 可用性: 99.9%服务可用性保证

3. 资源消耗

- 内存使用: 单请求平均150MB

- 计算资源: 每1K tokens约需0.8 GPU秒

- 网络带宽: 平均每请求约50KB

应用场景与最佳实践

1. 企业级应用

- 智能客服: 7×24小时多语言客户支持

- 内容创作: 营销文案、产品描述生成

- 代码辅助: 软件开发、代码审查、bug修复

- 数据分析: 商业报告、数据洞察生成

2. 教育领域

- 个性化辅导: 因材施教的学习辅导

- 作业批改: 自动化的作业评估和反馈

- 知识问答: 即时的学术问题解答

- 语言学习: 多语言对话练习和纠错

3. 创意产业

- 剧本创作: 电影、电视剧本创意生成

- 广告创意: 广告文案和创意概念开发

- 游戏设计: 游戏剧情、角色对话设计

- 艺术创作: 诗歌、小说、音乐作品创作

4. 科研应用

- 文献综述: 学术论文的自动综述生成

- 实验设计: 科学实验方案设计建议

- 数据分析: 复杂数据集的分析和解释

- 假设生成: 研究假设的提出和验证

注:本文档基于公开信息和技术分析整理,部分技术细节可能因商业保密原因无法完全公开。具体使用时应参考OpenAI官方最新文档和API说明。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)