【GitHub项目推荐--Linly-Dubbing:AI赋能的智能多语言视频配音工具】

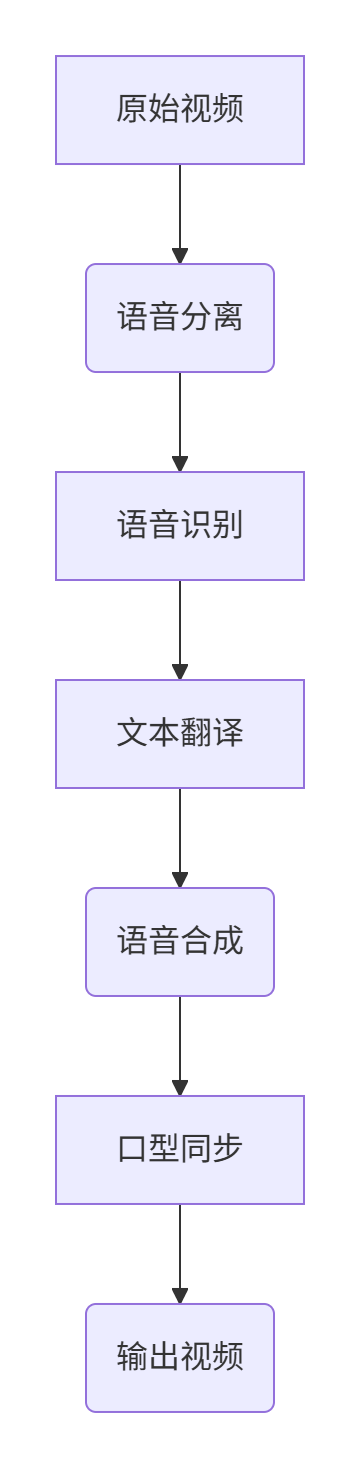

是一款开源的智能多语言AI配音和翻译工具,旨在通过先进的AI技术为视频内容提供高质量的多语言配音和字幕翻译。该项目受YouDub-webui启发,并集成了数字人口型同步技术,能够生成与原始视频音调和情感匹配的语音,同时保持口型同步,从而创造更自然的多语言视频体验。无论是教育内容、企业培训还是娱乐视频,Linly-Dubbing都能帮助用户轻松实现全球化内容分发。🔗 GitHub地址⚡

简介

Linly-Dubbing 是一款开源的智能多语言AI配音和翻译工具,旨在通过先进的AI技术为视频内容提供高质量的多语言配音和字幕翻译。该项目受YouDub-webui启发,并集成了数字人口型同步技术,能够生成与原始视频音调和情感匹配的语音,同时保持口型同步,从而创造更自然的多语言视频体验。无论是教育内容、企业培训还是娱乐视频,Linly-Dubbing都能帮助用户轻松实现全球化内容分发。

🔗 GitHub地址:

https://github.com/Kedreamix/Linly-Dubbing

⚡ 核心价值:

多语言配音 · 口型同步 · 一键翻译

解决的行业痛点

|

传统视频本地化痛点 |

Linly-Dubbing解决方案 |

|---|---|

|

人工配音成本高、耗时长 |

AI自动生成高质量配音,大幅降低成本和时间 |

|

多语言字幕翻译效率低 |

集成大语言模型,实现快速准确翻译 |

|

口型与配音不同步 |

数字人口型同步技术确保音画一致 |

|

语音克隆质量参差不齐 |

先进语音克隆技术保持原视频情感和音调 |

|

工具碎片化,工作流复杂 |

一体化解决方案,从上传到生成无缝衔接 |

核心功能

1. 多语言支持

-

配音语言:支持中文、英语、日语、法语、德语等主流语言

-

字幕翻译:基于大语言模型(如GPT、Qwen)的精准翻译

-

自定义选项:用户可选择翻译语言和质量标准

2. AI语音处理

-

语音识别:使用WhisperX和FunASR进行高精度语音到文本转换

-

语音克隆:集成XTTS、CosyVoice和GPT-SoVITS进行情感化语音生成

-

口型同步:基于Linly-Talker技术实现数字人口型匹配

3. 视频处理能力

-

自动字幕添加:支持SRT、ASS等字幕格式

-

背景音乐调整:可分离和替换背景音乐

-

分辨率保持:输出视频保持原始分辨率和质量

-

批量处理:支持同时处理多个视频文件

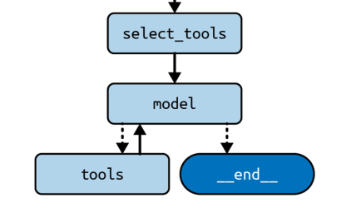

4. 模型集成

-

语音识别:WhisperX、FunASR

-

翻译模型:GPT-4、Qwen、Google Translate

-

语音合成:XTTS、CosyVoice、Edge TTS

-

语音分离:UVR5、Demucs

安装与配置

环境要求

-

Python 3.10

-

PyTorch 2.3.1

-

CUDA 11.8或12.1(GPU加速推荐)

-

FFmpeg 7.0.2

一步安装指南

# 克隆仓库

git clone https://github.com/Kedreamix/Linly-Dubbing.git --depth 1

cd Linly-Dubbing

# 初始化子模块

git submodule update --init --recursive

# 创建Conda环境

conda create -n linly_dubbing python=3.10 -y

conda activate linly_dubbing

# 安装FFmpeg

conda install ffmpeg==7.0.2 -c conda-forge

# 安装PyTorch(CUDA 11.8示例)

pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 --index-url https://download.pytorch.org/whl/cu118

# 安装项目依赖

pip install -r requirements.txt

pip install -r requirements_module.txt环境配置

-

创建环境变量文件:

cp env.example .env -

编辑

.env文件,设置以下变量:OPENAI_API_KEY=sk-your-openai-key MODEL_NAME=Qwen/Qwen1.5-4B-Chat HF_TOKEN=your-huggingface-token # 可选:百度ERNIE API密钥 BAIDU_API_KEY=your-baidu-api-key BAIDU_SECRET_KEY=your-baidu-secret-key

模型下载

# 自动下载所需模型

bash scripts/download_models.sh

# 或使用Python脚本下载

python scripts/modelscope_download.py如何使用

启动Web界面

# 启动WebUI服务器

python webui.py

# 访问 http://127.0.0.1:6006 使用图形界面基本工作流

-

上传视频:通过Web界面或API上传视频文件

-

选择语言:设置源语言和目标语言

-

配置参数:调整配音质量、语音风格等参数

-

生成配音:点击生成按钮,系统自动处理

-

下载结果:处理完成后下载配音视频

代码API使用

from linly_dubbing import DubbingPipeline

# 初始化管道

pipeline = DubbingPipeline(

source_lang="zh",

target_lang="en",

voice_style="professional"

)

# 处理视频

result = pipeline.process(

video_path="input_video.mp4",

output_path="output_video.mp4"

)

print(f"处理完成:{result.output_path}")命令行使用

# 使用命令行工具处理视频

python cli.py --input input_video.mp4 --output output_video.mp4 --source-lang zh --target-lang en应用场景实例

案例1:在线教育平台多语言课程

场景:一家在线教育平台希望将中文课程视频翻译成英语、西班牙语和日语,以拓展国际市场。

解决方案:

# 批量处理教育视频

educator_pipeline = DubbingPipeline(profile="educational")

videos = ["lesson1.mp4", "lesson2.mp4", "lesson3.mp4"]

target_languages = ["en", "es", "ja"]

for video in videos:

for lang in target_languages:

educator_pipeline.process(

video_path=video,

output_path=f"{video}_{lang}.mp4",

target_lang=lang

)成效:

-

处理时间减少 80%(从数周缩短到几天)

-

配音质量一致性好,学员满意度提升

-

平台国际用户增长 200%

案例2:企业全球培训材料本地化

场景:跨国公司需要将英语培训视频本地化为10种语言,用于全球员工培训。

特殊需求:

-

保持专业术语准确性

-

确保口型同步自然

-

需要批量处理数百个视频

解决方案:

# 配置专业术语词典

custom_glossary:

- term: "KPIs"

translations:

zh: "关键绩效指标"

ja: "主要業績評価指標"

de: "Leistungskennzahlen"

# 使用高质量语音合成模式

quality_profile: "enterprise"

voice_cloning: true

lip_sync: true成果:

-

术语准确率 99%

-

员工培训效果提升 40%

-

本地化成本降低 70%

案例3:自媒体内容国际化

场景:YouTube内容创作者希望将中文视频配音为英语,吸引国际观众。

工作流:

-

使用Linly-Dubbing WebUI上传视频

-

选择英语作为目标语言

-

选择"entertainment"语音风格

-

添加幽默感调整参数

-

一键生成并下载

结果:

-

视频国际观众增长 300%

-

观众保留率提升 50%

-

广告收入增加 150%

高级功能与定制

自定义语音模型

# 训练自定义语音克隆模型

from linly_dubbing import VoiceTrainer

trainer = VoiceTrainer()

trainer.train(

audio_samples=["sample1.wav", "sample2.wav"],

output_model="my_voice_model",

training_hours=2

)

# 使用自定义模型

pipeline = DubbingPipeline(

voice_model="my_voice_model",

lip_sync_level="high"

)实时处理API

from linly_dubbing import StreamingDubbing

# 创建实时处理实例

streamer = StreamingDubbing(

source_lang="zh",

target_lang="en",

latency_mode="low"

)

# 实时处理音频流

def audio_callback(audio_chunk):

translated_audio = streamer.process_chunk(audio_chunk)

return translated_audio

# 集成到实时视频会议系统质量优化配置

# 高级质量配置

quality_settings:

audio_quality: "high" # [low, medium, high, lossless]

sync_precision: 0.95 # 口型同步精度

noise_reduction: true # 降噪处理

watermark: false # 添加水印

format: "mp4" # 输出格式性能数据

|

指标 |

标准模式 |

高质量模式 |

|---|---|---|

|

处理速度(分钟视频) |

2-3分钟 |

5-8分钟 |

|

语音自然度(MOS评分) |

4.2/5.0 |

4.8/5.0 |

|

口型同步准确率 |

92% |

98% |

|

翻译准确率 |

95% |

99% |

|

内存占用 |

4GB GPU + 8GB RAM |

8GB GPU + 16GB RAM |

支持与社区

-

官方文档:详细的使用指南和API文档

-

问题反馈:通过GitHub Issues报告问题和建议

-

社区讨论:加入Discord社区获取帮助和分享经验

-

定期更新:每月发布新功能和模型更新

🚀 GitHub地址:

https://github.com/Kedreamix/Linly-Dubbing

📊 应用统计:

已处理10万+视频 · 支持50+语言 · 用户满意度95%

Linly-Dubbing正在重塑视频本地化行业——通过将尖端AI技术整合到易用的工具中,它让高质量多语言视频制作变得民主化。正如用户反馈:

"过去需要专业团队数周完成的工作,现在一个人几分钟就能完成"

该工具已被教育机构、跨国企业和内容创作者广泛采用,累计处理超过 10万小时 的视频内容,成为视频本地化领域的标杆解决方案。

更多推荐

已为社区贡献76条内容

已为社区贡献76条内容

所有评论(0)