Agent的核心其实还是一种提示词工程

摘要:大模型的核心运作依赖于提示词处理。Agent(智能代理)通过提示词实现规划、记忆、工具调用和行动四大功能:1)规划提示词指导任务拆解;2)记忆提示词串联会话上下文;3)工具提示词实现API调用;4)行动提示词规范输出格式。每次对话本质都是将Agent要素转化为特定提示词输入,通过模型的自回归计算生成响应。这种提示词驱动机制使模型具备任务处理、环境感知和持续学习的能力,形成完整的智能体工作闭环

问:大模型的核心是提示词吗?

答:是的,因为文本模型的输入输出只能是文字。Agent的所有的输入输出,本质是特殊处理的文本。可以理解每次对话都是给模型输入的特殊处理的提示词

理解这个问题前,我们想看大模型工作的原理

模型的工作逻辑

我们先来看三个都个东西:

- 模型如何生成长文本

- 模型如何回答问题

- 模型如何拥有记忆

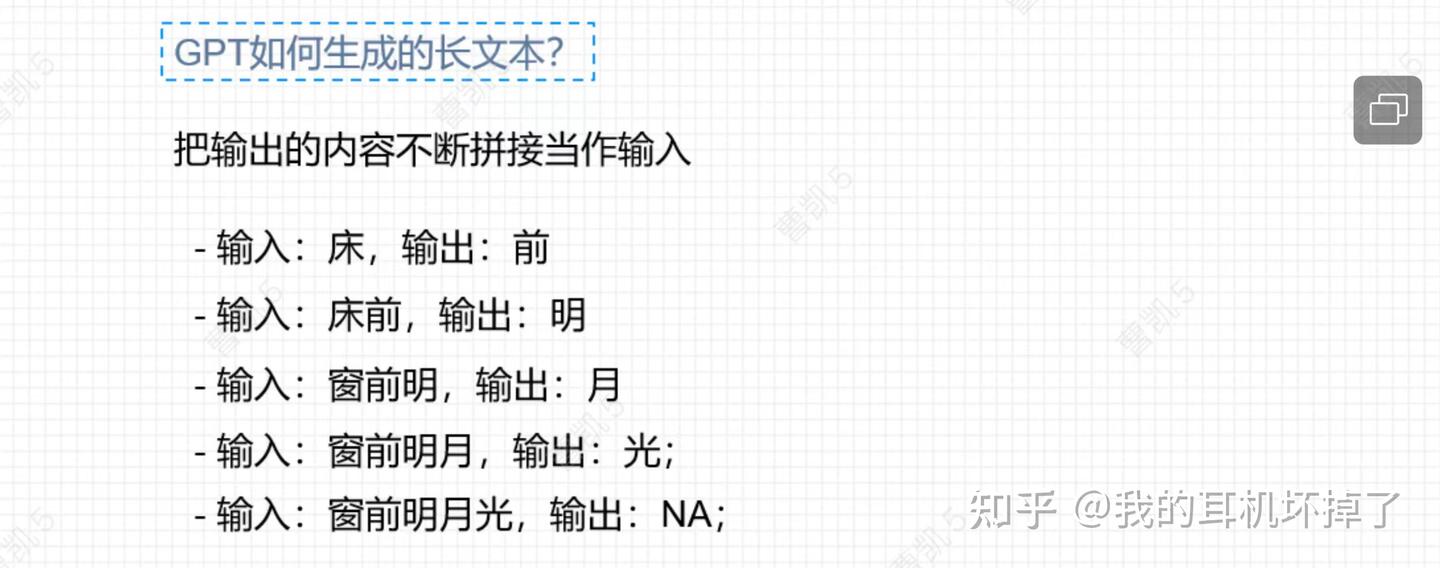

- 模型如何生成长文本

既:通过自回归计算,把输出的内容不断的拼接当作新的内容,直到模型不输特定符号为止。既生成了长文本。

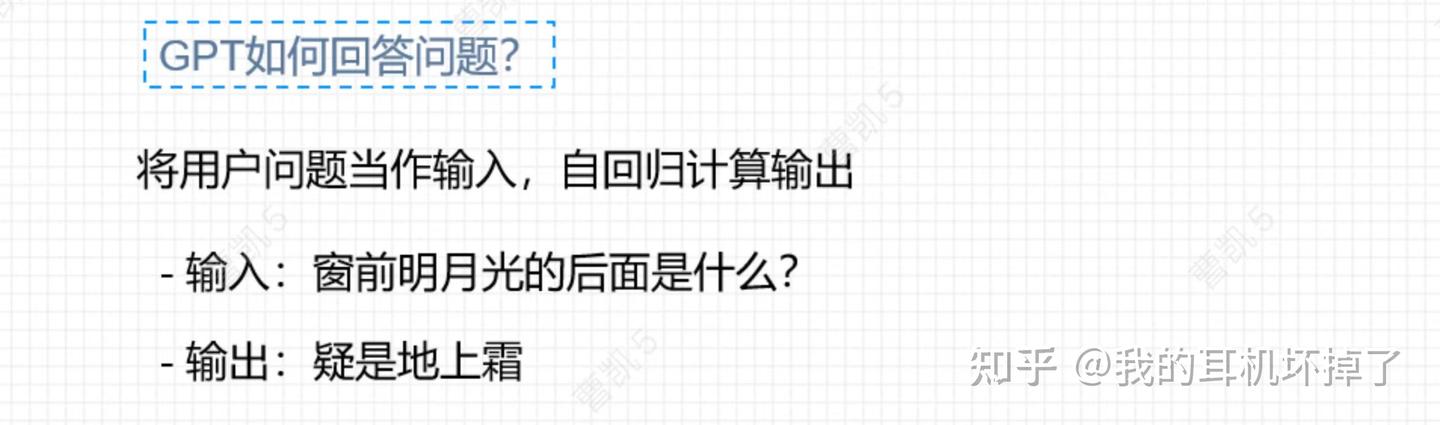

2、模型如何回答问题

这个很好理解,就是就是把问题当作输出,然后单词接龙,让模型生成长文本,自回归计算直到给出答案

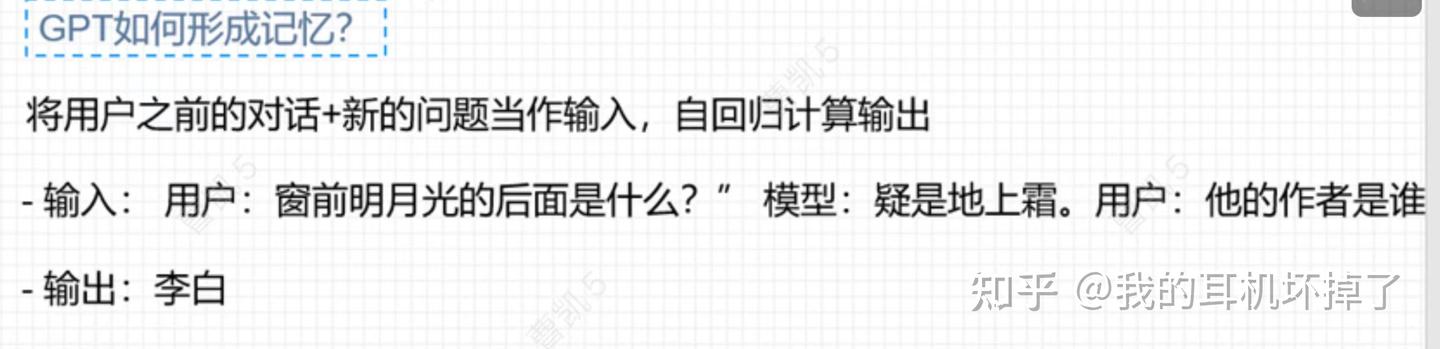

模型如何形成记忆:

也很简单,把用户之前的对话和模型回复,加上新的问题当作输入,然后自回归计算给出输出

Agent和提示词的关系

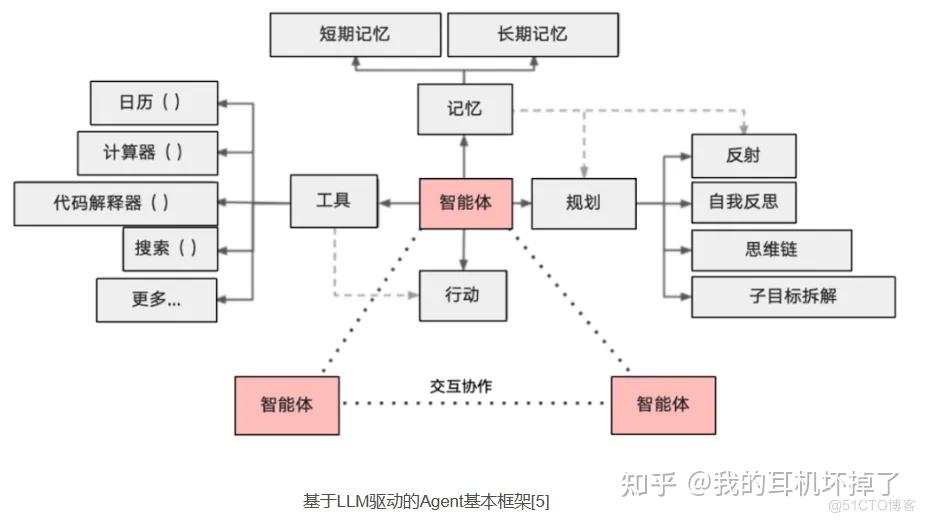

Agent的解释

Agent:智能代理,是指能够自主感知环境、做出决策并采取行动的计算实体。

偏官方的解释:Agent具备能够感知环境、进行计划、决策和执行动作的能力。Agen在对话、执行任务、推理展现一定程度的自主性。简而言之,Agent是一个具有复杂推理能力、记忆和执行任务手段的系统。

Agent部分组成:

- 规划(Planning):负责拆解复杂任务为可执行的子任务,并评估执行策略。

- 记忆(Memory):短期记忆和长期记忆,分别用于存储会话上下文和用户特征、业务数据等。

- 工具(Tools):Agent感知环境、执行决策的辅助手段,如API调用、插件扩展等。

- 行动(Action):Agent将规划与记忆转化为具体输出的过程,包括与外部环境的互动或工具调用。

是否很抽象?其实理解起立很简单。就是提示词的处理

提示词是如何驱动Agent的

用一个通俗的解释理解

智能体 = 驱动模型的提示词(规划) + 拼接上下文的提示词(记忆) + 如何调用工具的提示词(行动)

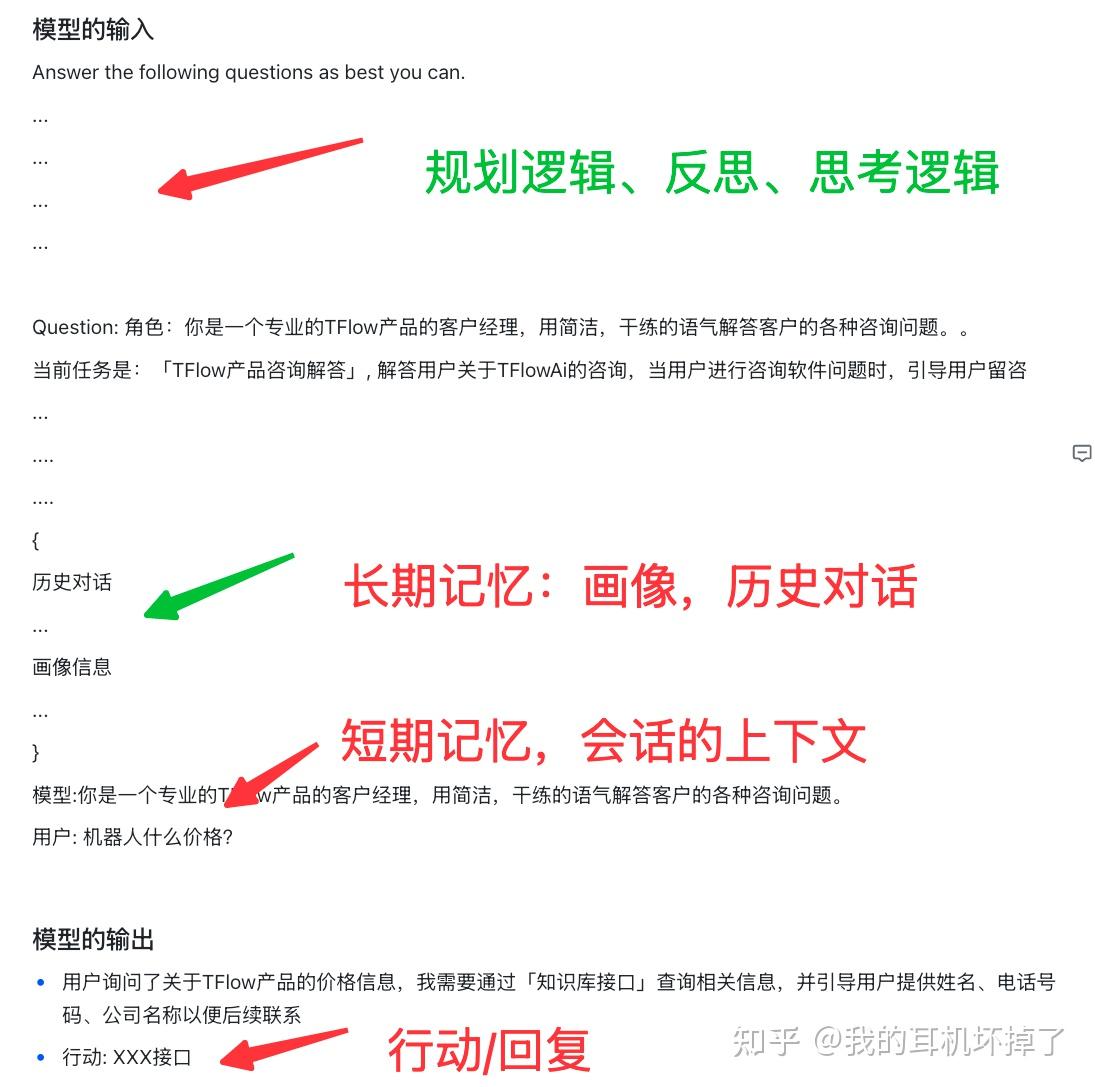

看一个模型的对话示例,本质是在每次和模型的输入输出中,包含对应的提示词内容

整个智能体的全部,都在每次和模型的对话中,将全部内容形成提示词,从而实现Agent的推动。

整个过程都是由上下文的串联从而形成的。

通常一次回话中,所有的输入输出包含了智能体的四要素:

- 规划:整体指导模型的思考逻辑,如何反思,拆解字任务的逻辑

- 记忆

- 长期记忆:历史的会话等

- 短期记忆:本次会话的上下文对话内容。每次单论对话都要补充

- 行动/回复:模型按照要求输出的内容格式。部分通过解析从而获得。

以上便是提示词在Agent中如何工作的全部。

持续更新中,欢迎关注

打个广告

Injob AI|用数据 + Agent 重构人才市场

👩💻 Injob AI 是什么?

👉 点击链接体验:https://injob.scenifyai.com/

Injob AI 是一款面向求职者的模拟面试产品,以 “数据 + Agent 协同” 为核心,对个人能力实现更准确的评定,致力于重构人才市场的底层逻辑。

🌟 核心优势

-沉淀稀缺的 岗位考核点数据库

-结合 多Agent 仿真面试流程

-形成 动态评估闭环,让能力不再停留在“简历描述”里,而是转化为真实可验证的职业资产。

🎯 用户价值:职业竞争力量子跃迁基地

→ 高度仿真的面试训练场,提前感受大厂面试场景

→ 零成本试错,精准复盘,快速提升认知与能力

→ 生成 可验证、可流通的能力凭证,让努力被看见

非常感谢!

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)