Prompt Engineering学习指南

核心Prompt技巧如角色扮演、思维链 (CoT)、少样本学习等,在不同行业应用时底层逻辑是一致的,主要是根据行业术语和特定任务流程进行适配和填充。Prompt不是简单的“提问”,而是未来人类与AI协作的编程语言。一个好的Prompt能精准地引导AI,将其庞大的知识和能力转化为你想要的、高质量的输出。:建立量化评估体系(如准确率、相关性分数),实现Prompt的A/B测试和CI/CD(持续集成/部

一、为什么学?-“心理路线图”

1.解锁AI的真正潜力:Prompt不是简单的“提问”,而是未来人类与AI协作的编程语言。一个好的Prompt能精准地引导AI,将其庞大的知识和能力转化为你想要的、高质量的输出。糟糕的Prompt则会让结果南辕北辙。

2.高回报的职业前景:专业的Prompt工程师是全球范围内的稀缺人才,薪资水平和发展前景非常可观。据LinkedIn 2024年报告(2025年LinkedIn新版《Jobs on the Rise》或《Future of Work》尚未发布),Prompt工程师岗位需求年增长率达187%,成为AI领域增长最快的职业之一。美国平均年薪$136,141(Glassdoor, 2025),中国头部企业年薪可达50-120万元。

3.跨行业适用性:Prompt工程不再是少数技术人员的“专长”。核心Prompt技巧如角色扮演、思维链 (CoT)、少样本学习等,在不同行业应用时底层逻辑是一致的,主要是根据行业术语和特定任务流程进行适配和填充。Prompt工程会像曾经的Office办公软件技能一样,从一项专门技术逐渐演变为一项每个知识工作者都需要掌握的基础职业技能。金融、医疗、教育、创意等行业均急需该技能。

二、学什么?-“技能树地图”

我们把Prompt工程的核心知识,拆解成1张地图,3个阶段、6大模块,具体如下:

Prompt学习技能树地图及工具箱

|

阶段 |

模块 |

核心技能点 |

具体学习内容 |

学习 成果 |

|

L1:入门 |

认知层 |

什么是Prompt?大模型如何“理解”? |

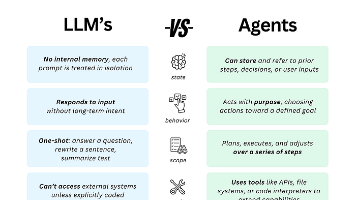

1.理解LLM原理:知其然(文本生成)并知其所以然(概率预测、基于训练数据的统计模型)。 2.核心概念:了解Token、Temperature、Top-P、频率惩罚等参数的基本影响。 3.局限性认知:理解模型的幻觉、知识截止日期和偏见问题。 |

能解释“为什么AI会胡说八道” |

|

基础层 |

清晰指令、角色扮演、格式控制 |

1.指令清晰:学习如何给出具体、无歧义的指令。 2.角色扮演:使用“你是一名...”为模型设定身份,约束其回答风格和范围。 3.格式指定:要求模型以JSON、Markdown、HTML等特定格式输出。 4.基础分隔符:使用"""、---等符号将指令与数据分开。 |

能让AI稳定输出“能用的答案” |

|

|

L2: 进阶 |

策略层 |

CoT(思维链)、Few-shot、Self-Consistency |

1.少样本学习(Few-Shot):提供高质量示例,让模型模仿解决新任务。 2.思维链(CoT):使用“让我们一步步思考...”引导模型展示推理过程,攻克逻辑难题。 3.自我反思(Self-Refine):让模型批判自己之前的输出并进行改进。 4.生成知识提示:先让模型生成相关事实,再利用这些知识回答最终问题。 |

能让AI解决“复杂推理题” |

|

工具层 |

Prompt模板库、自动化批处理、API调用 |

1.API调用:学习通过OpenAI、Anthropic或国内平台(文心、通义等) 的API与模型交互,脱离聊天界面。 2.自动化框架:初步使用 LangChain 或 LlamaIndex 等框架,实现多步骤的Prompt链式调用。 3.Function Calling:学会如何让模型理解和请求调用外部函数(如查数据库、计算、搜索),是构建AI智能体的核心。 |

能让AI“批量生产”内容 |

|

|

L3:专家 |

系统层 |

构建Prompt工作流、评估体系、持续迭代 |

1.提示词注入防御:在System Prompt中设计安全护栏,隔离用户输入,防止恶意攻击。 2.RAG架构:深入掌握检索增强生成,将模型与外部知识库连接,解决幻觉和时效性问题。 3.评估与迭代:建立量化评估体系(如准确率、相关性分数),实现Prompt的A/B测试和CI/CD(持续集成/部署)。 4.成本与延迟优化:优化Token使用,管理上下文窗口,平衡效果与性能开销。 5.AI智能体设计:设计多智能体协作(Multi-Agent)系统,完成规划、决策、执行等复杂任务。 |

能设计“AI+人类”的协作系统 |

|

融合层 |

跨界融合,探索前沿 |

1.领域深化:将Prompt工程与法律、金融、医疗、编程等特定领域知识深度融合,成为“AI+领域”专家。 2.模型微调结合:理解何时用Prompting,何时需要微调(Fine-Tuning),以及如何结合两者达到最佳效果。 3.模态扩展:探索图像、音频与文本的交叉提示(如对GPT-4V下达复杂视觉推理指令)。 4.人机协同设计:设计最优的人机交互循环,让人类专家在关键环节进行监督和修正。 |

能设计垂直领域的复杂AI Agent |

国内初学者从入门到精通学习资源推荐总表

|

模块 |

阶段 |

视频资源(中文为主) |

文档/白皮书 |

工具资源 |

社区资源 |

|

认知层 |

入门 |

•吴恩达《ChatGPT Prompt Engineering》(中文字幕版,B站) •百度AI Studio《提示工程入门》 |

•百度文心一言《提示词基础指南》 •阿里通义千问《开发者手册》 |

•百度文心一言在线调试工具 •智谱AI Token计算器 |

•知乎"提示工程"话题 •GitHub中文项目(LangGPT) •微信公众号"LangGPT" |

|

进阶 |

•深度求索《大语言模型应用实战》 •华为云《企业级AI系统设计》 |

• 百度《文心大模型技术白皮书》 • 中国信通院《生成式AI服务安全指南》 |

•Moonshot API高级调用示例 •DeepSeek API文档(中文) |

•ModelScope(魔搭社区) •GitHub(Dify/FastGPT源码) •阿里云开发者社区 |

|

|

专家 |

• 中国AI产业发展联盟《上下文工程前沿》 • 腾讯AI Lab《大模型优化》 |

• 阿里《通义千问企业级部署指南》 • 智谱AI《企业级提示工程白皮书》 |

• 企业级提示管理平台(百度文心企业版) • 多模型协同调度系统(智谱AI) |

• 中国计算机学会AI专委会 •GitHub(国内团队仓库) •生成式AI产业联盟 |

|

|

基础层 |

入门 |

• B站《大语言模型基础》(李宏毅中文授课) • 阿里云《LLM原理与实践》 |

• 智谱AI《大语言模型入门》 • DeepSeek《基础提示技术文档》 |

• 百度文心一言Playground • 阿里通义千问在线演示平台 |

• CSDN"大语言模型"板块 • GitHub(中文教程仓库) • 微信交流群"AI技术入门圈" |

|

进阶 |

• 斯坦福CS224N中文解读(B站"跟李沐学AI") • 华为云《Transformer架构解析》 |

• 《Attention Is All You Need》中文解读版 • 百度《提示工程最佳实践》 |

• 模型性能评估工具(ModelScope-Eval) • 提示模板生成器(LangGPT模板库) |

• 百度飞桨开发者社区 • GitHub(LangChain中文PR) • OpenI启智社区 |

|

|

专家 |

• 中科院《神经符号AI研究进展》 • 腾讯AI Lab《大语言模型优化》 |

• 华为《盘古大模型技术白皮书》 • 深度求索《DeepSeek模型训练指南》 |

• 模型压缩工具(AWQ中文文档版) • 提示优化框架(AutoPrompt中文社区版) |

• Papers With Code(中文解读) • GitHub(顶会论文复现) • 中国AI开源软件联盟 |

|

|

策略层 |

入门 |

• 阿里通义千问《提示词设计入门》 • B站《零样本提示实战教程》 |

• 智谱AI《提示词模板集》 • DeepSeek《基础提示技术文档》 |

• PromptPerfect(中文界面版) • 在线Token计算器(百度AI Studio工具集) |

• 小红书"AI提示词"话题 • GitHub(中文提示模板库) • 知乎AI板块 |

|

进阶 |

• 深度求索《思维链推理技术》 • 腾讯云《多模态提示工程》 |

• 阿里《通义千问高级提示策略》 • 《Chain-of-Thought Prompting》中文解读 |

• LangChain中文社区版 • Dify/FastGPT开发框架 |

• Learn Prompting中文社区 • GitHub(LangGPT项目) • AI Prompt工程师微信交流群 |

|

|

专家 |

• 百度研究院《动态提示优化》 • 中科院《多智能体提示协同》 |

• 腾讯《多模态提示工程白皮书》 • 华为《提示工程与模型微调协同》 |

• 动态提示生成引擎(Dify高级版) • 多模态提示工具(文心一格+ERNIE Bot) |

• 中国AI工程化论坛 • GitHub(AutoPrompt中文适配版) • 生成式AI产业联盟 |

|

|

工具层 |

入门 |

• 阿里云《API调用入门》(Python中文教程) • B站《OpenAI API中文教程》 |

• 百度文心一言API文档 • 阿里通义千问SDK使用指南 |

• 百度AI Studio Token计算器 • 提示测试平台(FastGPT调试工具) |

• GitHub(中文工具项目) • 腾讯云AI实验室 • CSDN"AI工具"板块 |

|

进阶 |

• Moonshot API高级用法(中文教程) • DeepSeek API调用实战 |

• Dify开发文档 • FastGPT框架使用指南 |

• 国产提示工程框架(Dify/FastGPT) • 提示管理系统(LangFlow中文社区版) |

• ModelScope(工具插件库) • GitHub(Dify/FastGPT源码) • 阿里云AI工具市场 |

|

|

专家 |

• 企业级LLMOps实践(百度智能云) • 多模型部署架构(阿里云) |

• 百度《文心大模型API企业级应用》 • 阿里《通义千问插件开发指南》 |

• 自定义工具开发(Dify插件SDK) • 大规模提示调度系统(FastGPT企业版) |

• OpenI启智社区(开源工具项目) • GitHub(企业级解决方案) • 百度文心企业版社区 |

|

|

系统层 |

入门 |

• 腾讯云《AI应用部署教程》 • B站《FastAPI+LLM部署》 |

• 阿里云《函数计算部署LLM指南》 • 百度《文心一言应用开发入门》 |

• Docker容器化工具(中文文档) • 轻量部署平台(Dify Cloud) |

• GitHub(简易部署案例) • 云原生社区中文论坛 • 微信公众号"AI部署实战" |

|

进阶 |

• 华为云《企业级AI系统架构》 • 百度智能云《多模型协同系统》 |

• 智谱AI《企业级应用架构设计》 • 阿里《通义千问高并发处理》 |

• Kubernetes AI部署工具(中文指南) • 应用监控平台(DeepSeek Monitor) |

• ModelScope(完整应用案例) • GitHub(RAG+Prompt融合方案) • KubeCon中文社区 |

|

|

专家 |

• 中国信通院《AI系统安全与治理》 • 百度《智能体技术架构》 |

• 腾讯《多模态智能体开发白皮书》 • 华为《盘古大模型企业级解决方案》 |

• 企业级AI治理平台(百度文心安全中心) • 智能体开发框架(LangGPT Agent) |

• 中国DevOps社区AI SIG • GitHub(多模型协同系统) • 华为云企业级解决方案论坛 |

三、怎么学—“学习路线图”

我们总结为“学(输入)—练(内化)—拆(解构)—创(输出)—社(生态)”五步学习法。

|

维度 |

核心心法 |

具体方法 |

关键原则 |

|

学 |

系统化知识构建 (从点到面,形成体系) |

1.分层递进学习:基础→进阶→前沿,按认知规律设计学习路径 2.问题驱动探究:以实际问题为锚点,定向研究解决方案 3.技术卡片积累:将核心知识点转化为标准化卡片(原理/场景/案例) 4.交叉学科融合:结合所处行业等跨界知识 |

1.先博后专,构建T型知识结构 2.理论联系实际,避免纯学术化学习 3.定期复盘,更新知识体系 |

|

练 |

刻意练习 (精准打击,强化肌肉记忆) |

1.分阶训练:基础技能→综合应用→复杂挑战,难度逐步提升 2.量化目标:设定可测量的训练指标(如"优化100个提示词,准确率≥90%") 3.反馈闭环:通过工具评估/社区点评/实际效果建立反馈机制 4.极限突破:针对薄弱环节进行专项强化(如"长文本提示优化特训") |

1.聚焦关键技能,避免盲目练习 2.注重质量而非数量,追求"刻意"而非"随意" 3.记录训练日志,追踪进步轨迹 |

|

拆 |

深度解构 (透视本质,提炼规律) |

1.结构分析:拆解案例的核心组件(角色/任务/约束/流程) 2.技术还原:识别使用的关键技术和设计模式 3.反向工程:通过输入变异测试推断提示逻辑 4.优化重构:在模仿基础上提出改进方案 |

1.不只看表面效果,更要探究设计原理 2.结合场景分析技术适用性,避免生搬硬套 3.从失败案例中学习教训,形成避坑指南 |

|

创 |

价值创造 (从0到1,实现能力转化) |

1.问题发现:从行业痛点中寻找创作方向 2.原型迭代:快速开发最小可行产品,通过用户反馈迭代 3.系统化输出:将碎片化成果整合为完整解决方案 4.商业验证:评估作品的实用价值和市场潜力 |

1.以解决实际问题为导向,避免为创新而创新 2.注重作品质量和用户体验,而非炫技 3.持续优化,追求可复用/可扩展的解决方案 |

|

社 |

生态协同 (开放共享,互利共生) |

1.知识共享:通过文章/演讲/工作坊分享经验 2.问题协作:参与社区项目,共同解决技术难题 3.反馈迭代:将作品置于社区环境中获取改进建议 4.标准共建:参与行业规范制定,推动技术标准化 |

1.秉持开放心态,既获取也贡献 2.注重高质量互动,避免低效社交 3.长期深耕,建立专业口碑和影响力 |

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)