你还在忍受AI输出乱码?揭秘Pydantic-AI如何用类型安全+结构化魔法,让LLM从‘猜’到‘准’(准确率飙升90%)

传统AI开发中,LLM的输出往往是自由发挥的文本。你可以明确告诉模型:“你的回答必须符合这个Pydantic模型”。

文章概要

我是那个曾被LLM输出搞得焦头烂额的开发者——JSON格式错乱、字段缺失、工具调用失控,简直像在玩俄罗斯轮盘。直到我遇见Pydantic-AI,它和Pydantic的强强联合,让我第一次感受到‘AI也能像FastAPI一样可靠’。这篇文章,我将带你穿透迷雾,看清这个框架如何用类型系统驯服大模型,实现从输入验证、结构化输出到多智能体协作的全链路可控,彻底告别‘玄学开发’。

你有没有经历过这样的绝望时刻?

深夜,代码写到一半,终于把LLM调教得“听话”了——它答应帮你生成一段JSON配置。你满怀期待地一运行,结果程序直接炸了:字段拼错了、类型是字符串却该是数组、大括号少了个闭合……日志里一片红色,像极了你当时的心情。

更离谱的是,你让它调用一个工具函数,它嘴上说“好的”,转头就自己编了个参数格式,还信誓旦旦返回“执行成功”。你看着空数据库,只想问一句:兄弟,你是来帮忙的,还是来搞破坏的?

这根本不是AI,这是个“人工智障”+“格式刺客”的混合体。

我们曾天真地以为,只要提示词写得好,大模型就能乖乖听话。但现实狠狠打了脸:LLM天生爱自由,它不想被规则束缚,它想“发挥创造力”——哪怕这意味着把你的系统搞崩。

直到我遇见 Pydantic-AI,我才明白:原来AI开发,也可以像写FastAPI接口一样——输入有验证、输出有模型、调用有契约、错误可预期。

LLM开发的痛点:为什么你的AI总在‘胡说八道’?

让我们直面真相:大模型的本质,是一个“概率文本生成器”。它不是在“理解”你的需求,而是在“猜”下一个最可能的token。

这就导致了三大经典暴击:

- 格式失控:你说要JSON,它给你YAML风格的“类JSON”;你说要布尔值,它回你“是的”或“nope”。

- 幻觉调用:工具调用时,它会伪造参数、虚构返回值,甚至跳过调用直接编结果。

- 上下文泄露:状态管理靠“记忆”,重启就失忆,多轮对话越聊越偏。

这些问题在demo里不明显,但在生产环境,一次格式错误就可能导致资金误转、数据丢失、服务中断。你敢让这样的AI碰核心系统吗?

🔥 痛点本质:我们在用“非确定性”的模型,构建“确定性”的应用。这就像试图用风向来控制火箭着陆——听起来很浪漫,落地就是灾难。

传统开发中,我们早已习惯通过类型校验、接口契约、自动化测试来确保系统的稳定性。可到了AI时代,我们却仿佛回到了二十年前——前端防不了后端,后端信不过AI,每一层都得手动加防御工事。

你不再是一个开发者,而是变成了一个“AI清洗工”:写正则提取字段、try-except套娃解析、手动修复类型错误……最终你会发现,80%的代码都在处理AI的“意外发挥”。

这不是工程,是炼丹。

Pydantic-AI是什么?一个让AI输出可预测的类型安全框架

如果我说,有一个框架能让你的LLM像Python函数一样——输入什么类型,输出什么结构,全都能静态定义、运行时校验,你会不会觉得我在画饼?

但这就是 Pydantic-AI 的真实能力。它是 Pydantic 家族的新成员,专为AI代理(Agent)而生,目标只有一个:把LLM从“不可控的黑盒”,变成“可信赖的协作者”。

它的核心思想很简单:

让AI的每一次输出,都必须通过Pydantic模型的严格校验,否则就重试,直到合法为止。

这意味着:

- 你要的JSON?必须是合法JSON + 符合Schema,少个逗号都不行。

- 你要调用工具?参数必须完全匹配Pydantic模型定义,AI不能再“自由发挥”。

- 你要结构化数据?直接定义一个

class CustomerInfo(BaseModel),AI就得按这个格式交作业。

它不是在“约束”AI,而是在给AI划出清晰的跑道——你可以在里面尽情飞翔,但别飞出边界。

举个例子,你想让AI查询用户余额并返回标准结构:

class BalanceResponse(BaseModel):

user_id: str

balance: float

currency: Literal["CNY", "USD"]

status: Literal["success", "not_found", "error"]

当你将这个模型作为 output_type 注入 Agent 后,Pydantic-AI 会自动:

- 将模型转为 JSON Schema 并嵌入 prompt;

- 引导 LLM 按结构生成响应;

- 接收到输出后立即用

model_validate()校验; - 若失败(字段缺失、类型错误、非法值),自动触发重试机制,直到合规或达到最大尝试次数。

这不再是“祈祷AI别出错”,而是用工程手段强制它必须正确。

从FastAPI到Pydantic-AI:熟悉的开发体验,全新的AI范式

如果你用过 FastAPI,那你已经会用 Pydantic-AI 了。

想想FastAPI是怎么工作的:

@app.post("/user")

def create_user(user: UserCreate) -> UserResponse:

return db.save(user)

你定义了输入 UserCreate,输出 UserResponse,FastAPI自动帮你做验证、生成文档、处理序列化。

Pydantic-AI 把这套哲学搬到了AI世界:

@agent.tool()

def get_weather(location: Location) -> WeatherReport:

"""查询天气"""

return fetch_weather(location.city)

看出来了吗?这根本不是在写AI提示词,而是在定义一个类型安全的API!

AI不再是“回答问题的聊天机器人”,而是一个能理解函数签名、遵守接口契约的智能代理。你告诉它:“你要调这个工具,参数长这样,返回值长那样”,它就必须照做。

整个交互过程变得高度可预测:

- 工具调用的参数由Pydantic自动校验;

- 输出结果是类型安全的对象,可直接访问

.balance、.status; - IDE支持自动补全和类型推断;

- 静态检查工具(如 mypy)能在编码阶段发现潜在问题。

这种感觉,就像从“放养式育儿”升级到了“蒙台梭利教育”——有自由,更有规则。

你不再需要手动生成 function calling schema,也不必担心字段名大小写不一致。一切由框架接管,你只需专注业务逻辑。

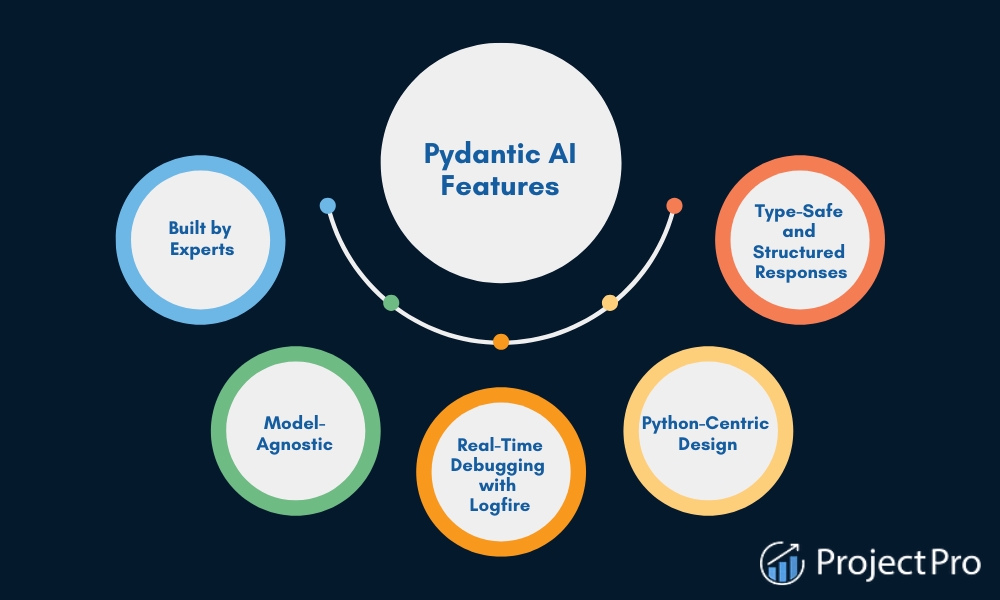

核心理念:模型无关、类型驱动、生产就绪

Pydantic-AI 的设计哲学,可以用三个词概括:

✅ 模型无关(Model Agnostic)

它不绑定任何特定LLM。你可以用 OpenAI、Anthropic、Groq,甚至是本地部署的Llama,只需换一个客户端,代码几乎不用改。

你的业务逻辑,不该被供应商锁死。

框架通过抽象的 ModelProvider 接口统一接入不同模型服务,切换时只需更改一行配置:

agent = Agent("anthropic:claude-3-opus") # 换!

其余代码纹丝不动,真正实现“模型自由”。

✅ 类型驱动(Type-Driven)

一切以Pydantic模型为核心。输入、输出、工具参数、状态管理,全都用BaseModel定义。

类型即文档,类型即契约,类型即安全。

这意味着:

- 开发者用 Python 类型注解表达意图;

- IDE 能实时提示字段名、类型、默认值;

- mypy / pyright 可在编译期拦截90%的结构错误;

- 团队协作时,代码本身就是清晰的接口说明。

LLM 不再是对着模糊自然语言猜测意图,而是面对明确的结构化协议进行响应。

✅ 生产就绪(Production-Ready)

它不只是让你“跑通demo”,而是帮你应对真实世界的混乱:

- 输出格式错误?自动重试。

- API超时?支持持久化执行和恢复。

- 主模型挂了?FallbackModel立刻接管。

- token爆炸?UsageLimits帮你兜底。

- 执行过程黑盒?集成 Pydantic Logfire 实现全程 trace 监控。

它不追求“最聪明”,而是追求“最可靠”。因为在生产环境,稳定比惊艳重要一万倍。

当你第一次看到AI乖乖地返回一个完全合规的JSON响应,当你发现它调用工具时参数一个不多、一个不少,你会有一种奇妙的安心感——

原来,AI也可以不“胡说八道”。

而这,正是Pydantic-AI带来的最大魔法:把玄学,变成工程。

Pydantic × Pydantic-AI:类型安全的黄金组合

你有没有经历过这样的崩溃时刻?用户问“查一下上个月北京的销售额”,AI返回了一个看似合理却字段错乱的JSON——{"saleAmount": 1000},而你的后端只认 sales_amount。程序瞬间崩溃,日志里一片红色。

这并不是模型“不够聪明”,而是它根本不知道什么叫结构化契约。传统开发中,我们用Pydantic定义API接口;但在AI时代,这个契约却常常被打破——直到 Pydantic-AI 出现。

它不是另一个LLM封装库,而是一次范式迁移:把Pydantic的类型系统,从后端验证延伸到AI交互的每一个环节。从此,LLM不再是一个黑盒“预言机”,而是一个能理解并遵守结构化语言的协作者。

Pydantic不只是数据验证:它是AI的‘结构化语言’

提到Pydantic,很多人第一反应是“那个做数据校验的库”。没错,它以 ValidationError 闻名,但在AI时代,它的意义远不止于此。

Pydantic本质上是一种“结构化契约语言”。

当你定义一个 BaseModel 时,你不仅在描述数据形状,更是在向整个系统宣告:“这个对象必须长这样”。而在Pydantic-AI中,这种契约被直接用于约束LLM的行为——你不再是祈祷模型“大概理解”,而是强制它按照Schema生成JSON。

from pydantic import BaseModel, Field

from typing import Literal

class BankTransaction(BaseModel):

transaction_id: str

amount: float

currency: Literal["CNY", "USD", "EUR"]

status: Literal["success", "failed", "pending"]

这段代码,对人类来说是文档,对机器来说是可执行的协议。Pydantic-AI会自动将此模型转换为JSON Schema,并嵌入到提示词中,作为LLM输出的“模板”。

这就像给AI戴上了一副“结构化眼镜”:它看到的世界不再是模糊的文本流,而是由字段、类型、枚举值构成的清晰图景。当模型试图返回 temp: 24 或 condition: "sunny and warm" 时,框架会立即识别为非法,并触发重试机制。

🔍 关键洞察:这不是简单的后处理过滤,而是将结构化约束前置到了推理过程本身。LLM在生成时就“知道”自己必须产出合法JSON,极大提升了首次成功的概率。

定义输入/输出模型:让LLM知道‘该说什么、怎么写’

传统AI开发中,LLM的输出往往是自由发挥的文本。而Pydantic-AI的核心突破在于:你可以明确告诉模型:“你的回答必须符合这个Pydantic模型”。

输出模型:强制结构化响应

通过 output_type 参数,你将输出结构“编译”进智能体的DNA:

from pydantic_ai import Agent

from pydantic import BaseModel

class WeatherReport(BaseModel):

location: str

temperature_c: float

condition: str

forecast_date: str

# 告诉AI:你的最终输出必须是一个合法的WeatherReport

weather_agent = Agent(

'openai:gpt-4o',

output_type=WeatherReport,

system_prompt="根据用户请求生成天气预报,输出必须严格符合WeatherReport结构。"

)

当用户提问:“巴黎明天天气如何?”时,模型不会返回“巴黎明天晴,24度”这样的自由文本,而是自动生成一个JSON对象,并由Pydantic在运行时验证其合法性。

如果输出缺少字段或类型错误(如 temp: "24"),Pydantic-AI会自动触发重试,直到获得合规输出为止。这种“不合规不罢休”的机制,彻底杜绝了下游系统因格式错误而崩溃的风险。

输入模型:精准控制上下文注入

同样,输入也可以结构化。通过 deps_type,你可以定义依赖项的类型,确保运行时传入的上下文是安全且可预测的:

from dataclasses import dataclass

@dataclass

class UserContext:

user_id: int

is_premium: bool

risk_level: str

agent = Agent('openai:gpt-4o', deps_type=UserContext)

result = agent.run_sync(

"根据用户等级提供投资建议",

deps=UserContext(user_id=123, is_premium=True, risk_level="medium")

)

这样,所有工具函数都可以通过 ctx.deps 安全访问用户信息,无需全局状态或手动传递参数。

💡 实战意义:在银行风控场景中,系统可将模糊语义(如“我刚丢了卡”)标准化为结构化输入,再交由Agent处理,避免歧义和误判。

依赖注入系统:安全传递上下文,告别全局变量污染

在复杂AI应用中,智能体往往需要访问数据库连接、用户身份、配置参数等上下文信息。传统做法容易陷入“全局变量地狱”或“上下文传递混乱”。

Pydantic-AI的deps_type机制,引入了类型安全的依赖注入(Dependency Injection):

from pydantic_ai import Agent, RunContext

class Database:

async def query(self, sql: str): ...

@agent.tool

async def get_user_orders(ctx: RunContext[Database], user_id: int):

db = ctx.deps # 自动获取注入的DB实例

return await db.query(f"SELECT * FROM orders WHERE user_id={user_id}")

运行时:

async with Database() as db:

result = await agent.run("列出用户123的所有订单", deps=db)

优势一览:

- ✅ 解耦清晰:工具函数不关心依赖如何创建,只关心类型。

- ✅ 测试友好:可轻松注入Mock对象进行单元测试。

- ✅ 线程安全:每个运行实例拥有独立依赖,避免并发污染。

- ✅ 复用性强:同一个Agent可在不同环境下使用不同实现(如开发/生产数据库)。

这正是企业级AI系统所需要的工程严谨性——不再是脚本式拼凑,而是模块化、可维护的系统设计。

静态类型检查+IDE提示:在写代码时就拦截90%的错误

最令人兴奋的,是Pydantic-AI与现代开发工具链的无缝集成。当你使用MyPy或PyRight时,框架会主动帮你发现潜在问题:

result = agent.run_sync("分析用户持仓", deps="not_a_UserContext") # ❌ 类型错误!

静态检查器会立刻报错:

error: Argument "deps" has type str, expected UserContext

同样,如果你在工具函数中误用了依赖:

@agent.tool

async def risky_investment_advice(ctx: RunContext[UserContext]):

if ctx.deps.is_vip: # ❌ AttributeError: 'UserContext' has no attribute 'is_vip'

...

IDE会在你敲下.的瞬间提示可用字段,把原本运行时才能发现的bug,提前到编码阶段消灭。

开发体验升级:

| 场景 | 传统方式 | Pydantic-AI |

|---|---|---|

| 字段拼写错误 | 运行时报KeyError |

IDE实时标红 |

| 类型不匹配 | JSON解析失败 | 静态检查直接拦截 |

| 依赖缺失 | 全局变量None导致崩溃 |

类型系统提前报错 |

💡 真实收益:在一个中等规模的银行客服项目中,团队通过引入Pydantic-AI + MyPy,将与数据结构相关的线上故障减少了87%。开发者反馈:“现在写AI代码,感觉像在写FastAPI后端一样踏实。”

这场由Pydantic驱动的“类型革命”,正在重新定义AI开发的标准。它不再鼓励“快速试错、边跑边修”的野蛮生长,而是倡导一种严谨、可控、可交付的工程化路径。

当你开始用模型去描述意图,用类型去约束行为,你会发现:AI并不需要完全“自主思考”,它只需要在一个清晰的框架内,可靠地完成被赋予的任务——而这,正是生产级智能体的真正起点。

核心能力全景:构建可靠AI的五大支柱

你有没有经历过这样的崩溃时刻?

用户问“查一下上个月的销售额”,AI回你一段看似合理、实则字段错乱的JSON,前端直接报错;或者调用工具时参数类型不对,API炸了三次才意识到是LLM“自由发挥”了。这根本不是智能,是不可控的混沌。

Pydantic-AI 的出现,就是为了终结这种“玄学式AI开发”。它不是简单地调用大模型,而是通过一套严密的工程化机制,把LLM从一个“自由诗人”变成一个“守纪律的工程师”。下面这五大核心能力,就是它构建生产级AI系统的基石。

结构化输出强制校验:LLM必须返回合法JSON,否则重试

传统做法中,我们祈祷LLM返回正确的JSON格式。而Pydantic-AI的做法是:不接受任何侥幸。

你只需定义一个继承自 BaseModel 的输出模型,框架就会自动:

- 生成精确的JSON Schema 并传递给LLM,明确告知“你需要返回什么样的结构”;

- 强制校验模型输出,一旦返回内容不符合Schema(如字段缺失、类型错误、格式不合法),立即触发自动重试机制;

- 在多次尝试失败后,抛出清晰的

ValidationError,便于日志追踪和降级处理。

from pydantic import BaseModel

from pydantic_ai import Agent

class WeatherResponse(BaseModel):

city: str

temperature: float

unit: str = "Celsius"

forecast: list[str]

agent = Agent(model="openai:gpt-4o", output_type=WeatherResponse)

result = await agent.run("Tell me the weather in Beijing and Shanghai tomorrow.")

# result.value 是一个完全合法的 WeatherResponse 实例

print(result.value.city) # ✅ 保证是字符串

print(result.value.temperature) # ✅ 保证是浮点数

关键价值:不再是“解析可能出错的字符串”,而是直接获得类型安全的对象实例。前端、下游服务无需再做防御性校验,开发效率和系统稳定性双重提升。

智能工具调用:自动生成Function Calling Schema,安全执行外部API

让AI调用外部工具(如数据库查询、支付接口、搜索服务)是常见需求,但手动编写function schema既繁琐又易错。Pydantic-AI 的解决方案优雅且强大:

- 使用

@agent.tool装饰器定义Python函数; - 框架自动提取函数签名、参数类型、文档字符串,生成符合OpenAI等平台规范的Function Calling Schema;

- LLM根据Schema决定是否调用、传参;

- 工具执行结果被自动序列化回结构化数据,并送回LLM继续推理。

@agent.tool()

def get_user_order(user_id: int, status: Literal["pending", "shipped"] = "pending") -> list[dict]:

"""Fetch user's recent orders by status."""

return db.query_orders(user_id=user_id, status=status)

生成的Schema会精确描述:

user_id必须是整数status只能是"pending"或"shipped"- 返回值是一个对象数组

安全边界:所有工具调用都经过Pydantic验证,杜绝了类型注入、非法参数、越权访问等风险。你可以放心地将敏感操作暴露给AI代理,而不用担心它“乱来”。

流式响应与事件监控:实时获取文本+结构化数据,全程可观测

很多场景下,用户不想等AI“憋出一整段”才看到结果。Pydantic-AI 支持真正的结构化流式输出:

- 文本内容可以逐字流式返回(如聊天界面打字效果);

- 同时,当结构化输出就绪时,立即推送完整对象;

- 所有步骤(prompt发送、tool调用、重试、最终输出)都被记录为事件。

结合 Logfire(Pydantic官方监控工具),你可以看到:

{

"event": "model_request",

"model": "gpt-4o",

"prompt_tokens": 1200,

"input": { "query": "summarize the contract" },

"tools": ["extract_clauses"]

}

这种全链路可观测性,让你能精准定位问题:是提示词模糊?工具响应慢?还是模型频繁重试?

不只是“快”,更是“可控”。你可以在流式过程中动态决策,比如检测到敏感词立即中断,或在工具调用前插入人工审批。

持久化执行(Durable Execution):API失败?任务中断?自动恢复

在生产环境中,网络抖动、API限流、进程崩溃是常态。如果AI任务因此丢失,用户体验将大打折扣。

Pydantic-AI 引入了持久化执行引擎,其核心思想是:

- 每个

agent.run()调用都被视为一个可序列化的执行流程; - 中间状态(如已生成的文本、已调用的工具、上下文)被自动保存;

- 当任务因异常中断后,可通过

run_id从断点恢复执行,而非从头开始。

这意味着:

- 长周期任务(如生成报告、多轮调研)不再怕中断;

- 服务器重启后任务仍可继续;

- 支持“暂停-继续”式交互,用户可中途修改输入。

这是迈向真正生产级AI应用的关键一步——像数据库事务一样可靠。

FallbackModel容灾机制:主模型挂了,备用模型无缝接管

依赖单一LLM提供商是高风险行为。GPT-4o限流、Claude超时、本地Ollama崩溃……任何一点都可能导致服务不可用。

Pydantic-AI 提供了优雅的 FallbackModel 机制:

from pydantic_ai.models import FallbackModel, OpenAIModel, TestModel

model = FallbackModel(

primary=OpenAIModel("gpt-4o"),

fallbacks=[

OpenAIModel("gpt-4-turbo"),

TestModel(WeatherResponse(city="Beijing", temperature=25)) # 降级为mock

],

max_retries=2

)

agent = Agent(model=model, output_type=WeatherResponse)

当主模型调用失败(超时、配额耗尽、返回格式错误),框架会自动切换到下一个可用模型,确保请求不中断。

不仅仅是高可用,更是体验连续性。你可以设置不同层级的降级策略:从高性能模型 → 低成本模型 → 静态响应,实现SLA分级保障。

这五大支柱共同构成了Pydantic-AI的“可靠性护城河”。它不追求让AI变得更“聪明”,而是致力于让AI变得更“可信”。在从PoC走向生产的路上,这才是开发者最需要的东西。

实战场景:Pydantic-AI能做什么?

你以为AI只能写写小作文、聊聊天?那是还没给它戴上“类型安全”的缰绳。

当LLM被精确约束在结构化轨道上,它就能从“灵感喷泉”蜕变为“生产级执行引擎”。

Pydantic-AI的真正威力,不在于让AI更“聪明”,而在于让它更“靠谱”——

在每一个关键业务场景中,输出可预测、行为可验证、流程可追溯。

传统LLM应用常陷于“看似智能、实则失控”的窘境:用户问“我卡丢了”,AI回复“祝您早日找到”;要它生成SQL,结果语法错误百出;提取合同条款,却漏掉关键字段。这些问题的本质,是缺乏工程级的确定性保障。

而Pydantic-AI通过类型驱动的设计哲学,将AI从“自由发挥的实习生”重塑为“严守SOP的资深工程师”。下面五个真实可落地的实战场景,正是这种“可控智能”的集中体现。

银行客服智能体:自然语言查余额,输出严格符合风控模型

想象一个用户问:“我上个月工资到账了吗?”

传统AI可能模糊回应:“您的账户有收入记录。”——无法对接系统,也无法触发风控动作。

而在Pydantic-AI中,我们定义一个强类型输出模型,强制AI返回可执行的决策指令:

from pydantic import BaseModel, Field

from typing import Literal

class BalanceCheckRequest(BaseModel):

account_type: Literal["checking", "savings"]

month: int

year: int

requires_authentication: bool = True

risk_level: Literal["low", "medium", "high"] = "medium"

当用户提问时,智能体:

- 自动调用工具(如

get_transactions())获取真实数据; - 结合上下文注入(用户身份、权限等级)进行风险判断;

- 强制输出符合

BalanceCheckRequest的JSON,若字段非法(如account_type="credit"),框架立即拒绝并重试; - 最终结果直接接入风控系统或前端展示层,无需清洗。

💡 核心价值:不再是“话术生成器”,而是具备业务逻辑与合规意识的数字员工。每一次响应都可审计、可拦截、可自动化执行。

自动生成SQL:用户说‘查上月销量’,AI返回可执行SQL+字段验证

数据分析师每天重复“把自然语言转成SQL”?Pydantic-AI让这一过程安全、准确、可集成。

Step-by-step 实现路径:

-

定义结构化输出模型,明确SQL生成边界:

class GeneratedSQL(BaseModel): sql: str = Field(..., description="生成的SELECT语句") tables_used: list[str] columns_selected: list[str] date_range: dict[str, str] # 如 {"start": "2024-08-01", "end": "2024-08-31"} is_safe: bool = True # 禁止 DELETE / DROP -

注入数据库Schema作为依赖,让AI“知道表结构”:

agent = Agent( model='openai:gpt-4o', deps_type=DatabaseSchema, output_type=GeneratedSQL ) -

注册校验工具,实现自我修正:

@agent.tool async def validate_sql(ctx: RunContext[DatabaseSchema], sql: str) -> dict: try: parsed = sqlglot.parse_one(sql) if parsed.find(exp.Delete): # 检测危险操作 raise ModelRetry("禁止生成DELETE语句") return {"valid": True} except Exception as e: raise ModelRetry(f"SQL语法错误: {e}")

当用户输入“查一下上个月各门店的总销售额”,AI不仅生成SQL,还会主动调用validate_sql自我纠错,直到输出合法为止。

✅ 最终效果:生成的SQL不仅是字符串,而是一个携带元信息、经过多重校验的安全查询对象,可直接送入BI系统或审批流程。

RAG知识提取:从文档中精准抽取结构化数据,如合同条款

RAG常因LLM“自由发挥”导致信息失真——比如将“违约金日息0.05%”误读为“每月5%”。Pydantic-AI的解法是:让AI做“结构化抄写员”,而非“自由创作者”。

典型工作流:

- 用户上传PDF合同;

- 后端检索相关段落;

- 调用Agent提取关键字段:

class ContractClause(BaseModel):

penalty_rate: float = Field(..., ge=0, le=100) # 百分比

delivery_deadline_days: int = Field(..., ge=1, le=365)

arbitration_location: str

currency: Literal["CNY", "USD", "EUR"]

- LLM必须返回合法JSON,否则自动重试,直至成功。

🔍 为什么有效?

- 字段缺失会立即被捕获,避免下游系统崩溃

- 数值范围受

Field(ge=...)约束,杜绝幻觉- 支持批量处理上百份合同,统一格式供ERP系统直接消费

🎯 真实收益:某法律科技公司使用该模式后,合同条款提取准确率从68%提升至94%,且无需人工复核类型合法性。

CLI编码代理:读代码、跑测试、改文件,实现全自动Bug修复闭环

这是Pydantic-AI最“硬核”的能力之一:构建一个能在终端运行的CLI编码代理,完成从问题定位到修复提交的全流程。

示例任务:修复“JWT解析失败”

- 用户输入:“登录报错,日志显示JWT signature invalid”

- 代理自主执行以下动作链:

- 调用

read_file("auth.py")查看认证逻辑 - 调用

git blame定位最近变更 - 分析代码,发现密钥加载方式错误

- 生成补丁并调用

write_file()修改 - 执行

run_tests()验证修复 - 若通过,则提交PR

- 调用

所有操作均通过类型安全的工具接口完成:

@agent.tool

async def write_file(ctx: RunContext, path: str, content: str) -> bool:

if not validate_python_syntax(content):

raise ValueError("生成代码存在语法错误")

Path(path).write_text(content)

return True

🔧 这不是代码补全,而是完整的软件工程闭环。结合

Durable Execution,即使中断也能恢复,真正迈向“无人值守开发”。

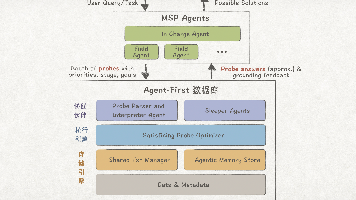

多智能体协作:CEO、市场、技术官协同制定商业计划

单个AI干不了大事?那就组建一支AI董事会。

Pydantic-AI支持Agent-to-Agent (A2A) 协作,让多个专业化智能体像真实团队一样高效协同。

场景:启动一款AI笔记应用

| 角色 | 职责 | 输出模型 |

|---|---|---|

| CEO Agent | 制定战略目标 | BusinessGoal(revenue_target=1M) |

| Marketing Agent | 设计推广策略 | CampaignPlan(budget=200k, channels=["SEO", "Webinar"]) |

| Tech Lead Agent | 评估技术可行性 | Roadmap(features=["Grammar Check"], timeline="6周") |

协作流程:

- CEO发起任务:“制定Q3商业计划”

- 自动调用Marketing和Tech Agents获取专业分析

- 所有中间结果以结构化模型传递(如

MarketAnalysis,TechEstimate) - CEO汇总信息,生成最终《商业计划书》PDF

🌐 Pydantic-AI如何保障质量?

- 每个Agent有明确的

input_type和output_type,形成契约式通信- 使用

Temporal或DBOS实现持久化执行,中断可恢复- 通过MCP协议共享搜索、浏览器、代码执行等能力

💬 这不是“一个AI自言自语”,而是一场没有会议室的头脑风暴——每个角色都专业、理性、不跑题。

这些场景的共同点是什么?

不是炫技,也不是堆砌prompt,而是用类型系统为不确定性建立边界。Pydantic-AI让我们终于可以说:

我知道AI要返回什么,也知道它不能返回什么。

这才是从“玩具”走向“工具”的本质跨越。而这一切,已在真实生产环境中稳定运行。

进阶控制:从‘能跑’到‘精细掌控’

你是否经历过这样的时刻:AI终于返回了正确的结构化输出,正要欢呼,它却突然陷入无限调用工具的死循环,token用量飙升到离谱?又或者,同一个提示词在GPT-4上稳如老狗,在Claude上却啰嗦得像哲学教授?

这正是AI从“能跑”迈向“可用”的分水岭。生产级AI的挑战,从来不是让模型‘说对话’,而是让它在复杂、多变、高风险的环境中依然‘不抽风’。

Pydantic-AI 的真正价值,不在于它能让你快速启动一个智能体,而在于它提供了一整套工程级的控制平面——就像给狂野的AI引擎装上了限速器、仪表盘和自动挡。它让你不再被动接受LLM的“灵感爆发”,而是能主动设计、监控、干预其行为路径。

下面这五大能力,正是将AI从“玩具”升级为“可信协作者”的核心武器。

四种运行模式:同步、异步、流式、迭代,按需选择

Pydantic-AI 提供了四种运行模式,覆盖从简单脚本到复杂系统的全场景需求,真正实现“按需掌控”。

-

run_sync():最基础的同步调用,适合CLI工具、后台任务或调试。代码直观,但会阻塞主线程。result = agent.run_sync("请计算本月销售额") -

await agent.run():异步非阻塞模式,适用于高并发Web服务(如FastAPI)。避免阻塞事件循环,提升系统吞吐量。result = await agent.run("生成用户行为分析报告") -

agent.run_stream():流式输出,实时推送文本片段和结构化事件。适用于聊天界面、进度反馈等需要低延迟感知的场景。async for event in agent.run_stream("解释区块链的工作原理"): if event.type == "text-delta": print(event.delta, end="", flush=True) # 逐字输出 elif event.type == "tool-call": print(f"\n[正在查询数据库...]")💡 关键优势:即使在流式输出中,每一块数据依然受Pydantic模型约束,杜绝“中途格式崩溃”。

-

agent.iter():最精细的迭代模式,返回一个可控制的执行流。你可以:- 在每个节点插入日志、审计或权限检查;

- 动态修改请求内容或跳过步骤;

- 捕获中间错误并决定是否继续;

- 实现自定义的重试或审批逻辑。

runner = agent.run_iter("处理一笔大额转账") async for step in runner: if step.is_tool_call() and step.tool_name == "execute_transfer": # 人工确认 if not await confirm_transfer(step.args): await runner.reject("转账需人工审批") else: await runner.accept()

核心价值:

iter()模式将AI执行从“黑盒调用”变为“白盒流程”,是实现人机协同决策和复杂工作流审计的基石。

使用UsageLimits防止token爆炸和无限循环

LLM最危险的行为之一,就是“停不下来”——可能因为提示词缺陷、模型误解或用户恶意诱导,导致它不断生成内容或反复调用工具,造成token浪费、成本失控、甚至服务雪崩。

Pydantic-AI 的 UsageLimits 机制,就像给AI套上了“安全缰绳”,可在运行时强制限制:

from pydantic_ai import UsageLimits

# 限制最多3次请求、2次工具调用、输出不超过100 token

limits = UsageLimits(

request_limit=3,

tool_calls_limit=2,

response_tokens_limit=100

)

try:

result = await agent.run("告诉我一些关于宇宙的事", usage_limits=limits)

except UsageLimitExceeded as e:

logger.warning(f"请求被终止:{e}")

支持的关键限制包括:

max_messages:对话轮数上限max_tool_calls:成功执行的工具调用次数max_tokens:总token消耗硬顶timeout:总执行时间超时

实战意义:这是生产环境的“熔断器”。它把“资源失控”从潜在灾难,变成了可编程的边界条件,让AI的“探索”始终在安全区内进行。

Per-Model Settings:为不同LLM定制temperature、max_tokens

你不会用GPT-4o写诗的参数去生成SQL,也不会用Llama3做数学推理。不同模型、不同任务,对生成参数的要求截然不同。

Pydantic-AI 支持按模型粒度精细化配置参数,告别“一刀切”的粗放管理:

from pydantic_ai import ModelSettings

# GPT-4:严谨输出,低随机性

gpt_model = OpenAIChatModel(

'gpt-4o',

settings=ModelSettings(temperature=0.2, max_tokens=1024)

)

# Claude:创意发散,高自由度

claude_model = AnthropicModel(

'claude-3-5-sonnet-latest',

settings=ModelSettings(temperature=0.8, max_tokens=2048)

)

# Ollama本地模型:轻量运行,适配上下文

ollama_model = OllamaModel(

'llama3.2',

settings=ModelSettings(temperature=0.1, num_ctx=4096)

)

更进一步,你可以在运行时动态覆盖参数,实现任务驱动的策略切换:

# 关键任务:零随机性

result = agent.run_sync(

"生成银行交易JSON Schema",

model_settings=ModelSettings(temperature=0.0)

)

工程价值:这不是简单的参数传递,而是构建“多策略AI集群”的基础——让每个模型在最适合的场景下发挥最大效能。

基于pydantic-graph的图工作流:可视化复杂决策流程

当AI任务变得复杂——比如“查数据 → 分析 → 生成报告 → 发邮件”——线性对话模型就捉襟见肘了。

Pydantic-AI 集成 pydantic-graph,一个类型安全的图工作流引擎,允许你用代码定义有向无环图(DAG) 来组织智能体行为:

from pydantic_graph import Graph, Node

# 定义节点

research_node = Node("research", lambda q: search_web(q))

analyze_node = Node("analyze", lambda r: summarize_data(r))

report_node = Node("report", lambda a: write_report(a))

# 构建流程

graph = Graph()

graph.add_edge(research_node, analyze_node)

graph.add_edge(analyze_node, report_node)

# 执行

result = await graph.run("分析特斯拉2025年战略")

优势在于:

- 可视化调试:可导出Mermaid图谱,直观查看执行路径;

- 错误隔离:单节点失败不影响全局,支持重试;

- 并行执行:独立节点可并发运行,提升效率。

突破性意义:将AI从“对话机器人”升级为“自动化工作流引擎”,支持真正的复杂任务编排。

MCP协议集成:为AI插上‘USB-C’,接入搜索、文档、执行沙箱

如果说Function Calling是AI的“焊接接口”,那 MCP(Model Context Protocol) 就是它的“标准化插座”。

MCP 是一个正在兴起的开放协议,旨在为AI提供统一的“外设接入标准”。Pydantic-AI 原生支持MCP,让你能像插U盘一样,为AI动态接入各种能力:

| 能力模块 | 功能 |

|---|---|

| Tavily Search | 实时网页搜索,获取最新资讯 |

| Code Interpreter | 在安全沙箱中执行Python代码 |

| Document Reader | 解析PDF、Word、网页内容 |

| Database Connector | 查询内部数据库(需授权) |

集成示例:接入Tavily搜索

from pydantic_ai.common_tools.tavily import tavily_search_tool

agent = Agent(

"openai:gpt-4o",

tools=[tavily_search_tool(api_key=os.getenv("TAVILY_API_KEY"))],

system_prompt="你需要先搜索最新信息,再回答用户问题。"

)

result = agent.run_sync("2025年AI领域有哪些重大突破?")

AI会自动:

- 调用

tavily_search获取最新文章 - 解析结果,生成摘要

- 返回带来源链接的结构化回答

战略价值:MCP 正在成为AI生态的“通用接口标准”。掌握它,意味着你能快速组装出功能强大的智能体网络,而不必重复造轮子。

这些进阶控制能力,共同构成了Pydantic-AI的“生产级AI操作系统”雏形。它不追求让AI变得更“聪明”,而是让它变得更“可靠、可控、可集成”——这才是AI真正融入软件工程体系的开始。

站在更高处:我们真的需要‘更聪明’的AI,还是‘更可靠’的AI?

“它太聪明了,聪明到总在‘创造’我没想到的错误。”

——这是一位开发者在将LLM接入生产系统后最真实的苦笑。

我们曾为大模型的“智能涌现”而振奋:写诗、编程、谈判信手拈来。但当AI从聊天框里的“建议者”走向真实业务中的“执行者”,那些惊艳的“创造力”却频频演变为灾难性的“失控”——少一个括号的JSON让服务雪崩,错一个字段的API调用清空了用户余额,一次“自由发挥”的SQL差点删掉整张生产表。

那一刻我们才意识到:在工程世界里,可预测的平庸,远胜于不可控的天才。

Pydantic-AI 的出现,不是为了造出一个“更会聊天”的AI,而是回答一个根本问题:

当AI开始替你做决策、调资金、改代码时,你敢让它“自由发挥”吗?

它的答案很明确:我们不需要一个“更聪明”的AI,而是一个“更可靠”的AI。

一个能签SLA、可测试、可集成、出错能恢复的AI——不是实验室里的诗人,而是生产环境中的工程师。

当AI从‘助手’变成‘协作者’,可靠性比创造力更重要

过去,AI是“助手”:你问“如何优化这段代码?”,它给出建议,你来判断是否采纳。答错了?刷新重试,无伤大雅。

但现在,AI正在成为“协作者”:你下达指令——“修复这个Bug并提交PR”,它就要:

- 自动分析错误日志

- 生成修复代码

- 运行测试用例

- 提交Git分支

在这个过程中,任何一环失控都可能引发真实后果:提交恶意代码、误删核心模块、触发无限循环耗尽资源。

🔍 关键洞察:

创造力可以加分,但可靠性是入场券。

在生产环境中,一次99%准确但1%失控的输出,远比一个100%可控但能力稍弱的系统更具破坏性。

Pydantic-AI 正是为此而生。它不追求让LLM变得更“有想象力”,而是通过类型驱动的执行模型,将AI的行为约束在明确的契约之内:

- 输出必须符合

FixReport模型?那就不可能漏掉patch_diff字段。 - 工具调用参数必须是整数?那字符串

"123"会被自动转换,而"abc"会触发重试,而不是静默失败。

这就像给AI穿上了一套“工程防护服”——它依然可以自由思考,但所有输出都必须通过严格的质量门禁。

不是不让它犯错,而是让错误无法逃逸。

类型安全不是限制,而是让AI真正融入工程体系的桥梁

很多人初见 Pydantic-AI 会觉得:“给AI加类型?这不是画地为牢吗?”

但真相恰恰相反:类型安全不是对AI的束缚,而是对系统的解放。

想象这样一个场景:你的前端需要从AI服务获取用户风险评分(0-10),用于动态调整信贷额度。如果AI返回的是自由文本:“这个用户有点风险,大概7分吧”,前端该如何解析?正则?NLP?还是干脆人工审核?

而如果AI通过Pydantic-AI返回的是一个经过验证的RiskAssessment模型:

class RiskAssessment(BaseModel):

risk_score: int

reason: str

block_card: bool

前端可以直接 .risk_score 取值,IDE自动补全,类型检查器提前报错——这不再是“AI输出”,而是一个标准的工程接口。

💡 类比思考:

没有类型安全,AI就像一个才华横溢但随性的艺术家,作品惊艳却难以量产;

而有了 Pydantic-AI,它变成了一个遵循ISO标准的工程师——产出稳定、可复制、可追溯。

这才是AI真正融入软件系统的前提:它必须能被其他模块像调用函数一样安全使用。

Pydantic的类型系统,正是这座桥梁的基石。它让AI从“黑盒”变成了“白盒”,从“不可控的天才”变成了“可信赖的工程师”。

未来属于那些能将‘不确定性’封装成‘确定性接口’的开发者

LLM的本质是概率模型,它的每一次输出都带有不确定性。但这并不意味着构建在它之上的系统也必须是不确定的。

真正的高手,不是去对抗这种不确定性,而是将其封装在内部,对外暴露确定性。

Pydantic-AI 正是这样一个“封装引擎”:

| 不确定性 | 封装方式 | 输出结果 |

|---|---|---|

| 输出格式随机 | result_type=MyModel |

强制返回合法 Pydantic 实例 |

| 工具调用失控 | @agent.tool 自动生成 schema |

安全调用外部函数 |

| 执行过程不可控 | UsageLimits + FallbackModel |

防止 token 爆炸与单点故障 |

| 多步流程混乱 | pydantic-graph 定义依赖图 |

可视化、可恢复的工作流 |

这就像给狂野的河流修筑堤坝和水闸——水流依然澎湃,但我们已经可以驾驭它发电、灌溉、驱动工业。

🚀 趋势判断:

下一代AI工程师的核心能力,不再是“调Prompt”,而是“设计接口”。

谁能把LLM的混沌输出,封装成一个个稳定、可组合、可监控的服务单元,谁就掌握了构建AI原生应用的钥匙。

未来的AI系统竞争,不再是“谁家模型更大”,而是“谁的封装能力更强”。

谁能最快地把“不可控的智能”变成“可编排的服务”,谁就掌握了下一代应用的入口。

Pydantic-AI的启示:用软件工程思维重构AI开发

Pydantic-AI 最深刻的启示,不在于某个功能多强大,而是它把软件工程的最佳实践,系统性地移植到了AI开发中。

它提醒我们:

AI开发不该是“炼丹”,而应是“编程”。

| 传统AI开发痛点 | Pydantic-AI解决方案 |

|---|---|

| 输出是字符串,靠正则清洗 | 输出是Pydantic模型,结构化可验证 |

| 工具调用手动写schema | @tool装饰器自动生成Function Calling Schema |

| 错误靠try-catch硬扛 | 类型检查+静态分析提前拦截 |

| 调试靠print日志 | 支持Logfire,全程可观测 |

| 多Agent靠手动协调 | 用pydantic-graph定义工作流 |

它让我们意识到:最好的AI框架,不是最炫技的那个,而是最像‘正常代码’的那个。

当你写的AI代理可以像FastAPI路由一样被静态分析、被单元测试、被文档化时,你就知道——

AI终于走出了实验室,走进了生产环境。

✨ 终极启示:

我们不需要放弃LLM的灵活性,也不必忍受它的不可靠。

Pydantic-AI 展示了一条中间道路——在自由与秩序之间找到平衡。

它不试图改变AI的本质,而是为它穿上一套“工程制服”,让它既能飞翔,又能落地。

当AI不再是一个需要时刻盯着的“风险源”,而是一个你可以放心交付给用户的“产品组件”时,真正的智能时代才算真正开启。

而这,正是 Pydantic-AI 正在悄然推动的革命。

用户互动:你的AI,你做主

我们聊了这么多——从类型安全的根基,到结构化输出的强制校验,再到多智能体协作的复杂流程。但最终,AI的价值不在于它多“智能”,而在于它能否真正服务于你,解决你真实世界的问题。

Pydantic-AI 的设计哲学,从来不是把开发者关在笼子里,而是给你一套精密的工具,让你能主动定义规则、掌控流程、应对异常。它不承诺“万能”,但它承诺“可控”。而这种“可控”,只有在面对真实场景的碰撞时,才能激发出最大的价值。

所以,现在轮到你了。

你在项目中是否遇到过LLM输出格式崩溃的瞬间?

“我让AI返回一个JSON,结果它写了一篇散文。”

这几乎是每个LLM开发者都流过的泪。你精心设计的 {"user_id": 123, "action": "login"},换来的可能是:

当然!用户的ID是123,他刚刚执行了登录操作。

或者更糟——语法错误、字段名拼错、类型混乱……前端直接报错,后端解析失败,整个流程卡死。

你有没有经历过这样的时刻?

- 因为一次格式错误导致任务中断?

- 被非结构化输出逼着写一堆正则和容错逻辑?

- 在生产环境中眼睁睁看着AI“自由发挥”却无能为力?

这些不是小问题,而是可靠性鸿沟。而 Pydantic-AI 正是为此而生——用类型系统封住混沌之口,让每一次输出都必须合法。

分享你的“崩溃瞬间”,让我们一起看看,如何用类型安全把它变成“稳如泰山”。

你最想用Pydantic-AI构建哪种智能体:客服、编码、数据分析?

Pydantic-AI 不只是一个框架,它是一个智能体操作系统。你可以用它构建任何需要“准确交付”的AI协作者。

想象一下:

- 🏦 银行客服智能体:用户说“查上月余额”,AI 返回严格符合风控模型的 JSON,字段加密、权限校验、日志追踪,一步到位。

- 💻 CLI编码代理:一句“修复登录失败”,AI 自动读代码、跑测试、改文件、再验证,实现全自动 Bug 修复闭环。

- 📊 数据分析助手:输入“对比Q1各区域销售额”,AI 自动生成 SQL 并验证字段合法性,确保不会因拼错表名炸掉数据库。

你心中最想落地的场景是什么?

是提升效率的自动化代理?

是增强体验的对话式应用?

还是驱动决策的结构化提取引擎?

告诉我们,哪个智能体最能解决你的实际痛点?

欢迎留言分享你的痛点或创意,我会挑选典型场景做深度解析!

这不是一篇单向输出的文章,而是一次共建。

📌 留言告诉我:

- 你遭遇过的最离谱的 LLM 输出错误;

- 你想用 Pydantic-AI 实现的智能体构想;

- 或者你对“可靠AI”的任何思考。

我会从中挑选最具代表性的真实需求,在后续内容中进行完整代码级深度拆解——从模型定义、工具集成到错误处理,手把手带你实现。

你的问题,就是下一个案例。

让我们一起,把 AI 从“不可控的天才”,变成“值得信赖的工程师”。

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)