Transformer vs. Diffusion:谁将主宰通用视频生成与世界模型的未来?

摘要: OpenAI的Sora模型标志着视频生成技术的范式转变,从基于U-Net的经典Diffusion架构转向以Transformer为核心的Diffusion Transformer(DiT)。对比显示,Transformer在全局建模、长序列处理、可扩展性和组合性上具有显著优势,能够统一处理不同分辨率、时长的视频,并涌现出接近物理规律的生成能力。这种架构更接近通用视频生成和世界模型的需求,支

探讨 Sora 背后的技术革命,以及为何新一代架构指明了通向 AI 世界的道路。

引言:一场静悄悄的技术范式转移

2024 年初,OpenAI 发布的 Sora 模型震惊了世界。它生成的视频不仅时长、清晰度惊人,更在于其对物理世界细腻的理解和惊人的一致性。许多人将其归功于 Diffusion(扩散模型)的胜利,但业内专家清楚地知道,这背后是一场深刻的技术架构范式转移:从以 U-Net 为核心的经典 Diffusion 架构,转向了以 Transformer 为核心的新一代 Diffusion 架构。

本文将深入对比这两种技术路径,探讨为何 Transformer 正在成为通往通用视频生成和世界模型的更优道路。

一、核心概念厘清:两种架构是什么?

在深入对比之前,我们需要先明确讨论的对象。

1. 经典 Diffusion 架构 (U-Net Based)

这是我们过去几年在文生图(如 Stable Diffusion)、文生视频(如 Runway Gen-2)领域最常见的技术。它的核心是一个 U-Net 网络——一种编码器-解码器结构,通过跳跃连接保留细节。它的任务是迭代地对噪声数据进行“去噪”,最终生成清晰的图像或视频帧。

特点:专为图像生成设计,强依赖于卷积操作。

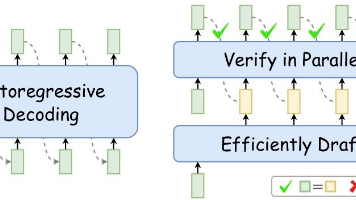

2. 新一代 Transformer 架构 (DiT Based)

这是 Sora 所采用的核心技术,通常被称为 Diffusion Transformer (DiT)。它做了一個大膽的取捨:完全摒弃了 U-Net,而是将噪声化的输入数据打成 Patch(图像/视频块),连同时间步、条件提示等信息一起,输入一个标准的 Transformer 模型(包含自注意力层和前馈网络)来预测噪声。

特点:将视觉生成问题转化为类似 NLP 的序列建模问题。

二、技术全方位对比

下表从多个关键维度对两种架构进行了直观对比:

| 对比维度 | 经典 Diffusion (U-Net based) | 新一代 Transformer (DiT based) | 对通用视频生成与世界模型的意义 |

|---|---|---|---|

| 核心网络 | 卷积U-Net | Transformer | 根本性差异,决定了模型能力上限 |

| 归纳偏置 | 局部性、平移不变性。擅长处理图像像素间的局部空间关系。 | 全局性、可缩放性。自注意力机制天然建模全局和长程依赖关系。 | Transformer 在理解视频的全局时空语义、长序列依赖上具有压倒性优势。 |

| 可缩放性 (Scalability) | 较差。U-Net 的深度和宽度增加带来的性能提升有瓶颈。 | 极强。遵循“Scaling Law”。模型参数量、训练数据量、计算资源的增加能带来稳定且可预测的性能提升。 | 这是通向通用化的关键。Sora 的成功证明了,只要大力出奇迹,用 Transformer 架构堆数据和算力,就能涌现出前所未有的能力。 |

| 处理长序列/视频 | 吃力。通常需要分别在帧内(空间)和帧间(时间)设计复杂的注意力或卷积模块,结构复杂。 | 天然优势。将视频视为时空补丁(Spacetime Patches)的序列,与处理文本 token 序列没有本质区别。可以统一处理不同时长、分辨率、宽高比的视频。 | 实现了视频生成的“大一统”。这是构建世界模型的基础,因为真实世界的事件是多尺度、可变长度的。 |

| 泛化与组合性 | 较弱。生成的视频容易出现帧间闪烁、物体形态不稳定,难以保持长程一致性。 | 极强。得益于全局注意力,能更好地保持主体的一致性、理解复杂的时空指令(如“摄像机环绕拍摄”),并组合不同概念生成全新的场景。 | 世界模型的核心要求:理解物理规则、保持对象持久性、支持逻辑组合。Transformer 架构更接近这个目标。 |

| 训练效率 | 相对较高。U-Net 的卷积计算效率高,但对于长视频需要复杂的工程优化。 | 较低。自注意力机制的计算复杂度是序列长度的平方,但对大规模分布式训练友好。 | 为了最终的能力,牺牲训练效率是值得的。硬件的发展(更快的GPU/TPU)也在弥补这一劣势。 |

| 目前代表模型 | Stable Diffusion Video, Runway Gen-2, Pika | OpenAI Sora | Sora 展示的质量和对物理世界的理解能力,远超之前的任何模型。 |

三、深入解读:为何 Transformer 是更优路径?

1. 通向通用视频生成:统一性 (Unification)

经典 Diffusion 模型通常为固定的分辨率、时长和宽高比进行训练,泛化能力受限。而 Transformer 架构通过将视频 Token化 为时空补丁,可以处理可变分辨率、可变时长、可变宽高比的输入和输出。

这种灵活性是“通用”视频生成的前提。Sora 能够生成从宽屏电影到手机竖屏视频的各种内容,正是这种统一性的体现。 它不再是一个为特定任务定制的工具,而是一个通用的视觉内容生成基础。

2. 通向世界模型:涌现 (Emergence) 与组合性 (Compositionality)

世界模型需要对物理世界有深刻的理解,例如:

-

对象持久性:一个物体在被遮挡后再次出现应该保持不变。

-

三维几何一致性:从不同角度生成同一个场景。

-

因果关系:理解“因为A,所以B”的事件逻辑。

-

U-Net 架构:其卷积的局部性使得它难以在长视频中维持全局一致性,容易“遗忘”或“扭曲”之前帧的信息。它更像是一个强大的“模式补全器”,而非“世界模拟器”。

-

Transformer 架构:

- 全局注意力:允许视频中任何位置的补丁与任何其他位置的补丁进行交互。这意味着模型可以在第一帧就“看到”最后一帧,从而规划中间的内容,保持物体的持久性和状态。

- 涌现能力:当 Transformer 模型被 scaled up 到足够大时,会涌现出令人惊讶的能力。Sora 能模拟出粗糙的物理规则(如镜头撞击后的破碎)、数字世界(Minecraft)以及情感表达,这些能力并非被明确编程,而是从海量数据中学习到的统计规律,这种规律无限接近真实的物理规律。

- 组合性:Transformer 在 NLP 中已展现出强大的组合能力(例如理解“骑着马的宇航员”)。在视频生成中,这种能力表现为将文本描述中的不同概念、动作和场景流畅地组合成一个连贯的、符合逻辑的视频序列。

四、结论与展望

领域正在从专门化的、基于U-Net的Diffusion模型转向统一化的、基于Transformer的Diffusion模型。这类似于 NLP 领域从 RNN/CNN 转向 Transformer 的范式迁移。

- 经典 Diffusion 架构:并未过时,它在特定、可控的视频生成任务(如图生视频、视频编辑)上因其效率和高成熟度,仍会有一席之地。它是一个强大的“专家”系统。

- 新一代 Transformer 架构:是通向通用视频生成和世界模型的更有潜力的路径。它的可缩放性和对长序列、全局关系的强大建模能力,使其能够通过 Scaling 来不断逼近对物理世界的模拟。Sora 是第一个强有力的证明。

未来的发展将集中于:

- 更高效的 Transformer:降低其计算复杂度,例如采用状态空间模型(如 Mamba)、混合专家(MoE)等。

- 更好的 Tokenization:如何更有效地将视觉信息离散化或转化为 token。

- 与多模态的深度融合:将文本、图像、视频、音频、深度信息等统一 token化,训练真正的多模态基础模型。

- 从生成到推理:如何让这些模型不仅生成视频,还能进行因果推理、预测和决策,这才是世界模型的终极目标。

简而言之,Transformer架构以其卓越的扩展性和全局建模能力,正在为通用视频生成和世界模型奠定新的、更坚实的技术基础。 我们正站在一个新时代的起点,未来的发展无疑将更加令人兴奋。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)