5MB秒杀Ollama!某国产品的Rust神器免费上线,本地AI推理直接起飞

你是否也曾经对着 680MB 的 Ollama 发出过“这也太大了吧”的感叹?你是否也渴望一个轻量、快速、兼容 OpenAI API 的本地 AI 推理服务器?好消息来了,Rust 写的 Shimmy 闪亮登场,它不仅只有 5.1MB,而且启动时间不到 100ms,内存占用还不到 50MB!更关键的是——它永远免费。没错,没有隐藏条款,没有“现在免费以后再说”,也没有“突然收费”。Shimmy 就

引言

你是否也曾经对着 680MB 的 Ollama 发出过“这也太大了吧”的感叹?你是否也渴望一个轻量、快速、兼容 OpenAI API 的本地 AI 推理服务器?好消息来了,Rust 写的 Shimmy 闪亮登场,它不仅只有 5.1MB,而且启动时间不到 100ms,内存占用还不到 50MB!

更关键的是——它永远免费。没错,没有隐藏条款,没有“现在免费以后再说”,也没有“突然收费”。Shimmy 就是为开发者而生的“隐形基础设施”,安装完之后你几乎感觉不到它的存在,但它却在背后默默高效地运行。

接下来,我们一起来看看这个“小而美”的本地 AI 推理神器到底有多厉害!

一、什么是 Shimmy?

Shimmy 是一个用 Rust 编写的本地 AI 推理服务器,支持 GGUF 模型(如 Llama 系列、Phi 系列等),并提供与 OpenAI API 完全兼容的接口。它是一个单文件二进制程序,适用于 Linux、macOS 和 Windows,且完全开源,MIT 协议,永远免费。

为什么说它是“隐形基础设施”?

因为它几乎不需要配置,自动发现模型、自动分配端口、自动启动服务,你只需要一个命令就能让它跑起来,完全不打扰你的开发流程。

二、Shimmy vs Ollama:谁才是轻量之王?

| 指标 | Shimmy | Ollama |

|---|---|---|

| 二进制大小 | 5.1MB | 680MB |

| 启动时间 | <100ms | 5-10 秒 |

| 内存占用 | <50MB | 200MB+ |

| OpenAI API 兼容性 | 100% | 部分支持 |

| 是否需要配置 | 无需配置 | 手动配置 |

| 支持 LoRA | ✅ | ❌ |

从表格中可以看到,Shimmy 在多个维度上都碾压 Ollama,尤其在体积、启动速度和资源占用方面表现惊人。

三、Shimmy 的核心亮点

1. 超轻量、极速启动

- 二进制仅 5.1MB,下载安装毫无压力。

- 启动时间小于 100ms,几乎是“秒开”。

- 内存占用不到 50MB,对资源友好。

2. OpenAI API 全兼容

- 支持 OpenAI 的

/v1/chat/completions接口,可以无缝接入 VSCode Copilot、Cursor、Continue.dev 等工具。 - 自带 Shimmy 原生 API 和 WebSocket 流式接口。

3. 自动发现模型 + 热插拔切换模型

- 自动扫描本地模型目录(支持 Hugging Face 缓存、Ollama 模型目录、自定义路径等)。

- 支持热插拔切换模型,无需重启服务。

4. 支持 LoRA 适配器

- 从训练到部署只需 30 秒,非常适合需要微调模型的开发者。

5. 多平台支持,一键安装

- 支持 Linux、macOS、Windows。

- 可通过 Cargo 安装,也可下载预编译二进制文件。

- VSCode 插件已上线,未来还将支持 npm、pip、Docker。

四、如何快速上手?

1. 安装 Shimmy

# 通过 Cargo 安装(推荐)

cargo install shimmy

# 或者下载 Windows 预编译版本

curl -L https://github.com/Michael-A-Kuykendall/shimmy/releases/latest/download/shimmy.exe

⚠️ Windows 用户注意:可能会被 Defender 误报,建议使用 Cargo 安装,或添加例外。

2. 获取模型

Shimmy 支持自动发现以下路径中的模型:

- Hugging Face 缓存目录:

~/.cache/huggingface/hub/ - Ollama 模型目录:

~/.ollama/models/ - 当前目录下的

./models/ - 环境变量指定:

SHIMMY_BASE_GGUF=path/to/model.gguf

示例下载模型命令:

huggingface-cli download microsoft/Phi-3-mini-4k-instruct-gguf --local-dir ./models/

huggingface-cli download bartowski/Llama-3.2-1B-Instruct-GGUF --local-dir ./models/

3. 启动服务

# 自动分配端口

shimmy serve

# 或手动指定端口

shimmy serve --bind 127.0.0.1:11435

服务启动后,默认监听在 http://localhost:11435,你可以直接在 VSCode、Cursor 等工具中配置使用。

五、如何与主流工具集成?

1. VSCode Copilot 配置

{

"github.copilot.advanced": {

"serverUrl": "http://localhost:11435"

}

}

2. Continue.dev 配置

{

"models": [{

"title": "Local Shimmy",

"provider": "openai",

"model": "your-model-name",

"apiBase": "http://localhost:11435/v1"

}]

}

3. Cursor IDE

只需将 API 地址设置为 http://localhost:11435/v1,即可直接使用。

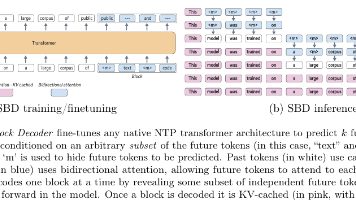

六、技术架构一览

Shimmy 使用了以下核心技术栈:

- Rust + Tokio:保证内存安全与高性能异步处理。

- llama.cpp 后端:业界标准的 GGUF 推理引擎。

- OpenAI API 兼容层:实现无缝替换。

- 动态端口管理:避免端口冲突。

- 零配置自动发现:即插即用。

七、为什么 Shimmy 永远免费?

作者 Michael A. Kuykendall 明确表示:Shimmy 永远不会变成付费产品。它将始终保持 MIT 开源许可,完全免费。如果你想支持项目发展,可以每月赞助 $5,比一杯咖啡还便宜,但带来的价值却无限。

八、结语:轻量、高效、免费,Shimmy 真的很“香”!

Shimmy 的出现,标志着本地 AI 推理服务进入了一个更轻、更快、更智能的时代。它不仅解决了 Ollama 的“笨重”问题,还带来了自动发现、热插拔、LoRA 支持等高级功能。

如果你是开发者,正在寻找一个高效、省心的本地 AI 推理方案,Shimmy 绝对值得你一试!

相关链接

- GitHub 仓库:https://github.com/Michael-A-Kuykendall/shimmy[1]

- VSCode 插件:Shimmy Extension[2]

- 项目文档:docs/[3]

- 赞助项目:GitHub Sponsors[4]

“最好的代码是你几乎不需要去想的代码。”

Shimmy,正是这句话的完美诠释。

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

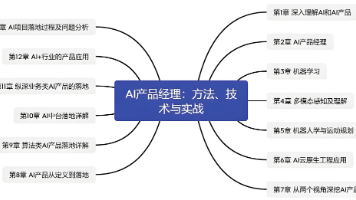

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献158条内容

已为社区贡献158条内容

所有评论(0)