手把手教你离线私有化部署DeepSeek大模型(Win10环境)大模型入门到精通,收藏这篇就足够了!

如果在去年,想要部署一个大模型,是需要一个很强大的电脑的。好在今年年初,DeepSeek横空出世,凭借着出色的问答能力和对硬件要求相对友好(普通家用电脑即可运行)而受到广泛关注。

互联网上有那么多免费的AI,包括豆包、腾讯元宝、KIMI、通义、文心一言、Deepseek等等,为什么还要费时费力的自己部署大模型?

当然是为了离线运行。有的生产环境无法接入互联网,有的希望将自己多年来积累的资料作为知识库,但是又不想泄露到互联网上,所以自己部署一个专属大模型就很有必要了。

如果在去年,想要部署一个大模型,是需要一个很强大的电脑的。好在今年年初,DeepSeek横空出世,凭借着出色的问答能力和对硬件要求相对友好(普通家用电脑即可运行)而受到广泛关注。

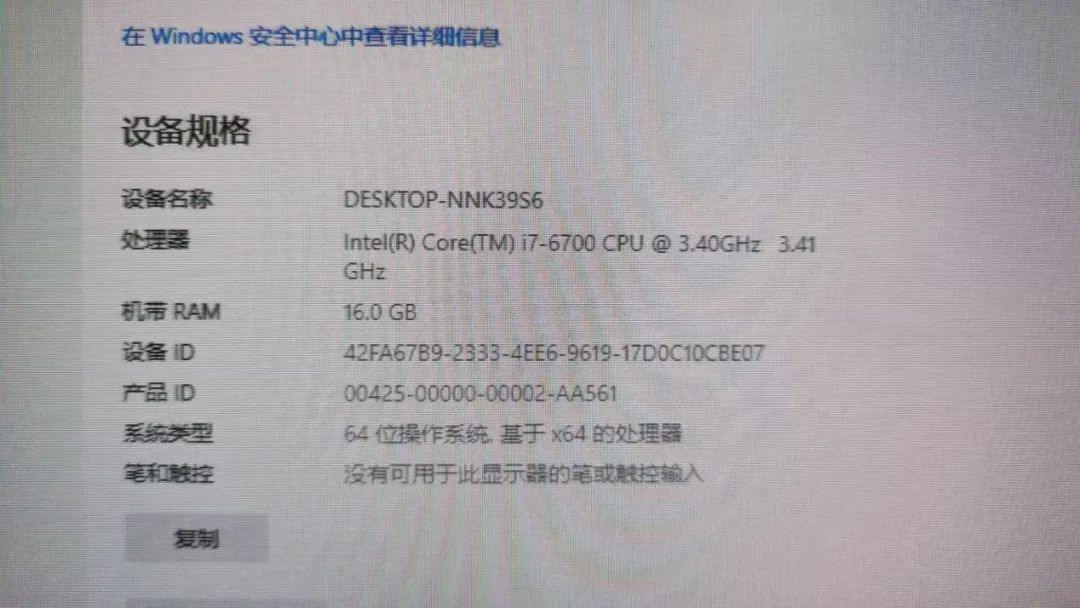

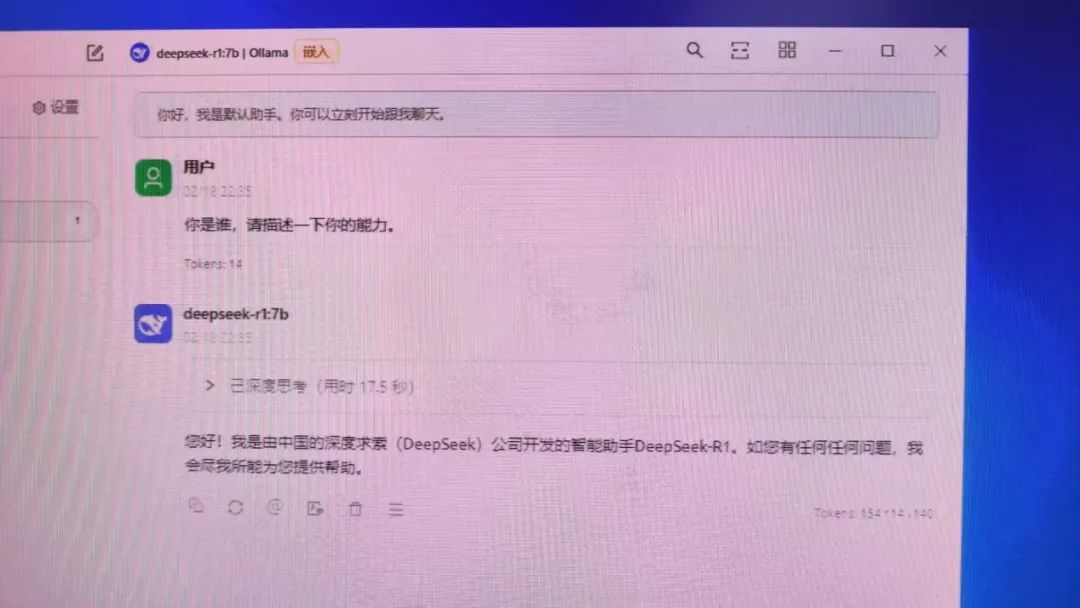

今年2月份,我就跟风在我的破电脑上部署了Deepseek(CPU是I7-6700,内存16GB,没有显卡),跑7B的模型凑合着还能用,当时发了朋友圈。如下图所示:

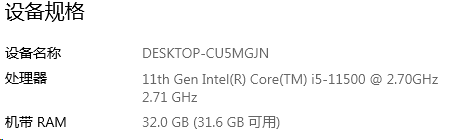

后来从朋友那里找了一台稍好一点的电脑,CPU是I5-11500,内存了32GB,同样没有显卡,但是内存大了以后就可以跑14B的模型了。

正好近期有空,就把整个部署的流程记录下来,免得时间长了就忘记了,同时也供大家参考。

一、所需软件清单

1.DeepSeek 模型文件:

模型参数量级通常为 1.5B、7B、8B、14B、70B、671B 等(B 代表 Billion/十亿)。例如,1.5B 模型包含约 15 亿参数。671B 为满血版,需要非常专业的显卡支持,普通用户就不要想了。

硬件要求建议:纯 CPU 运行时,模型运行速度及可加载的模型大小主要取决于内存容量。内存大小应大于目标模型的体积。内存不足时,只能选择较小模型,否则加载缓慢甚至失败。

以我的环境(32GB 内存)为例:

8B 模型:运行速度尚可接受。

14B 模型:响应较慢(单次完整回答可能需十多分钟),但回答质量显著优于 8B 模型。

模型格式:常见为 Ollama 格式或 GGUF 格式。后文将介绍两者区别及安装方法。

模型类型:R1有基础模型和蒸馏模型2种,二者对比如下,建议选择蒸馏模型。

模型下载地址:

https://www.modelscope.cn/organization/deepseek-ai?tab=model

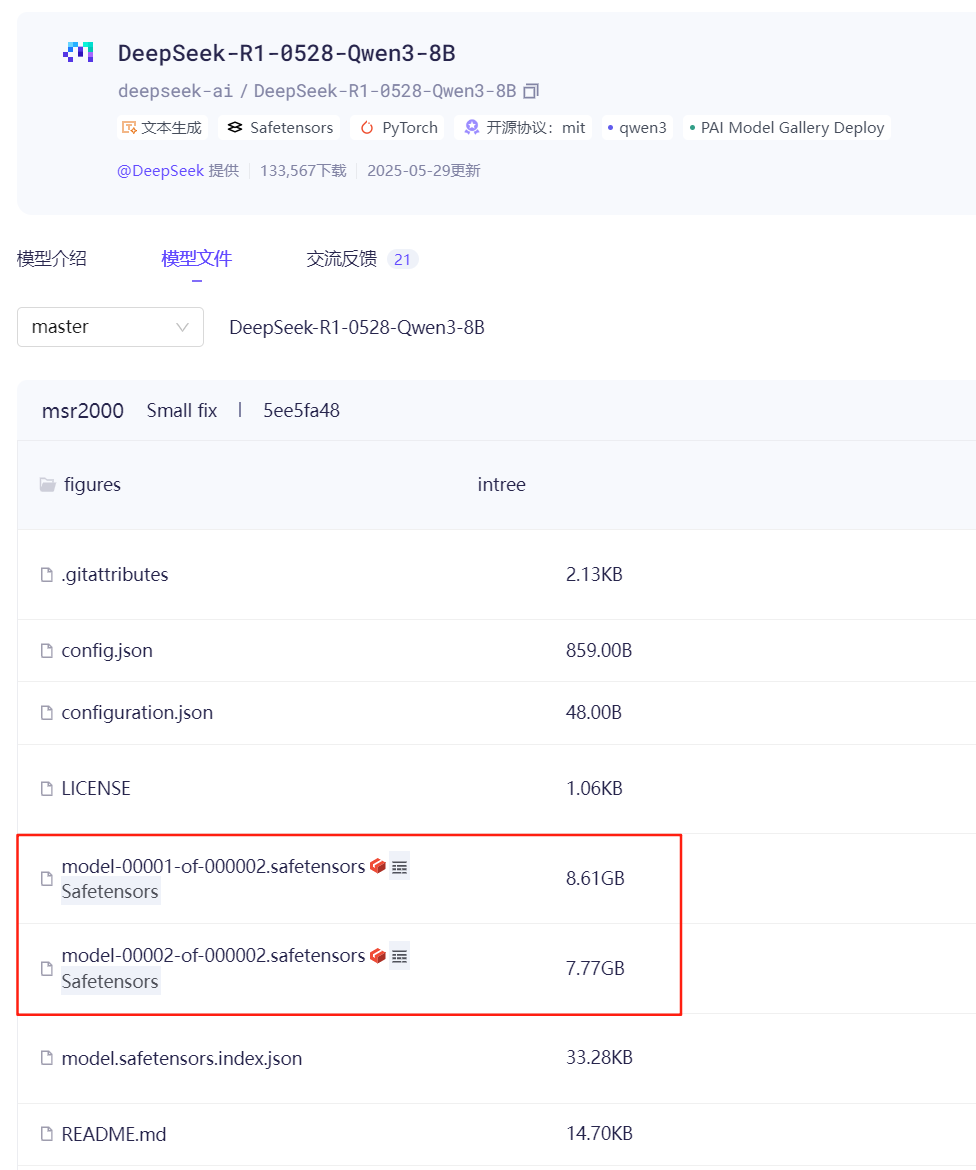

8B的模型下载地址:https://www.modelscope.cn/models/deepseek-ai/DeepSeek-R1-0528-Qwen3-8B/files

下载页面截图如下:

2.Ollama: 用于本地运行大型语言模型的命令行工具。

官网下载地址:https://ollama.com/download/windows

3.Cherry Studio: 大模型交互客户端,用于调用 Ollama 并提供图形界面(Ollama是命令行界面,不太好用),同时可以加载本地知识库。同类软件还有 Chatbox, MaxKB 等。

官网下载地址:https://www.cherry-ai.com/download

4.依赖项: 安装前需确保已安装 Microsoft Visual C++ 运行库,微软官网下载地址为:https://aka.ms/vs/17/release/vc_redist.x64.exe

5.操作系统: Windows 10 22H2 或更新版本。

二、软件安装与模型部署

1.安装 Ollama: 运行安装程序,按提示完成安装(一路点击“下一步”)。

2.安装 Cherry Studio:

确保已安装所需 C++ 运行库。

运行 Cherry Studio 安装程序,按提示完成安装。

3.部署 DeepSeek 模型:

3.1 ollama 格式模型安装:

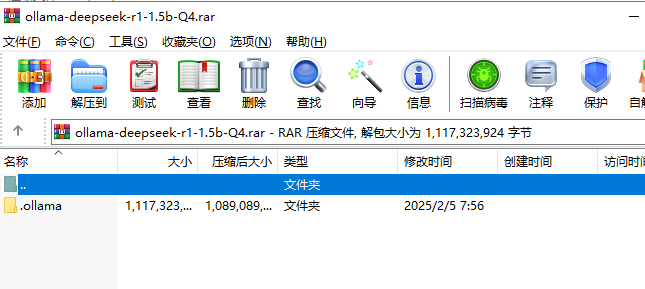

以 ollama-deepseek-r1-1.5b-Q4 (Q4 代表 4-bit 量化) 为例:

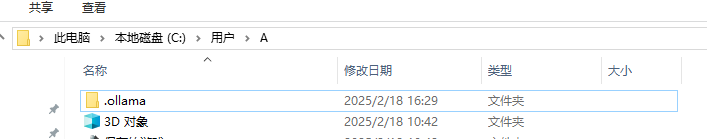

假设当前 Windows 用户名为 A。将下载的模型压缩包解压,将其中的“.ollama”文件夹解压到 C:\Users\A\ 目录下。

解压出来的文件夹如下图所示:

其他模型(如 8B)按同样方法操作,如果再解压其他模型到这里,提示文件有重复,直接覆盖就行,没什么影响。

3.2 GGUF 格式模型安装:

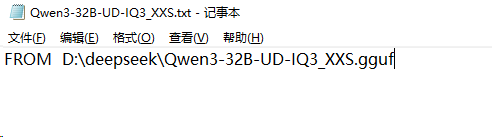

GGUF 格式模型需通过命令创建加载。以 Qwen3-32B-UD-IQ3_XXS.gguf 为例:

假设GGUF模型的文件路径为 D:\deepseek\Qwen3-32B-UD-IQ3_XXS.gguf。

在同目录下创建模型信息文件(如 Qwen3-32B-UD-IQ3_XXS.txt)。

用记事本打开该文件,写入一行内容:FROM D:\deepseek\Qwen3-32B-UD-IQ3_XXS.gguf,如下图所示:

打开命令提示符 (cmd),切换到 D:\deepseek 目录。

运行命令创建模型:ollama create Qwen3-32B-UD-IQ3_XXS -f Qwen3-32B-UD-IQ3_XXS.txt

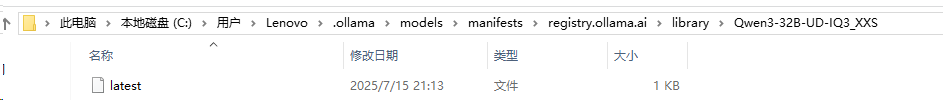

等待创建完成(需数分钟)。临时文件位于 C:\Users[用户名].ollama\models\manifests\registry.ollama.ai\library\Qwen3-32B-UD-IQ3_XXS。

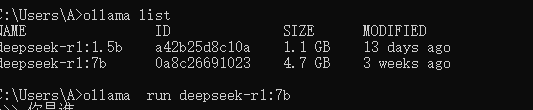

创建完成后,运行 ollama list 可查看已加载模型。

3.3测试模型:

运行 ollamalist 确认模型已列出。

运行 ollama run deepseek-r1:7b 开始与模型对话。

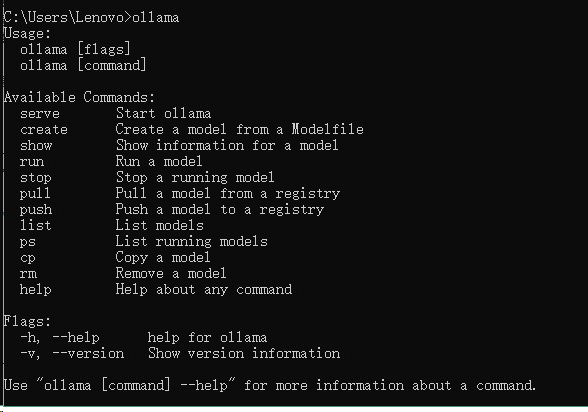

ollama的常用命令如下,一般就用得上ollama show、ollama list等,不复杂。如下图所示:

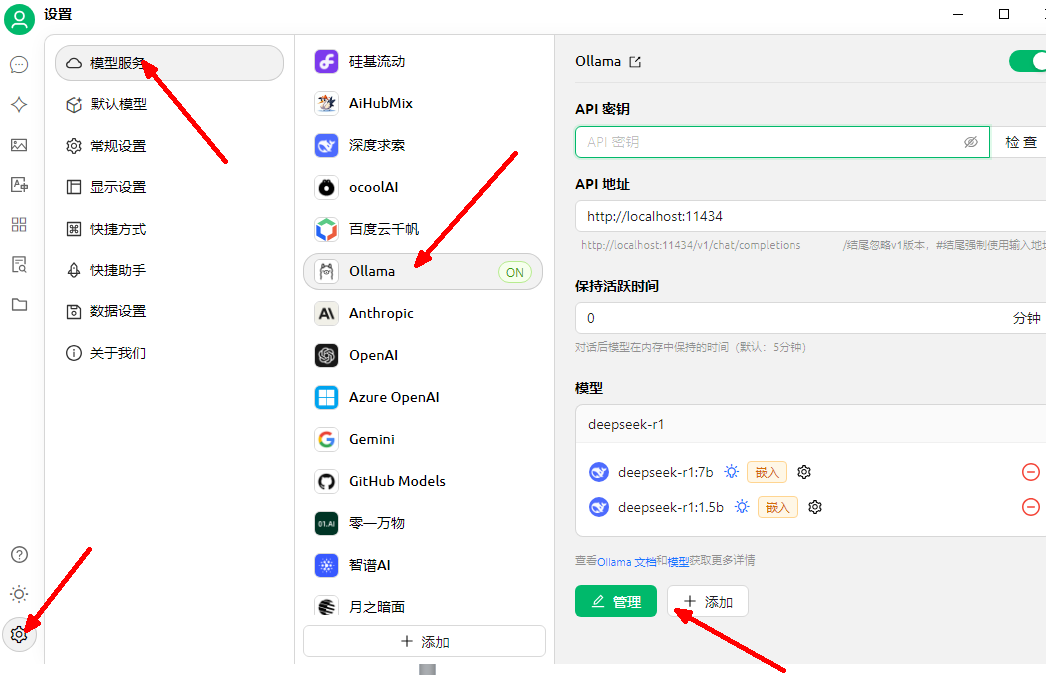

三、在 Cherry Studio 中调用模型与知识库

1.添加并调用模型:

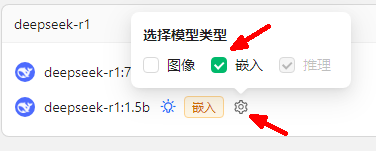

打开 Cherry Studio。参照下图顺序操作,将部署好的模型添加进来。

在“默认模型”处选择 7b 模型,即可在对话框中进行聊天。

2.添加个人知识库(RAG):

点击模型名称右侧的齿轮图标(设置),勾选“嵌入”(Embedding) 选项。

点击左侧导航栏的“知识库”,可添加文件夹或文档作为本地知识库。但是导入知识库的过程比较慢,需要耐心等待。

四、配置局域网访问

若需为局域网内其他设备提供服务,需进行以下配置:

1.设置环境变量

打开命令提示符 (cmd),运行命令:

setx OLLAMA_HOST “0.0.0.0” && setx OLLAMA_ORIGINS “*”

2.开放防火墙端口

以管理员身份打开命令提示符 (cmd),运行命令:

netsh advfirewall firewall add rule name=“Allow Ollama Service” dir=in protocol=TCP localport=11434 action=allow

3.重启电脑使配置生效

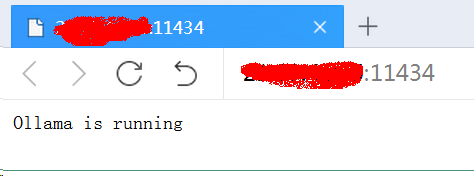

4.局域网内其他设备访问 http://[服务端IP地址]:11434,若显示 “ollama is running” 即表示配置成功。

五、局域网客户端访问服务端模型

方法 1:使用 Cherry Studio (客户端需要Windows 10以上的操作系统)

在客户端电脑安装 Cherry Studio。

参照 第三节 的方法添加模型,在模型选择界面应能自动发现局域网服务端提供的模型。

选择模型并设置默认后即可使用。

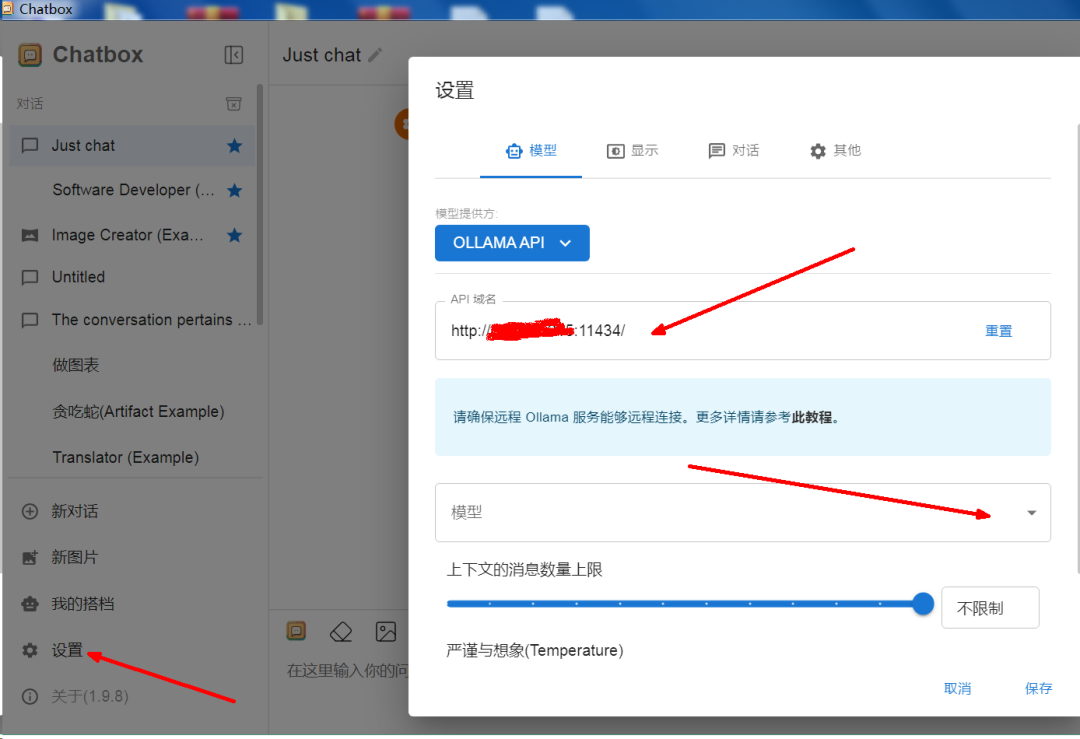

方法 2:使用 Chatbox (兼容 Windows 7,如果是win7,则需使用旧版本 1.9.8 或更早版本)

打开 Chatbox,点击“设置”,在“模型提供方”中选择 OLLAMA API。

在“API 域名”中填入服务端地址:http://[服务端IP地址]:11434。

点击保存。模型下拉框中将显示服务端所有可用模型。

方法 3:浏览器插件 (如 Page Assist,不推荐)

适用于 Chrome 内核浏览器。

注意: 此方法在测试中稳定性较差(易卡死),体验不佳,不建议使用。

大模型算是目前当之无愧最火的一个方向了,算是新时代的风口!有小伙伴觉得,作为新领域、新方向人才需求必然相当大,与之相应的人才缺乏、人才竞争自然也会更少,那转行去做大模型是不是一个更好的选择呢?是不是更好就业呢?是不是就暂时能抵抗35岁中年危机呢?

答案当然是这样,大模型必然是新风口!

那如何学习大模型 ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。但是具体到个人,只能说是:

最先掌握AI的人,将会比较晚掌握AI的人有竞争优势。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

但现在很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习路线完善出来!

在这个版本当中:

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型路线+学习教程已经给大家整理并打包分享出来, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:了解大模型的基础知识,以及大模型在各个行业的应用和分析,学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段:AI大模型RAG应用开发工程,主要学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,主要学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调,并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

更多推荐

已为社区贡献273条内容

已为社区贡献273条内容

所有评论(0)