算力革命与范式迁移:解码 2025 AI 硬件战争背后的技术密码

《皮衣战神与算力革命:GB300芯片与DeepSeek模型的双重突破》 英伟达GTC2025大会上,黄仁勋展示的GB300芯片与DeepSeek模型引发行业震动。GB300采用全液冷散热方案,单卡算力达15PFLOPS,推理性能较前代提升36倍,成本却降低32倍。同时,中国DeepSeek模型通过开源策略席卷开发者社区,其动态推理引擎显著提升效率。这场技术革命标志着AI产业从参数竞赛转向效率革命,

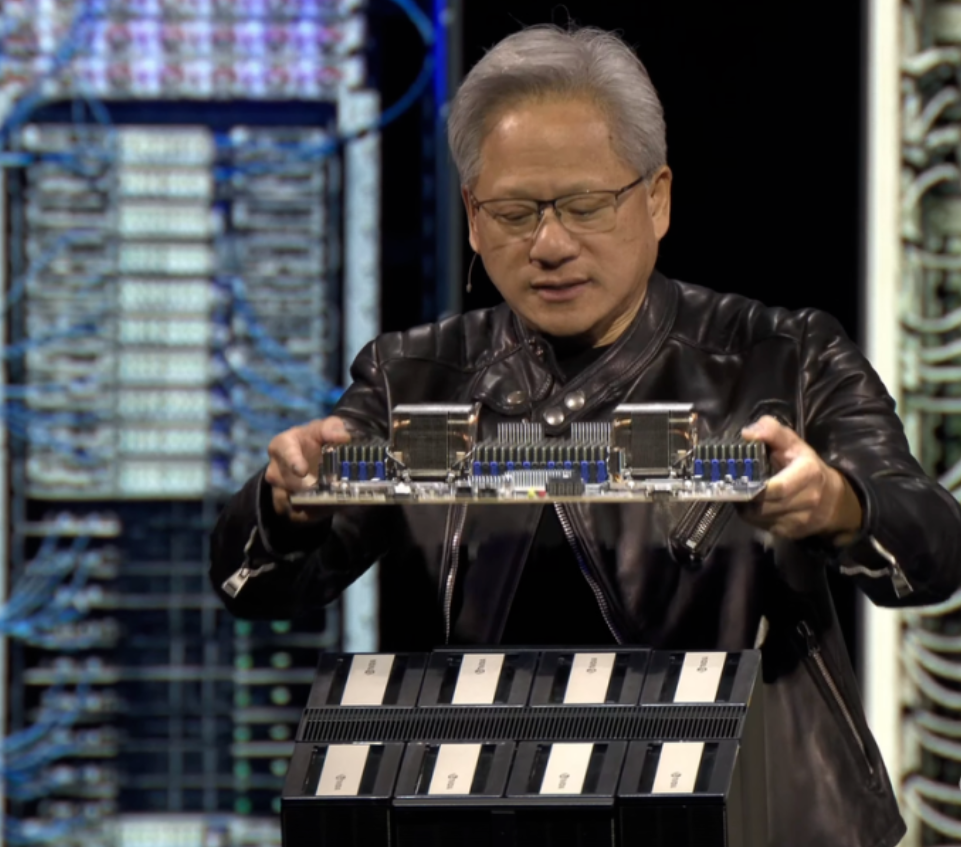

当黄仁勋穿着那件被网友戏称为 "焊在身上" 的黑色皮衣,在 GTC 2025 舞台上展示 GB300 芯片时,台下观众同时目睹了两个震撼场景:液冷机柜中 72 颗 GPU 组成的 "算力矩阵" 闪烁着幽蓝光芒,而大屏幕上 DeepSeek 模型的响应速度数据正以肉眼可见的速度刷新。这场被称为 "AI 超级碗" 的技术盛宴,不仅贡献了 "皮衣战神" 的新名场面,更标志着全球 AI 产业已进入 "算力供给与模型创新" 的深度博弈阶段。

本文将从硬件突破、开源浪潮和行业变革三个维度,解析这场技术革命的底层逻辑与实践启示。

黑色皮衣下的算力怪兽:英伟达 GB300 的技术突围

英伟达 GTC 大会历来是 AI 硬件的风向标,2025 年的这场发布会更是将 "参数竞赛" 推向新高度。黄仁勋开场的 "大家来找茬" 环节颇具戏剧性 —— 当 RTX 5090 与 4090 并排展示时,"体积小 30%,能效高 30%,性能翻倍" 的提升看似常规,直到 Blackwell Ultra 架构的 GB300 登场,才真正揭开算力革命的序幕。

这款被称为 "AI 工厂核反应堆" 的芯片,搭载 288GB HBM3e 显存,单卡 FP4 算力达到 15 PFLOPS,推理性能较前代 H100 提升 36 倍,而成本却降低 32 倍。更令人惊叹的是其集群设计:GB300 NVL72 机架系统可集成 72 颗 GPU 与 36 颗 Grace CPU,处理 DeepSeek-R1 模型时将响应时间从 1.5 分钟压缩至 10 秒,这意味着原本需要一个小型数据中心的算力,现在可浓缩至标准机柜规模。

散热技术的突破成为此次升级的关键支撑。为驯服 1400W 的功耗巨兽,GB300 彻底抛弃传统风冷,采用全液冷散热方案,密集的水冷管线不仅解决了热密度难题,更推动双鸿、奇鋐等供应商订单激增,形成新的产业链热点。这种 "水冷革命" 背后,是英伟达对 AI 工业化的深刻理解 —— 当单机架包含 60 万组件时,散热效率已成为算力密度的核心约束条件。

黄仁勋在演讲中抛出的 "Rubin 架构预告" 引发更大争议。这款预计 2026 年发货的下一代芯片,性能号称是 Hopper 架构的 900 倍,命名灵感来自暗物质研究先驱薇拉・鲁宾。网友调侃 "这是要凑齐科学界全明星" 的背后,反映出行业对 "算力天花板" 的集体焦虑 —— 当 Scaling Law(缩放定律)遭遇质疑时,硬件厂商必须用更激进的创新证明 "算力需求永无止境"。

从实验室到生产线:DeepSeek 掀起的开源革命

就在硅谷为 GB300 欢呼的同时,一款中国 AI 模型正以 "烟头烫外星人" 的颠覆性姿态席卷全球开发者社区。2025 年初,DeepSeek V3 的全面开源在 GitHub 引发星标狂潮,海外网友用这个略带戏谑的比喻,形容中国 AI 技术 "离谱到像科幻片" 的进步速度。

DeepSeek 的突围之道在于避开参数竞赛的红海,转而深耕推理效率。其技术团队发现,当模型参数超过千亿级后,"推理计算量比预期多 100 倍" 的行业痛点逐渐显现。为此,他们开发的动态推理引擎能像 "学霸拆解作业" 般分解复杂问题,生成带完整思维链的解决方案,这种能力完美契合了程序员群体中流行的 "Vibe Coding"(玄学编程)模式 —— 需求口述即可,报错全扔给 AI 处理。

开源策略带来的蝴蝶效应超出预期。电商平台上 "DeepSeek 镜像站搭建教程" 销量破万,知识付费博主靠 "AI + 小红书电商" 课程日入过万,甚至有人用其批量生产短剧剧本实现单月变现超 10 万。这些商业化案例印证了黄仁勋 "100 亿数字员工" 的预言并非空谈,更揭示出 AI 工业化的另一条路径:当算力成本通过开源降低门槛后,场景创新将爆发出惊人能量。

这场开源运动还意外催生了 "AI 牛马" 等职场梗的流行。程序员自嘲 "月薪 3500,AI 替我干 3500 的活",看似调侃实则反映行业变革:两个工程师借助 AI 工具就能产出过去五十人的代码量,尽管这些代码被戏称为 "用乐高搭火箭",但生产力跃迁已不可逆。DeepSeek 创始人在 Reddit 上分享的 "草根逆袭故事" 收获百万点赞,证明技术民主化正在重塑全球 AI 的权力格局。

技术博弈背后的产业重构:效率革命与生态战争

英伟达与 DeepSeek 的双线突破,本质上反映了 AI 产业的底层变革 —— 当硬件进入 "液冷时代",软件走向 "开源自由",整个行业正从 "参数竞赛" 转向 "效率革命"。这场变革的影响已超越技术范畴,正在重塑产业链分工、人才需求和商业规则。

在硬件端,GB300 的液冷方案不仅是技术升级,更代表一种新的基础设施思维。英伟达推出的 "AI 工厂操作系统 Dynamo",通过优化单机架 60 万组件的协同效率,实现每兆瓦收入最大化。这种 "算力即服务" 的模式,使得小公司也能租用顶级算力进行创新,打破了过去由巨头垄断的研发壁垒。而中国信科移动等企业在 6G 领域的布局(上半年申请 130 余件专利),则预示着未来 AI 与通信的深度融合将创造更大想象空间。

软件生态的分裂与融合同样值得关注。英伟达的闭源路线与 DeepSeek 的开源策略形成鲜明对比,但两者都在构建各自的 "护城河":前者通过 GR00T N1 双系统认知模型(系统 1 直觉反应 + 系统 2 深度思考)打造 AI 操作系统,后者则依靠 15TB 物理 AI 数据集吸引开发者生态。这种分化催生了 "混合架构" 的流行 —— 企业既用 GB300 满足极致性能需求,又借助开源模型降低开发成本。

对开发者而言,这场变革意味着技能体系的全面升级。量子计算领域的进展(IBM Qiskit 2025 新 API 实现错误感知编程)提醒我们,AI 硬件的边界正在不断扩展。建议技术人关注三个方向:液冷技术适配(应对高密度算力需求)、混合推理框架(平衡性能与成本)、物理 AI 接口(机器人与虚拟世界的交互标准)。当黄仁勋在发布会现场摆摊卖煎饼畅想未来时,或许正是在暗示:AI 的下一个风口,将出现在最传统的场景中。

从皮衣老黄的 "凡尔赛" 宣言到 DeepSeek 的 "草根逆袭",2025 年的 AI 硬件战争已超越技术比拼的范畴,成为一场关于创新范式的深刻变革。当算力成本持续下降,开源生态日益成熟,每个开发者都站在 "AI 工业化" 的临界点上。或许正如网友所说:"老黄卖的不是芯片,是通往元宇宙的船票",而真正决定航程的,将是那些懂得驾驭算力浪潮的技术实践者。你的代码,准备好被 100 亿数字员工接手了吗?

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)