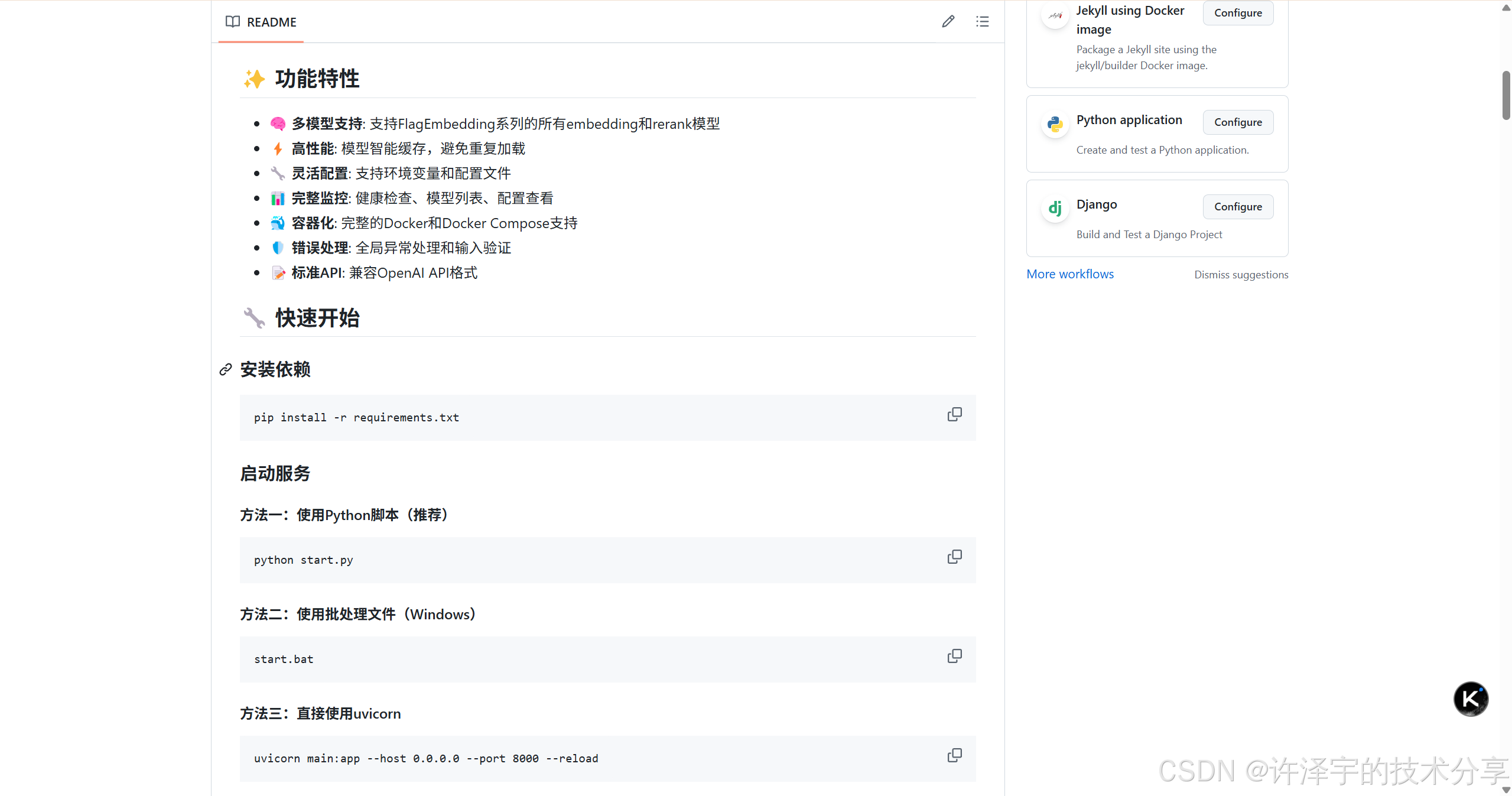

从零到一构建企业级AI向量服务:AntSK-PyApi深度技术解析

本文介绍了开源企业级向量服务项目AntSK-PyApi,该项目基于Python构建高性能文本嵌入向量生成与文档重排序API服务。文章分析了项目技术架构,包括FastAPI异步框架、智能模型管理系统和OpenAI兼容API设计,重点解读了核心功能实现、性能优化策略和企业级特性。该项目解决了模型管理复杂、性能优化困难等痛点,支持RAG系统、语义搜索等AI应用场景。文章还探讨了未来技术演进方向,如多模态

在AI大模型时代,文本向量化和语义检索已成为构建智能应用的核心基础设施。今天我们来深度剖析一个开源的企业级向量服务项目——AntSK-PyApi,看看如何用Python打造一个高性能、可扩展的文本嵌入向量生成与文档重排序API服务。

🎯 项目背景:为什么需要专业的向量服务?

在当今的AI应用生态中,文本向量化技术扮演着至关重要的角色。无论是RAG(检索增强生成)系统、语义搜索引擎,还是推荐系统,都离不开高质量的文本向量表示。然而,直接在应用中集成向量化模型往往面临以下挑战:

🔍 技术痛点分析

-

模型管理复杂:不同场景需要不同的embedding模型,模型加载、缓存、版本管理成为技术难题

-

性能优化困难:模型推理性能优化需要深度的技术积累,包括内存管理、并发处理等

-

接口标准化缺失:各种模型的调用方式不统一,增加了开发和维护成本

-

部署运维复杂:模型服务的容器化部署、监控告警、扩缩容等运维工作繁重

AntSK-PyApi正是为了解决这些痛点而诞生的。它不仅提供了标准化的API接口,还在架构设计上充分考虑了企业级应用的需求。

🏗️ 技术架构深度剖析

核心技术栈选型

让我们先来看看AntSK-PyApi的技术选型,每一个选择都有其深层次的考量:

# 核心依赖分析

fastapi==0.104.1 # 现代异步Web框架,性能卓越

uvicorn[standard]==0.24.0 # ASGI服务器,支持高并发

pydantic==2.5.0 # 数据验证,类型安全

numpy==1.24.3 # 数值计算基础

FlagEmbedding==1.2.10 # 文本嵌入模型库

modelscope==1.9.5 # 模型管理和下载

torch>=1.13.0 # 深度学习框架

transformers>=4.21.0 # Hugging Face模型生态

为什么选择FastAPI?

FastAPI相比传统的Flask有着显著优势:

-

原生异步支持:基于asyncio,天然支持高并发请求处理

-

自动API文档:基于OpenAPI标准,自动生成交互式API文档

-

类型安全:与Pydantic深度集成,提供运行时类型检查

-

性能卓越:基准测试显示性能接近NodeJS和Go

🎨 架构设计哲学

AntSK-PyApi的架构设计遵循了几个重要的设计原则:

1. 单一职责原则(SRP)

每个模块都有明确的职责边界:

-

main.py:API路由和业务逻辑 -

config.py:配置管理 -

start.py:服务启动和初始化

2. 开闭原则(OCP)

通过插件化的模型加载机制,支持扩展新的embedding模型而无需修改核心代码。

3. 依赖倒置原则(DIP)

通过配置文件和环境变量实现配置与代码的解耦。

🔧 核心功能实现深度解析

智能模型管理系统

AntSK-PyApi最精彩的部分莫过于其智能的模型管理系统。让我们深入分析load_model函数的实现:

def load_model(model_name: str):

"""加载或获取已缓存的模型"""

if model_name in loaded_models:

return loaded_models[model_name]

try:

# 模型路径安全处理

safe_model_name = model_name.replace("/", "_").replace("\\", "_")

filename = f"{safe_model_name}-key"

file_path = os.path.join(directory_path, filename)

# 智能缓存机制

if os.path.exists(file_path):

with open(file_path, 'r', encoding='utf-8') as f:

model_dir = f.read().strip()

# 缓存有效性验证

if not os.path.exists(model_dir):

logger.warning(f"缓存的模型路径不存在,重新下载: {model_dir}")

os.remove(file_path)

raise FileNotFoundError("缓存的模型路径无效")

else:

# 自动模型下载

cache_dir = os.path.join(directory_path, "cache")

model_dir = snapshot_download(model_name, revision="master", cache_dir=cache_dir)

# 持久化模型路径

with open(file_path, 'w', encoding='utf-8') as f:

f.write(model_dir)

# 智能模型类型识别

if "rerank" in model_name.lower():

model = FlagEmbedding.FlagReranker(model_dir, use_fp16=DEFAULT_USE_FP16)

else:

model = FlagEmbedding.FlagModel(model_dir, use_fp16=DEFAULT_USE_FP16)

loaded_models[model_name] = model

return model

这个函数的设计有几个亮点:

🎯 多层缓存策略

-

内存缓存:

loaded_models字典实现模型实例的内存缓存 -

磁盘缓存:通过文件系统缓存模型路径,避免重复下载

-

缓存失效处理:智能检测缓存有效性,自动清理无效缓存

🛡️ 异常处理机制

采用了分层异常处理策略:

-

业务异常:HTTPException用于API层面的错误响应

-

系统异常:通用Exception处理系统级错误

-

异常链传播:保持异常的完整调用栈信息

⚡ 性能优化技巧

-

FP16精度:通过

use_fp16参数减少内存占用,提升推理速度 -

模型类型自动识别:根据模型名称自动选择合适的模型类

-

路径安全处理:防止路径注入攻击

文本嵌入向量生成API

嵌入向量生成是整个系统的核心功能,让我们分析其实现细节:

@app.post("/v1/embeddings", response_model=EmbeddingResponse)

async def create_embeddings(request: EmbeddingRequest):

"""创建文本嵌入向量"""

try:

# 多层输入验证

if not request.model or not request.model.strip():

raise HTTPException(status_code=400, detail="模型名称不能为空")

if not request.input or len(request.input) == 0:

raise HTTPException(status_code=400, detail="输入文本不能为空")

if all(not text.strip() for text in request.input):

raise HTTPException(status_code=400, detail="输入文本不能全部为空")

# 编码格式验证

if request.encoding_format not in ["float", "base64"]:

raise HTTPException(status_code=400, detail="encoding_format参数必须是'float'或'base64'")

# 模型加载与推理

model = load_model(request.model)

embeddings = model.encode(request.input)

# 数据格式标准化

if not isinstance(embeddings, np.ndarray):

embeddings = np.array(embeddings)

if embeddings.ndim == 1:

embeddings = embeddings.reshape(1, -1)

# 响应数据构建

data = []

for i, embedding in enumerate(embeddings):

if request.encoding_format == "base64":

# Base64编码优化

embedding_bytes = embedding.astype(np.float32).tobytes()

embedding_b64 = base64.b64encode(embedding_bytes).decode('utf-8')

data.append(EmbeddingData(index=i, embedding=embedding_b64))

else:

data.append(EmbeddingData(index=i, embedding=embedding.tolist()))

# Token使用量统计

prompt_tokens = count_tokens(request.input)

return EmbeddingResponse(

data=data,

model=request.model,

usage=Usage(prompt_tokens=prompt_tokens, total_tokens=prompt_tokens)

)

🔍 技术亮点分析

1. 多格式输出支持 系统支持两种向量编码格式:

-

float格式:直接返回浮点数数组,便于直接使用

-

base64格式:二进制编码,减少网络传输开销

2. 数据类型安全处理 通过numpy数组的标准化处理,确保不同模型输出格式的一致性:

# 确保embeddings是numpy数组

if not isinstance(embeddings, np.ndarray):

embeddings = np.array(embeddings)

# 处理单文本情况

if embeddings.ndim == 1:

embeddings = embeddings.reshape(1, -1)

3. OpenAI兼容性设计 API响应格式完全兼容OpenAI的embeddings接口,便于现有应用的无缝迁移。

文档重排序系统

重排序功能是提升检索质量的关键技术,其实现更加复杂:

@app.post("/v1/rerank", response_model=RerankResponse)

async def create_rerank(request: RerankRequest):

"""文档重排序"""

try:

# 输入验证省略...

model = load_model(request.model)

# 构建查询-文档对

pairs = [[request.query, doc] for doc in request.documents]

# 相关性分数计算

scores = model.compute_score(pairs, normalize=True)

# 分数格式标准化

if not isinstance(scores, list):

if hasattr(scores, 'tolist'):

scores_converted = scores.tolist()

if not isinstance(scores_converted, list):

scores = [scores_converted]

else:

scores = scores_converted

else:

scores = [float(scores)]

# 结果排序与过滤

results_with_index = [(i, score) for i, score in enumerate(scores)]

results_with_index.sort(key=lambda x: x[1], reverse=True)

# Top-N过滤

if request.top_n is not None and request.top_n > 0:

results_with_index = results_with_index[:request.top_n]

# 响应构建

results = []

for rank_index, (original_index, score) in enumerate(results_with_index):

result = RerankResult(

index=original_index,

relevance_score=float(score)

)

if request.return_documents:

result.document = RerankDocument(text=request.documents[original_index])

results.append(result)

return RerankResponse(

id=str(uuid.uuid4()),

results=results,

tokens=RerankTokens(

input_tokens=count_tokens([request.query] + request.documents),

output_tokens=0

)

)

🎯 重排序算法优化

1. 分数标准化处理 通过normalize=True参数,确保不同模型输出分数的可比性。

2. 灵活的Top-N机制 支持动态指定返回结果数量,满足不同场景需求。

3. 原始索引保持 在排序过程中保持文档的原始索引,便于上层应用的结果映射。

🔒 企业级特性深度解析

全局异常处理机制

AntSK-PyApi实现了完善的异常处理体系:

@app.exception_handler(ValidationError)

async def validation_exception_handler(request: Request, exc: ValidationError):

"""处理Pydantic验证错误"""

logger.error(f"请求验证失败: {exc}")

return JSONResponse(

status_code=422,

content={

"error": "请求参数验证失败",

"detail": str(exc),

"errors": exc.errors()

}

)

@app.exception_handler(Exception)

async def global_exception_handler(request: Request, exc: Exception):

"""全局异常处理器"""

logger.error(f"未处理的异常: {exc}", exc_info=True)

return JSONResponse(

status_code=500,

content={

"error": "服务器内部错误",

"detail": "服务器遇到了一个意外的错误,请稍后重试"

}

)

这种分层异常处理设计有以下优势:

-

用户友好:为不同类型的错误提供清晰的错误信息

-

调试便利:详细的日志记录便于问题排查

-

安全性:避免敏感信息泄露

配置管理系统

配置管理采用了环境变量与配置文件相结合的方式:

# 环境变量优先,配置文件兜底

MODEL_STORAGE_PATH = os.getenv("MODEL_STORAGE_PATH", r"D:\git\AntBlazor\model")

API_HOST = os.getenv("API_HOST", "0.0.0.0")

API_PORT = int(os.getenv("API_PORT", "8000"))

LOG_LEVEL = os.getenv("LOG_LEVEL", "INFO")

DEFAULT_USE_FP16 = os.getenv("USE_FP16", "true").lower() == "true"

这种设计模式的优势:

-

灵活性:支持不同环境的配置差异化

-

安全性:敏感配置可通过环境变量注入

-

可维护性:配置集中管理,便于维护

容器化部署方案

项目提供了完整的Docker化部署方案:

# 多阶段构建优化

FROM python:3.11-slim

# 环境变量设置

ENV PYTHONUNBUFFERED=1

ENV PYTHONDONTWRITEBYTECODE=1

# 系统依赖安装

RUN apt-get update && apt-get install -y \

gcc g++ git curl \

&& rm -rf /var/lib/apt/lists/*

# Python依赖安装

COPY requirements.txt .

RUN pip install --no-cache-dir --upgrade pip && \

pip install --no-cache-dir -r requirements.txt

# 应用代码复制

COPY . .

# 健康检查配置

HEALTHCHECK --interval=30s --timeout=30s --start-period=5s --retries=3 \

CMD curl -f http://localhost:8000/health || exit 1

CMD ["python", "start.py"]

Docker Compose配置进一步简化了部署:

version: '3.8'

services:

antsk-py-api:

image: registry.cn-hangzhou.aliyuncs.com/xuzeyu91/antsk-base:antsk-py-api-1.0.3

container_name: antsk-py-api

ports:

- "8000:8000"

environment:

- MODEL_STORAGE_PATH=/app/models

- USE_FP16=true

volumes:

- ./models:/app/models # 模型持久化

- ./logs:/app/logs # 日志持久化

restart: unless-stopped

healthcheck:

test: ["CMD", "curl", "-f", "http://localhost:8000/health"]

interval: 30s

timeout: 10s

retries: 3

🚀 性能优化深度分析

内存管理优化

1. FP16精度优化 通过半精度浮点数减少内存占用:

model = FlagEmbedding.FlagModel(model_dir, use_fp16=DEFAULT_USE_FP16)

FP16相比FP32可以减少约50%的内存占用,在保持精度的同时显著提升性能。

2. 模型缓存策略 全局模型缓存避免重复加载:

loaded_models: Dict[str, Any] = {}

3. 数据类型优化 在向量编码时使用numpy的高效数据结构:

embedding_bytes = embedding.astype(np.float32).tobytes()

并发处理优化

FastAPI的异步特性使得系统能够高效处理并发请求:

@app.post("/v1/embeddings", response_model=EmbeddingResponse)

async def create_embeddings(request: EmbeddingRequest):

# 异步处理逻辑

异步处理的优势:

-

非阻塞I/O:网络请求不会阻塞其他请求处理

-

资源利用率高:单线程处理大量并发连接

-

扩展性好:支持水平扩展

网络传输优化

1. Base64编码选项 提供二进制编码减少传输开销:

if request.encoding_format == "base64":

embedding_bytes = embedding.astype(np.float32).tobytes()

embedding_b64 = base64.b64encode(embedding_bytes).decode('utf-8')

2. 响应压缩 FastAPI自动支持gzip压缩,减少网络传输量。

🔍 实际应用场景分析

RAG系统集成

在RAG(检索增强生成)系统中,AntSK-PyApi可以作为向量化服务:

# 文档向量化

import requests

def vectorize_documents(documents, model="BAAI/bge-large-zh-v1.5"):

response = requests.post("http://localhost:8000/v1/embeddings", json={

"model": model,

"input": documents

})

return [item["embedding"] for item in response.json()["data"]]

# 查询重排序

def rerank_documents(query, documents, model="BAAI/bge-reranker-v2-m3"):

response = requests.post("http://localhost:8000/v1/rerank", json={

"model": model,

"query": query,

"documents": documents,

"top_n": 5,

"return_documents": True

})

return response.json()["results"]

语义搜索引擎

构建企业级语义搜索引擎:

class SemanticSearchEngine:

def __init__(self, api_base="http://localhost:8000"):

self.api_base = api_base

self.embedding_model = "BAAI/bge-large-zh-v1.5"

self.rerank_model = "BAAI/bge-reranker-v2-m3"

def index_documents(self, documents):

"""文档索引化"""

embeddings = self.get_embeddings(documents)

# 存储到向量数据库(如Milvus、Pinecone等)

return embeddings

def search(self, query, top_k=10):

"""语义搜索"""

# 1. 查询向量化

query_embedding = self.get_embeddings([query])[0]

# 2. 向量检索(从向量数据库)

candidate_docs = self.vector_search(query_embedding, top_k * 2)

# 3. 重排序优化

reranked_results = self.rerank_documents(query, candidate_docs)

return reranked_results[:top_k]

def get_embeddings(self, texts):

response = requests.post(f"{self.api_base}/v1/embeddings", json={

"model": self.embedding_model,

"input": texts

})

return [item["embedding"] for item in response.json()["data"]]

def rerank_documents(self, query, documents):

response = requests.post(f"{self.api_base}/v1/rerank", json={

"model": self.rerank_model,

"query": query,

"documents": documents,

"return_documents": True

})

return response.json()["results"]

推荐系统应用

在推荐系统中利用文本向量进行内容理解:

class ContentRecommendationSystem:

def __init__(self):

self.api_base = "http://localhost:8000"

self.model = "BAAI/bge-m3" # 多语言模型

def compute_content_similarity(self, content_list):

"""计算内容相似度矩阵"""

embeddings = self.get_embeddings(content_list)

similarity_matrix = np.dot(embeddings, np.array(embeddings).T)

return similarity_matrix

def recommend_similar_content(self, target_content, candidate_contents, top_n=5):

"""基于内容相似度的推荐"""

all_contents = [target_content] + candidate_contents

embeddings = self.get_embeddings(all_contents)

target_embedding = embeddings[0]

candidate_embeddings = embeddings[1:]

# 计算余弦相似度

similarities = np.dot(candidate_embeddings, target_embedding)

# 排序并返回Top-N

sorted_indices = np.argsort(similarities)[::-1]

recommendations = []

for i in sorted_indices[:top_n]:

recommendations.append({

"content": candidate_contents[i],

"similarity": float(similarities[i])

})

return recommendations

🔮 未来发展趋势与技术展望

技术演进方向

1. 多模态支持 未来版本可能会支持图像、音频等多模态数据的向量化:

# 未来可能的API设计

@app.post("/v1/multimodal-embeddings")

async def create_multimodal_embeddings(request: MultimodalRequest):

# 支持文本、图像、音频的联合向量化

pass

2. 流式处理 对于大规模文档处理,支持流式API:

@app.post("/v1/embeddings/stream")

async def create_embeddings_stream(request: StreamEmbeddingRequest):

# 流式返回向量结果

async def generate():

for batch in process_in_batches(request.input):

yield batch_embeddings

return StreamingResponse(generate(), media_type="application/json")

3. 模型微调支持 集成模型微调能力,支持领域特定优化:

@app.post("/v1/models/finetune")

async def finetune_model(request: FinetuneRequest):

# 支持在线模型微调

pass

架构优化方向

1. 微服务化 将不同功能拆分为独立的微服务:

-

模型管理服务

-

向量计算服务

-

重排序服务

-

缓存服务

2. 分布式部署 支持多节点分布式部署,提升处理能力:

# Kubernetes部署配置示例

apiVersion: apps/v1

kind: Deployment

metadata:

name: antsk-py-api

spec:

replicas: 3

selector:

matchLabels:

app: antsk-py-api

template:

spec:

containers:

- name: api

image: antsk-py-api:latest

resources:

requests:

memory: "2Gi"

cpu: "1"

limits:

memory: "4Gi"

cpu: "2"

3. 智能负载均衡 基于模型类型和请求特征的智能路由:

class IntelligentLoadBalancer:

def route_request(self, request):

if "large" in request.model:

return self.high_memory_nodes

elif "rerank" in request.model:

return self.cpu_optimized_nodes

else:

return self.balanced_nodes

生态系统建设

1. 插件化架构 支持第三方模型和算法的插件化集成:

class ModelPlugin:

def load_model(self, model_path):

pass

def encode(self, texts):

pass

def compute_score(self, pairs):

pass

2. 监控与可观测性 集成Prometheus、Grafana等监控工具:

from prometheus_client import Counter, Histogram

REQUEST_COUNT = Counter('api_requests_total', 'Total API requests')

REQUEST_LATENCY = Histogram('api_request_duration_seconds', 'API request latency')

@app.middleware("http")

async def add_prometheus_metrics(request: Request, call_next):

start_time = time.time()

response = await call_next(request)

REQUEST_COUNT.inc()

REQUEST_LATENCY.observe(time.time() - start_time)

return response

3. 开发者生态 提供丰富的SDK和工具链:

# Python SDK示例

class AntSKClient:

def __init__(self, api_base, api_key=None):

self.api_base = api_base

self.api_key = api_key

def embeddings(self, texts, model="BAAI/bge-large-zh-v1.5"):

return self._post("/v1/embeddings", {

"model": model,

"input": texts

})

def rerank(self, query, documents, model="BAAI/bge-reranker-v2-m3"):

return self._post("/v1/rerank", {

"model": model,

"query": query,

"documents": documents

})

💡 最佳实践与性能调优

部署最佳实践

1. 资源配置建议

# 生产环境资源配置

resources:

requests:

memory: "4Gi" # 基础内存需求

cpu: "2" # CPU核心数

limits:

memory: "8Gi" # 内存上限

cpu: "4" # CPU上限

2. 环境变量优化

# 性能优化配置

export USE_FP16=true # 启用半精度

export MODEL_STORAGE_PATH=/fast/ssd # 使用SSD存储

export LOG_LEVEL=WARNING # 减少日志开销

export UVICORN_WORKERS=4 # 多进程部署

3. 监控指标设置

# 关键监控指标

METRICS = {

"request_rate": "每秒请求数",

"response_time": "响应时间",

"memory_usage": "内存使用率",

"model_load_time": "模型加载时间",

"error_rate": "错误率"

}

性能调优技巧

1. 批处理优化

def batch_process(texts, batch_size=32):

"""批量处理优化"""

results = []

for i in range(0, len(texts), batch_size):

batch = texts[i:i+batch_size]

batch_results = model.encode(batch)

results.extend(batch_results)

return results

2. 缓存策略

from functools import lru_cache

@lru_cache(maxsize=1000)

def cached_embedding(text, model_name):

"""LRU缓存优化"""

return model.encode([text])[0]

3. 异步优化

import asyncio

async def async_batch_embedding(texts, model):

"""异步批处理"""

tasks = []

for batch in create_batches(texts):

task = asyncio.create_task(process_batch(batch, model))

tasks.append(task)

results = await asyncio.gather(*tasks)

return flatten(results)

🛠️ 开发调试与问题排查

常见问题及解决方案

1. 内存不足问题

# 解决方案:启用FP16精度

export USE_FP16=true

# 或选择更小的模型

model_name = "BAAI/bge-small-zh-v1.5" # 替代large版本

2. 模型下载失败

# 解决方案:配置代理或使用镜像源

import os

os.environ['HF_ENDPOINT'] = 'https://hf-mirror.com'

3. 并发性能问题

# 解决方案:调整worker数量

uvicorn main:app --workers 4 --worker-class uvicorn.workers.UvicornWorker

调试工具与技巧

1. 性能分析

import cProfile

import pstats

def profile_api():

"""性能分析"""

profiler = cProfile.Profile()

profiler.enable()

# API调用

result = create_embeddings(request)

profiler.disable()

stats = pstats.Stats(profiler)

stats.sort_stats('cumulative')

stats.print_stats(10)

2. 内存监控

import psutil

import tracemalloc

def monitor_memory():

"""内存监控"""

tracemalloc.start()

# 执行操作

process = psutil.Process()

memory_info = process.memory_info()

current, peak = tracemalloc.get_traced_memory()

print(f"Current memory usage: {current / 1024 / 1024:.1f} MB")

print(f"Peak memory usage: {peak / 1024 / 1024:.1f} MB")

3. 日志分析

import logging

from logging.handlers import RotatingFileHandler

# 配置结构化日志

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s',

handlers=[

RotatingFileHandler('app.log', maxBytes=10485760, backupCount=5),

logging.StreamHandler()

]

)

🎯 总结与思考

AntSK-PyApi作为一个开源的企业级向量服务项目,在技术架构和实现细节上都体现了深度的工程思考。从智能的模型管理系统到高效的异步处理机制,从完善的异常处理到灵活的配置管理,每一个设计决策都体现了对企业级应用需求的深刻理解。

🌟 项目亮点总结

-

技术架构先进:基于FastAPI的异步架构,支持高并发处理

-

模型管理智能:多层缓存策略,自动下载和类型识别

-

API设计标准:兼容OpenAI格式,便于生态集成

-

部署方案完整:Docker化部署,支持容器编排

-

性能优化深入:FP16精度、批处理、异步优化等多重手段

-

企业级特性:异常处理、监控告警、配置管理等完善

🚀 技术价值与启示

对于开发者的启示:

-

架构设计的重要性:良好的架构设计是项目成功的基础

-

性能优化的系统性:从算法到工程的全方位优化思路

-

企业级特性的必要性:监控、日志、异常处理等不可忽视

对于企业应用的价值:

-

降低技术门槛:标准化API接口简化集成复杂度

-

提升开发效率:开箱即用的向量服务加速AI应用开发

-

保障服务质量:企业级特性确保生产环境稳定运行

🔮 未来展望

随着AI技术的快速发展,向量服务将在更多场景中发挥重要作用。AntSK-PyApi作为一个优秀的开源项目,为我们展示了如何构建高质量的AI基础设施。相信在社区的共同努力下,这个项目将会在多模态支持、分布式部署、智能优化等方向上持续演进,为AI应用生态贡献更大价值。

💬 互动讨论

看完这篇深度技术解析,你对AntSK-PyApi项目有什么看法?在你的实际项目中,是否遇到过类似的技术挑战?欢迎在评论区分享你的经验和思考:

🔥 讨论话题:

-

你认为向量服务在AI应用中最重要的特性是什么?

-

在模型管理和缓存策略方面,你有哪些优化建议?

-

对于企业级部署,你觉得还需要考虑哪些因素?

-

你是否有过类似的开源项目开发经验?有什么心得分享?

如果这篇文章对你有帮助,请点赞👍、收藏⭐、分享🔄,让更多开发者了解这个优秀的开源项目!

关注我,获取更多AI技术深度解析和开源项目分享!

标签: #AntSK #PyAPI #向量服务 #FastAPI #FlagEmbedding #文本嵌入 #文档重排序 #企业级架构 #开源项目 #AI基础设施

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)