联邦学习:如何在保护隐私的前提下训练AI

联邦学习是一种分布式机器学习方法,它允许在多个设备(如手机、边缘设备)上训练AI模型,而无需共享原始数据,从而保护用户隐私。以下是逐步解释其工作原理和隐私保护机制,确保回答结构清晰、可靠。如需进一步探讨特定技术(如差分隐私的数学细节)或实际案例,请随时提问!

·

联邦学习:在保护隐私的前提下训练AI

联邦学习是一种分布式机器学习方法,它允许在多个设备(如手机、边缘设备)上训练AI模型,而无需共享原始数据,从而保护用户隐私。以下是逐步解释其工作原理和隐私保护机制,确保回答结构清晰、可靠。

1. 联邦学习的基本概念

- 目标:在数据分散存储的背景下(例如,用户设备上的个人数据),协作训练一个全局AI模型,同时避免数据集中化带来的隐私风险。

- 核心思想:数据保留在本地设备上,仅共享模型更新(如梯度或参数增量),而非原始数据。

- 隐私优势:原始数据从不离开设备,大大降低数据泄露风险。

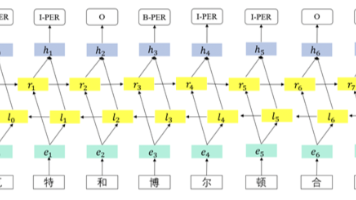

2. 联邦学习的工作流程

联邦学习通过迭代过程实现训练,每个迭代轮次包括以下步骤:

- 服务器初始化:中央服务器初始化全局模型,例如一个神经网络,参数为$w_0$。

- 设备本地训练:

- 每个设备下载当前全局模型$w_t$。

- 使用本地数据训练模型,计算本地更新(如梯度$\Delta w^{(i)}$)。

- 数学表示:本地损失函数最小化,例如$ \min_w L^{(i)}(w; D^{(i)}) $,其中$D^{(i)}$是第i个设备的私有数据。

- 更新上传:设备仅上传模型更新$\Delta w^{(i)}$到服务器(不共享$D^{(i)}$)。

- 服务器聚合:服务器安全地聚合所有更新,更新全局模型:

$$ w_{t+1} = w_t + \eta \cdot \frac{1}{n} \sum_{i=1}^{n} \Delta w^{(i)} $$

其中,$n$是设备数量,$\eta$是学习率。 - 重复迭代:重复步骤2-4,直到模型收敛。

3. 隐私保护的关键技术

为确保训练过程隐私安全,联邦学习结合多种机制:

- 数据本地化:原始数据始终保留在设备上,仅传输模型更新(如梯度),避免数据暴露。

- 加密通信:使用安全协议(如TLS)传输更新,防止中间人攻击。

- 差分隐私(Differential Privacy):

- 在本地更新中添加噪声,例如$\Delta w^{(i)} + \mathcal{N}(0, \sigma^2)$,其中$\mathcal{N}$是高斯噪声。

- 数学保证:添加噪声后,单个更新无法推断原始数据,满足$\epsilon$-差分隐私($\epsilon$是隐私预算)。

- 安全聚合(Secure Aggregation):

- 使用加密技术(如安全多方计算),使服务器只能看到聚合结果,无法访问单个设备的更新。

- 例如,设备上传加密的$\Delta w^{(i)}$,服务器解密后仅得到总和$\sum \Delta w^{(i)}$。

- 模型剪枝和量化:减少更新大小,降低通信中信息泄露风险。

4. 优点与挑战

- 优点:

- 隐私性强:数据不移动,符合GDPR等法规。

- 效率高:减少网络带宽使用,适用于移动设备。

- 可扩展性:支持大规模分布式数据源。

- 挑战:

- 通信开销:多轮迭代需要频繁设备-服务器通信。

- 数据异构性:不同设备数据分布不均(Non-IID),可能影响模型性能。

- 隐私-效用权衡:添加噪声(差分隐私)可能降低模型准确性。

5. 简单代码示例

以下Python伪代码展示联邦学习的核心流程(基于PyTorch风格):

import torch

# 服务器端

def server_aggregate(global_model, client_updates):

# 安全聚合更新(例如平均)

avg_update = torch.mean(torch.stack(client_updates), dim=0)

global_model = global_model + avg_update # 更新全局模型

return global_model

# 客户端(设备端)

def client_train(global_model, local_data):

# 下载全局模型

model = global_model.clone()

# 本地训练(数据不离开设备)

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

for epoch in range(10):

for x, y in local_data:

loss = torch.nn.functional.cross_entropy(model(x), y)

loss.backward()

optimizer.step()

# 计算并返回更新(仅梯度差)

update = model.parameters() - global_model.parameters()

return update

# 主循环

global_model = initialize_model() # 初始化模型

for round in range(100): # 训练轮次

client_updates = []

for client in clients:

update = client_train(global_model, client.local_data) # 本地训练

client_updates.append(update)

global_model = server_aggregate(global_model, client_updates) # 聚合更新

6. 实际应用与总结

- 应用场景:适用于医疗(医院间共享模型但不共享患者数据)、金融(银行协作反欺诈模型)或移动键盘预测(用户输入数据本地处理)。

- 总结:联邦学习通过在本地训练并仅共享加密或噪声化的模型更新,实现在保护隐私的前提下高效训练AI。成功部署需平衡隐私技术(如差分隐私)和模型性能,确保AI既智能又安全。

如需进一步探讨特定技术(如差分隐私的数学细节)或实际案例,请随时提问!

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)