多模态AI:当AI能同时理解文字、图片和声音

多模态AI通过融合文字、图片和声音,实现了更智能的感知和决策能力,推动AI从单一模态向全方位理解进化。其在日常生活和专业领域的应用日益广泛,但需持续优化以克服技术瓶颈。作为专业助手,我建议关注开源框架(如Hugging Face Transformers)进行实践探索。

·

多模态AI:同时理解文字、图片和声音

多模态AI是一种能够同时处理和分析多种类型数据的智能系统,例如文本、图像和音频。这种能力使AI更接近人类感知世界的方式,提升了其在复杂任务中的表现。下面,我将逐步解释其原理、关键技术和应用场景,帮助您全面理解这一领域。

1. 多模态AI的基本原理

多模态AI的核心在于“融合”不同模态的数据。每个模态(如文字、图片、声音)首先被单独处理以提取特征,然后这些特征被结合起来进行推理。例如:

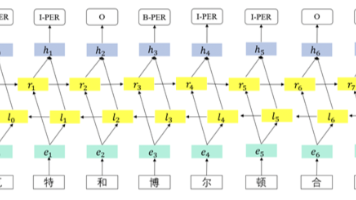

- 特征提取:使用深度学习模型(如卷积神经网络CNN处理图像、循环神经网络RNN处理音频、Transformer处理文本)将原始数据转换为数值特征向量。

- 特征融合:通过机制如注意力机制或加权平均,将不同模态的特征整合成一个统一表示。数学上,这可以用公式表示:

- 行内示例:设$z_t$为文本特征向量,$z_i$为图像特征向量,$z_a$为音频特征向量,则融合特征$z_f$可表示为$z_f = \alpha \cdot z_t + \beta \cdot z_i + \gamma \cdot z_a$,其中$\alpha, \beta, \gamma$是权重参数。

- 独立公式:对于更复杂的融合,如基于注意力的融合: $$ z_f = \sum_{m \in {t,i,a}} \text{softmax}(W_m z_m) \cdot z_m $$ 这里,$W_m$是可学习权重矩阵,$\text{softmax}$函数确保权重归一化。

- 推理输出:融合后的特征用于预测任务,如分类或生成,例如$P(\text{label} | z_f)$表示给定融合特征后标签的概率。

这种融合过程模拟了人类大脑整合感官信息的方式,使AI能处理跨模态任务,如从图片和文字描述中推断上下文。

2. 关键技术实现

多模态AI依赖于先进的算法和架构:

- 模型架构:主流模型使用Transformer-based架构(如CLIP或Multimodal Transformers),通过自注意力和交叉注意力机制对齐不同模态。例如,在处理图像和文本时,模型会计算图像区域与文本单词的相关性。

- 训练方法:采用对比学习或联合训练,在大型多模态数据集(如COCO或AudioSet)上预训练,以学习模态间的关联。损失函数常设计为最小化模态间差异,例如对比损失: $$ \mathcal{L} = -\log \frac{\exp(z_t \cdot z_i / \tau)}{\sum_{j} \exp(z_t \cdot z_j / \tau)} $$ 其中$\tau$是温度参数,$z_j$是负样本特征。

- 挑战与优化:模态间数据不平衡(如文本数据远多于音频)可能导致偏差。解决方案包括数据增强和自适应权重调整,确保所有模态公平贡献。

3. 实际应用场景

多模态AI已在多个领域落地,提升用户体验和效率:

- 智能助手:如语音助手结合文字指令和图像识别,实现“看、听、说”交互。例如,用户上传图片并说“描述这张照片”,AI能生成文字描述。

- 医疗诊断:分析医学影像(图片)、患者病历(文字)和语音症状描述,辅助医生决策,提高准确性。

- 自动驾驶:融合摄像头图像、雷达声音和导航文本,实时感知环境,避免事故。

- 内容创作:生成式AI如DALL·E或GPT-4,输入文字提示和音频线索,输出图像或视频。

4. 潜在挑战与未来方向

尽管强大,多模态AI仍面临挑战:

- 数据对齐:不同模态的时间或空间对齐问题(如视频中的音频与画面同步)需精细处理。

- 计算资源:融合多模态数据需更高算力,优化模型效率是关键。

- 伦理风险:偏见可能放大,需确保公平性和隐私保护。

未来,研究正聚焦于更高效的融合机制和通用多模态模型,使AI能无缝理解复杂真实世界。

总结

多模态AI通过融合文字、图片和声音,实现了更智能的感知和决策能力,推动AI从单一模态向全方位理解进化。其在日常生活和专业领域的应用日益广泛,但需持续优化以克服技术瓶颈。作为专业助手,我建议关注开源框架(如Hugging Face Transformers)进行实践探索。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)