AI大基建时代:FPGA明星梦碎,“伴星“机会仍在

中小规模FPGA的“伴星”模式,以较为低调的方式,通过做xPU等明星芯片的配套,在AI大基建时代,或许会拥有比大容量FPGA更多的机会?

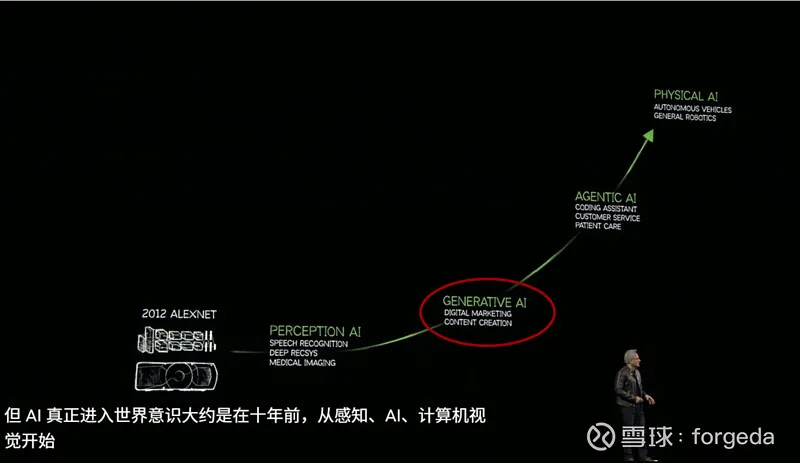

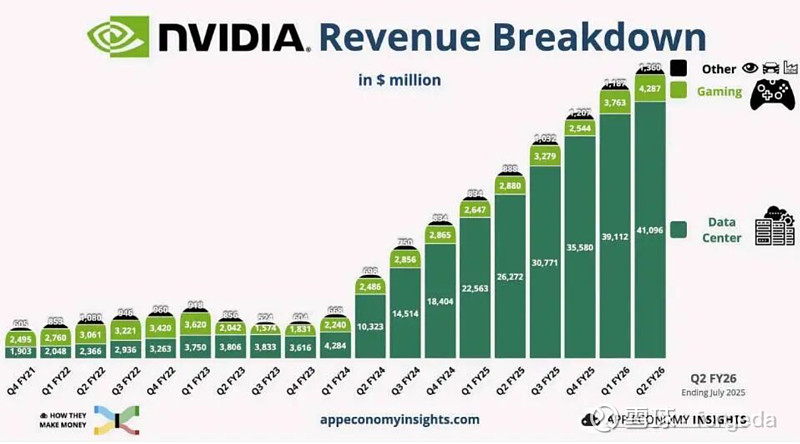

全球正以不可逆的确定性方式,大步跨入AI时代,率先启动以GPU芯片为核心的算力基础设施建设——AI数据中心,更是直接将英伟达的股价推高到超4万亿美元的宇宙最高位,顺便带动AI服务器、PCB、光模块等一众“达链”上的兄弟们,一起发财一起飞。

按照瑞银分析师的数据,大型科技公司今年的投资规模为3750亿美元,明年将继续攀升到5000亿美元

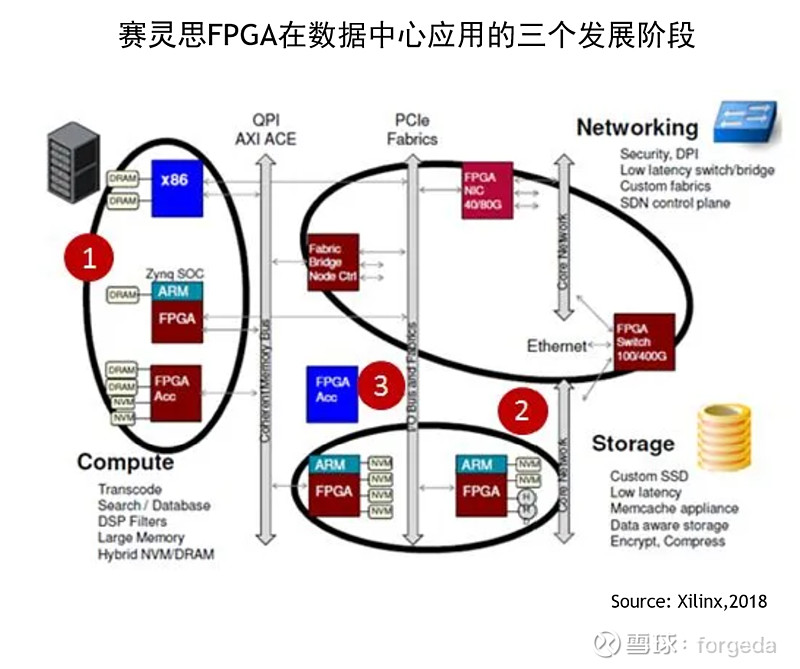

在第一波AI浪潮——感知AI(Perception AI)的崛起时,FPGA曾被给予厚望,包括Xilinx2017年推出数据中心战略优先,以及更早AI黎明(微软语)时代吃上异构计算红利的Altera。

2022年开始,生成式AI(Generative AI)火遍全球,各路模型九九归一,Transformer一统江湖,GPU登顶AI芯片王座,可以得到的大致结论是:数据中心FPGA,虽然C位的明星梦碎,但作为相对低调的伴星角色,则是红利长存。

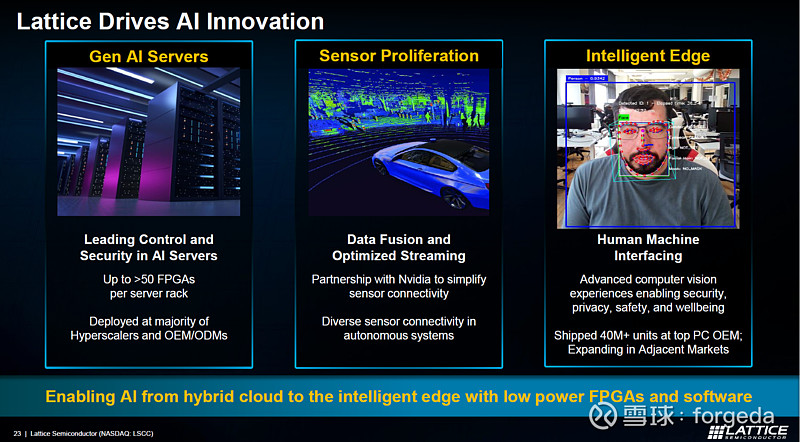

自从莱迪思(LSCC)在8月份发布季报以来,特别是公司CEO在电话会议中首次明确其中小规模FPGA,在AI时代数据中心的市场机会以来,股价已连续上涨,公司市值也悄悄重回90亿美元大关。

当然,相对于英伟达GPU卷起AI风暴带来的天量营收,FPGA在数据中心营收增幅,大概只相当于“钢镚”小钱。

相对于GPU的一骑绝尘,不只是FPGA,就连CPU都显得星光黯淡。

即便是对这个市场最重视、投入最多、也可能是表现最好的Altera,从英特尔的一买一卖大致已经可以得出结论:

数据中心的算力芯片C位之争,FPGA并不在其中。

虽然不乏有做AI推理芯片的初创企业Positron公司,首个产品使用的是Altera最新的Agilex-7M FPGAs,直接搭建大语言模型推理的AI计算机,比肩英伟达DGX H100,据称性能每瓦性能高约 5 倍,每美元性能比则是高 4 倍。

也有亚马逊云AWS弹性计算服务EC2 F1,已升级为全新新一代FPGA的F2,为基因组学、多媒体处理、大数据、网络安全/加速和基于云的视频广播领域的FPGA加速解决方案。

但前者只是其AI研发芯片的过渡产品,后者更多视为锦上添花,不太影响高性能FPGA,基本上已退出数据中心C位算力芯片竞争的共识。

一直主打“差异化”竞争的莱迪思公司,旗下FPGA正在成为诸多XPU、GPU、AI加速器、以及交换机的伴随芯片,营收持续增长,市场前景可期。

按照其管理层在2025Q2季报电话会上的介绍,目前在超大规模云服务提供商的机架上,通常有40-60台服务器,根据不同配置,每个机架有70-130个中小型FPGA芯片,这正是莱迪思在AI数据中心的目标市场。

根据自身优势进行精准角色定位。

按照其预估,2025年与AI相关营收,占比将近20%,到2026年时,将继续增长至25%左右。

集功耗、规模和价格三大应用优势于一身,是其作为“伴芯(companion chip)”角色的关键,完美避开了与两大头部厂商之间的直接竞争关系:

“大规模FPGA因功耗和成本因素,较难成为伴随芯片”。

手握超大规模高性能FPGA的赛灵思和阿尔特拉,难免有一颗“做C位明星"的心,直接与数据中心加速器客户,以及ASIC客户之间形成“排他式”的竞争关系。

并且,由于目前两大FPGA厂商均被两大CPU厂商收编,莱迪思认为其另一个优势在于作为纯血FPGA厂商,能够保持CPU中立。

就像国际政治关系中的瑞士类似,可以是夹缝中求生存,也可以看作左右逢源。

与莱迪思一样作为纯血FPGA厂商的安路科技,同样在2024年度报告中,同样表示“在数据中心等领域保持较高收入增长”,以及“在数据中心领域,FPGA能够使数据中心的不同器件更加有效的协同,最大程度发挥每个器件的硬件优势避免数据转换导致的算力空耗,提升云服务的响应速度和能效”的相关介绍。

或许也可以这样理解,中小规模FPGA的“伴星”模式,以较为低调的方式,通过做xPU等明星芯片的配套,在AI大基建时代,或许会拥有比大容量FPGA更多的机会?

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)