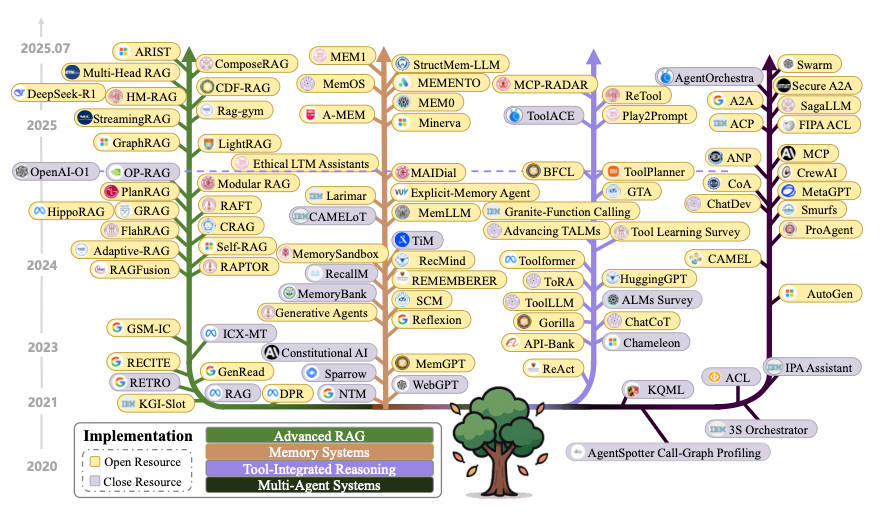

RAG、记忆、工具与多智能体:一文看懂上下文工程的技术框架

提示工程与上下文生成:通过精心设计的提示词来引导LLMs的行为,包括零样本(zero-shot)和少样本(few-shot)学习方法,以及通过链式思考(Chain-of-Thought)和树状思考(Tree-of-Thought)等技术来分解复杂问题,提高模型的推理能力。上下文工程的三大核心组件应对大语言模型中信息管理的核心挑战,并构建出一个完整框架——每个组件既针对上下文工程流程的不同环节发挥作

近期,来自中国科学院、加利福尼亚大学、昆士兰大学、北京大学、清华大学共同撰写的一篇论文《A Survey of Context Engineering for Large Language Models》,首次对于上下文工程进行了全面且系统性的回顾。

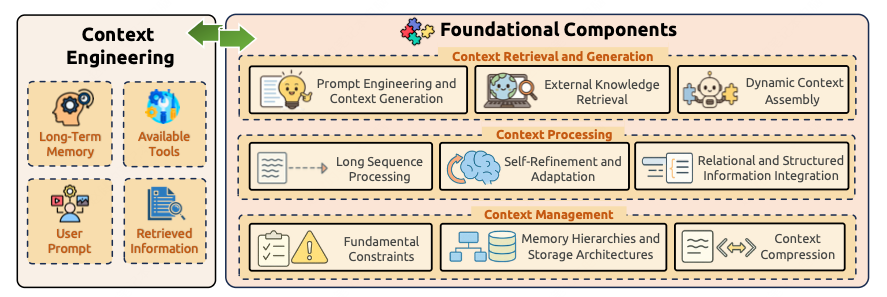

该论文最大的亮点在于提出了上下文工程的技术框架,将其分为“基础组件”与“系统实现”两大层面。

基础组件包括上下文检索与生成(Context Retrieval & Generation)、上下文处理(Context Processing)、上下文管理(Context Management)三部分,系统实现包括检索增强生成(RAG)、记忆系统(Memory Systems)、工具集成推理(Tool-Integrated Reasoning)、多智能体系统(Multi-Agent Systems)四部分。

上下文工程是 LLM 从“静态工具”进化为“动态智能体”的核心基础设施,其未来取决于跨模态、长程记忆与协作能力的突破。

# 01 上下文工程的基础组件

上下文工程的三大核心组件应对大语言模型中信息管理的核心挑战,并构建出一个完整框架——每个组件既针对上下文工程流程的不同环节发挥作用,又保持协同关系,从而实现全面的上下文优化并形成有效的上下文工程策略。

上下文检索与生成通过提示工程、外部知识检索和动态语境组装获取适配的上下文信息,细分为三个场景:

-

提示工程与上下文生成:通过精心设计的提示词来引导LLMs的行为,包括零样本(zero-shot)和少样本(few-shot)学习方法,以及通过链式思考(Chain-of-Thought)和树状思考(Tree-of-Thought)等技术来分解复杂问题,提高模型的推理能力。

-

外部知识检索:从外部知识库中检索信息,以增强模型的知识储备,包括检索增强生成(RAG)技术,以及通过知识图谱和结构化数据来提供更丰富的上下文。

-

动态上下文组装:将检索到的信息动态组合成适合模型处理的上下文,根据任务需求灵活地选择和整合不同的信息源。

上下文处理通过长序列处理、自我优化机制和结构化数据集成对获取的信息进行转换与优化,细分为四个场景:

-

长上下文处理:处理和优化长序列上下文,以提高模型对长文本的理解能力。包括了架构创新(如长网(LongNet)和闪电注意力(FlashAttention))来处理超长序列,以及通过位置插值和扩展技术来处理超出模型原始上下文窗口限制的文本。

-

上下文自我优化与适应:通过自我反馈和优化机制动态调整上下文,包括自我精炼(Self-Refine)和多方面反馈(Multi-Aspect Feedback)等技术,这些技术允许模型通过迭代改进来提高输出质量。

-

多模态上下文:将多模态数据(如图像、音频、视频)整合到上下文中,以增强模型的感知能力。这涉及到将不同模态的数据转换为模型能够理解的格式,以及处理多模态数据之间的关系。

-

关系与结构化上下文:处理和优化结构化数据,以提高模型对复杂关系的理解,包括图神经网络(Graph Neural Networks)和知识图谱嵌入技术,来增强模型的推理能力。

上下文管理则通过突破基础约束、实施精密内存层级结构和开发压缩技术,实现语境信息的高效组织与利用,细分为三个场景。

-

基本约束:处理上下文时面临的基本限制,如上下文长度限制和模型的有限内存,在这些限制下有效地组织和检索上下文信息。

-

内存层次与存储架构:设计高效的内存管理和存储架构,以支持长上下文的处理。包括通过分层内存结构和压缩技术来优化内存使用。

-

上下文压缩:通过压缩技术减少上下文的存储和计算开销,包括通过自编码器(Autoencoders)和记忆增强技术来实现上下文的高效压缩。

将上下文管理技术应用于实际场景,如对话系统和推荐系统,可以提高系统的性能和用户体验。

# 02 上下文工程的的系统实现

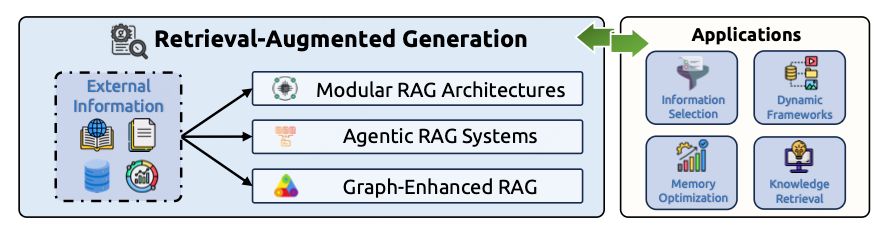

将基础组件整合为实用智能架构的先进系统实现,就是上下文工程的“系统实现”,标志着从理论框架到可部署系统的演进。

检索增强生成系统(RAG),通过将外部知识源与语言模型生成能力相融合,成功弥合了参数化知识与动态信息获取之间的鸿沟。

-

模块化 RAG 架构:将 RAG 系统模块化,提高系统的灵活性和可扩展性。模块化设计允许开发者根据具体需求选择和组合不同的组件,从而构建出更高效、更适应特定任务的系统。

-

代理 RAG 系统:引入代理机制,使系统能够动态地检索和利用外部知识。代理可以根据任务需求自主地决定何时检索信息,以及如何处理检索到的信息,从而提高系统的适应性和效率。

-

图增强 RAG:利用图结构化知识,提高模型对复杂关系的理解和推理能力。图结构可以更好地表示实体之间的关系,从而增强模型的推理能力,使其能够处理更复杂的任务。

将 RAG 系统应用于实际任务,如问答系统和文本生成,系统能够生成更准确、更丰富的回答和文本内容。

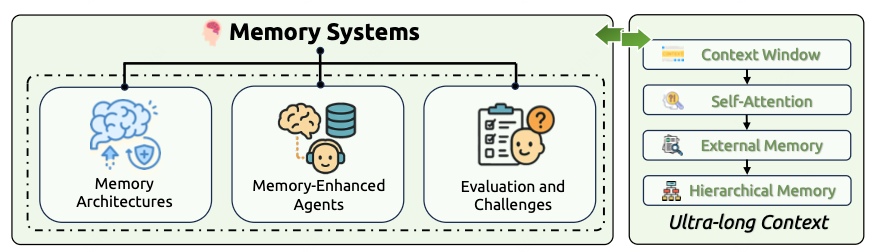

记忆系统通过实现持久化信息存储、检索与利用机制,使大语言模型能够超越无状态交互的局限。该技术将模型从模式匹配处理器转变为具备学习能力、适应性和长期语境理解能力的智能体,使其能够在持续交互中实现跨越式发展。

-

记忆架构:设计多层记忆架构,支持不同类型的上下文存储。记忆架构的设计需要平衡存储效率和访问速度,以满足不同任务的需求。

-

记忆增强型代理:通过代理机制增强模型的记忆管理能力。代理可以根据任务需求动态地管理内存,提高记忆的利用效率,从而增强系统的性能。

-

评估与挑战:评估内存系统的性能,并解决实际应用中的挑战。这包括如何处理内存中的信息过载问题,以及如何确保信息的准确性和一致性。

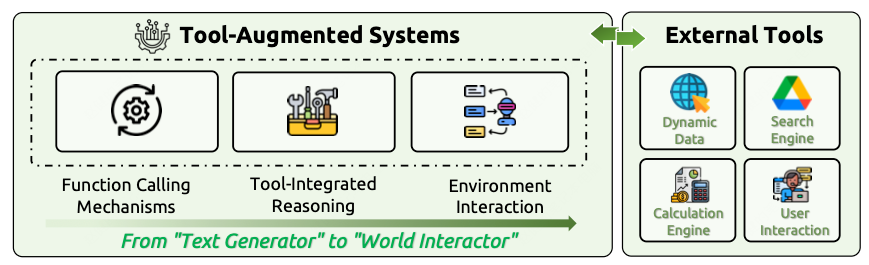

工具增强系统将语言模型从被动的文本生成器转变为能动态使用工具并操控环境的主动世界交互者。该技术通过函数调用机制、集成化推理框架和先进的环境交互能力,使模型能够突破其固有局限。

-

函数调用机制:设计高效的函数调用机制,使模型能够调用外部工具。函数调用机制允许模型在需要时调用特定的工具,从而扩展其功能和能力。

-

工具集成推理:通过工具集成提高模型的推理能力。工具集成推理使模型能够利用外部工具提供的功能,从而更好地完成复杂的任务。

-

代理与环境互动:使模型能够与外部环境进行互动,以完成复杂任务。代理可以根据任务需求与环境进行交互,动态地获取和利用信息,从而提高系统的适应性和效率。

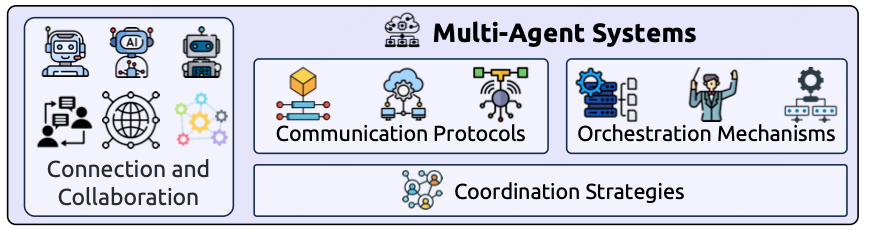

多智能体系统堪称协作智能的巅峰之作,它使多个自主智能体能够通过协调与通信,解决超越单个智能体能力的复杂问题。该技术聚焦于精密通信协议、协同编排机制与协调策略,实现在异构智能体架构间的无缝协作。

-

通信协议:设计高效的通信协议,使代理之间能够有效协作。通信协议需要确保信息的准确传递和及时反馈,从而提高系统的整体性能。

-

协调机制:通过协调机制优化代理之间的协作。协调机制可以确保代理之间的任务分配和资源管理,从而提高系统的效率和稳定性。

-

协作策略:制定有效的协作策略,以提高系统的整体性能。协作策略需要根据任务需求和代理的能力进行动态调整,从而实现最优的协作效果。

总结来看,RAG系统通过模块化架构与图增强技术实现外部知识集成;记忆系统借助精密内存架构实现持久化语境管理,支撑长期学习能力;工具集成推理通过函数调用与环境交互使语言模型成为世界交互者;多智能体系统通过通信协议与协同机制展现多代理协作模式。每种实现方式既构建于基础组件之上,又针对语境利用中的特定挑战。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)