让AI学会“温故而知新”:基于最近邻方法的智能新范式

在当今所有AI都在追求更大、更复杂的神经网络时,一股新的思潮正在悄然兴起:为什么不让我们AI系统像一个博闻强识的智者一样,通过“回忆”和“类比”过去的知识来解决新问题呢?它让我们看到,人工智能的未来,或许不是一味地追求更大的模型,而是走向一种“模型(大脑) + 数据库(记忆)” 的更优雅、更高效、也更接近人类思维的架构。它告诉我们,智能不仅在于抽象概括的能力,也在于精准回忆和灵活应用的经验。当AI

—— Novel Approaches to AI Development Based on Nearest Neighbor Method

今天,我想和大家探讨一个听起来有些“复古”却又极具革命性的话题——基于最近邻方法的人工智能新范式。在当今所有AI都在追求更大、更复杂的神经网络时,一股新的思潮正在悄然兴起:为什么不让我们AI系统像一个博闻强识的智者一样,通过“回忆”和“类比”过去的知识来解决新问题呢?

这并非要取代现有的深度学习,而是为其赋予一种更根本、更高效、也更容易理解的智能。

一、困境:传统AI的“能耗之痛”与“遗忘之殇”

我们今天的AI,尤其是大型语言模型,取得了惊人的成就,但也面临着两大严峻挑战:

1. 巨大的能耗:训练一个GPT级别的模型,其碳排放量相当于五辆汽车一生的排放总和。每一次微调、每一个新任务,都可能需要巨大的计算资源。

2. 致命的“幻觉”:模型会 confidently 编造事实,因为它本质上是一个“统计生成器”,而非一个“事实回忆器”。它学会了语法和模式,但无法确切地记住和核查知识。

我们不禁要问:是否存在一种方式,能让AI在拥有强大能力的同时,又像查阅百科全书一样精准、且无需每次都从头学起?

最近邻方法(k-NN)的现代化应用,正是对这个问题的精彩回答。

二、核心思想:从“死记硬背”到“即查即用”

最近邻方法的核心思想非常简单,甚至可以说是机器学习中最直观的概念之一:要判断一个新事物是什么,只需看看它最像你已知的哪个事物。

想象一下,你是一位经验丰富的医生。当遇到一位新病人时,你不会凭空做出诊断,而是会迅速在脑海中回忆:“这个病人的症状,和我过去治疗过的哪位病人最相似?” 然后,你会参考当时的病历和成功治疗方案。

这个“回忆-比对-应用”的过程,就是基于最近邻方法的AI新范式的精髓。

它与传统神经网络的对比在于:

· 传统神经网络:像一个刻苦的学生,通过大量习题训练,把知识“压缩”进网络的权重(参数)里。优点是速度快,缺点是知识被固化,难以更新,且过程不透明。

· 最近邻方法:像一位老师傅,拥有一个巨大的、随时可更新的“案例库”(数据库)。遇到新问题,就去库里去寻找最相似的案例来解决。优点是灵活、可解释、知识更新成本低,缺点是“查阅”需要时间。

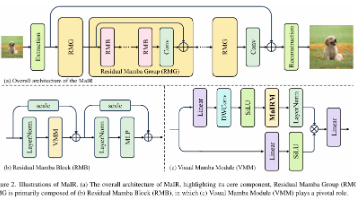

三、新范式如何工作?三大“现代化”改造

你可能会问,古老的k-NN如何应对现代AI的复杂任务?研究者们赋予了它三项现代化的“超能力”:

1. 深度表征(Deep Representation):

· 古老k-NN:比较的是原始的像素或单词。

· 现代k-NN:先用一个深度神经网络(如BERT, GPT)将输入(文本、图像)转化为一个高维的、蕴含语义的向量(Vector)。这个向量就是数据的“数字指纹”。

· 比喻:不再是比对两篇文章的每一个字是否相同,而是比较两篇文章的“中心思想”是否相似。

2. 大规模高效检索(Efficient Retrieval):

· 在数十亿的“案例”中快速找到最相似的那一个,靠的不是线性扫描,而是使用近似最近邻(ANN)搜索算法,如FAISS。这就像用导航软件在全球地图上瞬间找到离你最近的咖啡店,而不是一家一家去敲门。

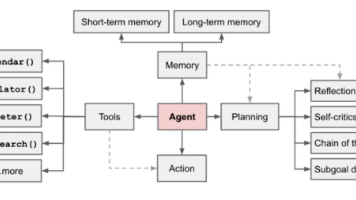

3. 与神经网络的协同(Hybrid Models):

· 这是最激动人心的部分!最新研究不再二选一,而是让神经网络和最近邻库协同工作。

· 工作流程:

a. 神经网络接收一个问题。

b. 系统立刻在庞大的“记忆库”中检索与之最相关的若干信息片段。

c. 神经网络将“检索到的信息”和“问题”结合起来,生成最终答案。

· 这就是当前最前沿的“检索增强生成(RAG)”技术的思想核心。

四、为什么说这是“新范式”?它的巨大优势是什么?

这种结合了深度学习和最近邻检索的方法,带来了一场静悄悄的革命:

1. 动态知识,永不落伍:模型的知识存在外部数据库里。要更新知识?只需更新数据库即可,无需重新训练动辄耗费百万的模型。这让AI能够轻松追踪最新信息。

2. 源头可溯,减少“幻觉”:模型给出的答案,可以标注出是参考了“记忆库”中的哪一条信息。这大大增强了答案的可信度和可解释性,让AI“引经据典”,而非“信口开河”。

3. 计算高效,绿色低碳:将庞大的知识存储与复杂的推理计算分离。训练一个强大的“大脑”(深度模型)一次,然后可以通过更换不同的“记忆库”来适应不同领域,极大降低了能源消耗。

4. 小样本学习,快速适应:对于一个新领域,我可能只需要为“记忆库”添加几十个高质量样本,模型就能表现出不错的效果,而不需要数以万计的标注数据。

结语:通向更稳健、更可信的AI

同学们,这项“新”范式之所以迷人,不是因为它推翻了深度学习,而是因为它弥补了深度学习的固有缺陷。它让我们看到,人工智能的未来,或许不是一味地追求更大的模型,而是走向一种“模型(大脑) + 数据库(记忆)” 的更优雅、更高效、也更接近人类思维的架构。

它告诉我们,智能不仅在于抽象概括的能力,也在于精准回忆和灵活应用的经验。当AI既拥有了深度神经网络的“悟性”,又拥有了最近邻方法的“记性”时,我们才能真正迈向一个更可靠、更可信的智能时代。

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)