【OpenAI】马斯克杀入 AI 编程!xAI 新模型 Grok Code Fast 1 发布 + API KET的使用教程!

当开发者通过 OpenAI API 调用模型服务时,需要在请求中携带这串 Key,OpenAI 服务器通过验证 Key 的有效性,来确认开发者的身份、判断其是否拥有调用权限,并统计 API 的使用量(用于计费)。简单来说,OpenAI Key 就像是开发者访问 OpenAI 模型能力的“钥匙”,没有 Key 则无法通过 API 使用 OpenAI 的技术服务。

文章目录

马斯克杀入 AI 编程!xAI 新模型 Grok Code Fast 1 发布

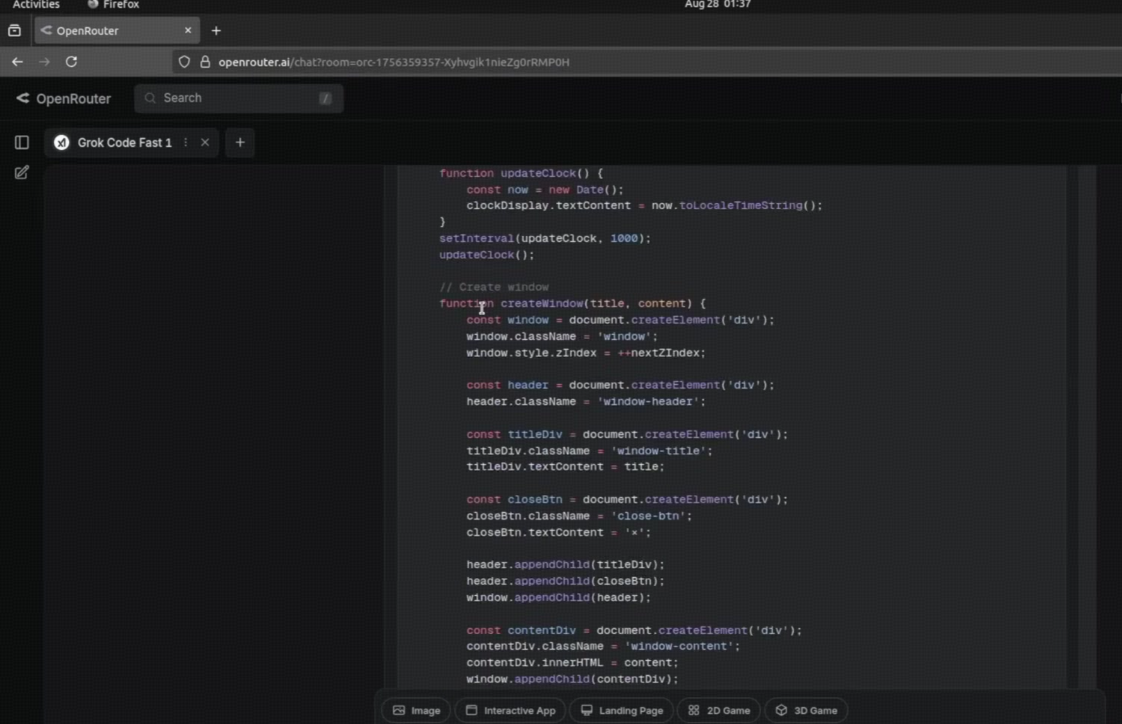

AI 编程的赛道,又迎来一位重量级玩家 —— 马斯克的 xAI。最近,xAI 悄然发布了一款专为编码而生的新模型:Grok Code Fast 1。这款模型最初以代号 “Sonic” 在内部流传,如今正式亮相,便凭借其 256K 超长上下文、惊人的速度和极具竞争力的价格,迅速在开发者社区掀起波澜。更重要的是,它目前已在多个平台开放限时免费试用!这究竟是 xAI 的一次炫技,还是将改变我们编程方式的又一利器?下面将为你带来全方位的深度解析。

一、背景:不止是快,更是为 “AI 代理” 而生

Grok Code Fast 1 并非凭空出世。它是 xAI Grok 产品线中的一个垂直变体,与通用的 Grok-3 或 Grok-4 不同,它的目标非常明确:专注并优化代理式编码(Agentic Coding)任务。

什么是代理式编码?

简单来说,就是让 AI 不再仅仅是一个代码补全或问答工具,而是成为一个能够理解复杂任务、自主规划步骤、调用外部工具(如 API、数据库)、并最终交付完整解决方案的智能代理。为了实现这个目标,xAI 将 Grok Code Fast 1 的核心定位为 “快、准、省”:

- 快 (Fast):为实时交互和高频任务设计,减少开发者等待时间。

- 准 (Accurate):继承 Grok 系列的强大推理能力,并针对编码场景进行微调。

- 省 (Economical):提供极具吸引力的定价,降低企业和个人开发者的使用门槛。

发布后,xAI 迅速将其推向主流生态,目前已集成到 OpenRouter、Poe、Vercel AI Gateway,甚至进入了 GitHub Copilot 的公共预览版。这种开放的姿态,无疑是 xAI 在 AI 代理时代抢占开发者心智的重要一步。

二、核心特性:是什么让它与众不同?

Grok Code Fast 1 的强大之处,在于其专为开发者痛点设计的一系列功能。

-

代理式编码支持 (Agentic Coding)

这是它的核心亮点。它能处理复杂的工作流,例如:“分析我们项目的用户反馈数据库,找出 TOP 3 的功能需求,并为这些需求生成初步的 API 设计和 Python 实现代码。” 在这个任务中,它需要分解问题、查询数据库(通过函数调用)、分析数据、最后再生成代码,这已经远远超出了传统代码生成器的范畴。 -

可见推理痕迹 (Visible Reasoning Traces)

这是开发者梦寐以求的功能!在给出最终答案前,Grok Code Fast 1 会展示它的“思考过程”。它就像给 AI 的大脑装上了一个“监视器”,让你能清楚地看到:它是如何理解你的问题的?它计划分几步来解决?每一步的推理依据是什么?这种透明度极大地提升了 AI 的可控性和可调试性。当结果不符合预期时,你可以根据推理痕迹快速定位问题,并优化你的提示词(Prompt)。 -

强大的可控性与工具使用 (Steerability & Function Calling)

模型提供了高度可调的行为机制。你可以通过 Prompt 精确控制其输出风格、代码规范和解决方案的侧重点。同时,它原生支持函数调用和外部工具集成,可以轻松连接你的 API、数据库或任何内部系统,构建强大的自动化工作流。 -

256K 超长上下文窗口

256,000 tokens 的上下文长度意味着:- 可以轻松处理整个代码库,你可以把一个中小型项目的所有核心代码都喂给它,让它进行重构、添加新功能或修复深层 Bug;

- 能够理解复杂文档,无论是厚厚的 API 文档还是项目需求书,它都能完整消化,并在此基础上进行开发;

- 支持长链条推理,在复杂的调试过程中,它不会因为对话过长而“忘记”前面的关键信息。

-

结构化输出 (Structured Outputs)

模型可以稳定地以 JSON 等格式返回响应,这对于需要进行程序化解析和集成的应用场景至关重要,让 AI 的输出能无缝对接到你的开发工具链中。

三、性能与技术规格:它到底有多能打?

尽管 xAI 未公布模型的具体参数规模,但从其表现来看,它无疑是基于百亿级参数的大模型,并在海量高质量代码和推理数据上进行了深度微调。

- 上下文长度:256,000 tokens。

- 知识截止日期:可能与 Grok 3 相似(2024 年 11 月)。

- 性能表现:根据第三方平台(如 Rival)的初步评测,Grok Code Fast 1 在编码生成、视觉数学推理和文档问答等基准测试中,表现优于或持平于 Claude 3.5 Sonnet 和 GPT-4-Turbo,但在响应速度和成本上优势明显。

- 成本优势:xAI 官方声称,在企业级任务中,该模型结合其独特的缓存输入令牌机制,最高可将成本降低 20%-50%。

四、如何上手?API 访问指南

接入 Grok Code Fast 1 非常简单,具体方式如下:

- 官方 API:通过 xAI 官网申请 API 密钥,其接口与 OpenAI API 兼容,迁移成本极低。

什么是 OpenAI Key?

1. 定义与本质

OpenAI Key(又称 “OpenAI API Key”),是 OpenAI 为开发者提供的身份认证凭证,本质上是一串由字母、数字和特殊符号组成的唯一字符串(例如:sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx)。

当开发者通过 OpenAI API 调用模型服务时,需要在请求中携带这串 Key,OpenAI 服务器通过验证 Key 的有效性,来确认开发者的身份、判断其是否拥有调用权限,并统计 API 的使用量(用于计费)。简单来说,OpenAI Key 就像是开发者访问 OpenAI 模型能力的“钥匙”,没有 Key 则无法通过 API 使用 OpenAI 的技术服务。

2. OpenAI Key 的核心作用

-

身份验证

OpenAI 通过 Key 识别开发者身份,确保只有注册并获得授权的用户才能调用 API,防止未授权访问与滥用。 -

权限控制

不同类型的 Key 对应不同的权限,例如:免费账号的 Key 有调用次数、模型类型限制(如无法调用 GPT-4);付费账号的 Key 可解锁更多模型、更高调用额度,且支持自定义 API 参数(如上下文窗口长度、响应速度)。 -

用量统计与计费

OpenAI 根据 Key 的调用记录统计开发者使用 API 的次数(按 “token” 计费,token 是模型处理文本的基本单位,1 个 token 约等于 0.75 个英文单词或 2 个中文字符),并根据用量从开发者绑定的支付方式中扣费(免费账号通常有初始额度,如 5 美元,用完后需升级付费)。 -

资源管理

开发者可创建多个 Key,为不同的项目、应用分配独立的 Key,便于区分不同场景的 API 使用情况,也能在某个 Key 泄露时快速删除,避免影响其他项目。

3.OpenAI API Key的使用场景

- 自动化集成:将OpenAI的文本生成能力集成到现有应用、网站或服务中,实现流程自动化。

- 专属大模型应用:利用API Key创建个性化的AI应用,如智能客服、内容推荐系统等。

- 数据分析与处理:通过API调用进行自然语言处理,提升数据分析的智能化水平。

无论你身处哪个领域,掌握API Key的获取与使用,都能为你的项目增添无限可能。

通过“OpenAI官网”获取API Key(国外)

1、访问OpenAI官网

在浏览器中输入OpenAI官网的地址,进入官方网站主页。

https://www.openai.com

- 点击右上角的“Sign Up”进行注册,或选择“Login”登录已有账户。

- 完成相关的账户信息填写和验证,确保账户的安全性。

登录后,导航至“API Keys”部分,通常位于用户中心或设置页面中。

2、生成API Key

- 在API Keys页面,点击“Create new key”按钮。

- 按照提示完成API Key的创建过程,并将生成的Key妥善保存在安全的地方,避免泄露。🔒

3、使用 OpenAI API代码

现在你已经拥有了 API Key 并完成了充值,接下来是如何在你的项目中使用 GPT-4.0 API。以下是一个简单的 Python 示例,展示如何调用 API 生成文本:

import openai

import os

# 设置 API Key

openai.api_key = os.getenv("OPENAI_API_KEY")

# 调用 GPT-4.0 API

response = openai.Completion.create(

model="gpt-4.0-turbo",

prompt="鲁迅与周树人的关系。",

max_tokens=100

)

# 打印响应内容

print(response.choices[0].text.strip())

通过“能用AI”获取API Key(国内)

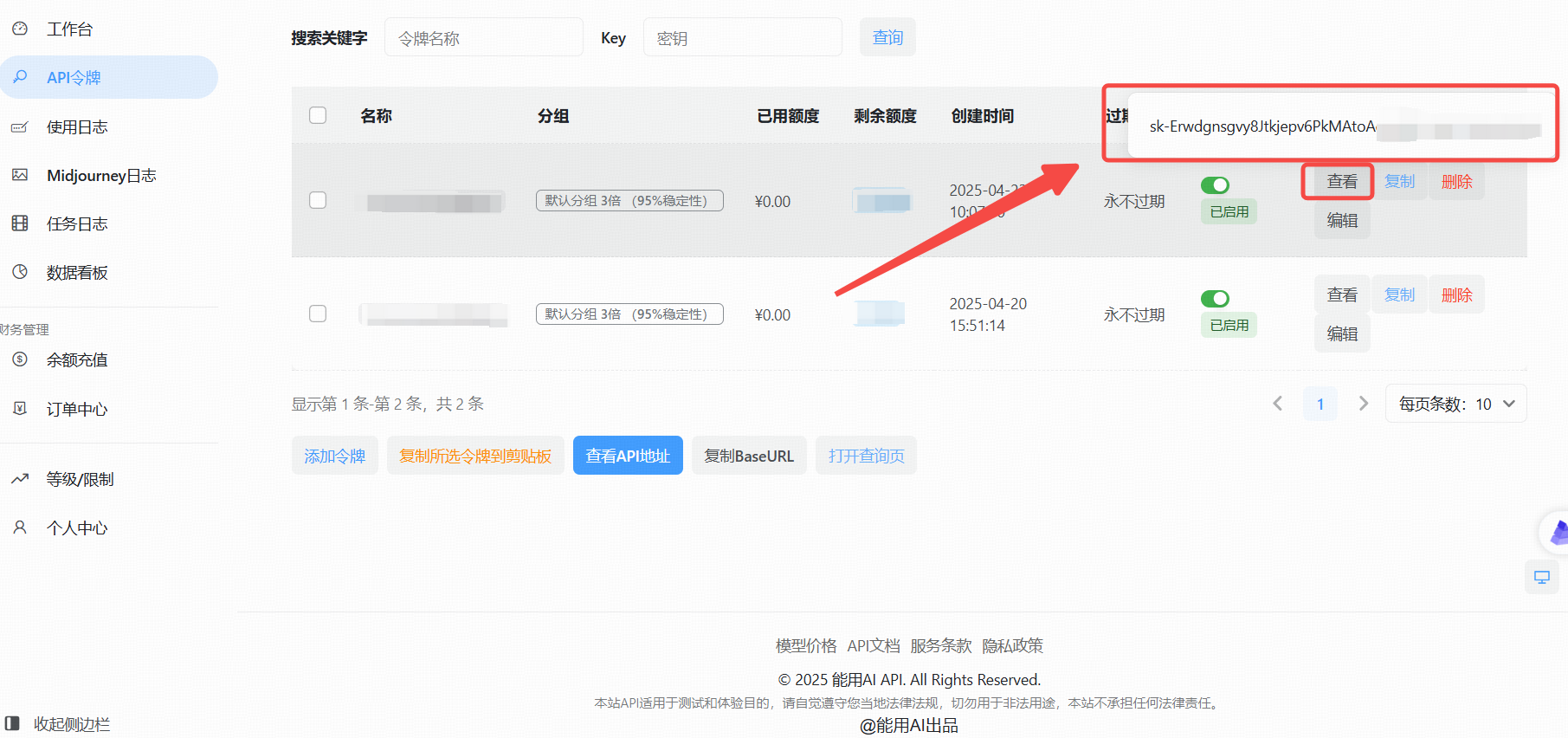

针对国内用户,由于部分海外服务访问限制,可以通过国内平台“能用AI”获取API Key。

1、访问能用AI工具

在浏览器中打开能用AI进入主页

https://ai.nengyongai.cn/register?aff=PEeJ

登录后,导航至API管理页面。

2、生成API Key

- 点击“添加令牌”按钮。

- 创建成功后,点击“查看KEY”按钮,获取你的API Key。

###/3、使用OpenAI API的实战教程

拥有了API Key后,接下来就是如何在你的项目中调用OpenAI API了。以下以Python为例,详细展示如何进行调用。

(1).可以调用的模型

gpt-3.5-turbo

gpt-3.5-turbo-1106

gpt-3.5-turbo-0125

gpt-3.5-16K

gpt-4

gpt-4-1106-preview

gpt-4-0125-preview

gpt-4-1106-vision-preview

gpt-4-turbo-2024-04-09

gpt-4o-2024-05-13

gpt-4-32K

claude-2

claude-3-opus-20240229

claude-3-sonnet-20240229

(2).Python示例代码(基础)

基本使用:直接调用,没有设置系统提示词的代码

from openai import OpenAI

client = OpenAI(

api_key="这里是能用AI的api_key",

base_url="https://ai.nengyongai.cn/v1"

)

response = client.chat.completions.create(

messages=[

# 把用户提示词传进来content

{'role': 'user', 'content': "鲁迅为什么打周树人?"},

],

model='gpt-4', # 上面写了可以调用的模型

stream=True # 一定要设置True

)

for chunk in response:

print(chunk.choices[0].delta.content, end="", flush=True)

在这里插入代码片

(3).Python示例代码(高阶)

进阶代码:根据用户反馈的问题,用GPT进行问题分类

from openai import OpenAI

# 创建OpenAI客户端

client = OpenAI(

api_key="your_api_key", # 你自己创建创建的Key

base_url="https://ai.nengyongai.cn/v1"

)

def api(content):

print()

# 这里是系统提示词

sysContent = f"请对下面的内容进行分类,并且描述出对应分类的理由。你只需要根据用户的内容输出下面几种类型:bug类型,用户体验问题,用户吐槽." \

f"输出格式:[类型]-[问题:{content}]-[分析的理由]"

response = client.chat.completions.create(

messages=[

# 把系统提示词传进来sysContent

{'role': 'system', 'content': sysContent},

# 把用户提示词传进来content

{'role': 'user', 'content': content},

],

# 这是模型

model='gpt-4', # 上面写了可以调用的模型

stream=True

)

for chunk in response:

print(chunk.choices[0].delta.content, end="", flush=True)

if __name__ == '__main__':

content = "这个页面不太好看"

api(content)

通过这段代码,你可以轻松地与OpenAI GPT-4.0模型进行交互,获取所需的文本内容。✨

更多文章

【IDER、PyCharm】免费AI编程工具完整教程:ChatGPT Free - Support Key call AI GPT-o1 Claude3.5

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)