直播美颜SDK架构设计详解:如何支持高效的面具特效功能?

本文从技术架构的角度,详解了直播美颜SDK如何支持高效的面具特效功能,涵盖图像处理、AI人脸识别、渲染引擎、插件化扩展及跨平台适配等核心模块,并分析了技术难点与商业应用价值。对于直播平台和短视频APP开发者来说,这是提升用户粘性与商业化转化的必读指南。

在当今的直播和短视频浪潮中,“美颜+特效”几乎已经成为平台的标配。观众们早已不满足于单一的滤镜和磨皮,面具特效(Mask Effect)凭借实时趣味性和互动性,逐渐成为美颜SDK中的重要功能。一个能高效支持面具特效的直播美颜SDK架构,不仅能带来更丝滑的用户体验,还能直接提升平台的留存率和商业变现能力。

那么,如何从技术架构的角度,设计出既高性能、又灵活扩展的美颜SDK?今天,笔者将结合图像处理、实时渲染、AI识别等核心要素,带你走进“面具特效功能”的幕后。

一、为什么面具特效成为直播标配?

在直播场景中,观众追求的不只是美颜后的自然效果,更是互动中的新鲜感。比如:

在娱乐直播中,主播戴上卡通面具,能迅速拉近与粉丝的距离;

在电商直播中,虚拟面具可以叠加品牌元素,达到“软广告”的效果;

在社交直播中,情侣PK戴上搞怪面具,互动趣味性瞬间拉满。

从商业价值来看,面具特效已经不单是娱乐工具,更是提升用户粘性与转化率的“增长引擎”。

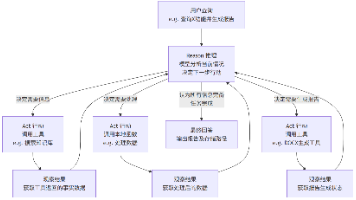

二、直播美颜SDK的架构核心

一个完善的美颜SDK架构,往往由以下几层组成:

底层图像处理模块

负责实时获取视频流,并完成基本的图像预处理(如降噪、曝光校正、色彩增强)。

性能要求极高,需要在毫秒级别完成处理,避免直播延迟。

AI人脸识别与关键点检测模块

面具特效的核心在于“贴合”,而贴合的前提是精准的人脸识别。

借助深度学习模型,可以检测面部关键点(眼睛、鼻梁、嘴角等),为后续特效叠加提供定位坐标。

特效渲染引擎

支持2D/3D特效实时渲染,常见技术包括OpenGL、Metal、Vulkan等。

优秀的引擎会对GPU资源进行优化,保证特效不卡顿、不掉帧。

插件式特效管理器

面具特效需要灵活扩展,例如:节日面具、品牌联名面具、互动面具。

插件式架构可以让开发者在不修改底层代码的前提下,快速接入新的素材。

跨平台适配层

无论是iOS、Android,还是PC端直播推流软件,美颜SDK都要保证一致的特效体验。

这意味着底层代码需要有良好的跨平台抽象,减少重复开发成本。

三、面具特效的技术难点与解决方案

人脸跟踪的稳定性

难点:当主播快速转头、光线不足或佩戴眼镜时,面具可能会“漂移”。

解决方案:采用深度学习+多帧预测的混合算法,提升关键点跟踪稳定性。

渲染性能瓶颈

难点:实时面具渲染需要同时处理美颜、滤镜、贴纸等多重特效,容易造成卡顿。

解决方案:引入GPU并行渲染、分辨率动态调整、纹理复用技术。

素材兼容与扩展性

难点:不同设计师制作的面具素材,格式和适配性差异大。

解决方案:统一素材规范(如FBX、GLTF),并在SDK中内置素材解析器。

写在最后:

从架构层面看,支持高效面具特效的直播美颜SDK,需要在性能优化、AI识别、渲染能力和扩展性上全面发力。它不仅仅是一套图像处理工具,更是推动直播行业商业化、互动化的关键引擎。

对于正在搭建直播平台或研发短视频应用的企业而言,选择一个性能稳定、跨平台兼容、支持插件化扩展的美颜SDK,将在用户体验和商业价值之间,找到最佳平衡点。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)