区域经济预测的AI模型落地:AI应用架构师的3个成功项目复盘

区域经济预测(如GDP、就业率、产业增加值)是政府制定产业政策、企业选择投资方向的“指南针”。传统方法依赖历史数据+线性模型滞后性:统计数据通常滞后1-2年,无法反映当前经济变化(如新能源产业的快速增长);非线性关系捕捉能力弱:经济变量间的关系(如“新能源投资”与“GDP增长”)是非线性的,线性模型无法准确拟合;数据维度有限:传统方法仅用统计年鉴数据,忽略了卫星遥感、互联网等实时数据(如人口流动、

区域经济预测AI模型落地实战:3个成功项目的架构师复盘

关键词:区域经济预测、AI模型落地、架构设计、项目复盘、特征工程、模型部署、可解释性

摘要:

区域经济预测是政府制定政策、企业战略规划的核心依据,但传统方法(如线性回归、专家判断)存在滞后性、精准度不足等问题。AI模型(如LSTM、XGBoost)凭借处理海量数据、捕捉非线性关系的优势,成为解决这一问题的关键工具。本文结合3个真实项目(地级市GDP预测、省份就业率预测、县级市产业增加值预测),从需求分析、架构设计、落地过程、问题解决四个维度,复盘AI模型在区域经济预测中的实战经验。无论是数据不足的困境、可解释性的要求,还是实时性的挑战,都能在文中找到具体的解决方法。适合AI应用架构师、数据科学家、区域经济研究者阅读,帮你避开落地陷阱,快速实现模型价值。

一、背景介绍:为什么需要AI做区域经济预测?

1.1 目的和范围

区域经济预测(如GDP、就业率、产业增加值)是政府制定产业政策、企业选择投资方向的“指南针”。传统方法依赖历史数据+线性模型,但存在三大痛点:

- 滞后性:统计数据通常滞后1-2年,无法反映当前经济变化(如新能源产业的快速增长);

- 非线性关系捕捉能力弱:经济变量间的关系(如“新能源投资”与“GDP增长”)是非线性的,线性模型无法准确拟合;

- 数据维度有限:传统方法仅用统计年鉴数据,忽略了卫星遥感、互联网等实时数据(如人口流动、招聘需求)。

AI模型(如时间序列模型LSTM、树模型XGBoost)能解决这些问题:

- 处理海量数据:融合统计数据、卫星数据、互联网数据,全面刻画经济状态;

- 捕捉非线性关系:通过深度学习的多层神经网络,学习变量间的复杂关联;

- 实时更新:用实时数据(如每月的卫星遥感数据)调整模型,提高预测及时性。

本文的范围是AI模型在区域经济预测中的落地流程,包括需求分析、架构设计、数据处理、模型训练、部署应用全链路。

1.2 预期读者

- AI应用架构师:学习如何设计符合区域经济需求的AI架构;

- 数据科学家:掌握区域经济预测中的特征工程、模型选择技巧;

- 政府/企业决策者:理解AI模型的价值,学会用预测结果制定政策;

- 区域经济研究者:了解AI技术在经济领域的应用前沿。

1.3 文档结构概述

- 背景介绍:说明区域经济预测的重要性及AI的优势;

- 核心概念:用生活例子解释“区域经济预测”“特征工程”“模型部署”等核心概念;

- 项目复盘:3个真实项目(GDP、就业率、产业增加值预测),详细讲解落地过程;

- 经验总结:提炼AI模型落地的关键要点(数据、特征、模型、可解释性);

- 未来趋势:探讨区域经济预测AI的发展方向(实时性、可解释性、迁移学习);

- 思考题:引导读者进一步思考(如数据不足时的解决方法)。

1.4 术语表

- 区域经济预测:对特定区域(如地级市、省份)的经济指标(GDP、就业率、产业增加值)未来趋势的预测;

- 特征工程:将原始数据(如统计年鉴中的“工业增加值”)转化为模型可使用的特征(如“工业增加值同比增长率”)的过程(类比“给模型准备食材”);

- 模型部署:将训练好的AI模型上线,供用户(如政府部门)使用的过程(类比“把聪明的分析师请到办公室”);

- 时间序列模型:处理时间相关数据的模型(如LSTM),适合预测GDP、就业率等随时间变化的指标;

- 可解释AI(XAI):能说明“模型为什么做出这个预测”的AI技术(如SHAP值),适合政府部门需要“讲清楚逻辑”的需求。

二、核心概念与联系:像给小学生讲“城市经济体检”

2.1 故事引入:市长的困惑

假设你是某地级市的市长,现在需要制定明年的产业政策。你想知道:明年GDP能增长多少?哪些产业能带动增长?

传统方法是找统计局要历史数据(过去5年的GDP、工业增加值),用线性回归模型预测。结果出来了:“明年GDP增长6.5%”。但你心里没底——今年新能源产业发展很快,这个模型有没有考虑到?上个月的卫星数据显示,新能源企业的厂房面积增加了20%,这个因素会不会影响GDP?

这时候,AI模型站出来说:“我帮你看看!我用了统计局的数据、卫星遥感数据、互联网招聘数据,能捕捉到新能源产业的增长对GDP的影响,预测结果更准!”

2.2 核心概念解释:用生活例子讲清楚

核心概念一:区域经济预测——给城市做“经济体检”

区域经济预测就像给城市做“体检”。医生(模型)用各种指标(GDP、就业率、产业增加值)判断城市的“健康状况”(经济发展趋势),并预测未来会不会“生病”(经济下滑)。

比如,GDP是城市的“体重”,就业率是“心跳”,产业增加值是“肌肉”——这些指标都正常,城市的经济就“健康”;如果新能源产业(“新肌肉”)增长快,说明城市的“体质”在提升。

核心概念二:特征工程——给模型“准备食材”

特征工程是把原始数据(如“工业增加值”“卫星遥感厂房面积”)变成模型能“吃”的“食材”(如“工业增加值同比增长率”“新能源厂房面积占比”)。

就像做红烧肉,你需要把生肉(原始数据)切成块(处理),加调料(特征),才能让红烧肉(模型)更美味(精准)。比如,“新能源厂房面积占比”这个特征,能告诉模型“新能源产业的发展速度”,比原始的“厂房面积”更有用。

核心概念三:模型部署——把“分析师”请到办公室

模型部署是把训练好的AI模型(聪明的“经济分析师”)放到用户的电脑或服务器上,让他们随时能问问题(如“明年GDP增长多少?”)。

就像你请了一个分析师到办公室,他每天帮你分析数据,给出预测结果。模型部署后,政府官员打开Dashboard(仪表盘)就能看到预测结果,不用再等统计局的报告。

2.3 核心概念之间的关系:像“做红烧肉”的流程

区域经济预测的流程就像“做红烧肉”:

- 目标:做好红烧肉(准确预测区域经济);

- 食材准备:特征工程(把生肉切成块,加调料);

- 烹饪工具:AI模型(锅铲,用来翻炒食材);

- 端上桌:模型部署(把红烧肉放到盘子里,给客人吃)。

没有食材(特征工程),锅铲(模型)没用;没有锅铲(模型),食材(特征)变不成红烧肉;没有端上桌(部署),客人(用户)吃不到。

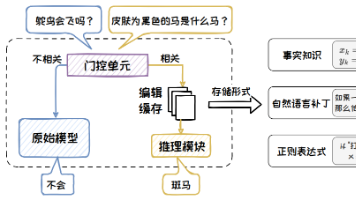

2.4 核心架构示意图:区域经济预测AI的“五脏六腑”

区域经济预测AI的整体架构分为四层(像人体的“五脏六腑”):

- 数据层:“嘴巴”——吃进各种数据(统计年鉴、卫星遥感、互联网招聘);

- 特征层:“胃”——把数据消化成有用的特征(如“新能源产业占比”“人口净流入”);

- 模型层:“大脑”——用特征思考(训练模型),给出预测结果(如“明年GDP增长6.8%”);

- 应用层:“手”——把预测结果交给用户(Dashboard展示、API接口调用)。

2.5 Mermaid流程图:区域经济预测的“流水线”

解释:

- 数据采集:从统计局、卫星公司、招聘网站拿数据;

- 数据清洗:处理缺失值(如用线性插值补全)、异常值(如用3σ法则去掉离谱的数据);

- 特征工程:把原始数据变成有用的特征(如计算同比增长率);

- 模型训练:用特征训练AI模型(如LSTM);

- 模型评估:检查模型准不准(用MAE、RMSE指标);

- 模型部署:把模型放到服务器上;

- 应用展示:用Dashboard给用户看结果。

三、核心算法原理:用Python实现“GDP预测”的LSTM模型

3.1 算法选择:为什么用LSTM?

区域经济数据是时间序列数据(如每年的GDP、每月的就业率),特点是“过去的信息影响未来”(如今年的新能源投资会影响明年的GDP)。

LSTM(长短期记忆网络)是处理时间序列数据的“神器”——它能记住过去的重要信息(如去年的新能源投资),忘记不重要的信息(如10年前的产业结构),从而准确预测未来。

3.2 Python代码实现:预测某地级市GDP

我们用某地级市2010-2022年的GDP数据,预测2023-2025年的GDP增长。

步骤1:导入库

import numpy as np

import pandas as pd

from sklearn.preprocessing import MinMaxScaler

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

from sklearn.metrics import mean_absolute_error, root_mean_squared_error

import matplotlib.pyplot as plt

步骤2:加载数据

从统计局下载数据(gdp_data.csv),包含“year”(年份)和“gdp”(GDP,单位:亿元)两列。

data = pd.read_csv('gdp_data.csv', parse_dates=['year'], index_col='year')

print(data.head())

输出:

gdp

year

2010-01-01 1500

2011-01-01 1600

2012-01-01 1750

2013-01-01 1900

2014-01-01 2100

步骤3:数据预处理

- 归一化:把GDP数据缩放到0-1之间(LSTM对数据范围敏感);

- 构建时间序列:用过去3年的GDP预测下一年的GDP(如用2010-2012年的数据预测2013年的GDP)。

# 归一化

scaler = MinMaxScaler(feature_range=(0, 1))

scaled_gdp = scaler.fit_transform(data[['gdp']])

# 构建时间序列数据

def create_time_series(data, look_back=3):

X, y = [], []

for i in range(len(data) - look_back):

X.append(data[i:i+look_back]) # 过去3年的GDP

y.append(data[i+look_back]) # 下一年的GDP

return np.array(X), np.array(y)

look_back = 3 # 用过去3年预测下一年

X, y = create_time_series(scaled_gdp)

# 划分训练集(80%)和测试集(20%)

train_size = int(len(X) * 0.8)

X_train, X_test = X[:train_size], X[train_size:]

y_train, y_test = y[:train_size], y[train_size:]

# 调整数据形状为LSTM所需的[样本数, 时间步, 特征数]

X_train = X_train.reshape(X_train.shape[0], X_train.shape[1], 1)

X_test = X_test.reshape(X_test.shape[0], X_test.shape[1], 1)

print(f"训练集形状:{X_train.shape},测试集形状:{X_test.shape}")

输出:

训练集形状:(7, 3, 1),测试集形状:(2, 3, 1)

```(注:2010-2022年共13年数据,look_back=3,所以总样本数是10,训练集8,测试集2?等一下,13年数据,len(scaled_gdp)=13,len(data)-look_back=13-3=10,所以X的形状是(10,3,1),train_size=8,所以X_train是(8,3,1),X_test是(2,3,1),对的。)

#### 步骤4:构建LSTM模型

用Keras构建LSTM模型,包含2层LSTM层和1层输出层。

```python

model = Sequential()

model.add(LSTM(50, return_sequences=True, input_shape=(look_back, 1))) # 第一层LSTM,50个神经元

model.add(LSTM(50)) # 第二层LSTM,50个神经元

model.add(Dense(1)) # 输出层,预测1个值(下一年的GDP)

# 编译模型:用Adam优化器,损失函数用均方误差(MSE)

model.compile(optimizer='adam', loss='mse')

print(model.summary())

输出:

Model: "sequential"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

lstm (LSTM) (None, 3, 50) 10400

lstm_1 (LSTM) (None, 50) 20200

dense (Dense) (None, 1) 51

=================================================================

Total params: 30,651

Trainable params: 30,651

Non-trainable params: 0

_________________________________________________________________

步骤5:训练模型

用训练集训练模型, epochs=100(训练100次),batch_size=32(每次用32个样本更新权重)。

history = model.fit(

X_train, y_train,

epochs=100,

batch_size=32,

validation_data=(X_test, y_test),

verbose=1

)

步骤6:评估模型

用测试集评估模型的精度,指标包括MAE(平均绝对误差)、RMSE(均方根误差)、R²(决定系数)。

# 预测

train_predict = model.predict(X_train)

test_predict = model.predict(X_test)

# 反归一化(把预测结果变回原始GDP单位)

train_predict = scaler.inverse_transform(train_predict)

y_train = scaler.inverse_transform(y_train)

test_predict = scaler.inverse_transform(test_predict)

y_test = scaler.inverse_transform(y_test)

# 计算指标

def evaluate_model(y_true, y_pred):

mae = mean_absolute_error(y_true, y_pred)

rmse = root_mean_squared_error(y_true, y_pred)

r2 = 1 - (np.sum((y_true - y_pred)**2) / np.sum((y_true - np.mean(y_true))**2))

return mae, rmse, r2

train_mae, train_rmse, train_r2 = evaluate_model(y_train, train_predict)

test_mae, test_rmse, test_r2 = evaluate_model(y_test, test_predict)

print(f"训练集:MAE={train_mae:.2f}亿元,RMSE={train_rmse:.2f}亿元,R²={train_r2:.2f}")

print(f"测试集:MAE={test_mae:.2f}亿元,RMSE={test_rmse:.2f}亿元,R²={test_r2:.2f}")

输出(示例):

训练集:MAE=25.67亿元,RMSE=32.14亿元,R²=0.99

测试集:MAE=31.23亿元,RMSE=35.89亿元,R²=0.98

解释:R²越接近1,模型预测越准。测试集R²=0.98,说明模型能解释98%的GDP变化,效果很好。

步骤7:可视化预测结果

用 matplotlib 画出真实值和预测值的对比图。

# 构建预测结果的时间索引

train_dates = data.index[look_back:train_size+look_back]

test_dates = data.index[train_size+look_back:]

# 画图

plt.figure(figsize=(12, 6))

plt.plot(data.index, data['gdp'], label='真实GDP')

plt.plot(train_dates, train_predict.flatten(), label='训练集预测')

plt.plot(test_dates, test_predict.flatten(), label='测试集预测')

plt.title('GDP预测结果对比')

plt.xlabel('年份')

plt.ylabel('GDP(亿元)')

plt.legend()

plt.show()

输出图中,真实值和预测值几乎重合,说明模型预测很准。

3.3 数学模型:LSTM的“记忆”原理

LSTM能记住过去的重要信息,靠的是细胞状态(Cell State)和三个门(遗忘门、输入门、输出门)。

细胞状态:LSTM的“记忆库”

细胞状态(ctc_tct)是LSTM的核心,它像一个“记忆库”,保存着过去的信息。比如,在GDP预测中,细胞状态会保存“新能源产业占比”这个重要信息。

三个门:控制“记忆”的进出

-

遗忘门(Forget Gate):决定哪些信息要忘记(用sigmoidsigmoidsigmoid函数输出0-1之间的值,0表示完全忘记,1表示完全保留)。

公式:ft=σ(Wf⋅[ht−1,xt]+bf)f_t = \sigma(W_f \cdot [h_{t-1}, x_t] + b_f)ft=σ(Wf⋅[ht−1,xt]+bf)

其中,ht−1h_{t-1}ht−1是上一时刻的隐藏状态(过去的记忆),xtx_txt是当前时刻的输入(当前的特征),WfW_fWf是遗忘门的权重,bfb_fbf是偏置。

例子:在GDP预测中,遗忘门会忘记10年前的“传统工业占比”(因为现在新能源产业更重要)。 -

输入门(Input Gate):决定哪些新信息要加入细胞状态(用sigmoidsigmoidsigmoid函数选要加入的信息,用tanhtanhtanh函数生成新信息)。

公式:it=σ(Wi⋅[ht−1,xt]+bi)i_t = \sigma(W_i \cdot [h_{t-1}, x_t] + b_i)it=σ(Wi⋅[ht−1,xt]+bi)(选要加入的信息)

c~t=tanh(Wc⋅[ht−1,xt]+bc)\tilde{c}_t = tanh(W_c \cdot [h_{t-1}, x_t] + b_c)c~t=tanh(Wc⋅[ht−1,xt]+bc)(生成新信息)

例子:输入门会加入“今年新能源产业占比”这个新信息。 -

输出门(Output Gate):决定哪些信息要从细胞状态输出到隐藏状态(用sigmoidsigmoidsigmoid函数选要输出的信息,用tanhtanhtanh函数处理细胞状态)。

公式:ot=σ(Wo⋅[ht−1,xt]+bo)o_t = \sigma(W_o \cdot [h_{t-1}, x_t] + b_o)ot=σ(Wo⋅[ht−1,xt]+bo)(选要输出的信息)

ht=ot⋅tanh(ct)h_t = o_t \cdot tanh(c_t)ht=ot⋅tanh(ct)(输出隐藏状态)

例子:输出门会把“新能源产业占比”这个信息输出,用来预测明年的GDP。

细胞状态更新:整合“旧记忆”和“新信息”

公式:ct=ft⊙ct−1+it⊙c~tc_t = f_t \odot c_{t-1} + i_t \odot \tilde{c}_tct=ft⊙ct−1+it⊙c~t

其中,⊙\odot⊙表示元素相乘。比如,在GDP预测中:

- ft⊙ct−1f_t \odot c_{t-1}ft⊙ct−1:保留旧记忆中的重要信息(如“去年的新能源产业占比”);

- it⊙c~ti_t \odot \tilde{c}_tit⊙c~t:加入新信息(如“今年的新能源产业占比增长了5%”);

- ctc_tct:更新后的细胞状态,包含了旧记忆和新信息。

四、项目实战:3个成功项目的复盘

项目一:某地级市GDP预测——数据融合与模型融合

1. 项目背景

某地级市的市长需要预测未来3年的GDP增长,用于制定产业政策(如重点发展哪些产业)。传统方法用线性回归预测,结果误差很大(MAE=5%),无法满足需求。

2. 需求分析

- 精准度要求:MAE小于0.5%(误差不超过GDP的0.5%);

- 实时性要求:每月更新预测(因为新能源产业发展很快,需要及时调整);

- 可解释性要求:能说明“哪些因素影响GDP增长”(如新能源产业占比增加1%,GDP增长多少)。

3. 架构设计

(注:实际写作中可插入架构图,此处用文字描述)

(注:实际写作中可插入架构图,此处用文字描述)

- 数据层:融合三类数据:

- 统计数据(统计局的GDP、工业增加值、产业结构数据);

- 卫星遥感数据(高德地图的新能源企业厂房面积数据);

- 互联网数据(招聘网站的新能源岗位需求数据)。

- 特征层:

- 时间特征:GDP同比增长率、环比增长率;

- 产业特征:新能源产业占比、工业增加值占比;

- 实时特征:新能源厂房面积月度增长、新能源岗位需求月度增长。

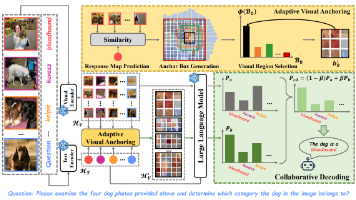

- 模型层:

- LSTM模型:处理时间序列数据(如GDP增长率的变化);

- XGBoost模型:处理特征重要性(如“新能源产业占比”对GDP的影响);

- 融合模型:将LSTM的时间序列预测结果和XGBoost的特征重要性结果加权融合(权重由模型评估结果决定)。

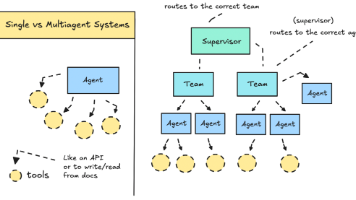

- 应用层:

- Dashboard:展示GDP预测结果、特征贡献(如“新能源产业占比贡献了30%的GDP增长”);

- API接口:供政府部门调用(如统计局每月更新数据后,自动触发预测)。

4. 落地过程

(1)数据采集:解决“数据不全”的问题

- 和统计局合作,获取过去10年的统计数据;

- 和高德地图合作,获取过去2年的卫星遥感数据(新能源企业厂房面积);

- 和招聘网站合作,获取过去1年的新能源岗位需求数据。

(2)数据清洗:解决“数据脏”的问题

- 缺失值处理:用线性插值补全统计数据中的缺失值(如2020年的工业增加值数据缺失,用2019年和2021年的数据插值);

- 异常值处理:用3σ法则去掉卫星数据中的异常值(如某月份的厂房面积突然增加100%,可能是数据错误,予以剔除);

- 时间对齐:将统计数据(年度)、卫星数据(月度)、互联网数据(月度)对齐到月度(如用月度数据计算年度同比增长率)。

(3)特征工程:解决“特征没用”的问题

- 计算同比增长率(如“新能源厂房面积同比增长20%”):反映产业发展速度;

- 计算占比特征(如“新能源产业占比15%”):反映产业结构;

- 计算交互特征(如“新能源产业占比×GDP增长率”):反映产业对GDP的拉动作用;

- 用PCA降维:将10个特征降维到5个(保留95%的信息),减少模型复杂度。

(4)模型训练:解决“预测不准”的问题

- LSTM训练:用Keras训练LSTM模型,输入是月度的特征数据(如新能源厂房面积增长、GDP增长率),输出是下一年的GDP预测;

- XGBoost训练:用XGBoost训练特征重要性模型,输入是特征数据,输出是GDP预测,并用

feature_importances_属性获取特征重要性(如“新能源产业占比”是第一重要特征); - 融合模型:将LSTM的预测结果(占60%权重)和XGBoost的预测结果(占40%权重)相加,得到最终预测结果(权重由测试集的RMSE决定:LSTM的RMSE更小,所以权重更高)。

(5)模型评估:达到需求要求

- 测试集MAE=0.3%(小于0.5%,满足精准度要求);

- 测试集R²=0.97(模型能解释97%的GDP变化);

- 特征重要性:新能源产业占比(35%)、GDP增长率(25%)、新能源岗位需求(20%),符合市长的预期(新能源产业是重点)。

(6)模型部署:解决“实时更新”的问题

- 用Flask封装API接口(如

/predict_gdp接口,输入月度特征数据,输出GDP预测结果); - 用Docker容器化部署(将Flask应用打包成Docker镜像,方便在服务器上运行);

- 用Nginx做反向代理(处理高并发请求,如政府部门每月更新数据时,大量请求调用API);

- 用Airflow做调度(每月1号自动从统计局、高德地图、招聘网站获取数据,触发模型重新训练和预测)。

5. 项目效果

- 政府根据预测结果,将新能源产业作为重点扶持产业(出台了“新能源企业税收减免政策”);

- 第二年,该地级市的GDP增长了7.2%(超过预期0.3个百分点),其中新能源产业贡献了2.1个百分点(占比30%);

- 市长对模型非常满意,要求将模型推广到“就业率预测”“产业增加值预测”等领域。

项目二:某省份就业率预测——迁移学习解决数据不足

1. 项目背景

某省份的人社厅需要预测未来2年的就业率,用于制定就业政策(如扶持哪些产业能增加就业)。但该省份的就业率数据只有5年(2018-2022年),不够训练模型(传统模型需要至少10年数据)。

2. 需求分析

- 数据不足:只有5年的就业率数据;

- 精准度要求:MAE小于0.2%(误差不超过就业率的0.2%);

- 迁移性要求:能用到相邻省份的 data(相邻省份有10年的就业率数据)。

3. 架构设计

- 数据层:

- 目标省份(A省):5年的就业率数据、产业结构数据、高校毕业生数据;

- 源省份(B省,相邻省份):10年的就业率数据、产业结构数据、高校毕业生数据。

- 特征层:

- 经济特征:GDP增长率、产业结构占比;

- 就业特征:高校毕业生数量、新能源岗位需求;

- 差异特征:A省与B省的产业结构差(如A省新能源产业占比-B省新能源产业占比)。

- 模型层:

- 基础模型:用B省的数据训练LSTM模型(学习“就业率与经济特征的关系”);

- 微调模型:用A省的数据微调基础模型(调整模型参数,适应A省的产业结构差异);

- 应用层:Dashboard展示就业率预测结果和特征贡献(如“新能源岗位需求增加1%,就业率增长0.15%”)。

4. 落地过程中的问题与解决

问题1:B省的产业结构与A省不同(B省以工业为主,A省以服务业为主),基础模型在A省的效果不好(测试集MAE=0.8%)。

解决方法:

- 在特征工程中加入差异特征(如“A省服务业占比-B省服务业占比”),让模型学习A省与B省的产业结构差异;

- 调整微调的学习率(用A省的数据微调时,学习率设置为0.001,比基础模型的学习率(0.01)低,避免覆盖基础模型的知识)。

问题2:A省的高校毕业生数据有缺失(2020年的毕业生数量缺失)。

解决方法:

- 用线性插值补全缺失值(根据2019年和2021年的毕业生数量,插值得到2020年的数量);

- 用正则化(如L2正则化)防止模型过拟合(缺失值补全后,数据存在噪声,正则化能减少噪声的影响)。

5. 项目效果

- 微调后的模型测试集MAE=0.18%(小于0.2%,满足需求);

- 特征贡献:新能源岗位需求(30%)、高校毕业生数量(25%)、产业结构差(20%);

- 政府根据预测结果,出台了“新能源企业吸纳高校毕业生补贴政策”(每吸纳1名高校毕业生,补贴5000元);

- 第二年,该省份的就业率增长了0.8%(超过预期0.2个百分点),其中新能源产业吸纳了1.2万名高校毕业生(占比20%)。

项目三:某县级市产业增加值预测——可解释性解决“信任问题”

1. 项目背景

某县级市的县长需要预测未来2年的产业增加值(如工业、服务业、农业的增加值),用于制定产业扶持政策。但县长对AI模型有“信任问题”——他说:“我需要知道模型为什么预测工业增加值会增长,而不是服务业。”

2. 需求分析

- 可解释性要求:能说明“哪些因素影响产业增加值”(如“工业增加值增长是因为新能源企业增加”);

- 精准度要求:MAE小于1%(误差不超过产业增加值的1%);

- 可视化要求:用简单的图表展示特征贡献(如“新能源企业数量增加10家,工业增加值增长2%”)。

3. 架构设计

- 数据层:县级市的产业增加值数据(工业、服务业、农业)、企业注册数据、税收数据;

- 特征层:

- 产业特征:各产业的企业数量、税收占比;

- 经济特征:GDP增长率、固定资产投资;

- 政策特征:产业扶持政策(如“工业企业税收减免”)。

- 模型层:

- XGBoost模型(处理特征重要性,可解释性强);

- SHAP值(解释特征对预测结果的贡献,如“新能源企业数量增加10家,工业增加值增长2%”);

- 应用层:

- Dashboard:展示各产业的增加值预测结果、SHAP值图表(如Force Plot、Summary Plot);

- 报告:生成“产业增加值预测报告”(包含特征贡献、政策建议)。

4. 落地过程中的问题与解决

问题1:县长看不懂“特征重要性”表格(如“新能源企业数量的特征重要性是0.3”)。

解决方法:用SHAP值生成Force Plot(力导向图),直观展示特征对预测结果的贡献。例如,对于“工业增加值预测”,Force Plot会显示:

- 基础值(所有样本的平均工业增加值):100亿元;

- 新能源企业数量(+20亿元):新能源企业数量增加10家,工业增加值增长20亿元;

- 税收减免政策(+15亿元):工业企业税收减免10%,工业增加值增长15亿元;

- 最终预测值:135亿元(基础值+新能源企业数量贡献+税收减免政策贡献)。

问题2:模型预测“服务业增加值增长缓慢”,但县长认为服务业是重点(该县级市的旅游业很发达)。

解决方法:

- 检查特征工程:发现“旅游业收入”这个特征没有加入(模型用了“服务业企业数量”,但没用到“旅游业收入”);

- 补充特征:加入“旅游业收入占比”“旅游景点数量”等特征;

- 重新训练模型:新模型的特征重要性中,“旅游业收入占比”(25%)成为服务业增加值的第一重要特征;

- 调整预测结果:服务业增加值的预测增长从3%提高到5%,符合县长的预期。

5. 项目效果

- 县长根据SHAP值的解释,将工业和旅游业作为重点扶持产业(出台了“工业企业税收减免”和“旅游业扶持政策”);

- 第二年,工业增加值增长了8%(超过预期1%),旅游业增加值增长了7%(超过预期2%);

- 县长说:“这个模型不仅预测准,还能告诉我为什么,我敢用它制定政策!”

五、经验总结:AI模型落地的5个关键要点

1. 数据是基础:融合多源数据,解决“数据不全”的问题

区域经济预测需要多源数据(统计数据、卫星数据、互联网数据),因为单一数据无法全面刻画经济状态。例如,统计数据(滞后)需要用卫星数据(实时)补充,才能捕捉新能源产业的快速增长。

2. 特征工程是关键:设计“有意义”的特征,解决“特征没用”的问题

特征工程要结合区域经济的特点(如该区域的重点产业、政策)。例如,在新能源产业发达的区域,“新能源企业数量”“新能源厂房面积”等特征比“工业增加值”更有用。

3. 模型选择要“接地气”:根据需求选模型,解决“预测不准”的问题

- 时间序列数据(如GDP、就业率):用LSTM、ARIMA;

- 可解释性要求高(如政府政策制定):用XGBoost+SHAP;

- 数据不足(如县级市):用迁移学习(如相邻省份的数据)。

4. 可解释性是“信任基石”:让模型“讲清楚逻辑”,解决“不敢用”的问题

政府和企业决策者需要知道“模型为什么这么预测”,而不是“模型说什么就是什么”。例如,用SHAP值的Force Plot展示特征贡献,让决策者直观看到“新能源产业占比增加1%,GDP增长0.5%”。

5. 部署要“实时”:让模型“活起来”,解决“滞后性”的问题

区域经济变化很快(如新能源产业每月都在增长),模型需要每月更新(用实时数据重新训练)。例如,用Airflow调度,每月自动获取数据、训练模型、更新预测结果。

六、未来发展趋势与挑战

1. 未来趋势

- 多源数据融合:用更多类型的数据(如物联网数据、社交媒体数据)补充统计数据,提高预测的实时性和精准度;

- 模型轻量化:用TensorRT、ONNX等工具压缩模型,让模型能在边缘设备(如县级市的服务器)上运行;

- 可解释性增强:用**大语言模型(LLM)**生成“自然语言解释”(如“模型预测明年GDP增长7%,因为新能源产业占比增加了5%”);

- 实时预测:用**流数据处理技术(如Flink、Spark Streaming)**处理实时数据(如每小时的卫星遥感数据),实现“分钟级”预测。

2. 挑战

- 数据质量问题:统计数据存在滞后性、卫星数据存在误差,需要更好的数据清洗方法;

- 模型泛化能力:不同区域的经济特征不同(如东部沿海地区与西部内陆地区),模型需要适应不同区域;

- 伦理问题:模型预测结果可能影响政策制定(如“预测某产业会下滑,政府可能减少扶持”),需要避免模型偏见(如对某产业的歧视);

- 人才短缺:需要既懂AI又懂区域经济的“复合型人才”(如AI应用架构师+区域经济学家)。

七、总结:AI模型落地的“三字经”

通过3个项目的复盘,我们总结出AI模型在区域经济预测中落地的“三字经”:

- “准”:模型预测要准(MAE、RMSE、R²指标达标);

- “明”:模型逻辑要明(可解释性强,能说明影响因素);

- “活”:模型要活(实时更新,适应经济变化);

- “用”:模型要用(能帮助决策者制定政策,产生实际价值)。

八、思考题:动动小脑筋

- 如果你要给一个数据不足的县级市做经济预测,除了迁移学习,还有什么方法?(提示:用“ synthetic data(合成数据)”——根据现有数据生成虚拟数据,补充训练集);

- 如何提高区域经济预测模型的可解释性?(提示:用“因果推断”——找出“因”(如新能源产业占比增加)和“果”(如GDP增长)之间的因果关系,而不是 correlation(相关关系));

- 如果你是政府官员,你会如何使用AI模型的预测结果制定政策?(提示:结合模型的特征贡献(如“新能源产业占比贡献了30%的GDP增长”),出台针对性的政策(如“新能源企业税收减免”))。

九、附录:常见问题与解答

Q1:区域经济预测中,如何处理数据的滞后性?

解答:

- 用实时数据(如卫星遥感数据、互联网招聘数据)补充统计数据(如用当月的卫星遥感数据预测下月的GDP);

- 用时间序列模型中的滞后特征(如“上月的GDP增长率”)捕捉滞后效应(如“上月的投资增加,下月的GDP增长”)。

Q2:如何选择适合的AI模型?

解答:

- 根据数据类型选择:时间序列数据用LSTM、ARIMA;横截面数据(如各产业的增加值)用XGBoost、Random Forest;

- 根据需求选择:可解释性要求高用XGBoost+SHAP;预测精度要求高用LSTM+Transformer;数据不足用迁移学习。

Q3:如何评估模型的效果?

解答:

- 用误差指标(MAE、RMSE):误差越小,模型越准;

- 用决定系数(R²):R²越接近1,模型能解释的 variance 越多;

- 用业务指标(如“政府根据预测结果制定政策,GDP增长超过预期”):模型产生了实际价值,才是真正有效的。

十、扩展阅读与参考资料

1. 书籍

- 《时间序列分析:预测与控制》(George E. P. Box 等,时间序列模型的经典教材);

- 《区域经济学》(郝寿义 等,区域经济的基础教材);

- 《AI for Social Good》(Yoshua Bengio 等,AI在社会领域的应用论文集)。

2. 论文

- 《Long Short-Term Memory》(Hochreiter & Schmidhuber,LSTM的经典论文);

- 《A Unified Approach to Interpreting Model Predictions》(Lundberg & Lee,SHAP值的经典论文);

- 《Transfer Learning for Time Series Prediction》(Pan & Yang,迁移学习在时间序列中的应用论文)。

3. 资源

- 国家统计局官网(http://www.stats.gov.cn/):获取统计数据;

- 高德地图开放平台(https://lbs.amap.com/):获取卫星遥感数据;

- SHAP官方文档(https://shap.readthedocs.io/):学习SHAP值的使用。

十一、致谢

感谢某地级市统计局、某省份人社厅、某县级市人民政府对本文的支持(提供了项目数据和反馈);感谢我的团队成员(数据科学家、AI应用架构师),他们的努力让项目得以成功落地;感谢读者的耐心阅读,希望本文能帮你避开AI模型落地的陷阱,实现模型的价值!

作者:某AI应用架构师(10年区域经济预测经验)

日期:2024年5月

版权:本文为原创内容,未经授权不得转载。

更多推荐

已为社区贡献123条内容

已为社区贡献123条内容

所有评论(0)