大模型LLM | 一文详解上下文工程(context engineering)_大模型上下文工程

上下文工程致力于构建灵活可变的系统,通过精准匹配信息格式,为大语言模型(LLM)供给有效的信息与工具资源,从而助力其顺利达成任务目标。上下文工程可视为一套完整的系统解决方案。随着智能体应用场景日趋复杂,其上下文信息来源愈发多元,既包含开发者构建的基础框架、用户动态输入,也涵盖历史交互痕迹、工具运行结果及第三方数据等。若想实现这些信息的有序整合与高效利用,必然需要一套复杂且专业的系统支撑。上下文工程

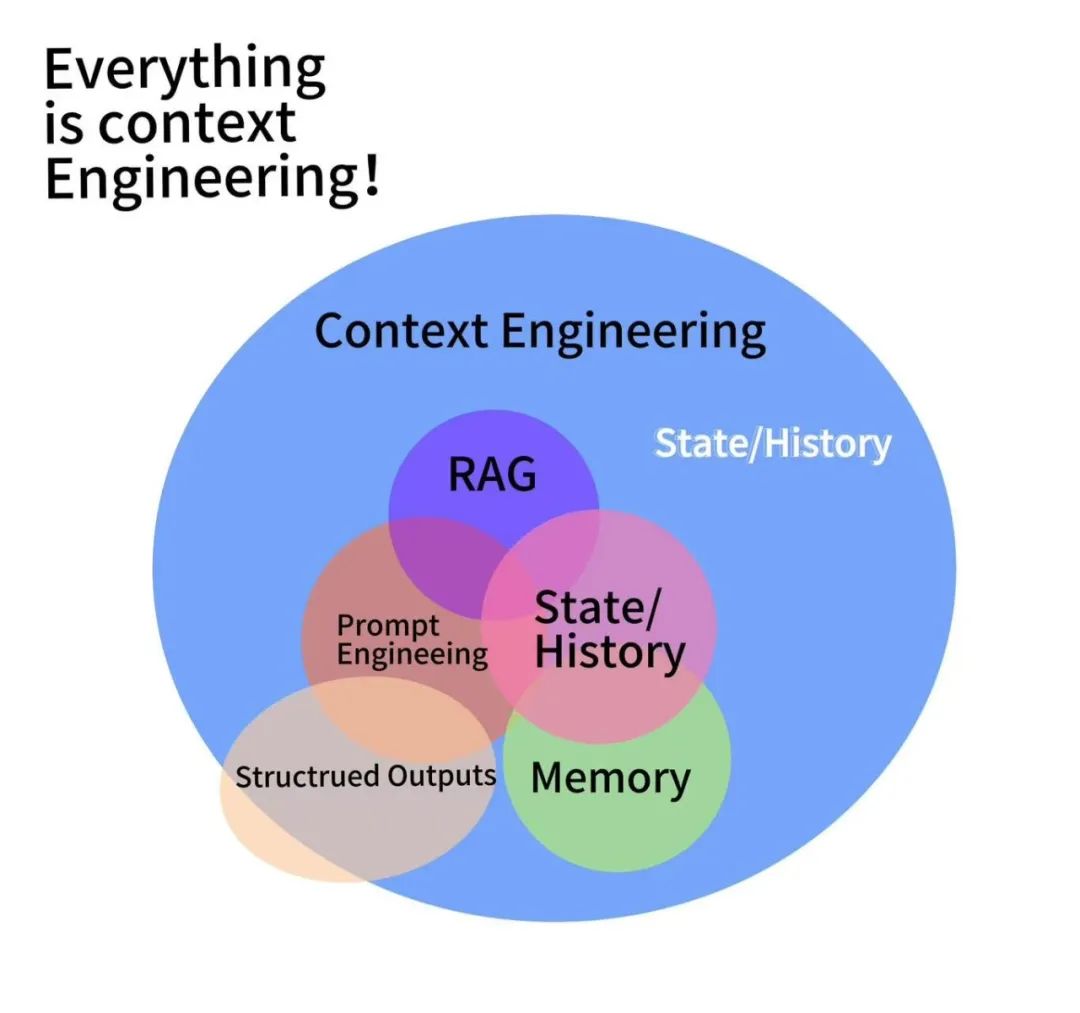

身处AI浪潮之中,提示词工程、RAG、记忆这些术语或许已不陌生,但上下文工程(context engineering)这一领域却尚未引起广泛关注。 上下文工程(context engineering)这一领域却尚未引起广泛关注。

事实上,上下文工程并非新兴概念,近两年来众多智能体开发者始终对其保持密切关注。至于它与提示词工程、RAG等技术的关联及重要性,可通过以下图表一目了然地呈现。

在传统提示工程里,开发者往往聚焦于精心雕琢提示语,盼着借此获取更优答案。但随应用复杂度持续攀升,单纯依靠提示难以适配现代智能体需求的问题,渐渐凸显出来。到如今 为智能体提供完整、结构化的上下文信息,其重要性已远超那些精巧设计的提示词 。

一言以蔽之,上下文工程就是为满足上述需求才出现的。

简单来说,上下文工程就是构建动态系统,把合适的信息和工具,按正确格式提供给LLM,使LLM可以合理完成任务 。

多数情形下,智能体执行任务不尽人意,核心缘由是没把恰当的上下文、指令和工具传递给模型。LLM 应用正从单纯的提示,过渡到更复杂、动态的智能系统形态 。

基于以上原因,上下文工程已成为AI工程师提升专业能力的重点发展方向。

上下文工程的具体定义是什么?

上下文工程致力于构建灵活可变的系统,通过精准匹配信息格式,为大语言模型(LLM)供给有效的信息与工具资源,从而助力其顺利达成任务目标。

上下文工程可视为一套完整的系统解决方案。随着智能体应用场景日趋复杂,其上下文信息来源愈发多元,既包含开发者构建的基础框架、用户动态输入,也涵盖历史交互痕迹、工具运行结果及第三方数据等。若想实现这些信息的有序整合与高效利用,必然需要一套复杂且专业的系统支撑。

上下文工程具有动态特性。由于大量上下文信息处于持续变化、实时生成的状态,因此在构建最终提示时,不能依赖固定的静态模板,而需要采用动态化的逻辑来应对。

准确信息的提供至关重要。智能体系统运行效果差,最常见的症结就在于缺失正确的上下文。大语言模型(LLM)无法洞悉人类思维,所以必须向其明确传递精准信息。毕竟在信息处理中,输入质量直接决定输出结果,低质量的输入只能换来毫无价值的反馈。

合理的工具支持是必要条件。由于LLM无法单纯依靠输入数据解决全部问题,在这些超出其原生能力范围的任务场景下,若想充分发挥LLM的效能,就需要为其配备适用的工具。无论是用于信息获取、任务执行,还是其他中间环节的辅助,这些工具都至关重要。可以说,在优化LLM任务处理能力方面,工具配备与信息供给同样关键。

规范的格式是交互基础。和人际沟通需注意表达逻辑类似,与LLM进行交互时,信息传递格式至关重要。特别是在LLM调用工具的过程中,规范设置工具的输入参数,是保障工具正常运作的必要条件。

上下文工程重要性工程在哪里?

在智能体系统运行失效的场景中,LLM通常是问题的关键所在。基于第一性原理进行深度拆解,LLM的错误可归因于两个核心因素:

一方面底层模型自身有漏洞,另一方面是模型能力不足以支撑任务。

底层模型在上下文传递环节出现缺失或偏差,使得最终输出无法达到预期的正确性。

伴随技术的不断精进,更多时候(特别是当模型变得更为强大时),模型错误多由第二个原因引发。致使模型性能降低的上下文传递问题,一般由以下因素导致:

上下文的缺失意味着模型未能接收到做出正确判断所需的完整信息。毕竟模型无法洞悉人类思维,若缺乏正确的上下文输入,它根本无法感知相关信息。

若上下文格式不正确,就会影响模型表现。这和人类沟通同理,表达形式会决定交流效果——数据传递给模型时,其格式精准度直接关系到模型的输出结果。

下文工程和提示工程不同点具体是什么?

为什么要推动从提示工程到上下文工程的变革?在智能模型发展的早期阶段,开发者往往将重心放在设计巧妙的提示词上,试图借此优化模型输出。但随着应用场景的复杂化,如今愈发明确:唯有提供完整、结构化的上下文信息,才能满足复杂任务需求,这远比精巧的提示措辞更具价值。

提示工程本质上是上下文工程的一个分支。即使手头有完整的上下文信息,如何将其组合成有效的提示仍是关键。二者的本质区别在于,提示工程聚焦于单个输入数据的优化,而上下文工程则需要管理动态数据集,并进行正确的格式处理 。

上下文的重要内容之一,便是指导LLM具体表现的核心指令。实际上,这一要素在提示工程中也发挥着关键作用。

优质的上下文工程应当涵盖:

-

关于工具的应用:智能体在检索外部信息时,需要依赖特定工具实现数据获取;而工具反馈的信息,必须经过格式调整,确保LLM能够准确理解并处理。

-

短期记忆管理:在长时间对话过程中创 建对话内容的精简摘要,便在后续交互中调用 。

-

关于长期记忆:一旦用户在之前的交流中表明过喜好倾向,就应当提取并利用这些数据。

-

提示工程设计:在生成提示信息时,要将智能体的操作要求进行清晰、完整的表述。

-

信息检索:通过动态方式获取相关数据,并在激活LLM前将信息补充到提示语句内。

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

2025最新版CSDN大礼包:《AGI大模型学习资源包》免费分享**

一、2025最新大模型学习路线

一个明确的学习路线可以帮助新人了解从哪里开始,按照什么顺序学习,以及需要掌握哪些知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1级别:AI大模型时代的华丽登场

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理,关键技术,以及大模型应用场景;通过理论原理结合多个项目实战,从提示工程基础到提示工程进阶,掌握Prompt提示工程。

L2级别:AI大模型RAG应用开发工程

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3级别:大模型Agent应用架构进阶实践

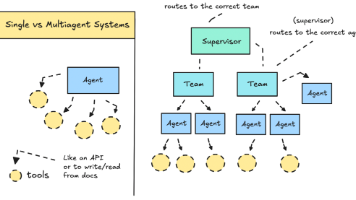

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体;同时还可以学习到包括Coze、Dify在内的可视化工具的使用。

L4级别:大模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调;并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

整个大模型学习路线L1主要是对大模型的理论基础、生态以及提示词他的一个学习掌握;而L3 L4更多的是通过项目实战来掌握大模型的应用开发,针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

二、大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

三、大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

四、大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

五、大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

更多推荐

已为社区贡献170条内容

已为社区贡献170条内容

所有评论(0)