CVPR生成革命,从模糊指令到像素级掌控,三篇论文让AI图像“指哪打哪”

今天,为大家推荐一个高性价比、高回报的研究方向:图像生成。

作为计算机视觉与人工智能交叉领域的核心议题,该方向持续推动着高质量、高真实感图像内容的创建与合成,其技术演进不仅反映在顶级会议中论文数量的显著增长,更体现于图像修复、风格迁移和跨模态生成等前沿任务中的突破。图像生成技术不仅能够支持创意视觉内容的自动化构建,还因其强大的泛化能力而在娱乐、教育、电子商务和工业设计等广泛领域中展现出巨大的应用潜力与适应性。

今天小图给大家精选3篇CVPR有关图像生成方向的论文,请注意查收!

OmniGen: Unified Image Generation

方法:

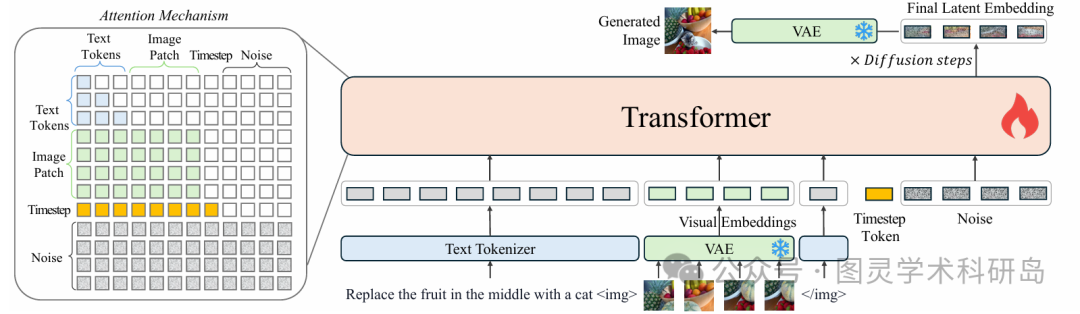

OmniGen采用一个由冻结的变分自编码器(VAE)和一个预训练的Transformer模型组成的精简架构,其中VAE负责将图像转换为连续的视觉特征,Transformer则根据指令生成图像。为了训练这个统一模型,作者构建了首个大规模、多任务的统一图像生成数据集X2I,将所有任务都标准化为统一的文本与图像交错序列格式,使其能够通过单一模型完成多样的输入-输出配对任务。在训练过程中,模型使用Rectified Flow方法进行优化,并通过对图像编辑任务中改动区域的损失进行加权,以缓解模型简单复制输入图像的“捷径”问题,从而确保其专注于实际的修改任务。

创新点:

-

统一多任务框架:OmniGen是首个能够在一个统一架构中端到端处理多模态指令和各种图像生成任务的通用模型,无需额外的插件或复杂的中间步骤。

-

简洁高效的架构设计:该模型采用简洁的VAE与Transformer架构,摒弃了传统扩散模型所需的额外编码器,显著简化了流程并提高了参数利用效率。

-

跨任务知识迁移能力:通过在统一格式的多任务数据集上训练,OmniGen能够有效地在不同任务间迁移知识,甚至处理未曾见过的任务和领域。

论文链接:

https://arxiv.org/pdf/2409.11340v2

EmoGen: Emotional Image Content Generation with Text-to-Image Diffusion Models

方法:

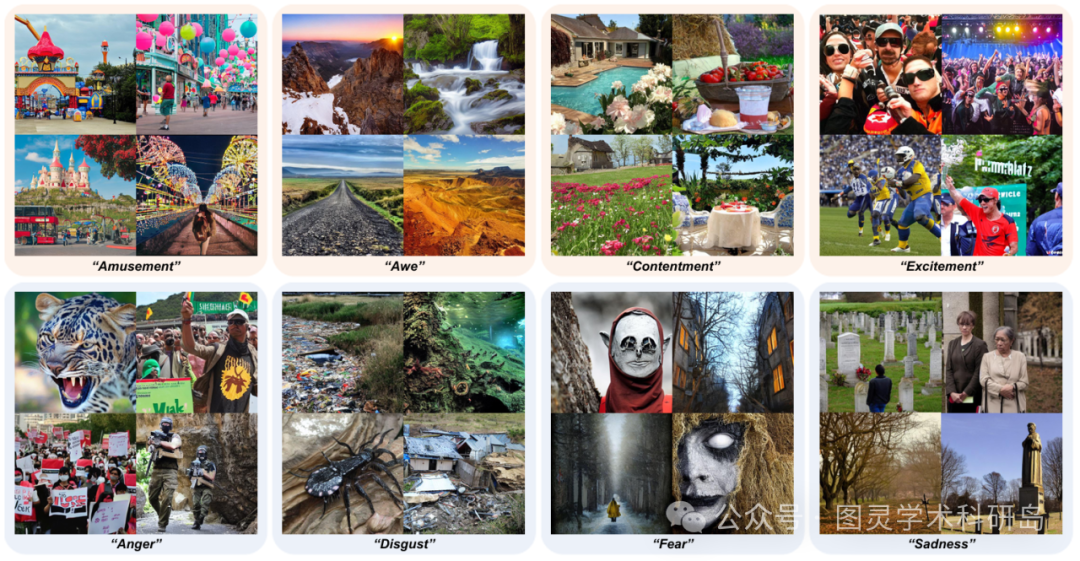

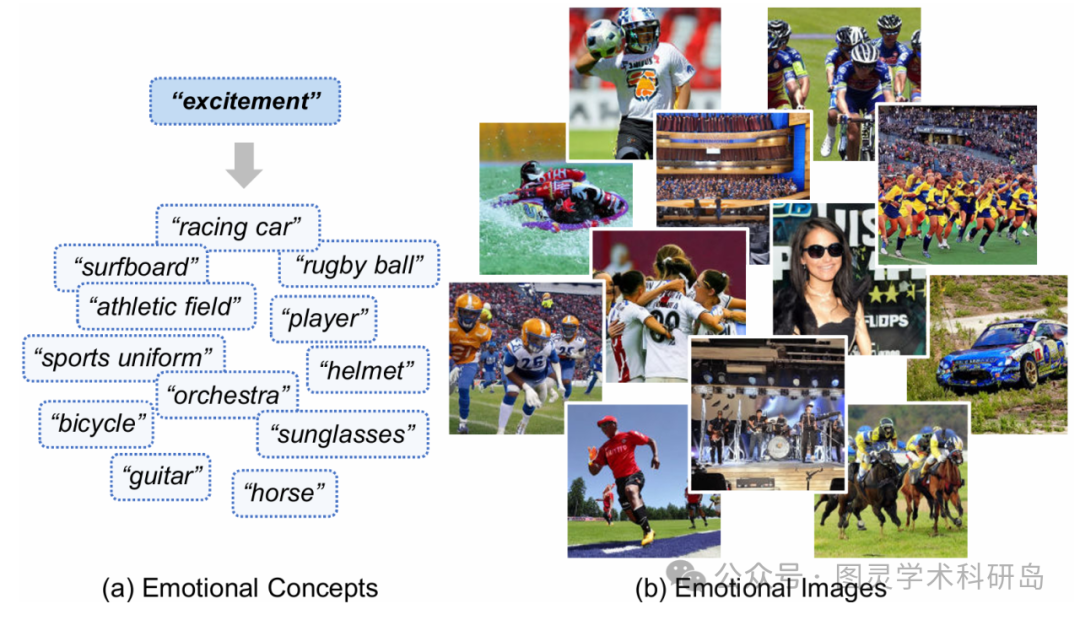

这篇文章首次提出了一个全新的挑战性任务:情感图像内容生成(EICG),旨在解决现有文生图扩散模型难以生成抽象情感概念的痛点,通过将情感类别作为输入,生成语义清晰、情感忠实且内容丰富的图像,这不仅是对传统图像情感转移方法的重大突破,更是为机器理解和创造情感艺术开辟了新路径,让图像创作不再局限于具体事物,而是触及人内心深处的情感共鸣。

创新点:

-

本文提出了情感图像内容生成(EICG)这一新颖任务,并为此设计了情感准确度、语义清晰度和语义多样性三项定制化评估指标。

-

为了具象化抽象情感,作者构建了一个独立的情感空间,并设计映射网络将其与强大的CLIP空间对齐。

-

通过引入属性损失和情感置信度,确保了生成图像既能包含丰富的语义内容,又能精准传达目标情感。

论文链接:

https://arxiv.org/abs/2401.04608

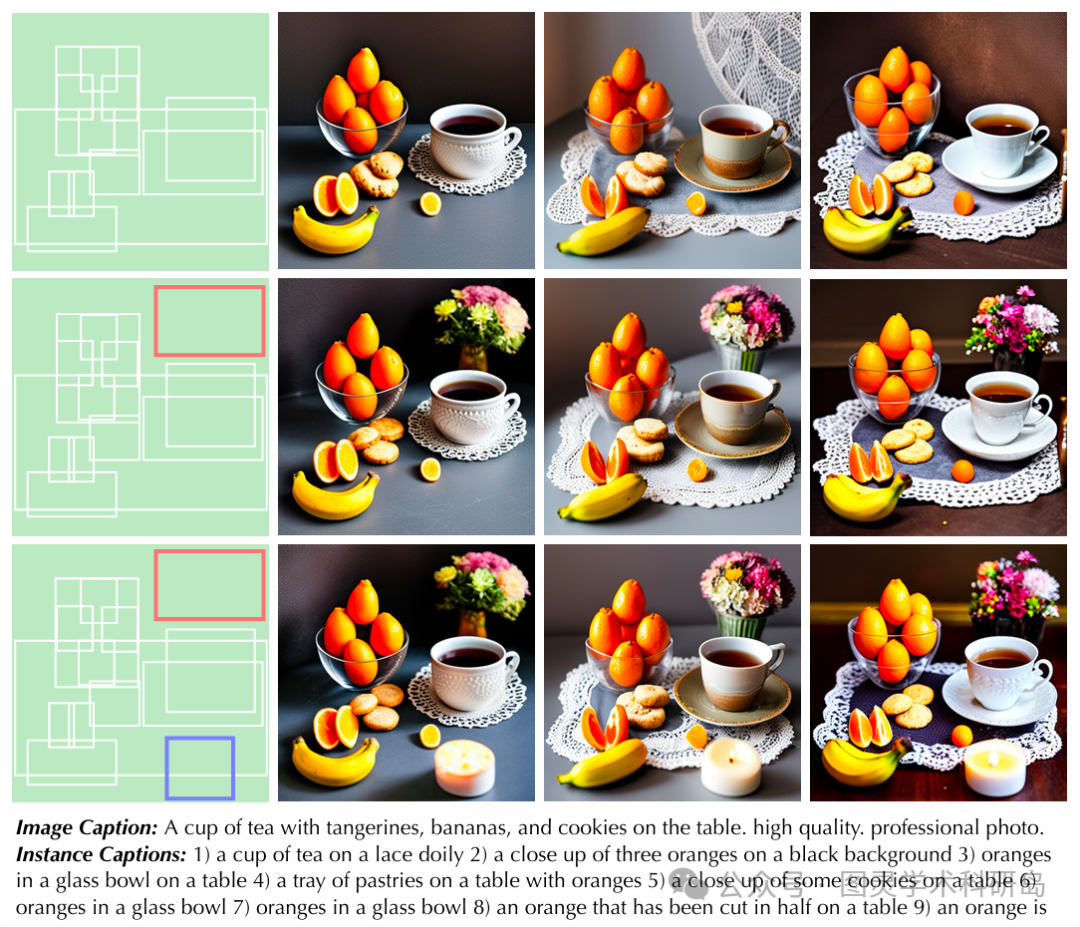

InstanceDiffusion: Instance-Level Control for Image Generation

方法:

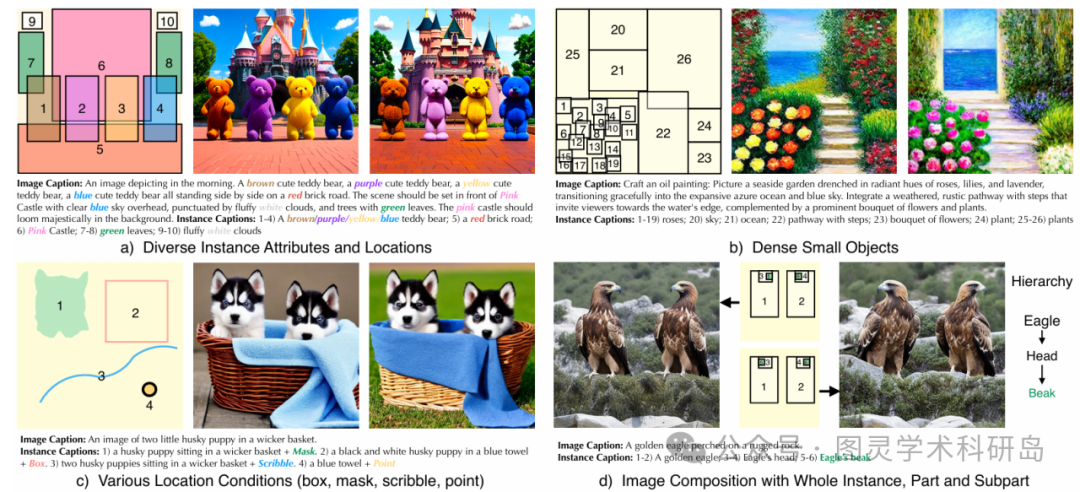

该方法在预训练的文生图UNet模型基础上,添加了可学习的UniFusion和ScaleU模块来处理额外的实例级条件。UniFusion将实例描述和各种位置信息(被统一参数化为2D点集)转换为令牌并进行融合,而ScaleU则通过动态调整UNet跳跃连接和主干特征图来提高对布局的遵守程度。在推理时,可选用的多实例采样器会为每个实例独立运行去噪操作,并将结果与全局潜在变量融合,最终生成高质量的图像。

创新点:

-

UniFusion模块:该模块能将多种形式的实例级条件(文本和位置)投射到同一特征空间,并无缝地融合到图像的视觉令牌中。

-

ScaleU模块:通过可学习的通道级向量动态校准模型特征,显著增强了模型对指定布局条件的精确遵循能力。

-

多实例采样器:这是一种在推理阶段使用的策略,能有效减少多实例条件之间的信息泄露和混淆,提升生成图像的质量和保真度。

论文链接:

https://arxiv.org/pdf/2402.03290

更多推荐

已为社区贡献22条内容

已为社区贡献22条内容

所有评论(0)