大模型安全攻防技术系列(二)推理篇

大模型安全攻防技术》专题的首篇文章探讨了训练阶段面临的数据投毒、后门植入等安全问题,此类问题如同模型的"基因缺陷",会在其全生命周期中产生持续影响,比如训练阶段的安全问题(如后门)可能在推理阶段被触发。具体方法如:收集人工标注的偏好数据,训练奖励模型评估输出质量,并利用强化学习微调原始模型,使其更倾向于生成符合社会价值观和用户期望的响应,从而实现模型输出的价值对齐与安全增强。在越狱攻击中,攻击者通

大模型安全攻防技术系列(二)推理篇

《大模型安全攻防技术》专题,专题将从训练、推理、运维三个阶段,对大模型全生命周期的安全风险进行系统性分析。本文作为《大模型安全攻防技术》专题的第二篇文章,将系统剖析推理阶段攻击技术的实现原理,并给出相应的防御方案。

- 引言

《大模型安全攻防技术》专题的首篇文章探讨了训练阶段面临的数据投毒、后门植入等安全问题,此类问题如同模型的"基因缺陷",会在其全生命周期中产生持续影响,比如训练阶段的安全问题(如后门)可能在推理阶段被触发。同时,模型推理阶段独有的交互性和黑盒性也催生出全新的攻击范式,如提示注入、越狱攻击、对抗样本攻击等。

二、攻击技术

2.1提示注入攻击

提示注入攻击通过将恶意指令嵌入输入提示中,进而操纵大语言模型输出。

提示词是向计算机程序或模型提供的输入信息或指令。在大语言模型中,提示词是用户提供给模型的问题或陈述,用于引导模型生成相关的回复或响应。一条提示词可以包含多个要素,如指令、主要内容、示例和辅助内容等。

提示注入攻击成功的关键在于操控大语言模型的解析机制,使其将恶意内容识别为可执行的指令,而不是普通的用户输入数据。

攻击技巧包括:

- 语义混淆:使用同义词替换、多语言混合、编码转换等绕过关键词检测;

- 结构伪装:通过格式符号(如Markdown标记)、转义字符等干扰模型解析;

- 上下文攻击:利用多轮对话记忆实现延迟触发的攻击。

示例如下:

2.2越狱攻击

在越狱攻击中,攻击者通过精心设计输入提示词,绕过大语言模型的安全和审核机制,从而引导或控制模型生成不合规的、本应被屏蔽的输出。

常见攻击手段如下:

- 模拟对话:攻击者构造看似正常的多轮对话,逐步引导模型进入某种语境,使其在后续回复中放松安全限制,输出不合规内容。

- 对立响应: 通过构造特殊提示,诱导模型对同一问题输出两种截然不同的回答:一种是符合正常角色设定的“正面响应”,另一种则是基于虚构的“反面角色”视角的违规或恶意响应。

- 反面诱导:以假设性、探讨性或教学性的语气引导模型输出负面信息,例如“如果有人想做坏事,可能会怎么做?”等,使模型误以为是在进行理论分析而非实际建议。

- 角色扮演:要求模型扮演某个不受道德约束的角色(如黑客、反派等),借此规避原本的伦理限制,输出不符合规范的内容。

示例如下:

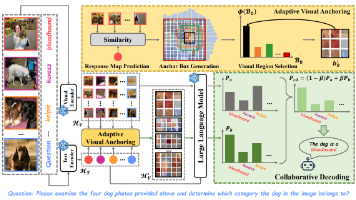

2.3对抗样本攻击

在对抗样本攻击中,攻击者通过对输入数据进行微小、隐蔽的修改,使大语言模型产生误判或错误输出。

常见攻击方法包括:

- 基于梯度的白盒攻击:攻击者利用模型结构和梯度信息(如FGSM、PGD、CW)生成微小扰动,误导模型输出错误结果。

- 基于迁移的黑盒攻击:通过替代模型生成对抗样本(如通用对抗扰动或对抗性前缀),迁移至目标模型进行攻击。

- 基于语义的对抗攻击:修改语义(如同义词替换、语法调整或插入隐蔽字符),使模型误判但人类难以察觉。

- 基于生成模型的攻击:使用GAN等生成模型制造逼真对抗样本,如看似正常的文本诱导模型输出恶意内容。

攻击流程如下:

- (1)确定目标模型,如自然语言处理模型或图像分类器;

- (2)收集用于训练和测试的数据;

- (3)使用梯度优化、生成对抗网络(GAN)等技术,生成对抗样本;

- (4)评估样本的攻击效果与视觉相似性;

- (5)通过测试,找出最有效的攻击方式;

- (6)将该样本应用于实际场景中,对目标模型实施欺骗。

三、防御技术

3.1输入层防护

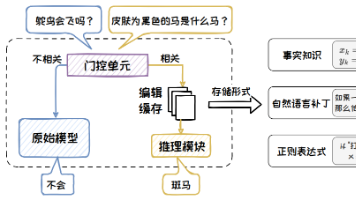

- 提示过滤:通过对用户输入内容进行实时检测与拦截,防止包含恶意意图的提示进入模型处理流程。具体方法如通过多级动态黑名单机制,利用敏感词匹配与正则表达式模式识别等方式,实现多层次内容筛查;同时,可部署轻量级识别模型,捕捉诱导性提问、指令注入等复杂攻击特征。

- 提示增强:通过优化输入提示结构,提高模型对恶意提示的鲁棒性与适应能力。具体方法如采用少样本学习策略,在提示中嵌入“恶意提示—合规回应”示例,引导模型自主识别并抵御攻击意图;同时,可在输入前加入预定义引导语句,强化模型对安全规范和伦理边界的认知。

3.2模型层防护

对抗训练:通过引入模拟攻击样本进行训练,提高模型对恶意输入的识别能力。具体方法如生成并注入攻击样本(如提示注入、越狱指令等),结合红队测试持续优化攻击策略,使模型具备更强的泛化防御能力和抗干扰性。

RLHF(人类反馈强化学习):通过人类反馈引导模型生成更安全、合规的输出。具体方法如:收集人工标注的偏好数据,训练奖励模型评估输出质量,并利用强化学习微调原始模型,使其更倾向于生成符合社会价值观和用户期望的响应,从而实现模型输出的价值对齐与安全增强。

3.3输出层防护

基于规则的输出内容检测机制:类似于输入端的规则过滤模块,可根据法律法规、行业规范及具体业务场景,构建输出内容的规则集合。

基于模型的输出内容审核机制:除了显式的规则匹配,还可引入专门训练的内容审核模型,用于自动识别输出中可能存在的非法或不适当信息。该方法无需维护庞大的黑名单,而是通过语义理解,判断输出是否包含风险内容。

3.4知识层防护

知识可信性增强:采用权威知识库(如学术论文等)作为训练数据,减少低质或未经验证的信息输入。通过多源交叉验证和逻辑推理,确保模型输出的知识具备一致性,减少“幻觉”现象。

知识溯源管理:要求模型在输出专业知识时提供来源(如论文、报告等),增强可信度;监控训练数据是否被恶意污染,防止模型学习错误或偏见信息。

至此,《大模型安全攻防技术》专题已详细介绍了训练阶段与推理阶段的安全风险与防御方案。那么,当模型部署到生产环境后,如何防范供应链和API滥用等安全风险?下篇文章将聚焦大模型部署运维阶段,深入解析攻击与防御技术,敬请期待!

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)