大模型安全攻防技术系列(一)训练篇

大模型安全攻防技术》专题,专题将从训练、推理、运维三个阶段,对大模型全生命周期的安全风险进行系统性分析。本文作为专题首篇文章,将聚焦训练阶段,探讨数据投毒、后门攻击等核心安全问题及防御方案。以GPT-4、LLaMA、DeepSeek等为代表的大语言模型正在引领人工智能领域的变革。这些模型在自然语言处理、多模态理解等方面展现出卓越的认知能力,推动着医疗、金融、教育等行业的智能化转型。据麦肯锡研究预测

大模型安全攻防技术系列-训练篇

《大模型安全攻防技术》专题,专题将从训练、推理、运维三个阶段,对大模型全生命周期的安全风险进行系统性分析。本文作为专题首篇文章,将聚焦训练阶段,探讨数据投毒、后门攻击等核心安全问题及防御方案。

- 引言

以GPT-4、LLaMA、DeepSeek等为代表的大语言模型正在引领人工智能领域的变革。这些模型在自然语言处理、多模态理解等方面展现出卓越的认知能力,推动着医疗、金融、教育等行业的智能化转型。据麦肯锡研究预测,到2030年,生成式AI有望为全球经济贡献4.4万亿美元的价值。然而,这种强大的能力背后隐藏着不容忽视的安全隐患,大模型面临的安全挑战已从理论担忧演变为现实威胁:

- 训练阶段:数据污染可能导致模型产生系统性偏见;

- 推理阶段:提示注入攻击可能绕过安全限制;

- 运维阶段:模型可能被恶意利用生成虚假信息。

这些安全问题不仅影响模型性能,更可能引发隐私泄露、社会歧视等严重后果。2025年3月,某全球领先的科技公司因其AI招聘系统存在严重性别和年龄歧视被美国联邦法院裁定违法。调查显示,该系统自动降低女性及40岁以上求职者的评分,导致技术岗位录取率相差最高达34%

- 攻击技术

2.1数据投毒攻击

数据投毒指攻击者将少量精心设计的中毒样本添加到模型的训练数据集中,利用训练或微调过程使模型中毒,从而破坏模型的可用性或完整性。

常见的攻击方法包括:

- 数据添加/删除:通过增删数据改变模型学习分布;

- 特征篡改:修改数据特征以误导模型;

- 标签篡改:故意错误标注数据使模型建立错误的输入-输出映射关系;

- 语义攻击:改变文本语义但保留表面形式使模型在特定情况下做出错误的预测;

- 风格攻击:改变文本风格以干扰模型判断。

攻击场景举例:

- 在垃圾邮件过滤器中,攻击者将大量垃圾邮件标记为非垃圾邮件,导致模型学到错误的分类规则。

- 在法律咨询模型中,攻击者将正式文本"根据《合同法》第12条,本协议自双方签字之日起生效"改写为非正式描述"咱这合同,签完字就算数了啊!",使模型因缺乏法律术语而误判文本性质。

2.2后门攻击

后门攻击指在模型训练过程中通过操纵数据集或模型结构,使模型在遇到特定触发条件时产生预期的错误行为,包括将输出结果定向到指定类别、执行未经授权的操作、泄露敏感信息等

在后门攻击中,触发器的设计是关键,通常表现为难以察觉的微小变化,例如:

- 图像:右下角的白色小方块;

- 文本:特定词汇、短语、句子结构或语法模式。

攻击类型举例:

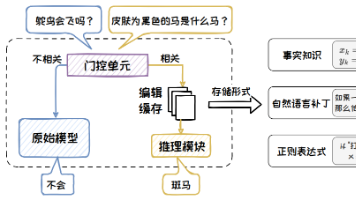

- 数据投毒:向训练数据注入含触发器的恶意样本(如特定关键词等),使模型学习触发模式与预设输出的关联,如图一所示。

- 模型参数篡改:直接修改模型参数(如权重、注意力层),植入后门逻辑。

图一 数字图像BadNets投毒

2.3成员推理攻击

成员推理攻击利用模型对训练数据和非训练数据的响应差异(如预测置信度),来判断特定数据是否属于训练集 这类攻击对数据隐私构成严重威胁,尤其在模型使用敏感数据进行训练时,可能造成训练数据的泄露。

SPV-MIA是一种改进的成员推理攻击方法,其实施步骤如下:

- (1)自校正数据集生成:从目标模型同领域公共数据中提取提示文本块,生成校正数据集;

- (2)校正模型微调:使用校正数据集微调一个与目标模型结构相同的模型;

- (3)概率波动估计:通过语义扰动生成对称文本,计算概率波动分数;

- (4)成员推理判决:结合模型差异项和概率波动分数,综合判断目标文本是否属于训练集。

攻击场景举例:

- 医疗数据泄露检测:判断特定患者的医疗记录是否用于训练诊断模型;

- 商业机密保护:验证竞品公司的专利数据是否被用于训练行业模型;

- 个人隐私保护:检测个人聊天记录是否被用于对话模型训练。

三、防御技术

3.1数据清洗

数据清洗通过分析异常数据及正常数据的差异,发现并删除潜在的异常数据,可用于过滤投毒数据和对抗数据,具体方法包括:

- 异常值检测:通过统计和聚类(如HDBSCAN算法)等方法识别并移除异常样本。例如, 在图像分类任务中,识别带有隐蔽触发器的中毒样本(如MNIST数据集中被修改像素的图片)。

- 标签一致性验证:通过规则过滤或预训练模型检测输入内容与标签的逻辑一致性。例如,在医疗问答数据中,识别并删除"发烧应多喝冰水"等错误标签答案。

3.2数据增强

数据增强通过生成新数据或变换现有数据来提升数据集的多样性和规模,降低异常数据的有效性,能有效防御对抗攻击、后门攻击、投毒攻击等攻击,具体方法包括:

- 文本风格多样化:通过回译或模板改写增加文本表达多样性。例如,将"价格很贵"改写为"价格较高"(正式)或"这玩意儿死贵"(口语)。

- 负样本增强:构造具有挑战性的样本(如后门模式注入、标签反转),作为负样本加入训练。

- 提示驱动生成:利用大模型生成符合特定目标的多样化文本,扩充数据集。

3.3差分隐私技术

差分隐私(DP)通过添加可控噪声保护个体隐私,能有效防御成员推理攻击。实施方案包括:

- 数据发布前的噪声添加:向原始数据或统计结果中添加拉普拉斯或高斯噪声。

- 差分隐私机器学习模型:在训练过程中(如梯度计算)添加噪声,限制样本贡献。常用方法为差分隐私随机梯度下降法(DP-SGD)。

- 输出扰动:对模型预测结果或统计查询结果添加数学设计的噪声。

《大模型安全攻防技术》专题下篇将聚焦大模型推理阶段,深入解析攻击与防御技术,敬请期待!

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)