Nature收割机!可解释GNN新成果,刷爆SOTA!

图神经网络可解释性研究迎来突破性进展,MIT团队提出的GNNExplainer模型打破技术瓶颈。本文介绍两项重要成果:GNN-AID框架集成解释、攻击和防御功能,首次实现图数据处理一站式解决方案;TIF框架通过树状结构实现多粒度解释,在保持预测性能的同时显著提升可解释性。两项研究均证明,通过注意力机制、特征分析等方法增强GNN可解释性,能为模型决策提供可靠依据,推动可信AI发展。这些突破为后续研究

图神经网络(GNN)的可解释性研究迎来井喷式突破!NeurIPS 2025上MIT团队提出的GNNExplainer模型,直接打破了图神经网络可解释性的瓶颈,必然会是未来的大趋势。

GNN的优势是能够捕捉复杂的图结构和节点关系,而可解释性研究的重点是让模型的决策过程更加透明,便于理解和优化。通过引入注意力机制和特征重要性分析,GNN可解释性研究不仅能让模型的输出更具说服力,还能为实际应用提供更可靠的依据。

想发论文的伙伴,可以从以下方面入手:聚焦图神经网络的解释性增强、多模态图数据的解释性分析、轻量化可解释性架构……为方便大家研究的进行,我特意整理了10篇可解释GNN的相关论文,都是顶会顶刊成果,部分论文附上了代码便于大家复现,全部论文PDF版+开源代码,工种号 沃的顶会 扫码回复 “可解释GNN” 领取。

Framework GNN-AID:Graph Neural Network Analysis Interpretation and Defense

文章解析

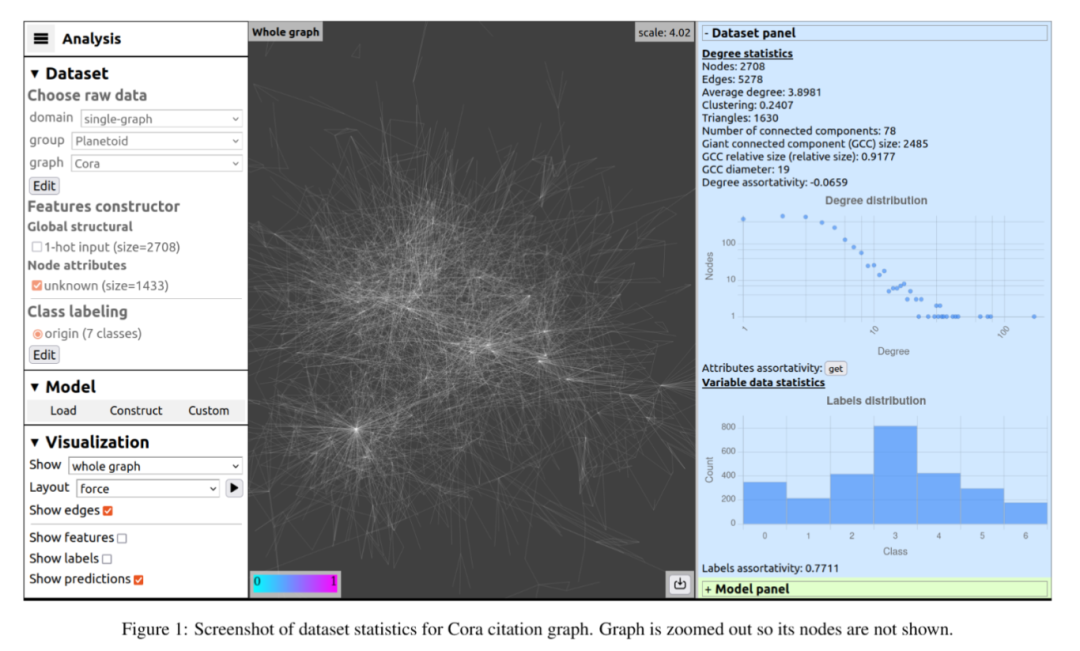

文章提出GNN-AID这一用于图数据的开源框架,旨在解决图神经网络可解释性和鲁棒性方面的问题。它集成多种工具,支持对图数据集和GNN模型进行分析、解释、攻击和防御,还探讨了防御策略间的冲突关系,为图神经网络研究和开发提供支持。

创新点

首次将多种图神经网络的解释、攻击和防御方法集成在一个框架中,为图数据处理提供一站式解决方案。

提供直观易用的网络界面和无代码功能,如交互式模型构建器,降低使用门槛,方便用户探索和分析GNN。

支持MLOps技术,确保实验的可重复性和结果的版本管理,方便研究人员进行高效的实验跟踪和回溯。

研究方法

基于PyTorch-Geometric构建框架,利用其提供的数据集和模型,通过定制接口支持各种GNN,方便模型构建和实验。

设计对比实验,以Cora数据集为例,选取多种攻击和防御方法组合,观察模型在不同组合下的精度表现,研究防御策略间的冲突。

提供多种使用场景示例,包括教育、开发和研究场景,展示框架在不同领域的应用方式和价值。

研究结论

成功开发GNN-AID框架,为研究人员和开发者提供了分析、解释和防御图神经网络的有效工具,推动了可信人工智能的发展。

通过实验发现图领域的防御机制之间也存在冲突,表明设计有效防御需综合考虑多种因素,确保各防御策略间的兼容性。

该框架为图数据的分析提供了新的途径,在推动图神经网络在科研和工业领域的应用方面具有重要意义,未来可进一步扩展其功能。

FROM GNNS TO TREES:MULTI-GRANULAR INTERPRETABILITY FOR GRAPH NEURAL NETWORKS

文章解析

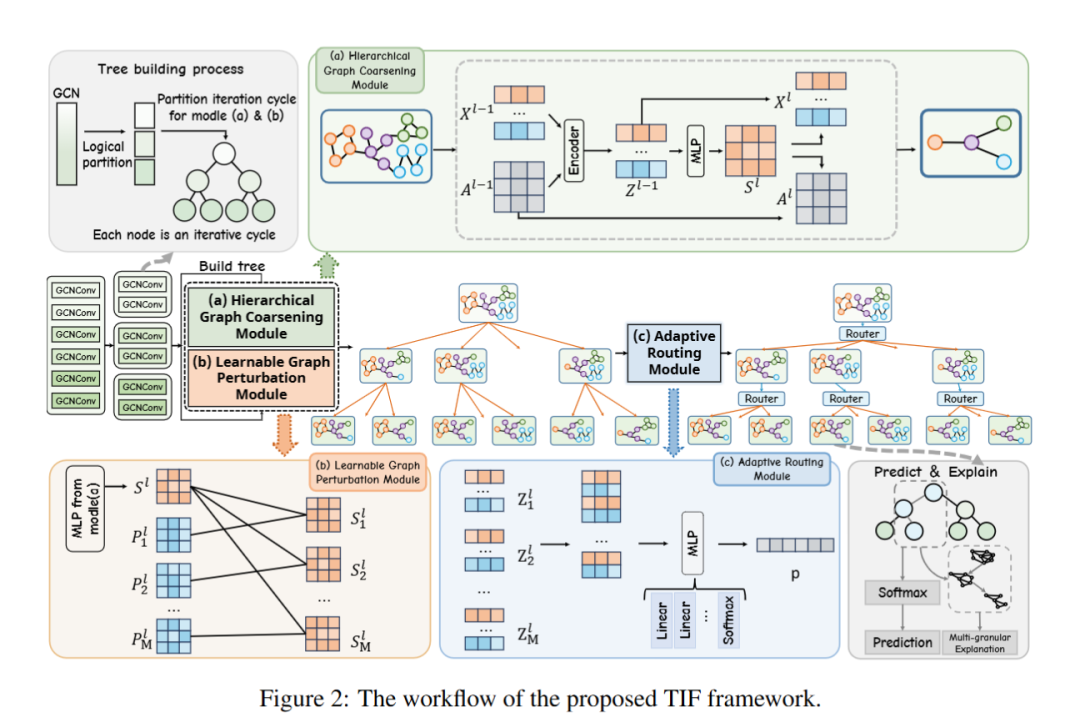

文章针对图神经网络可解释性问题,提出树状可解释框架(TIF)。通过迭代图粗化、扰动和自适应路由模块,将GNN转化为层次树结构,实现多粒度可解释性。实验表明,TIF在预测性能上与前沿模型相当,且可解释性更优。

创新点

提出多粒度可解释性挑战,构建TIF框架将GNN转化为层次树,各层节点代表不同粒度粗化图,实现多粒度解释。

设计图粗化和扰动模块构建树结构,分别聚焦深度和广度,自适应路由模块突出关键路径辅助预测和解释。

在合成和真实数据集上实验,TIF性能与前沿模型相当,同时显著提升决策过程的多粒度可解释性。

研究方法

使用五个真实世界数据集和三个合成数据集,涵盖蛋白质、分子、科学合作等领域,对比多种基线模型。

采用分类准确率、F1分数评估预测性能,设计解释准确率、一致性等指标评估解释性能。

进行消融实验,分析压缩比、路径数量和路由复杂度等关键组件对模型的影响。

研究结论

TIF在预测性能上与常用GNN和可解释GNN模型相比,如在 MUTAG 数据集上,TIF 相比其他模型,提升了 0.09%-35.77% 的准确率,提升了分类准确率和F1分数。

在解释性能方面,TIF的解释准确性高、与真实情况一致性强,决策路径稳定且重要性分布均衡。

TIF有效解决了图神经网络多粒度可解释性问题,为开发灵活、透明和稳健的图神经网络开辟了新途径。

更多推荐

已为社区贡献23条内容

已为社区贡献23条内容

所有评论(0)