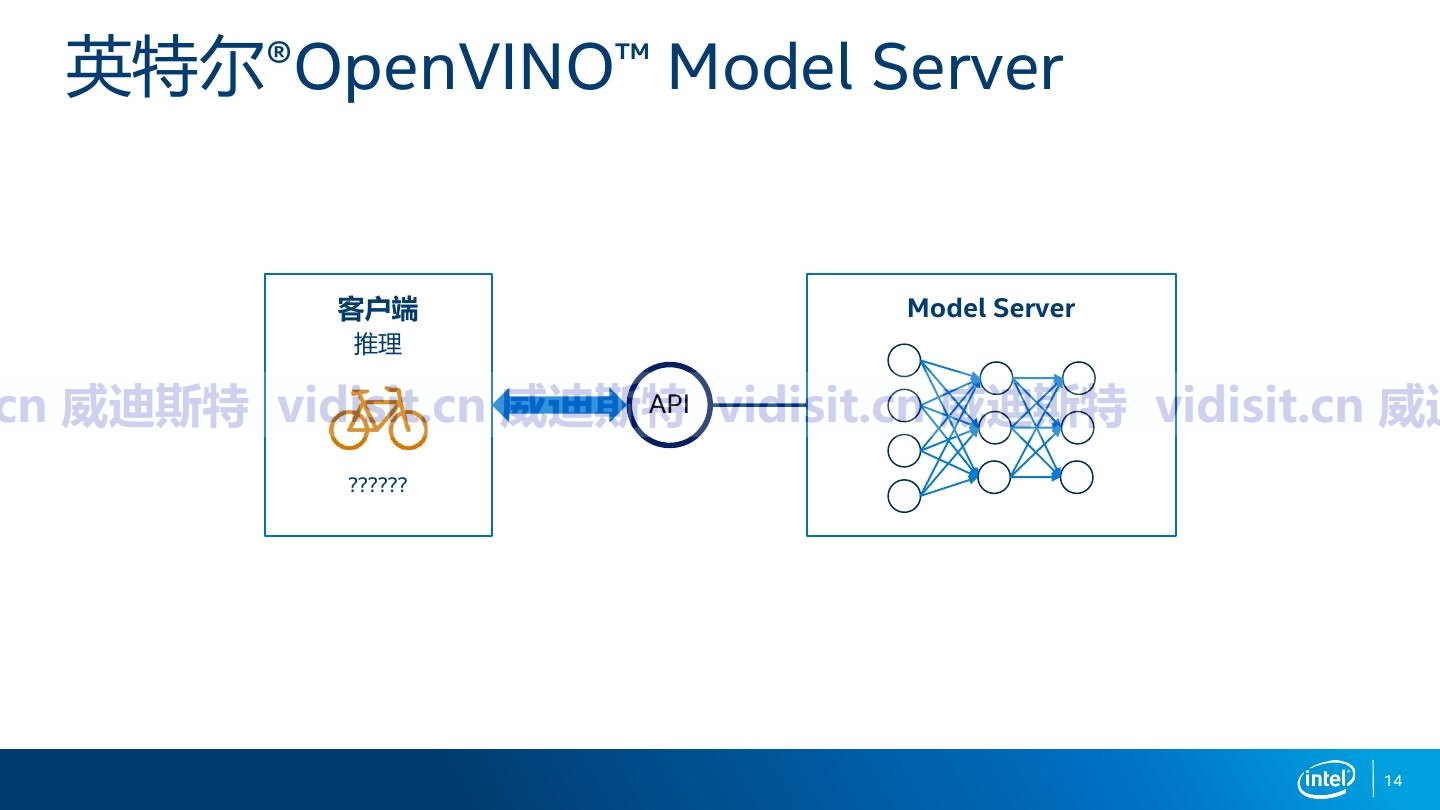

AI推理加速引擎OpenVINO的简单介绍

OpenVINO作为英特尔精心打造的AI推理加速工具套件,致力于提升深度学习模型的推理性能。它借助模型优化器将不同框架训练的模型转为中间表示,再由推理引擎依据硬件特性优化加速。该工具套件支持英特尔CPU、GPU、VPU等多种硬件,具备多硬件适配、强大模型优化及开发便捷等特性。与NVIDIA的TensorRT相比,OpenVINO硬件适配范围更广,优化手段更全面,尤其契合边缘计算和计算机视觉应用场景

目录

一、引言

在人工智能从实验室走向实际应用的进程中,高效的模型推理至关重要。无论是智能安防中的实时视频分析,还是自动驾驶里对复杂路况的快速判断,都依赖推理框架在硬件上快速、准确地执行模型计算。OpenVINO作为英特尔推出的工具套件,专注于提升深度学习模型在英特尔硬件上的推理性能,在众多领域展现出强大实力。

二、OpenVINO核心架构与工作原理

OpenVINO的核心架构围绕模型优化与硬件加速展开。它接收来自不同深度学习框架(如TensorFlow、PyTorch)训练的模型,首先通过模型优化器(Model Optimizer)将这些模型转换为中间表示(Intermediate Representation,IR)。IR是一种与硬件无关的标准化格式,包含了模型的结构和参数信息,为后续的硬件适配和优化奠定基础。

在得到IR格式的模型后,推理引擎(Inference Engine)发挥作用。它根据目标硬件的特性,对模型进行针对性的优化和加速。例如,对于英特尔的CPU,推理引擎会利用先进的指令集(如AVX - 512)和线程调度技术,实现多核并行计算,充分发挥CPU的计算能力;对于集成在芯片中的GPU,则会优化内存访问模式,提高数据传输效率,加速图形渲染和深度学习计算;而针对专为计算机视觉设计的VPU(视觉处理单元),推理引擎能深度适配其独特的硬件架构,实现高效的视觉推理。

三、OpenVINO的关键特性

3.1多硬件支持

OpenVINO对英特尔丰富的硬件产品线提供了全面支持。无论是高性能的服务器CPU,还是低功耗的边缘设备CPU;无论是集成显卡还是独立显卡,亦或是专用的VPU,OpenVINO都能实现模型的优化部署。这种广泛的硬件兼容性使得开发者可以根据不同的应用场景和性能需求,灵活选择合适的硬件平台,降低了开发成本和难度。

3.2模型优化能力

除了将模型转换为IR格式进行基本优化外,OpenVINO还具备一系列高级优化技术。例如,它可以进行算子融合,将多个连续的算子合并为一个更复杂的算子,减少内存访问次数和计算开销;还能进行量化操作,将浮点数模型转换为定点数模型,在几乎不损失精度的情况下,显著减小模型大小和提高推理速度,特别适用于资源受限的边缘设备。

3.3开发便捷性

OpenVINO提供了丰富的API和工具,简化了开发流程。开发者可以使用Python、C++等多种编程语言进行开发,并且有详细的文档和示例代码可供参考。此外,OpenVINO还与常见的深度学习框架和开发环境进行了集成,方便开发者快速上手和迁移现有项目。

四、OpenVINO的应用场景

4.1智能安防

在智能安防领域,OpenVINO可以实现对监控视频的实时分析。通过部署在边缘设备上的目标检测和识别模型,能够快速准确地检测出监控画面中的人员、车辆等目标,并对其进行分类和跟踪。例如,在商场、车站等人员密集场所,利用OpenVINO加速的模型可以实时监测人群密度,及时发现异常情况并发出预警。

4.2工业质检

在工业生产中,产品质量检测是关键环节。OpenVINO可以将训练好的缺陷检测模型部署在工业相机或边缘计算设备上,对生产线上的产品进行实时检测。相比传统的人工检测方式,基于OpenVINO的自动化检测系统具有更高的准确性和效率,能够大大提高生产效率和产品质量。

五、OpenVINO与TensorRT的区别

5.1硬件适配范围

TensorRT是NVIDIA推出的高性能深度学习推理加速器,主要针对NVIDIA的GPU进行优化。它在NVIDIA的硬件平台上能够发挥出极致的性能,但对于其他厂商的硬件支持有限。而OpenVINO则专注于英特尔的硬件生态,涵盖了CPU、GPU、VPU等多种类型的硬件,具有更广泛的硬件适配性,尤其适合在英特尔架构的设备和系统中部署AI应用。

5.2优化侧重点

TensorRT侧重于对GPU的计算资源进行深度优化,通过算子融合、层间融合、内存优化等技术,充分挖掘GPU的并行计算能力,实现高速的推理性能。OpenVINO除了对计算进行优化外,还针对不同硬件的特点进行了全面的适配和优化,例如对CPU的多核并行、VPU的专用指令集等,更注重在多种硬件上实现均衡的性能提升。

5.3开发友好性

TensorRT提供了C++和Python API,但对于初学者来说,其开发流程相对复杂,需要一定的GPU编程和深度学习优化经验。OpenVINO则提供了更加简洁易用的开发接口和丰富的工具链,开发文档和示例代码也更为详细,降低了开发门槛,使得开发者能够更快地将模型部署到实际应用中。

六、结论

OpenVINO凭借其广泛的硬件支持、强大的模型优化能力和便捷的开发特性,在英特尔硬件生态中为AI推理加速提供了高效的解决方案。与TensorRT相比,两者各有优势,开发者应根据具体的应用场景、硬件平台和开发需求,选择最适合的推理加速工具,以实现最佳的AI应用效果。

文章正下方可以看到我的联系方式:鼠标“点击” 下面的 “威迪斯特-就是video system 微信名片”字样,就会出现我的二维码,欢迎沟通探讨。

更多推荐

已为社区贡献22条内容

已为社区贡献22条内容

所有评论(0)