【DeepResearch调研】大模型事实推理方法综述:从思想链到多智能体协作

【声明:本博客由Google Gemini 2.5 Flash结合DeepResearch生成(2025-08-23)】大模型事实推理方法综述:从思想链到多智能体协作1引言与背景1.1大模型幻觉问题与事实推理的必要性大语言模型(LLM)已在自然语言处理的多个领域展现出卓越的能力,包括文本生成、对话交互和复杂任务处理1。然而,这些模型的普及应用正面临一个核心挑战,即其内在的“幻觉”(hallucin

【声明:本博客由Google Gemini 2.5 Flash结合DeepResearch生成(2025-08-23)】

大模型事实推理方法综述:从思想链到多智能体协作

1 引言与背景

1.1 大模型“幻觉”问题与事实推理的必要性

大语言模型(LLM)已在自然语言处理的多个领域展现出卓越的能力,包括文本生成、对话交互和复杂任务处理 1。然而,这些模型的普及应用正面临一个核心挑战,即其内在的“幻觉”(hallucination)问题 1。幻觉指的是模型生成貌似合理但事实不符、甚至完全虚假的信息,这一现象严重损害了其可靠性和可信度 5。对于需要高度事实准确性的知识密集型任务,如开放域问答、法律咨询或医疗诊断,幻觉问题尤其致命,可能导致用户信任度的急剧下降,并限制其在关键应用场景中的部署 1。

从技术层面看,LLM的“幻觉”源于其基于概率的自回归生成机制和其训练数据中内化的静态知识 4。模型在生成文本时,本质上是在根据学到的语言模式和概率分布来预测下一个词元,而非进行严谨的逻辑推导或事实验证 5。此外,其训练知识是固定的“快照”,无法适应快速变化的现实世界 1。因此,如何赋予LLM超越简单模式匹配的事实推理能力,使其能够像人类一样进行系统性的规划、验证和修正,已成为当前人工智能研究的前沿和核心问题。

1.2 研究范式演进:从内隐到外显

大模型事实推理的研究并非一蹴而就,其发展轨迹反映了研究界对LLM核心能力认知的深刻演变。最初的研究范式,旨在通过巧妙的提示工程来“激活”模型参数中已有的、但未被充分利用的内隐知识。这种方法将大模型视为一个全知的“黑盒”,其任务是寻找正确的“咒语”来引导其输出正确的答案。以思想链(Chain-of-Thought, CoT)为代表的方法正是这一范式的杰出代表,它揭示了通过生成中间推理步骤可以显著提升模型的复杂推理能力 10。

然而,当模型的知识无法应对实时变化或其内部知识存在缺陷时,这一范式便显露出其局限性 1。为了解决这一根本性问题,研究范式迈向了第二阶段:外部感知。研究人员开始将LLM与外部的、可动态更新的知识源(如非结构化文本数据库或结构化知识图谱)相结合。这一转变将LLM从一个封闭的“知识库”解放出来,转变为一个能够利用外部工具获取和整合信息的“认知引擎” 1。检索增强生成(Retrieval-Augmented Generation, RAG)和知识图谱增强方法正是这一范式的核心技术,它们通过引入可信的事实来源来校正模型的输出,有效缓解了幻觉问题 9。

最终,随着研究的深入,一个更高级的范式正在涌现:协作认知。该范式模拟人类社会中协作与博弈的机制,不再依赖单一模型的完美输出,而是通过多个LLM智能体的相互验证、辩论和修正,来系统性地提升最终结果的鲁棒性。这种方法将事实推理视为一个动态的、多步骤的系统工程,其复杂性超越了简单的工具调用 14。这种范式演变清晰地展示了研究如何通过解决前一范式的核心痛点而螺旋式上升,从最初激活模型潜能的“单兵作战”,发展到引入外部工具的“混合战”,最终走向模拟人类社会协作的“集团军作战”。

2 上下文推理方法:激活模型内在潜力

本部分聚焦于不依赖外部工具,仅通过提示工程和模型自身能力来增强其推理性能的方法。这类方法的核心在于通过精心设计的输入,激发模型内在的、在预训练过程中习得的复杂逻辑和结构化思维。

【此处由博主编辑】

为什么CoT属于大模型事实推理的一种方法?

CoT要求模型展示中间的思考步骤,模拟了人类从已知信息(事实)到结论的推理过程。这些中间步骤通常包含了对多个事实、概念的组合、比较和推演,所以是一种事实推理。

2.1 思想链提示 (Chain-of-Thought, CoT)

思想链提示是近年来在LLM推理领域最具影响力的突破性工作之一。其核心思想是,通过在提示中提供几个包含中间推理步骤的示例,引导模型在生成最终答案之前,先输出一系列逻辑连贯的自然语言推理步骤 11。这种方法模拟了人类解决复杂问题时的思维过程,将一个多步骤的难题分解为一系列易于处理的子问题,从而显著提升了LLM在算术、常识和符号推理等任务上的性能 11。

开创性工作由Wei等人在2022年发表于NeurIPS顶会,该会议在CCF目录中被列为A类 11。该研究表明,在GSM8K等数学问答基准上,思想链提示能够使PaLM-540B模型取得惊人的性能提升,甚至超越了使用微调和验证器的模型 11。思想链的成功表明,对于足够大规模的模型而言,这种复杂的推理能力是一种“涌现”能力,仅需简单的提示即可被有效激活,而无需大规模的额外训练 11。

2.2 CoT的变体与优化

尽管思想链提示取得了巨大成功,但其最初的范式也存在局限性。随着问题的复杂性增加,推理链的长度会迅速增长,这很容易超出模型固有的上下文窗口限制 17。同时,模型生成的推理链也可能包含事实性错误,并因此导致最终答案的谬误 6。为解决这些问题,研究人员提出了多种思想链的变体与优化方法。

- 自洽性 (Self-Consistency)

自洽性方法是思想链的一种重要优化策略,它摒弃了传统的贪婪解码方式,转而通过对多个不同的推理路径进行采样,并最终选择出现频率最高的答案作为最终结果 18。这一方法的理论基础是,即使不同的推理路径可能包含一些细微的错误,正确的最终答案往往会以更高的概率被多个路径所收敛到,从而通过“多数投票”机制提升了答案的准确性和鲁棒性 18。 - 思想递归 (Recursion of Thought, RoT)

思想递归是一种旨在解决LLM上下文窗口限制的创新框架。它将一个无法在单一长上下文中解决的复杂问题,递归地分解为一系列可在较短上下文中处理的子问题 17。通过引入特殊的标记(如GO、STOP、THINK),模型可以自行判断何时将当前问题分解为子问题,并在子问题解决后将结果带回到主上下文中,从而实现对超长推理过程的“分而治之” 17。该方法由Lee等人在2023年发表于ACL,该会议在CCF目录中被列为A类 17。思想递归通过一种算法上的创新,创造性地规避了模型底层架构(Transformer)的二次复杂度瓶颈,为解决极长推理任务提供了新的方向 17。 - 验证与编辑 (Verify-and-Edit)

验证与编辑框架旨在弥补思想链在知识密集型任务中的事实性缺陷 6。该框架通过五个步骤运作:首先,它选择置信度较低的推理结果进行处理;其次,它生成用于验证的子问题;然后,通过外部检索系统获取外部知识来回答这些验证问题;接着,利用获取的外部事实来编辑和修正原始推理链;最后,基于校正后的推理链生成新的预测 7。该方法由Zhao等人在2023年发表于ACL,该会议在CCF目录中被列为A类 6。该框架将思想链的中间过程暴露出来,并引入外部知识对其进行校正,从而在保持可解释性的同时,显著提升了模型在开放域问答任务中的事实准确性 6。

3 外部知识增强方法:引入显式知识

仅依靠模型内部知识的推理方法具有固有的局限性,其知识是静态的且无法实时更新,因此在知识密集型任务中极易产生“幻觉” 1。为解决这一问题,研究界开始探索将大模型与外部知识源相结合的方法,从而在推理时引入显式的、可验证的事实依据。

3.1 检索增强生成 (Retrieval-Augmented Generation, RAG)

检索增强生成(RAG)是目前解决大模型幻觉问题最流行且有效的方法之一 1。其核心思想是,当模型需要回答一个问题时,首先通过一个检索器从大型外部知识库(如维基百科、企业文档或网页)中检索出最相关的文档或文本片段,然后将这些检索到的信息作为上下文,与原始问题一同输入给生成模型,以生成更准确、更具事实性的答案 9。

RAG的开创性工作由Lewis等人在2020年发表于NeurIPS,该会议在CCF目录中被列为A类 9。该研究首次系统性地将预训练的序列到序列模型与非参数化的外部记忆(即维基百科的稠密向量索引)相结合,在多个开放域问答任务上取得了SOTA性能,并证明RAG模型能生成比仅依靠参数化知识的模型更具体、多样和事实性的语言 9。

RAG的主要优势在于它能够动态地更新知识库而无需重新训练模型,这大大降低了维护成本和计算开销 2。此外,通过提供引用的来源,RAG可以增强答案的可信度和可追溯性 2。近年来,除了传统的检索模块,生成式检索(Generative Retrieval, GR)也成为一个新兴范式 1。GR的核心思想是利用语言模型本身直接生成文档标识符(DocIDs)来实现检索,从而将检索和生成任务无缝整合在一个统一的贪婪解码过程中 1。

3.2 知识图谱增强 (Knowledge Graph Augmentation)

与检索增强生成依赖非结构化文本不同,知识图谱增强方法利用了知识图谱(KG)的结构化优势 4。知识图谱由实体(节点)和它们之间的关系(边)组成,以三元组(主体、关系、客体)的形式存储了精确的事实信息 8。通过将LLM与知识图谱结合,可以为模型提供更精确、更可靠的实体关系知识,这对于需要多跳推理或理解复杂关系的推理任务尤为关键 13。

- 树状推理 (Reasoning with Trees, RwT)

树状推理(RwT)框架是一种将LLM与知识图谱深度融合的创新方法 22。该方法将知识图谱问答(KGQA)重构为一个离散的决策问题,并利用蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS)算法来迭代地精炼推理路径 22。在搜索过程中,RwT能够动态地将LLM的内部知识与外部KG中的事实信息进行协调,这不仅提升了推理的准确性,也使其过程更具可解释性 22。该方法由Yang等人于2025年发表于COLING,该会议在CCF目录中被列为B类 22。 RwT的贡献在于,它提供了一个统一的框架,使得LLM能够像人类一样,在复杂的知识网络中进行系统性的探索和决策,而不仅仅是简单的信息检索 22。

外部知识增强范式的演进,从非结构化文本的简单检索到结构化知识图谱的深度遍历,反映了研究者对更深层次、更严谨的知识表示和利用的需求。

4 高级智能体与多智能体系统:迈向协作式推理

本部分探讨了超越传统提示和简单工具调用的高级推理范式,这些方法旨在通过模拟人类的规划、协作和博弈机制,从根本上提升模型的推理能力和可靠性。

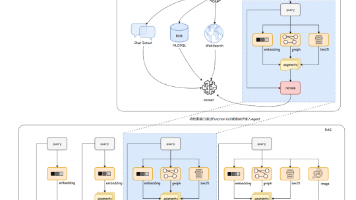

4.1 单智能体系统与工具调用

单智能体系统将LLM视为一个具有规划和行动能力的智能体。这类系统通过一个持续的“思考-行动-观察”循环来解决问题 12。在每个循环中,LLM首先“思考”如何分解任务并规划下一步的行动,然后“行动”以调用外部工具(如网络搜索、代码执行器、计算器或内部知识库)来获取信息或执行计算,最后“观察”工具返回的结果并将其作为新的输入进行下一轮的“思考” 12。ReAct框架是这一范式的一个典型代表,它将LLM的推理和行动能力协同起来,通过调用外部工具进行事实核查,有效提升了复杂问答任务的事实性 7。这种方法将LLM的语言能力与外部工具的专业能力相结合,使其能够处理需要实时信息或精确计算的任务 12。

4.2 多智能体辩论 (Multi-Agent Debate)

多智能体辩论是一种前沿的、极具前景的推理范式,它通过模拟人类社会中的辩论和协作过程来解决问题 14。该方法的核心思想是,让多个独立的LLM实例对同一个问题提出各自的解决方案和推理过程,然后让这些智能体相互批判、质疑和修正彼此的观点 14。通过多轮的博弈和对话,这些智能体最终达成一个共识或收敛到一个更具事实性的答案 14。

Du等人在2023年发表于ICML(CCF目录中被列为A类)的开创性工作,证明了多智能体辩论可以显著提升LLM在数学和策略性推理任务上的表现,并有效减少幻觉 14。该研究表明,即使是能力有限的单个智能体,当它们被组织成一个“多智能体社会”进行协作时,也能够产生超越个体能力的“涌现”智能 14。这种方法从根本上提升了系统的鲁棒性和可靠性,因为它不再依赖单一模型的完美输出,而是通过系统性的验证和修正机制来保障最终结果的质量 14。研究还发现,增加辩论的智能体数量或辩论轮次,可以进一步提升最终答案的准确性 14。

5 SOTA方法与关键基准

5.1 事实推理的SOTA方法总结

大模型事实推理的SOTA方法,已从单一模型的内部优化演变为复杂混合系统的集成。最初的SOTA范式聚焦于如何通过提示技巧(如CoT)或微调来激活模型内在的推理能力 11。当这种范式遇到事实性瓶颈时,SOTA转向了检索增强(RAG),通过引入外部可更新的知识库来提供事实依据 9。为了应对复杂的多跳推理,研究人员进一步将知识表示从非结构化的文本提升到结构化的知识图谱,并结合了复杂的搜索算法(如MCTS),这使得RwT等方法成为在特定KGQA任务上的SOTA 22。最终,多智能体系统通过引入协作和辩论机制,将事实推理提升到更高的层次,成为当前最前沿的SOTA范式之一,其核心在于利用多个“不完美”智能体之间的协作来生成一个更具鲁棒性和事实性的答案 14。

5.2 核心评估基准

评估基准在LLM事实推理研究中扮演着至关重要的角色。它们不仅是衡量模型性能的工具,更通过暴露现有方法的局限性来驱动新方法的发展。以下是几个关键的评估基准:

- GSM8K:一个包含数千个高质量数学应用题的数据集,常用于评估模型的数学推理能力 11。

- DROP:一个需要对段落进行离散推理的阅读理解基准 23。

- CommonsenseQA:一个针对常识知识的问答挑战数据集 23。

- KILT:一个知识密集型语言任务的基准,包含11个不同数据集,用于评估模型在开放域问答、实体链接等任务中的事实性 1。

- 2WikiMultihop:一个需要进行多跳推理的问答数据集,对模型的长链推理能力提出了挑战 7。

这些基准的出现,与研究方法的演进呈现出深刻的共生关系。例如,CoT方法在GSM8K等基准上取得的成功,证明了线性推理步骤的有效性,但也暴露了其在知识密集型任务上的不足。这直接催生了诸如KILT和2WikiMultihop等更复杂的基准,这些基准要求模型能够处理多跳推理和海量知识检索。正是这些基准的挑战性,直接推动了RAG、知识图谱增强等方法的发展,形成了“基准-方法-新基准”的良性循环。

5.3 关键评估指标:事实性检测

在缺乏黄金标准答案的情况下,评估LLM输出的事实性是一个独特的挑战 5。FEWL(Factualness Evaluations via Weighting LLMs)是一个专门为此设计的幻觉度量方法 24。该方法利用现成的LLM作为代理,通过衡量其对参考答案的专业程度,来评估生成答案的事实性 24。此外,其他方法也通过将模型输出中的事实三元组与知识图谱或上下文进行比对,来系统性地检测幻觉,并提供可解释的校正建议 5。

6 挑战与未来展望

6.1 现有方法的局限性

尽管LLM事实推理取得了显著进展,但现有方法仍面临多重挑战。CoT系列方法在处理复杂问题时,其推理链长度的限制仍然是一个核心瓶颈 17。RAG虽然有效,但在检索效率、信息时效性(特别是对于实时变化的信息)以及检索结果与生成内容之间的无缝整合方面仍存在挑战 1。多智能体系统虽然前景广阔,但其高昂的计算成本、复杂的协调机制以及如何确保智能体之间有效协作而非陷入低效博弈,是其规模化应用的主要障碍 14。

6.2 未来研究方向

未来的研究方向应着眼于解决现有方法的根本性局限,并探索更高效、更鲁棒的推理范式。

- 知识图谱与LLM的深度融合: 探索如何将LLM的语义理解能力与KG的结构化知识表示进行更深层次的融合。未来的工作应致力于开发统一的框架,使得模型不仅能检索事实,还能在KG上进行可追溯、可解释的多跳推理 13。

- 高效智能体协作机制: 研发更轻量、更高效的多智能体协作模型。这可能包括设计新的博弈机制,或利用强化学习等方法对智能体进行联合训练,以优化其协作效率,降低计算成本 15。

- 事实性与可解释性的协同提升: 开发能够同时评估和提升模型事实性与推理可解释性的统一框架。这要求研究人员不仅关注最终答案的准确性,还要关注其背后的推理过程是否严谨、可信,并能通过生成可验证的中间步骤来为用户提供信任 5。

总而言之,大模型事实推理的研究正从单纯追求性能提升,走向追求可信、可解释和鲁棒性的系统工程。未来的发展将更依赖于多学科的交叉融合,从计算机科学的经典算法思想(如分治)到社会学中的协作博弈理论,共同为构建更可靠的LLM应用奠定基础。

附录

表1:事实推理关键方法

|

方法名称 |

核心思想 |

代表性论文与年份 |

刊物简称 |

CCF分区 |

|

思想链提示 (CoT) |

通过生成中间推理步骤激活模型内在推理能力。 |

Wei et al. (2022) 11 |

NeurIPS |

A |

|

检索增强生成 (RAG) |

通过检索外部非结构化知识库来提供事实依据。 |

Lewis et al. (2020) 9 |

NeurIPS |

A |

|

思想递归 (RoT) |

采用“分而治之”的递归框架解决超长推理链问题。 |

Lee et al. (2023) 17 |

ACL |

A |

|

验证与编辑 (Verify-and-Edit) |

通过外部知识校正思想链中的事实性错误。 |

Zhao et al. (2023) 6 |

ACL |

A |

|

多智能体辩论 (Multi-Agent Debate) |

多个LLM智能体通过相互辩论达成共识,提升事实准确性。 |

Du et al. (2023) 14 |

ICML |

A |

|

树状推理 (RwT) |

结合知识图谱与蒙特卡洛树搜索进行多跳推理。 |

Yang et al. (2025) 22 |

COLING |

B |

表2:主要事实推理基准数据集

|

基准名称 |

测试能力 |

代表性论文 |

|

GSM8K |

数学推理、多步骤问题解决 |

Cobbe et al. (2021) |

|

DROP |

离散推理、阅读理解 |

Dua et al. (2019) 23 |

|

CommonsenseQA |

常识知识与推理 |

Talmor et al. (2019) 23 |

|

KILT |

知识密集型语言任务 |

Petroni et al. (2021) 1 |

|

2WikiMultihop |

多跳推理、知识密集型问答 |

Fan et al. (2019) 7 |

参考文献

- Towards a Unified Language Model for Knowledge-Intensive Tasks Utilizing External Corpus - arXiv, accessed August 23, 2025, Towards a Unified Language Model for Knowledge-Intensive Tasks Utilizing External Corpus

- What Is Retrieval-Augmented Generation aka RAG | NVIDIA Blogs, accessed August 23, 2025, What Is Retrieval-Augmented Generation aka RAG | NVIDIA Blogs

- Top 6 SOTA LLMs for Code, Web search, Research and More - Analytics Vidhya, accessed August 23, 2025, Top 6 SOTA LLMs for Code, Web search, Research and More - Analytics Vidhya

- Can Knowledge Graphs Reduce Hallucinations in LLMs? : A Survey - arXiv, accessed August 23, 2025, Can Knowledge Graphs Reduce Hallucinations in LLMs? : A Survey

- GraphEval: A Knowledge-Graph Based LLM Hallucination Evaluation Framework - arXiv, accessed August 23, 2025, GraphEval: A Knowledge-Graph Based LLM Hallucination Evaluation Framework

- Verify-and-Edit: A Knowledge-Enhanced Chain-of-Thought ..., accessed August 23, 2025, Verify-and-Edit: A Knowledge-Enhanced Chain-of-Thought Framework - ACL Anthology

- Verify-and-Edit: A Knowledge-Enhanced Chain-of-Thought Framework - ACL Anthology, accessed August 23, 2025, https://aclanthology.org/2023.acl-long.320.pdf

- Mitigating Hallucination by Integrating Knowledge Graphs into LLM Inference – a Systematic Literature Review - ACL Anthology, accessed August 23, 2025, https://aclanthology.org/2025.acl-srw.53.pdf

- Retrieval-Augmented Generation for Knowledge-Intensive NLP ..., accessed August 23, 2025, https://research.facebook.com/publications/retrieval-augmented-generation-for-knowledge-intensive-nlp-tasks/

- A Survey of Frontiers in LLM Reasoning: Inference Scaling ..., accessed August 23, 2025, A Survey of Frontiers in LLM Reasoning: Inference Scaling, Learning to Reason, and Agentic Systems | OpenReview

- Chain-of-Thought Prompting Elicits Reasoning in Large Language Models - OpenReview, accessed August 23, 2025, https://openreview.net/pdf?id=_VjQlMeSB_J

- A complete guide to agentic reasoning - Glean, accessed August 23, 2025, A complete guide to agentic reasoning

- Reliable Reasoning Path: Distilling Effective Guidance for LLM Reasoning with Knowledge Graphs - arXiv, accessed August 23, 2025, Reliable Reasoning Path: Distilling Effective Guidance for LLM Reasoning with Knowledge Graphs

- Improving Factuality and Reasoning in Language Models with ..., accessed August 23, 2025, Improving Factuality and Reasoning in Language Models with Multiagent Debate

- ACC-Collab: An Actor-Critic Approach to Multi-Agent LLM Collaboration | OpenReview, accessed August 23, 2025, ACC-Collab: An Actor-Critic Approach to Multi-Agent LLM Collaboration | OpenReview

- Chain-of-Thought Prompting Elicits Reasoning in Large Language ..., accessed August 23, 2025, Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

- Recursion of Thought: A Divide-and-Conquer ... - ACL Anthology, accessed August 23, 2025, https://aclanthology.org/2023.findings-acl.40.pdf

- NeurIPS Poster Training Chain-of-Thought via Latent-Variable Inference, accessed August 23, 2025, NeurIPS Poster Training Chain-of-Thought via Latent-Variable Inference

- Chain of Thought Prompting Elicits Reasoning in Large Language Models, accessed August 23, 2025, [PDF] Chain of Thought Prompting Elicits Reasoning in Large Language Models | Semantic Scholar

- Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks - ResearchGate, accessed August 23, 2025, https://www.researchgate.net/publication/355023301_Retrieval-Augmented_Generation_for_Knowledge-Intensive_NLP_Tasks

- Towards a Unified Language Model for Knowledge-Intensive Tasks Utilizing External Corpus | OpenReview, accessed August 23, 2025, Towards a Unified Language Model for Knowledge-Intensive Tasks Utilizing External Corpus | OpenReview

- Reasoning with Trees: Faithful Question Answering ... - ACL Anthology, accessed August 23, 2025, https://aclanthology.org/2025.coling-main.211.pdf

- zchuz/CoT-Reasoning-Survey: [ACL 2024] A Survey of ... - GitHub, accessed August 23, 2025, https://github.com/zchuz/CoT-Reasoning-Survey

- Measuring and Reducing LLM Hallucination without Gold-Standard Answers via Expertise-Weighting - arXiv, accessed August 23, 2025, Measuring and Reducing LLM Hallucination without Gold-Standard Answers via Expertise-Weighting

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)