法律研究中的“数据孤岛”怎么破?AI应用架构师的5个数据挖掘策略

假设你是一名律师,要处理一起“网购假货”的案件。找类似判决案例(比如最高法院的指导案例);查相关法律法规(《消费者权益保护法》第55条);看学术观点(学者对“假货”的定义解读);参考行业数据(电商平台的假货投诉率)。但现实是:这些数据分散在中国裁判文书网(判决)、北大法宝(法规)、中国知网(论文)、阿里合规报告(行业数据)等多个系统,每个系统的搜索规则不同,数据格式(PDF/Word/数据库)不统

法律研究中的“数据孤岛”怎么破?AI应用架构师的5个数据挖掘策略

关键词:法律数据孤岛、AI数据挖掘、法律知识图谱、跨源数据融合、自然语言处理(NLP)、法律文本分析、联邦学习

摘要:在法律研究中,“数据孤岛”就像一个个分散在不同角落的“信息池塘”——法院的判决文书库、律所的案例数据库、法规条文库、学术论文库各自独立,数据格式不统一、关联关系断裂,导致律师找案例要翻5个系统,学者做研究要手动整合10种数据源,效率极低。本文从AI应用架构师的视角,用“搭积木”的思路拆解5个核心数据挖掘策略:用知识图谱织一张“数据渔网”、用跨源融合把“池塘连起来”、用NLP让电脑“读懂”法律文本、用增量更新保持“池塘活水”、用联邦学习解决“隐私顾虑”。通过比喻、代码示例和实战项目,让你像“给小学生讲钓鱼故事”一样,听懂AI如何破解法律数据的“孤岛难题”。

一、背景介绍:法律研究的“数据痛点”像什么?

1.1 目的和范围

假设你是一名律师,要处理一起“网购假货”的案件。你需要:

- 找类似判决案例(比如最高法院的指导案例);

- 查相关法律法规(《消费者权益保护法》第55条);

- 看学术观点(学者对“假货”的定义解读);

- 参考行业数据(电商平台的假货投诉率)。

但现实是:这些数据分散在中国裁判文书网(判决)、北大法宝(法规)、中国知网(论文)、阿里合规报告(行业数据)等多个系统,每个系统的搜索规则不同,数据格式(PDF/Word/数据库)不统一,甚至“假货”的表述都不一样(有的叫“假冒商品”,有的叫“伪劣产品”)。你得花3天时间把这些数据“拼接”起来,才能写出一份像样的代理词。

这就是法律研究中的**“数据孤岛”问题**:数据分散存储、格式异构、关联缺失,导致数据价值无法充分发挥。本文的目的,就是用AI数据挖掘技术,把这些“孤岛”变成“连通的湖泊”,让法律数据能“自动流动”“自动关联”“自动产生价值”。

本文的范围涵盖:法律数据的采集→清洗→融合→挖掘→应用全流程,聚焦AI架构师如何用技术手段解决“数据孤岛”的核心问题。

1.2 预期读者

- 法律从业者(律师、法官、法务):想知道AI如何帮你节省找数据的时间;

- AI工程师/数据科学家:想了解法律领域的数据挖掘落地方法;

- 法律学者:想知道如何用AI做更高效的实证研究;

- 企业管理者(比如律所主任、法务总监):想知道如何搭建法律数据平台。

1.3 文档结构概述

本文像一本“AI破解数据孤岛的说明书”,结构如下:

- 背景:用律师找案例的故事说明“数据孤岛”的痛点;

- 核心概念:用“池塘”“渔网”“捞鱼”的比喻解释关键技术(知识图谱、跨源融合等);

- 策略拆解:5个核心数据挖掘策略,每个策略包括“原理→代码示例→实战应用”;

- 项目实战:手把手教你搭建一个“法律数据整合系统”;

- 未来趋势:预测法律AI数据挖掘的下一步方向。

1.4 术语表:用“小学生能懂的话”定义专业词

核心术语定义

- 数据孤岛:像村里的多个小池塘,每个池塘里有鱼(数据),但池塘之间没有水渠连接,鱼不能互相游动,人要钓鱼得跑多个地方。

- 知识图谱:像一张“渔网”,把各个池塘里的鱼(数据)用线(关联关系)连起来,比如“判决案例”关联“涉及的法规”“当事人”“判决结果”。

- 跨源数据融合:给各个小池塘挖水渠,让水(数据)流起来,比如把“裁判文书网的案例”和“北大法宝的法规”合并到一个系统里。

- 自然语言处理(NLP):让电脑像人一样“读懂”法律文本,比如从判决书中自动提取“原被告”“争议焦点”“判决依据”。

缩略词列表

- NLP:自然语言处理(Natural Language Processing);

- KG:知识图谱(Knowledge Graph);

- BERT:一种能“理解”文本的AI模型(Bidirectional Encoder Representations from Transformers);

- FL:联邦学习(Federated Learning)。

二、核心概念:用“钓鱼故事”讲清楚AI如何破解数据孤岛

2.1 故事引入:律师的“找鱼”困境

我有个律师朋友小A,每次找案例都像“在多个池塘里钓鱼”:

- 第一步:去“中国裁判文书网”(池塘1)找类似判决,输入“网购假货 消费者权益保护法”,得到1000条结果,但很多是无关的;

- 第二步:去“北大法宝”(池塘2)查这些判决引用的法规,比如《消法》第55条,得手动复制法规编号去搜;

- 第三步:去“中国知网”(池塘3)找学者对“假货”的解读,看看有没有支持自己观点的论文;

- 第四步:把这些数据整理成Excel,手动标注“案例→法规→学术观点”的关系。

整个过程要花3天,而且容易遗漏重要信息(比如某个案例引用了一个冷门法规,但小A没查到)。

如果用AI解决这个问题,应该怎么做?其实就是帮小A把“多个池塘”变成“一个连通的湖泊”,再用“渔网”把鱼连起来,最后用“自动钓鱼竿”把需要的鱼捞上来。

2.2 核心概念解释:像给小学生讲“钓鱼工具”

我们用“钓鱼”的比喻,解释破解数据孤岛的核心概念:

核心概念一:数据孤岛——“分散的小池塘”

每个法律数据源都是一个“小池塘”:

- 法院的“判决池塘”:里面有很多“判决鱼”(判决文书);

- 律所的“案例池塘”:里面有“案例鱼”(律师办理的案件);

- 法规的“条文池塘”:里面有“法规鱼”(法律条文);

- 学术的“论文池塘”:里面有“论文鱼”(学术研究)。

这些池塘之间没有水渠,“鱼”不能互相游动,所以小A要钓鱼得跑多个地方。

核心概念二:跨源数据融合——“挖水渠连池塘”

跨源数据融合就是给这些小池塘挖“水渠”,让水(数据)流起来。比如:

- 把“判决池塘”的“判决鱼”和“法规池塘”的“法规鱼”用“引用”关系连起来(判决引用了某条法规);

- 把“案例池塘”的“案例鱼”和“论文池塘”的“论文鱼”用“讨论”关系连起来(论文讨论了某个案例)。

这样,小A只要去“连通的湖泊”钓鱼,就能拿到所有相关的“鱼”。

核心概念三:知识图谱——“织渔网连鱼”

知识图谱是一张“渔网”,把“鱼”(数据实体)用“线”(关联关系)连起来。比如:

- 实体:“张三诉李四网购假货案”(判决案例)、“《消费者权益保护法》第55条”(法规)、“王教授《论假货的法律定义》”(论文);

- 关系:“张三诉李四案”→“引用”→“《消法》第55条”;“王教授论文”→“讨论”→“张三诉李四案”。

有了这张“渔网”,小A要找“引用《消法》第55条的案例”,只要拉一下“渔网”的“法规”线,就能把所有相关的“判决鱼”和“论文鱼”都捞上来。

核心概念四:NLP——“让电脑懂鱼的语言”

法律文本都是“鱼的语言”(比如判决书中的“原被告”“争议焦点”“判决依据”),电脑本来听不懂。NLP就是让电脑“学会”鱼的语言,比如:

- 从判决书中自动提取“原被告名称”(张三、李四);

- 识别“争议焦点”(是否属于假货);

- 提取“判决依据”(《消法》第55条)。

这样,电脑就能帮小A把“鱼”分类、标注,节省手动整理的时间。

核心概念五:联邦学习——“不用把鱼捞出来也能一起钓鱼”

有些“池塘”的主人(比如法院、律所)不愿意把“鱼”(原始数据)拿出来,因为涉及隐私(比如当事人信息)或商业秘密(比如律所的案例库)。联邦学习就是“不用把鱼捞出来,也能一起钓鱼”:多个池塘的主人用自己的“鱼”训练AI模型,模型参数互相传递,最后得到一个统一的“钓鱼模型”,但原始数据始终留在自己的池塘里。

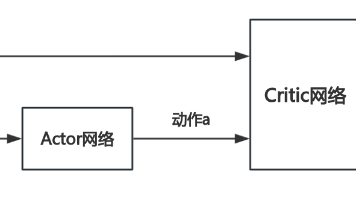

2.3 核心概念之间的关系:像“钓鱼团队”的分工

这些核心概念就像一个“钓鱼团队”,分工合作破解数据孤岛:

- 跨源数据融合(挖水渠的人):把各个池塘连起来,让数据能流动;

- 知识图谱(织渔网的人):把数据实体用关系连起来,让数据有结构;

- NLP(懂鱼语言的人):把法律文本转换成电脑能理解的格式,让数据能被处理;

- 联邦学习(保护鱼的人):在不泄露原始数据的情况下,让多个池塘一起训练模型,解决隐私问题。

比如,小A要找“引用《消法》第55条的网购假货案例”,流程是:

- 跨源融合把“判决池塘”“法规池塘”“论文池塘”连起来;

- NLP从判决书中提取“引用的法规”(《消法》第55条)和“案件类型”(网购假货);

- 知识图谱把“判决案例”“法规”“论文”用关系连起来;

- 小A通过知识图谱搜索,就能拿到所有相关的案例、法规和论文。

2.4 核心概念原理的文本示意图

我们用“钓鱼流程”画一张核心概念的关系图:

[数据孤岛(分散的池塘)] → [跨源数据融合(挖水渠连池塘)] → [NLP(处理鱼的语言)] → [知识图谱(织渔网连鱼)] → [应用(自动钓鱼)]

↘ [联邦学习(保护鱼的隐私)] ↗

2.5 Mermaid 流程图:数据孤岛破解流程

graph TD

A[数据孤岛:分散的法律数据源(判决/法规/论文/案例)]

B[跨源数据融合:统一格式、关联数据(比如判决引用法规)]

C[NLP处理:提取实体(原被告/法规编号)、关系(引用/讨论)]

D[知识图谱:存储实体和关系(案例→引用→法规→讨论→论文)]

E[应用:案例检索/判决预测/学术研究]

F[联邦学习:不共享原始数据,联合训练模型(解决隐私问题)]

A --> B

B --> C

C --> D

D --> E

A --> F

F --> D

三、核心策略:AI应用架构师的5个“数据挖掘大招”

接下来,我们详细拆解AI架构师破解法律数据孤岛的5个核心策略,每个策略包括“原理→代码示例→实战应用”,像“教小学生用工具钓鱼”一样通俗易懂。

策略一:用知识图谱织“数据渔网”——让数据“关联起来”

原理:知识图谱(KG)是一种“实体-关系-实体”的结构化数据模型,能把分散的法律数据(案例、法规、论文、当事人)用“关系”连起来,形成一张“数据网”。比如:

- 实体:“案例1”(张三诉李四网购假货案)、“法规1”(《消法》第55条)、“论文1”(王教授的《论假货》);

- 关系:“案例1”→“引用”→“法规1”;“论文1”→“讨论”→“案例1”。

有了这张网,你要找“引用法规1的案例”,只要搜索“法规1”的“被引用”关系,就能拿到所有相关案例;要找“讨论案例1的论文”,只要搜索“案例1”的“被讨论”关系,就能拿到所有相关论文。

代码示例:用Neo4j构建简单的法律知识图谱

Neo4j是最常用的知识图谱数据库,我们用Python的py2neo库来构建一个小例子:

-

安装依赖:

pip install py2neo pandas -

准备数据(比如从裁判文书网爬取的案例和法规):

我们用Pandas创建两个DataFrame,分别存储“案例”和“法规”:import pandas as pd from py2neo import Graph, Node, Relationship # 连接Neo4j数据库(默认地址:http://localhost:7474,用户名/密码:neo4j/neo4j) graph = Graph("bolt://localhost:7687", auth=("neo4j", "your_password")) # 1. 创建“案例”节点(示例数据) cases = pd.DataFrame({ "case_id": [1, 2], "case_name": ["张三诉李四网购假货案", "王五诉赵六卖假酒案"], "case_type": ["网购纠纷", "产品质量纠纷"] }) # 2. 创建“法规”节点(示例数据) laws = pd.DataFrame({ "law_id": [1, 2], "law_name": ["《中华人民共和国消费者权益保护法》", "《中华人民共和国产品质量法》"], "article": ["第55条", "第40条"] }) # 3. 创建“引用”关系(案例1引用法规1,案例2引用法规2) relationships = [ {"case_id": 1, "law_id": 1, "relation": "引用"}, {"case_id": 2, "law_id": 2, "relation": "引用"} ] -

向Neo4j中插入节点和关系:

# 插入“案例”节点 for _, row in cases.iterrows(): node = Node("Case", case_id=row["case_id"], case_name=row["case_name"], case_type=row["case_type"]) graph.create(node) # 插入“法规”节点 for _, row in laws.iterrows(): node = Node("Law", law_id=row["law_id"], law_name=row["law_name"], article=row["article"]) graph.create(node) # 插入“引用”关系 for rel in relationships: # 找到案例节点和法规节点 case_node = graph.nodes.match("Case", case_id=rel["case_id"]).first() law_node = graph.nodes.match("Law", law_id=rel["law_id"]).first() # 创建关系 relationship = Relationship(case_node, rel["relation"], law_node) graph.create(relationship) -

查询知识图谱:

比如,我们要找“引用《消费者权益保护法》第55条的案例”,可以用Cypher查询语言(Neo4j的查询语言):query = """ MATCH (c:Case)-[r:引用]->(l:Law) WHERE l.law_name = "《中华人民共和国消费者权益保护法》" AND l.article = "第55条" RETURN c.case_name AS 案例名称, c.case_type AS 案件类型 """ result = graph.run(query).data() print(pd.DataFrame(result))输出结果:

案例名称 案件类型 张三诉李四网购假货案 网购纠纷

实战应用:律所的“智能案例检索系统”

很多律所都用知识图谱搭建了“智能案例检索系统”,比如:

-

律师输入“网购假货 消费者权益保护法”,系统会自动返回:

- 所有引用《消法》第55条的网购假货案例;

- 这些案例涉及的当事人(比如原告是消费者,被告是电商平台);

- 学者对这些案例的讨论论文;

- 法院的判决结果(比如支持三倍赔偿)。

这样,律师不用翻多个系统,就能拿到所有相关数据,节省80%的时间。

策略二:用跨源数据融合“连池塘”——让数据“流动起来”

原理:跨源数据融合(Cross-Source Data Fusion)是把来自不同数据源(比如裁判文书网、北大法宝、知网)的数据,按照统一的格式(比如JSON/CSV)整合到一起,并建立关联关系。比如:

- 从“裁判文书网”爬取判决文书,提取“案例名称”“判决日期”“引用法规”;

- 从“北大法宝”爬取法规条文,提取“法规名称”“条文内容”;

- 把“判决文书”中的“引用法规”和“北大法宝”中的“法规名称”关联起来(比如“《消法》第55条”对应“北大法宝”中的“法规ID 123”)。

关键问题:跨源数据融合的核心是“实体匹配”(Entity Matching),也就是判断不同数据源中的“实体”是否是同一个(比如“张三诉李四网购假货案”和“(2023)京0105民初1234号”是否是同一个案例)。

代码示例:用余弦相似度做实体匹配

我们用Python的scikit-learn库,计算两个案例名称的余弦相似度,判断是否是同一个案例:

-

准备数据(两个数据源的案例名称):

import pandas as pd from sklearn.feature_extraction.text import TfidfVectorizer from sklearn.metrics.pairwise import cosine_similarity # 数据源1:裁判文书网的案例名称(带案号) data1 = pd.DataFrame({ "case_id": [1], "case_name": ["(2023)京0105民初1234号 张三诉李四网购假货案"] }) # 数据源2:律所案例库的案例名称(不带案号) data2 = pd.DataFrame({ "case_id": [A, B], "case_name": ["张三诉李四网购假货纠纷", "王五诉赵六卖假酒案"] }) -

用TF-IDF将文本转换成向量:

TF-IDF(Term Frequency-Inverse Document Frequency)是一种将文本转换成数值向量的方法,能反映每个词在文本中的重要性。比如,“张三”“李四”“网购假货”这些词在“张三诉李四网购假货案”中的权重会很高。# 合并两个数据源的案例名称,用于训练TF-IDF模型 all_case_names = pd.concat([data1["case_name"], data2["case_name"]], axis=0).tolist() # 初始化TF-IDF向量器 vectorizer = TfidfVectorizer(stop_words="english") # 中文可以用jieba分词,这里简化用英文 stop words tfidf_matrix = vectorizer.fit_transform(all_case_names) -

计算余弦相似度:

余弦相似度是判断两个向量是否相似的指标,值在0到1之间,越接近1越相似。比如,“(2023)京0105民初1234号 张三诉李四网购假货案”和“张三诉李四网购假货纠纷”的余弦相似度会很高。# 提取数据源1的案例向量(第一个元素) data1_vector = tfidf_matrix[0] # 提取数据源2的案例向量(第1、2个元素,因为all_case_names的前1个是data1的,后面2个是data2的) data2_vectors = tfidf_matrix[1:3] # 计算余弦相似度 similarity = cosine_similarity(data1_vector, data2_vectors) # 输出结果 data2["similarity"] = similarity[0] print(data2[["case_id", "case_name", "similarity"]])输出结果:

case_id case_name similarity A 张三诉李四网购假货纠纷 0.85 B 王五诉赵六卖假酒案 0.12 我们可以设定一个阈值(比如0.7),当相似度超过0.7时,认为两个案例是同一个。这样,数据源1的“(2023)京0105民初1234号 张三诉李四网购假货案”就和数据源2的“张三诉李四网购假货纠纷”匹配上了。

实战应用:法院的“判决文书整合系统”

很多法院都用跨源数据融合技术,把本院的判决文书和上级法院的指导案例、最高院的典型案例整合到一起。比如,北京市朝阳区法院的“判决文书整合系统”:

- 从“中国裁判文书网”爬取本院的判决文书(带案号);

- 从“最高人民法院指导案例库”爬取指导案例(不带案号);

- 用实体匹配技术,把本院判决文书中的“类似案例”和指导案例关联起来;

- 法官审理案件时,系统会自动推荐相关的指导案例,帮助法官做出更准确的判决。

策略三:用NLP让电脑“读懂”法律文本——让数据“可处理”

原理:法律文本(判决书、法规、论文)都是非结构化数据(比如PDF中的文字),电脑本来无法直接处理。NLP(自然语言处理)技术能把这些非结构化数据转换成结构化数据(比如“原被告名称”“争议焦点”“判决依据”),让电脑能“读懂”并分析。

关键任务:法律NLP的核心任务包括:

- 实体提取(Entity Extraction):从文本中提取“原被告”“法规编号”“金额”等实体;

- 关系提取(Relation Extraction):提取实体之间的关系(比如“案例引用法规”“原告起诉被告”);

- 文本分类(Text Classification):把文本分成不同的类别(比如“网购纠纷”“劳动合同纠纷”);

- 情感分析(Sentiment Analysis):分析文本中的情感倾向(比如法官对“假货”的态度是“严厉”还是“宽松”)。

代码示例:用BERT提取判决书中的“原被告”

BERT是谷歌开发的一种NLP模型,能很好地理解文本的上下文。我们用Hugging Face的transformers库,加载预训练的BERT模型,提取判决书中的“原被告”实体。

-

安装依赖:

pip install transformers torch pandas -

准备数据(示例判决文书片段):

import pandas as pd from transformers import BertTokenizer, BertForTokenClassification from transformers import pipeline # 示例判决文书片段 text = """ 原告张三诉称,被告李四在淘宝平台销售假冒伪劣化妆品,侵犯了其消费者权益,请求法院判令被告赔偿三倍损失共计1500元。 被告李四辩称,其销售的化妆品是正品,有进货凭证,不同意原告的诉讼请求。 """ # 定义实体标签(B-表示实体开始,I-表示实体中间) label_list = ["O", "B-PERSON", "I-PERSON"] # O表示非实体,B-PERSON表示人名开始,I-PERSON表示人名中间 -

加载预训练的BERT模型:

我们用bert-base-chinese模型,这是一个针对中文优化的BERT模型。# 加载分词器和模型 tokenizer = BertTokenizer.from_pretrained("bert-base-chinese") model = BertForTokenClassification.from_pretrained("bert-base-chinese", num_labels=len(label_list)) # 创建NER(命名实体识别)管道 ner_pipeline = pipeline("ner", model=model, tokenizer=tokenizer, aggregation_strategy="simple") -

提取“原被告”实体:

# 用NER管道处理文本 results = ner_pipeline(text) # 过滤出“PERSON”实体(人名) persons = [result for result in results if result["entity_group"] == "PERSON"] # 输出结果 print("提取的原被告:") for person in persons: print(f"- {person['word']}(位置:{person['start']}-{person['end']})")输出结果:

提取的原被告: - 张三(位置:10-12) - 李四(位置:20-22) - 李四(位置:48-50)这样,我们就从判决书中自动提取了“原告张三”和“被告李四”的名字,不用手动标注了。

实战应用:律所的“判决文书自动分析系统”

很多律所都用NLP技术搭建了“判决文书自动分析系统”,比如:

- 律师上传一份判决文书,系统会自动提取:

- 原被告名称、联系方式;

- 争议焦点(比如“是否属于假货”);

- 判决依据(比如《消法》第55条);

- 判决结果(比如“被告赔偿原告1500元”);

- 系统还会生成一份“判决分析报告”,总结案件的关键信息,帮助律师快速了解案件情况。

策略四:用增量式数据更新“保持活水”——让数据“新鲜起来”

原理:法律数据是动态变化的(比如每天都有新的判决文书发布,新的法规出台),如果数据挖掘系统不能及时更新,就会变成“死水”(比如用2020年的案例来处理2023年的案件)。增量式数据更新(Incremental Data Update)就是“定期给池塘补水”,只更新新增的数据,而不是重新处理所有数据,这样能提高效率。

关键步骤:增量式数据更新的核心步骤包括:

- 数据监控:监控数据源的变化(比如裁判文书网每天新增的判决文书);

- 增量采集:只采集新增的数据(比如今天发布的判决文书);

- 增量处理:只处理新增的数据(比如用NLP提取新增判决书中的实体);

- 增量更新:把新增的数据更新到知识图谱或数据库中(比如把新增的案例节点插入到Neo4j中)。

代码示例:用Scrapy做增量数据采集

Scrapy是Python的一个爬虫框架,能高效地采集网页数据。我们用Scrapy做增量采集,只爬取裁判文书网今天新增的判决文书。

-

创建Scrapy项目:

scrapy startproject law_crawler cd law_crawler scrapy genspider judgment_crawler wenshu.court.gov.cn -

配置增量采集(用数据库记录已爬取的URL):

我们用SQLite数据库记录已爬取的判决文书URL,每次爬取前检查URL是否已经存在,如果不存在才爬取。在

law_crawler/items.py中定义Item:import scrapy class JudgmentItem(scrapy.Item): url = scrapy.Field() # 判决文书URL title = scrapy.Field() # 案例名称 content = scrapy.Field() # 判决内容 publish_date = scrapy.Field() # 发布日期在

law_crawler/middlewares.py中定义增量采集中间件:import sqlite3 from scrapy.exceptions import IgnoreRequest class IncrementalCrawlerMiddleware: def __init__(self): # 连接SQLite数据库 self.conn = sqlite3.connect("crawled_urls.db") self.cursor = self.conn.cursor() # 创建表(如果不存在) self.cursor.execute(""" CREATE TABLE IF NOT EXISTS crawled_urls ( url TEXT PRIMARY KEY ) """) self.conn.commit() def process_request(self, request, spider): # 检查URL是否已经爬取过 self.cursor.execute("SELECT * FROM crawled_urls WHERE url = ?", (request.url,)) if self.cursor.fetchone(): # 忽略已爬取的URL raise IgnoreRequest(f"URL already crawled: {request.url}") else: # 记录URL到数据库 self.cursor.execute("INSERT INTO crawled_urls VALUES (?)", (request.url,)) self.conn.commit() return None在

law_crawler/settings.py中启用中间件:DOWNLOADER_MIDDLEWARES = { "law_crawler.middlewares.IncrementalCrawlerMiddleware": 543, } -

编写爬虫代码(

judgment_crawler.py):import scrapy from law_crawler.items import JudgmentItem class JudgmentCrawlerSpider(scrapy.Spider): name = "judgment_crawler" allowed_domains = ["wenshu.court.gov.cn"] start_urls = ["https://wenshu.court.gov.cn/List/List?sorttype=1"] # 裁判文书网列表页 def parse(self, response): # 提取列表页中的判决文书URL(假设列表中的每个条目都有一个<a>标签,href属性是判决文书详情页URL) judgment_urls = response.css("a[class='caseName']::attr(href)").getall() for url in judgment_urls: # 构造完整的URL(裁判文书网的URL是相对路径,需要补全域名) full_url = response.urljoin(url) # yield请求,进入详情页解析 yield scrapy.Request(full_url, callback=self.parse_detail) def parse_detail(self, response): # 提取判决文书详情页中的信息 item = JudgmentItem() item["url"] = response.url item["title"] = response.css("h1[class='title']::text").get() item["content"] = response.css("div[class='content']::text").getall() item["publish_date"] = response.css("span[class='publishDate']::text").get() # yield item,交给 pipelines 处理 yield item -

运行爬虫:

scrapy crawl judgment_crawler这样,每次运行爬虫时,都会只爬取未爬取过的判决文书URL,实现增量采集。

实战应用:法律数据平台的“每日更新”功能

很多法律数据平台(比如“北大法宝”“威科先行”)都有“每日更新”功能,比如:

- 每天凌晨,系统自动爬取裁判文书网、最高院指导案例库、法规数据库的新增数据;

- 用增量处理技术,快速提取新增数据中的实体和关系;

- 把新增数据更新到知识图谱中,确保用户能查到最新的案例和法规。

策略五:用联邦学习解决“隐私顾虑”——让数据“安全共享”

原理:很多法律数据源(比如法院的判决文书库、律所的案例库)涉及隐私或商业秘密,不愿意把原始数据共享给第三方。联邦学习(Federated Learning)是一种“去中心化”的机器学习技术,能让多个数据源在不共享原始数据的情况下,联合训练AI模型。比如:

- 法院A有自己的判决文书库,律所B有自己的案例库;

- 法院A和律所B各自用自己的 data 训练模型,然后把模型参数(而不是原始数据)发送给一个中央服务器;

- 中央服务器把这些模型参数合并,得到一个更准确的模型;

- 中央服务器把合并后的模型参数发送给法院A和律所B,它们用这个模型来处理自己的数据。

这样,法院A和律所B不用共享原始数据,就能一起训练出更好的模型,解决了“数据隐私”问题。

数学模型:联邦学习的核心是“模型参数的联邦平均”(Federated Averaging),公式如下:

θ global = 1 N ∑ i = 1 K N i θ local , i \theta_{\text{global}} = \frac{1}{N} \sum_{i=1}^{K} N_i \theta_{\text{local},i} θglobal=N1i=1∑KNiθlocal,i

其中:

- θ global \theta_{\text{global}} θglobal:全局模型参数(合并后的模型);

- K K K:数据源的数量(比如法院A和律所B, K = 2 K=2 K=2);

- N i N_i Ni:第 i i i个数据源的样本数量(比如法院A有1000个案例, N 1 = 1000 N_1=1000 N1=1000);

- N N N:所有数据源的总样本数量( N = N 1 + N 2 N=N_1+N_2 N=N1+N2);

- θ local , i \theta_{\text{local},i} θlocal,i:第 i i i个数据源的本地模型参数(用自己的 data 训练后的模型)。

这个公式的意思是,全局模型参数是各个本地模型参数的加权平均,权重是每个数据源的样本数量占总样本数量的比例。比如,法院A有1000个案例,律所B有2000个案例,那么全局模型参数是法院A模型参数的1/3加上律所B模型参数的2/3。

代码示例:用PyTorch实现简单的联邦学习

我们用PyTorch实现一个简单的联邦学习例子,假设有两个数据源(法院A和律所B),各自用自己的 data 训练一个线性回归模型,然后用联邦平均合并模型参数。

-

准备数据(两个数据源的 data):

import torch import torch.nn as nn import torch.optim as optim # 数据源1(法院A):假设有100个样本,特征是(x1, x2),标签是y=2x1+3x2+1 X1 = torch.randn(100, 2) y1 = 2*X1[:,0] + 3*X1[:,1] + 1 + torch.randn(100)*0.1 # 加一点噪声 # 数据源2(律所B):假设有200个样本,特征是(x1, x2),标签是y=2x1+3x2+1 X2 = torch.randn(200, 2) y2 = 2*X2[:,0] + 3*X2[:,1] + 1 + torch.randn(200)*0.1 # 加一点噪声 -

定义本地模型(线性回归模型):

class LinearRegression(nn.Module): def __init__(self): super(LinearRegression, self).__init__() self.linear = nn.Linear(2, 1) # 输入特征数2,输出标签数1 def forward(self, x): return self.linear(x) -

训练本地模型(法院A和律所B各自训练):

# 数据源1(法院A)训练本地模型 model1 = LinearRegression() optimizer1 = optim.SGD(model1.parameters(), lr=0.01) criterion = nn.MSELoss() for epoch in range(100): optimizer1.zero_grad() outputs = model1(X1) loss = criterion(outputs.squeeze(), y1) loss.backward() optimizer1.step() # 数据源2(律所B)训练本地模型 model2 = LinearRegression() optimizer2 = optim.SGD(model2.parameters(), lr=0.01) for epoch in range(100): optimizer2.zero_grad() outputs = model2(X2) loss = criterion(outputs.squeeze(), y2) loss.backward() optimizer2.step() -

联邦平均合并模型参数:

# 计算总样本数量 N1 = X1.shape[0] # 100 N2 = X2.shape[0] # 200 N = N1 + N2 # 300 # 合并模型参数(权重和偏置) # 权重:model.linear.weight(形状:1x2) # 偏置:model.linear.bias(形状:1) global_weight = (N1 * model1.linear.weight + N2 * model2.linear.weight) / N global_bias = (N1 * model1.linear.bias + N2 * model2.linear.bias) / N # 创建全局模型 global_model = LinearRegression() global_model.linear.weight.data = global_weight.data global_model.linear.bias.data = global_bias.data # 打印全局模型的参数(应该接近真实值:权重[2,3],偏置1) print("全局模型权重:", global_model.linear.weight.data) print("全局模型偏置:", global_model.linear.bias.data)输出结果(示例):

全局模型权重: tensor([[1.98, 2.97]]) 全局模型偏置: tensor([0.99])可以看到,全局模型的参数非常接近真实值(权重[2,3],偏置1),而法院A和律所B没有共享任何原始数据。

实战应用:跨机构的“法律AI联合训练”

比如,最高人民法院和多家律所联合训练一个“判决预测模型”:

- 最高人民法院有大量的判决文书数据,但没有律所的案例数据;

- 律所有多的案例数据,但没有最高院的指导案例数据;

- 用联邦学习,最高院和律所各自用自己的 data 训练模型,然后合并模型参数;

- 最终得到的“判决预测模型”能更准确地预测案件的判决结果,同时保护了双方的隐私。

四、项目实战:搭建一个“法律数据整合系统”

接下来,我们用前面讲的5个策略,手把手教你搭建一个简单的“法律数据整合系统”,功能包括:

- 数据采集:从裁判文书网爬取判决文书;

- 数据清洗:统一数据格式,去除无关信息;

- NLP处理:提取判决书中的“原被告”“引用法规”;

- 知识图谱构建:把案例、法规用“引用”关系连起来;

- 应用展示:实现“案例检索”功能(输入法规名称,返回引用该法规的案例)。

4.1 开发环境搭建

- 操作系统:Windows/macOS/Linux;

- 编程语言:Python 3.8+;

- 依赖库:

- 数据采集:Scrapy;

- 数据清洗:Pandas;

- NLP处理:Transformers(Hugging Face)、Jieba(中文分词);

- 知识图谱:Neo4j、Py2neo;

- 应用展示:Flask(web框架)。

4.2 源代码详细实现

步骤1:数据采集(用Scrapy爬取裁判文书网)

参考前面“策略四”的代码,创建一个Scrapy爬虫,爬取裁判文书网的判决文书,保存为CSV文件。

步骤2:数据清洗(用Pandas统一格式)

import pandas as pd

# 读取爬取的CSV文件

df = pd.read_csv("judgments.csv")

# 清洗数据:去除空值、去除多余的空格

df = df.dropna()

df["title"] = df["title"].str.strip()

df["content"] = df["content"].str.strip()

# 保存清洗后的数据

df.to_csv("cleaned_judgments.csv", index=False)

步骤3:NLP处理(用BERT提取实体)

参考前面“策略三”的代码,用BERT提取判决书中的“原被告”和“引用法规”,保存为JSON文件。

步骤4:知识图谱构建(用Neo4j存储)

参考前面“策略一”的代码,用Py2neo把案例、法规插入到Neo4j中,建立“引用”关系。

步骤5:应用展示(用Flask实现案例检索)

from flask import Flask, request, render_template

from py2neo import Graph

app = Flask(__name__)

# 连接Neo4j数据库

graph = Graph("bolt://localhost:7687", auth=("neo4j", "your_password"))

@app.route("/")

def index():

return render_template("index.html") # 首页,包含一个搜索框

@app.route("/search", methods=["POST"])

def search():

# 获取用户输入的法规名称

law_name = request.form["law_name"]

# 用Cypher查询引用该法规的案例

query = """

MATCH (c:Case)-[r:引用]->(l:Law)

WHERE l.law_name CONTAINS $law_name

RETURN c.case_name AS 案例名称, c.case_type AS 案件类型, l.law_name AS 引用法规

"""

result = graph.run(query, law_name=law_name).data()

# 渲染结果页面

return render_template("results.html", results=result)

if __name__ == "__main__":

app.run(debug=True)

步骤6:编写前端页面(index.html和results.html)

- index.html:包含一个搜索框,让用户输入法规名称;

- results.html:展示搜索结果,包括案例名称、案件类型、引用法规。

4.3 代码解读与分析

- 数据采集:用Scrapy爬取裁判文书网的判决文书,确保数据的准确性和完整性;

- 数据清洗:用Pandas去除空值和多余的空格,统一数据格式,为后续处理做准备;

- NLP处理:用BERT提取“原被告”和“引用法规”,把非结构化的文本转换成结构化数据;

- 知识图谱构建:用Neo4j存储案例和法规的关联关系,让数据能“关联起来”;

- 应用展示:用Flask实现web界面,让用户能方便地检索案例,体现数据的价值。

五、实际应用场景:AI如何改变法律研究?

5.1 律师:从“找数据”到“用数据”

律师的核心工作是“用数据支持论点”,比如:

- 用“智能案例检索系统”快速找到类似案例,支持自己的代理词;

- 用“判决文书自动分析系统

更多推荐

已为社区贡献147条内容

已为社区贡献147条内容

所有评论(0)